Non ho intenzione di mentire: Condurre un audit SEO approfondito è un affare importante.

E, come consulente SEO, ci sono poche parole più dolci di: “Il tuo audit sembra ottimo! Quando possiamo portarti a bordo?”

Anche se non sei stato attivamente alla ricerca di un nuovo lavoro, sapere che il tuo audit SEO ha fatto centro è una grande spinta per l’ego.

Ma, sei terrorizzato di iniziare? È il tuo primo audit SEO? O forse non sai da dove cominciare?

Inviare un fantastico audit SEO a un potenziale cliente ti mette nel miglior posto possibile.

Quindi prenditi il tuo tempo. Ricorda: il tuo obiettivo primario è quello di aggiungere valore al tuo cliente con le tue raccomandazioni per il sito sia a breve che a lungo termine.

In questa rubrica, ho messo insieme i passi da conoscere per condurre un audit SEO e un po’ di informazioni sulla prima fase dei miei processi quando ricevo un nuovo cliente. È suddiviso in sezioni qui sotto. Se ti sembra di avere una buona conoscenza di una particolare sezione, sentiti libero di saltare alla successiva.

Quando dovrei eseguire un audit SEO?

Dopo che un potenziale cliente mi invia un’e-mail esprimendo interesse a lavorare insieme e risponde al mio sondaggio, organizziamo una chiamata introduttiva (Skype o Google Hangouts è preferibile).

Prima della chiamata, faccio il mio mini audit SEO veloce (investo almeno un’ora per la ricerca manuale) basato sulle loro risposte al sondaggio per acquisire familiarità con il loro panorama di mercato. È come uscire con qualcuno che non hai mai incontrato.

Si tratta ovviamente di pedinarli su Facebook, Twitter, Instagram, e tutti gli altri canali che sono pubblici #soIcreep.

Ecco un esempio di come si presenta il mio sondaggio:

Ecco alcune domande chiave che vorrete fare al cliente durante il primo incontro:

- Quali sono i vostri obiettivi aziendali generali? Quali sono i tuoi obiettivi di canale (PR, social, ecc.)?

- Chi è il tuo pubblico di riferimento?

- Hai qualche partnership commerciale?

- Quanto spesso viene aggiornato il sito web? Hai uno sviluppatore web o un dipartimento IT?

- Hai mai lavorato con un consulente SEO prima? Oppure, ha mai avuto un lavoro SEO fatto in precedenza?

Sujan Patel ha anche alcuni ottimi consigli sulle domande da fare a un nuovo cliente SEO.

Dopo la chiamata, se sento che siamo una buona partita, invierò la mia proposta formale e il contratto (grazie HelloSign per aver reso questo un processo facile per me!).

Per iniziare, mi piace sempre offrire ai miei clienti il primo mese come periodo di prova per assicurarmi che vibriamo.

Questo dà sia al cliente che a me la possibilità di diventare amici prima di uscire. Durante questo mese, mi prenderò il mio tempo per condurre un audit SEO approfondito.

Questi audit SEO possono portarmi ovunque da 40 ore a 60 ore a seconda delle dimensioni del sito web. Questi audit sono suddivisi in tre parti separate e presentati con Google Slides.

- Tecnico: Errori di scansione, indicizzazione, hosting, ecc.

- Contenuto: Ricerca delle parole chiave, analisi dei concorrenti, mappe dei contenuti, meta dati, ecc.

- Link: Analisi del profilo dei backlink, tattiche di crescita, ecc.

Dopo il primo mese, se al cliente piace il mio lavoro, inizieremo a implementare le raccomandazioni del SEO audit. E andando avanti, eseguirò un mini-audit mensile e un audit approfondito trimestrale.

Per ricapitolare, eseguo un audit SEO per i miei clienti:

- Primo mese.

- Mensile (mini-audit).

- Quarzile (audit approfondito).

Cosa ti serve da un cliente prima di un SEO Audit

Quando io e un cliente iniziamo a lavorare insieme, condivido con loro un Google Doc che richiede una lista di password e fornitori.

Questo include:

- L’accesso a Google Analytics e qualsiasi strumento di analisi di terze parti.

- Google e Bing ads.

- Strumenti per webmaster.

- Accesso al backend del sito web.

- Accessi ai social media.

- Lista dei fornitori.

- Lista dei membri del team interno (incluso qualsiasi lavoro che esternalizzano).

Strumenti per il SEO Audit

Prima di iniziare il tuo SEO audit, ecco un riassunto degli strumenti che uso:

- Screaming Frog.

- Integrity (per utenti Mac) e Xenu Sleuth (per utenti PC).

- SEO Browser.

- Wayback Machine.

- Moz.

- BuzzSumo.

- DeepCrawl.

- Copyscape.

- Google Tag Manager.

- Google Tag Manager Chrome Extension.

- Annie Cushing’s Campaign Tagging Guide.

- Google Analytics (se ha accesso).

- Google Search Console (se ha accesso).

- Bing Webmaster Tools (se ha accesso).

- You Get Signal.

- Pingdom.

- PageSpeed Tool.

- Sublime Text.

Condurre un audit SEO tecnico

Strumenti necessari per un audit SEO tecnico:

- Screaming Frog.

- DeepCrawl.

- Copyscape.

- Integrity per Mac (o Xenu Sleuth per gli utenti PC).

- Google Analytics (se ha accesso).

- Google Search Console (se ha accesso).

- Bing Webmaster Tools (se ha accesso).

Step 1: Aggiungi il sito a DeepCrawl e Screaming Frog

Tools:

- DeepCrawl.

- Copyscape.

- Screaming Frog.

- Google Analytics.

- Integrity.

- Google Tag Manager.

- Codice Google Analytics.

Cosa cercare quando si usa DeepCrawl

La prima cosa che faccio è aggiungere il sito del mio cliente a DeepCrawl. A seconda delle dimensioni del sito del cliente, il crawl può richiedere un giorno o due per ottenere i risultati.

Una volta ottenuti i risultati di DeepCrawl, ecco le cose che cerco:

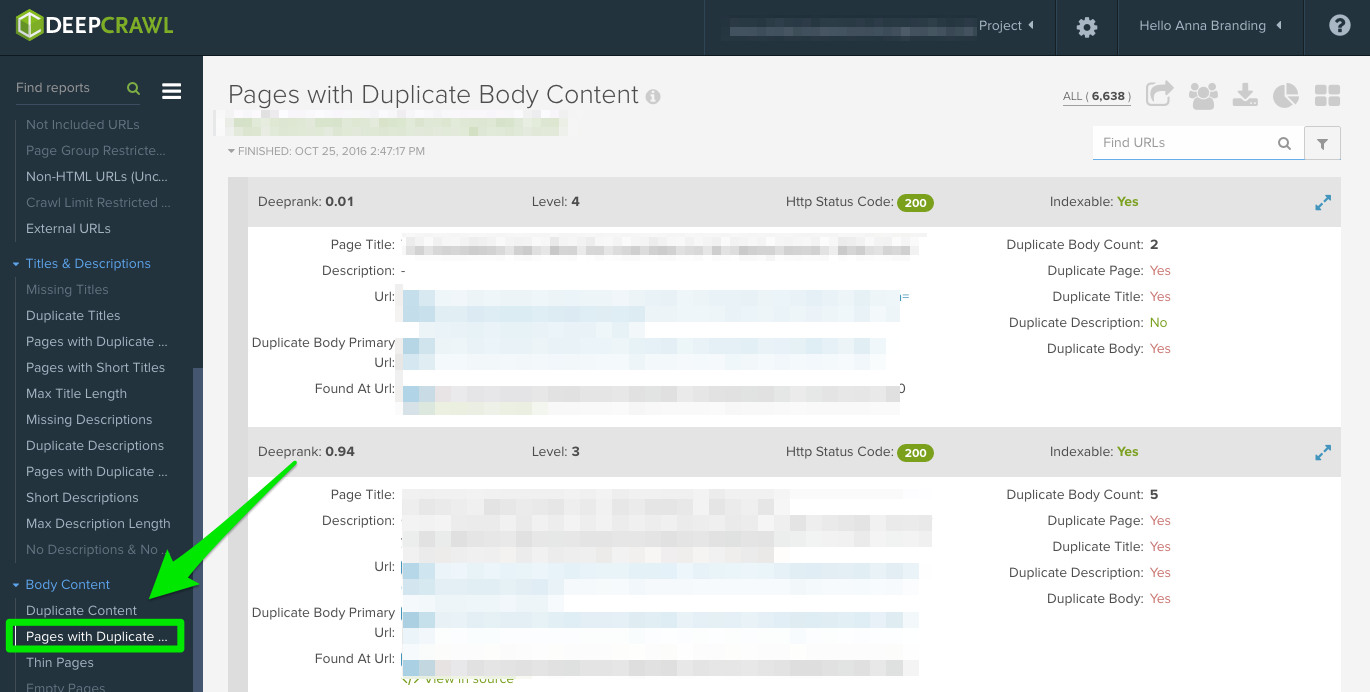

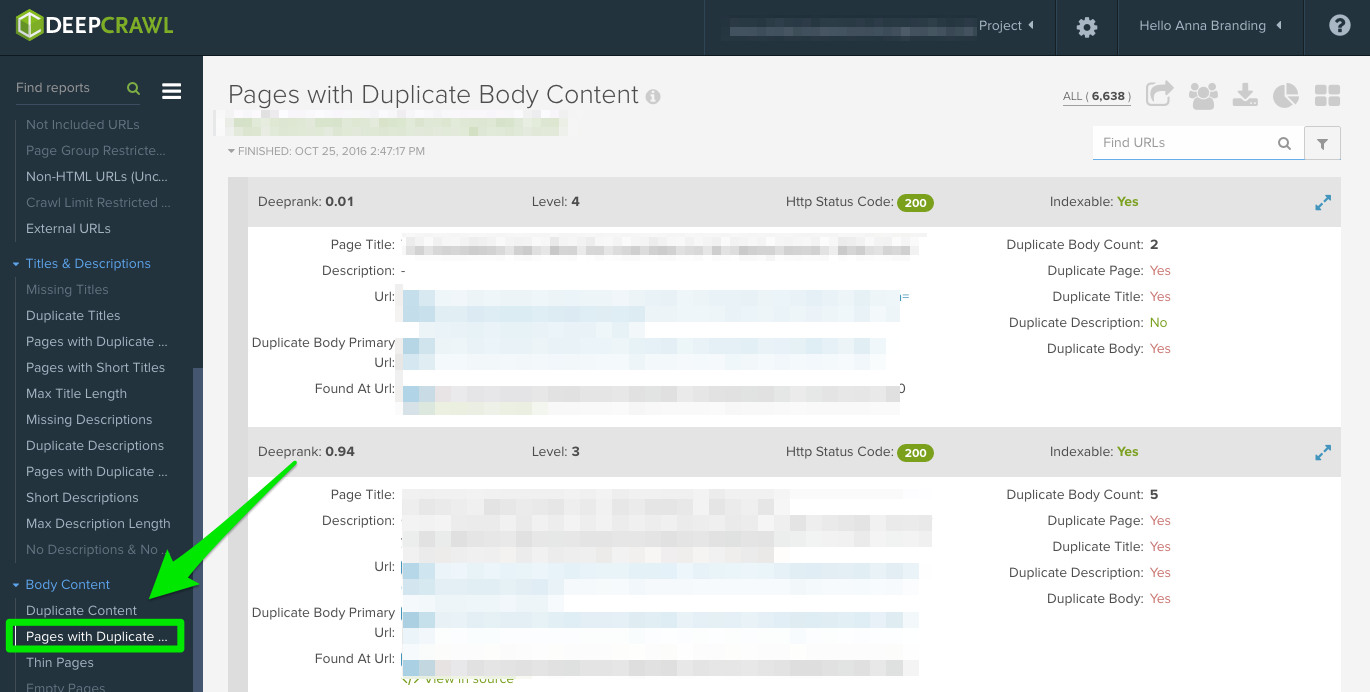

Contenuto duplicato

Guarda il rapporto “Pagine duplicate” per individuare il contenuto duplicato.

Se viene identificato un contenuto duplicato, ne farò una priorità assoluta nelle mie raccomandazioni al cliente per riscrivere queste pagine, e nel frattempo, aggiungerò il tag <meta name=”robots” content=”noindex, nofollow”> alle pagine duplicate.

Comuni errori di contenuto duplicato che scoprirai:

- Meta titoli e meta descrizioni duplicati.

- Contenuto del corpo duplicato da pagine di tag (userò Copyscape per aiutare a determinare se qualcosa è stato plagiato).

- Due domini (es: yourwebsite.co, yourwebsite.com).

- Sottodomini (es: jobs.yourwebsite.com).

- Contenuto simile su un dominio diverso.

- Paginazione non correttamente implementata (vedi sotto.)

Come risolvere:

- Aggiungi il tag canonical sulle tue pagine per far sapere a Google quale vuoi che sia il tuo URL preferito.

- Disconosci gli URL errati nel robots.txt.

- Riscrivi il contenuto (compresa la copia del corpo e i metadati).

Ecco un esempio di un problema di contenuto duplicato che ho avuto con un mio cliente. Come potete vedere qui sotto, avevano parametri URL senza il tag canonical.

Questi sono i passi che ho fatto per risolvere il problema:

- Ho risolto qualsiasi problema di 301 redirect.

- Ho aggiunto un tag canonical alla pagina che voglio far scansionare a Google.

- Aggiornate le impostazioni dei parametri di Google Search Console per escludere tutti i parametri che non generano contenuti unici.

- Aggiunto la funzione disallow al robots.txt agli URL errati per migliorare il crawl budget.

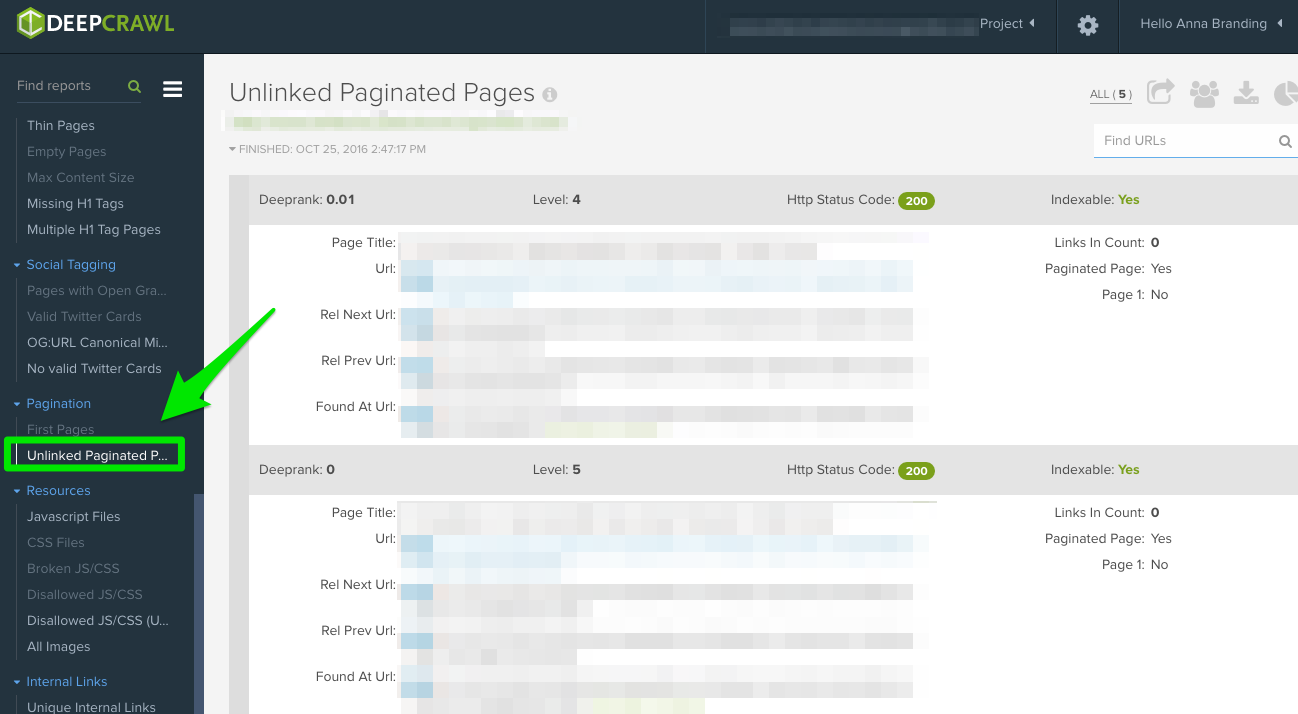

Paginazione

Ci sono due rapporti da controllare:

- Prime pagine: Per scoprire quali pagine stanno usando la paginazione, esamina il rapporto “Prime pagine”. Poi, puoi rivedere manualmente le pagine che lo utilizzano sul sito per scoprire se la paginazione è implementata correttamente.

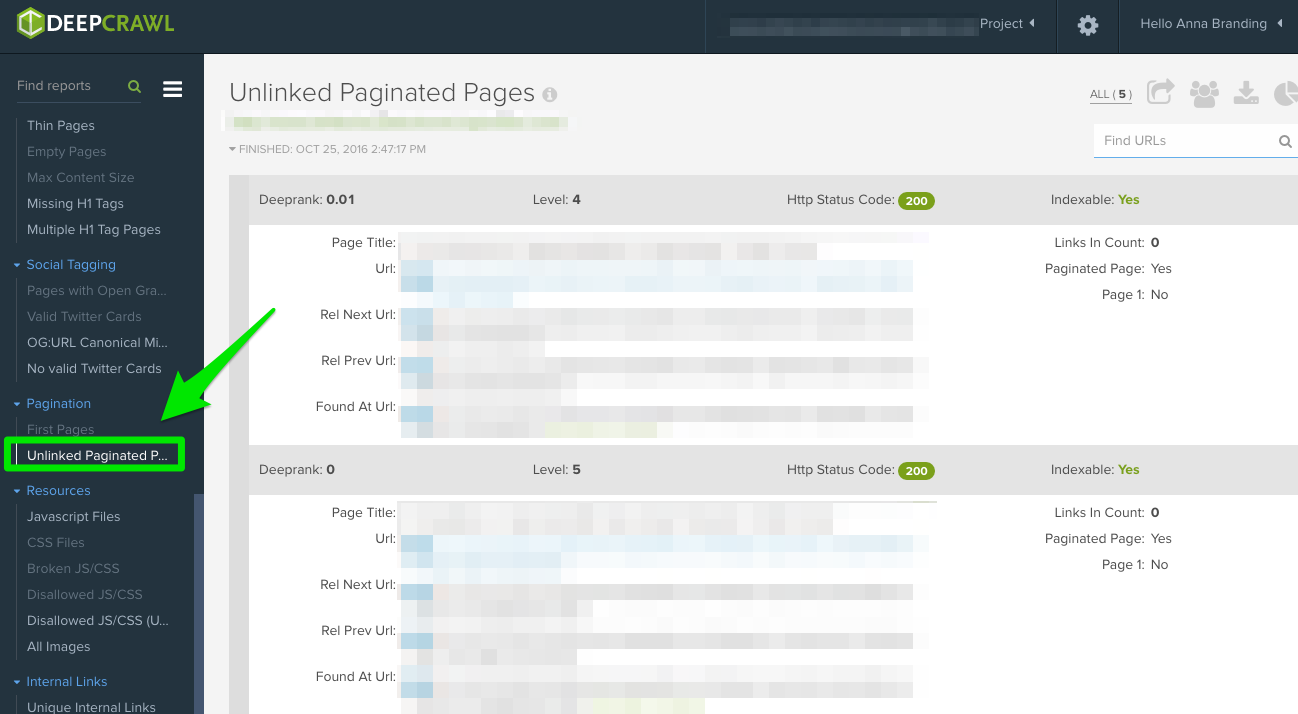

- Pagine di paginazione non collegate: Per scoprire se l’impaginazione funziona correttamente, il rapporto “Unlinked Pagination Pages” ti dirà se il rel=”next” e il rel=”prev” sono collegati alle pagine precedenti e successive.

In questo esempio qui sotto, sono riuscito a scoprire che un cliente aveva tag di paginazione reciproca usando DeepCrawl:

Come risolvere:

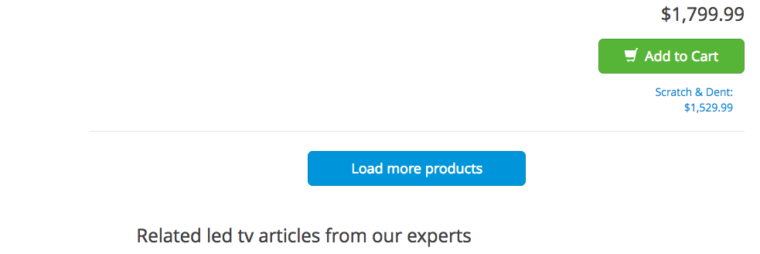

- Se hai una pagina “view all” o una pagina “load more”, aggiungi il tag rel=”canonical”. Ecco un esempio da Crutchfield:

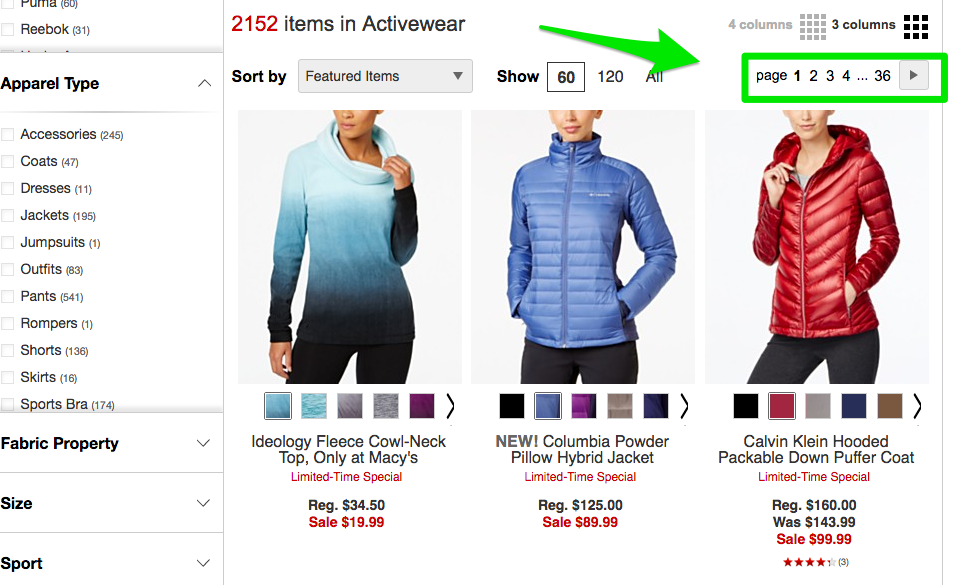

- Se hai tutte le tue pagine su pagine separate, allora aggiungi il markup standard rel=”next” e rel=”prev”. Ecco un esempio da Macy’s:

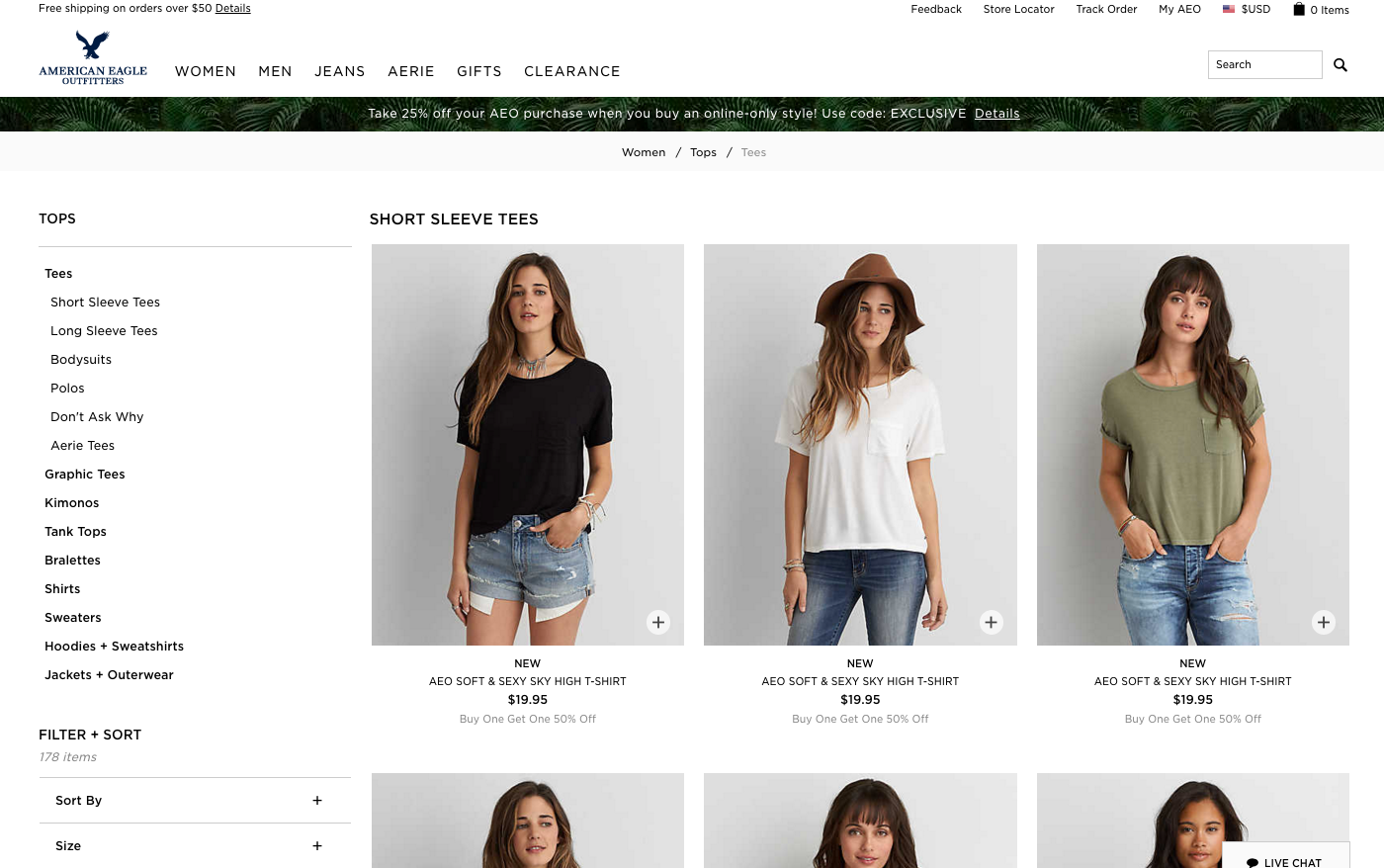

- Se stai usando lo scorrimento infinito, aggiungi l’equivalente URL della pagina paginata nel tuo javascript. Ecco un esempio di American Eagle.

Max Redirections

Guarda il rapporto “Max Redirections” per vedere tutte le pagine che reindirizzano più di 4 volte. John Mueller ha menzionato nel 2015 che Google può smettere di seguire i reindirizzamenti se ce ne sono più di cinque.

Mentre alcune persone si riferiscono a questi errori di crawl per consumare il “budget di crawl”, Gary Illyes si riferisce a questo come “carico dell’host”. È importante assicurarsi che le tue pagine rendano correttamente perché vuoi che il carico dell’host sia utilizzato in modo efficiente.

Ecco una breve panoramica dei codici di risposta che potresti vedere:

- 301 – Questi sono la maggior parte dei codici che vedrai durante la tua ricerca. I reindirizzamenti 301 vanno bene finché ci sono solo un reindirizzamento e nessun ciclo di reindirizzamento.

- 302 – Questi codici vanno bene, ma se lasciati più di 3 mesi circa, li cambierei manualmente in 301 in modo che siano permanenti. Questo è un codice di errore che vedrò spesso con i siti di e-commerce quando un prodotto è esaurito.

- 400 – Gli utenti non possono raggiungere la pagina.

- 403 – Gli utenti non sono autorizzati ad accedere alla pagina.

- 404 – La pagina non viene trovata (di solito significa che il cliente ha cancellato una pagina senza un reindirizzamento 301).

- 500 – Errore interno del server che dovrai collegare con il team di sviluppo web per determinare la causa.

Come risolvere:

- Rimuovi qualsiasi link interno che punta alle vecchie pagine 404 e aggiornale con il link interno della pagina reindirizzata.

- Sblocca le catene di redirect rimuovendo i redirect centrali. Per esempio, se il redirect A va al redirect B, C, e D, allora vorrete annullare i redirect B e C. Il risultato finale sarà un redirect A a D.

- C’è anche un modo per fare questo in Screaming Frog e Google Search Console qui sotto se state usando quella versione.

Cosa cercare quando si usa Screaming Frog

La seconda cosa che faccio quando ricevo il sito di un nuovo cliente è aggiungere il suo URL a Screaming Frog.

A seconda delle dimensioni del sito del cliente, posso configurare le impostazioni per scansionare aree specifiche del sito alla volta.

Ecco come sono le mie configurazioni dello spider Screaming Frog:

Lo puoi fare nelle impostazioni dello spider o escludendo aree del sito.

Una volta ottenuti i risultati di Screaming Frog, ecco le cose che cerco:

Codice Google Analytics

Screaming Frog può aiutarti a identificare quali pagine mancano del codice Google Analytics (UA-1234568-9). Per trovare il codice mancante di Google Analytics, segui questi passi:

- Vai a Configurazione nella barra di navigazione, poi Personalizzata.

- Aggiungi analytics\.js a Filtro 1, poi cambia il drop-down in Non contiene.

Come risolvere:

- Contattare gli sviluppatori del tuo cliente e chiedere loro di aggiungere il codice alle pagine specifiche che mancano.

- Per ulteriori informazioni su Google Analytics, vai alla sezione Google Analytics qui sotto.

Google Tag Manager

Screaming Frog può anche aiutarti a scoprire quali pagine mancano dello snippet di Google Tag Manager con passi simili:

- Vai alla scheda Configurazione nella barra di navigazione, poi Personalizzata.

- Aggiungi <iframe src-“//www.googletagmanager.com/ con Non contiene selezionato nel Filtro.

Come risolvere:

- Andare su Google Tag Manager per vedere se ci sono errori e aggiornare dove necessario.

- Condividi il codice con lo sviluppatore del tuo cliente per vedere se possono aggiungerlo di nuovo al sito.

Schema

Vuoi anche controllare se il sito del tuo cliente sta usando schema markup sul loro sito. Schema o dati strutturati aiuta i motori di ricerca a capire cosa sia una pagina sul sito.

Per verificare la presenza di schema markup in Screaming Frog, segui questi passi:

- Vai alla scheda Configurazione nella barra di navigazione, poi Personalizza.

- Aggiungi itemtype=”http://schema.\.org/ con ‘Contiene’ selezionato nel Filtro.

Indexing

Indexing

Vuoi determinare quante pagine vengono indicizzate per il tuo cliente, segui questo in Screaming Frog:

- Dopo che il tuo sito ha finito di essere caricato in Screaming Frog, vai in Direttive > Filtro > Indice per controllare se ci sono pezzi di codice mancanti.

Come risolvere:

- Se il sito è nuovo, Google potrebbe non averlo ancora indicizzato.

- Controlla il file robots.txt per assicurarsi che non stai impedendo tutto ciò che vuoi che Google strisci.

- Controlla per assicurarti di aver inviato la mappa del sito del tuo cliente a Google Search Console e Bing Webmaster Tools.

- Conduci la ricerca manuale (vedi sotto).

Flash

Google ha annunciato nel 2016 che Chrome inizierà a bloccare Flash a causa dei lenti tempi di caricamento delle pagine. Quindi, se stai facendo una verifica, vuoi identificare se il tuo nuovo cliente sta usando Flash o no.

Per fare questo in Screaming Frog, prova questo:

- Vai alla configurazione del ragno nella navigazione.

- Clicca su Controlla SWF.

- Filtra la scheda interna da Flash dopo che il crawl è fatto.

Come risolvere:

- Embed video da YouTube. Google ha comprato YouTube nel 2006, non c’è niente da fare qui.

- Oppure, optare per gli standard HTML5 quando si aggiunge un video.

Ecco un esempio di codice HTML5 per l’aggiunta di un video:

<video controls="controls" width="320" height="240">> <source class="hiddenSpellError" data-mce-bogus="1" />src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.mp4" type="video/mp4"> <source src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.ogg" type="video/ogg" />Your browser does not support the video tag.</video>

JavaScript

Secondo l’annuncio di Google nel 2015, JavaScript è ok da usare per il tuo sito web fino a quando non stai bloccando nulla nel tuo robots.txt (scaveremo più a fondo in questo tra poco!). Ma, vuoi ancora dare un’occhiata a come il Javascript viene consegnato al tuo sito.

Come risolvere:

- Rivedere Javascript per assicurarsi che non sia bloccato dal robots.txt

- Assicurati che Javascript sia in esecuzione sul server (questo aiuta a produrre dati di testo semplice rispetto a quelli dinamici).

- Se stai usando Angular JavaScript, dai un’occhiata a questo articolo di Ben Oren sul perché potrebbe uccidere i tuoi sforzi SEO.

- In Screaming Frog, vai alla Configurazione dello Spider nella barra di navigazione e clicca su Controlla JavaScript. Dopo che il crawl è finito, filtra i tuoi risultati nella scheda Internal per JavaScript.

Robots.txt

Robots.txt

Quando stai esaminando un robots.txt per la prima volta, vuoi vedere se qualcosa di importante è stato bloccato o non consentito.

Per esempio, se vedi questo codice:

User-agent: *Disallow: /

Il sito del tuo cliente è bloccato da tutti i web crawler.

Ma, se hai qualcosa come il file robots.txt di Zappos, dovresti essere a posto.

# Global robots.txt as of 2012-06-19User-agent: *Disallow: /bin/Disallow: /multiview/Disallow: /product/review/add/Disallow: /cartDisallow: /loginDisallow: /logoutDisallow: /registrazioneDisallow: /account

Stanno bloccando solo ciò che non vogliono che i web crawler trovino. Questo contenuto che viene bloccato non è rilevante o utile per il web crawler.

Come risolvere:

- Il tuo robots.txt è sensibile al maiuscolo/minuscolo, quindi aggiornalo in modo che sia tutto minuscolo.

- Rimuovi tutte le pagine elencate come Disallow che vuoi che i motori di ricerca scansionino.

- Screaming Frog di default non sarà in grado di caricare alcun URL non consentito da robots.txt. Se scegli di cambiare le impostazioni di default in Screaming Frog, ignorerà tutti i robots.txt.

- Puoi anche visualizzare le pagine bloccate in Screaming Frog sotto la scheda Response Codes, quindi filtrate dal filtro Blocked by Robots.txt dopo aver completato la scansione.

- Se hai un sito con più sottodomini, dovresti avere un robots.txt separato per ognuno.

- Assicurati che la sitemap sia elencata nel robots.txt.

Erori di scansione

Io uso DeepCrawl, Screaming Frog e gli strumenti per webmaster di Google e Bing per trovare e controllare gli errori di scansione dei miei clienti.

Per trovare i tuoi errori di crawl in Screaming Frog, segui questi passi:

- Dopo aver completato la scansione, vai su Bulk Reports.

- Scorri fino a Response Codes, quindi esporta il rapporto di errore lato server e il rapporto di errore client.

Come risolvere:

- I rapporti di errore client, dovresti essere in grado di reindirizzare da solo la maggior parte degli errori 404 nel backend del sito.

- I rapporti di errore server, collabora con il team di sviluppo per determinare la causa. Prima di correggere questi errori sulla directory principale, assicurati di fare il backup del sito. Potresti semplicemente aver bisogno di creare un nuovo file di accesso .html o aumentare il limite di memoria di PHP.

- Vorrai anche rimuovere qualsiasi di questi reindirizzamenti permanenti dalla mappa del sito e qualsiasi link interno o esterno.

- Puoi anche usare 404 nel tuo URL per aiutare a tracciare in Google Analytics.

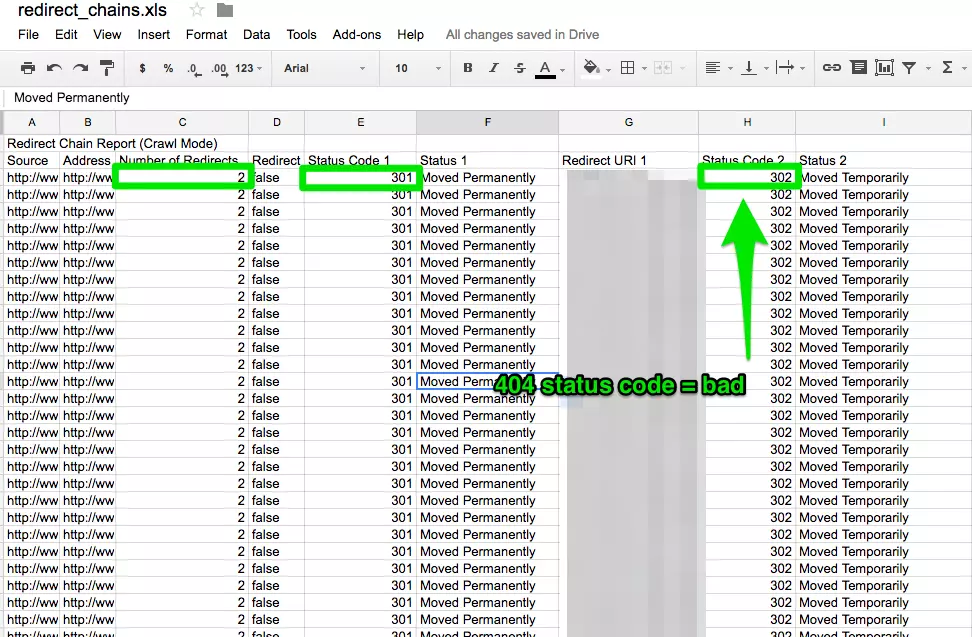

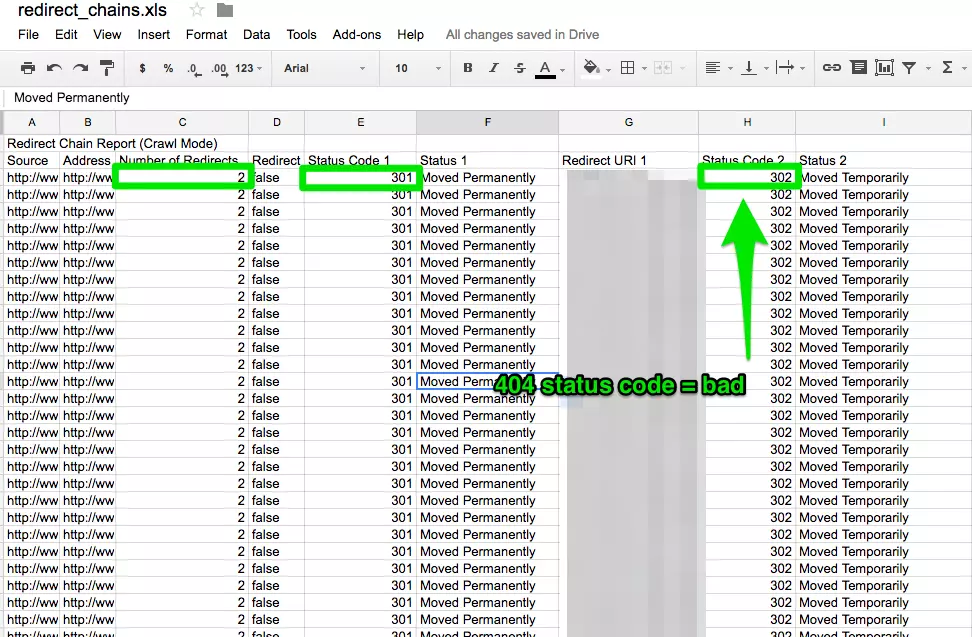

Catene di reindirizzamento

Le catene di reindirizzamento non solo causano una cattiva esperienza dell’utente, ma rallentano la velocità della pagina, i tassi di conversione scendono, e qualsiasi link love che puoi aver ricevuto prima è perso.

La correzione delle catene di reindirizzamento è una vittoria rapida per qualsiasi azienda.

Come risolvere:

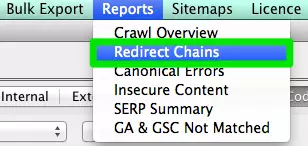

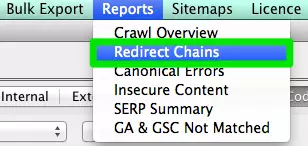

- In Screaming Frog dopo aver completato la scansione, vai su Reports > Redirect Chains per visualizzare il percorso di scansione dei tuoi reindirizzamenti. In un foglio di calcolo excel, puoi tracciare per assicurarti che i tuoi reindirizzamenti 301 rimangano tali. Se vedete un errore 404, vorrete ripulirlo.

Internal &Link esterni

Quando un utente clicca su un link al tuo sito e ottiene un errore 404, non è una buona esperienza utente.

E non aiuta nemmeno i motori di ricerca ad apprezzarti meglio.

Per trovare i miei link interni ed esterni interrotti uso Integrity per Mac. Puoi anche usare Xenu Sleuth se sei un utente PC.

Ti mostrerò anche come trovare questi link interni ed esterni in Screaming Frog e DeepCrawl se stai usando quel software.

Come risolvere:

- Se stai usando Integrity o Xenu Sleuth, esegui l’URL del sito del tuo cliente e otterrai una lista completa di URL non funzionanti. Puoi aggiornarli manualmente tu stesso o, se stai lavorando con un team di sviluppatori, chiedere loro aiuto.

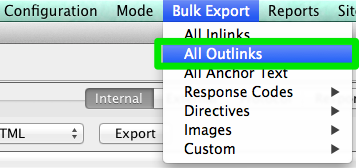

- Se stai usando Screaming Frog, dopo che il crawl è completato, vai su Bulk Export nella barra di navigazione, poi su All Outlinks. Puoi ordinare per URL e vedere quali pagine stanno inviando un segnale 404. Ripeti lo stesso passo con tutti gli Inlink.

- Se stai usando DeepCrawl, vai alla scheda Unique Broken Links sotto la sezione Internal Links.

URLs

Ogni volta che prendi un nuovo cliente, vuoi rivedere il loro formato URL. Cosa devo cercare negli URL?

- Parametri – Se l’URL ha caratteri strani come ?, =, o +, è un URL dinamico che può causare contenuti duplicati se non ottimizzato.

- User-friendly – Mi piace mantenere gli URL brevi e semplici, rimuovendo anche eventuali slash extra.

Come risolvere:

- Puoi cercare gli URL con parametri in Google facendo site:www.buyaunicorn.com/ inurl: “?” o qualsiasi cosa pensi che il parametro possa includere.

- Dopo aver eseguito il crawl su Screaming Frog, dai un’occhiata agli URL. Se vedi dei parametri elencati che stanno creando dei duplicati del tuo contenuto, devi suggerire quanto segue:

- Aggiungi un tag canonico alla pagina dell’URL principale. Per esempio, www.buyaunicorn.com/magical-headbands è la pagina principale e vedo www.buyaunicorn.com/magical-headbands/?dir=mode123$, allora il tag canonico dovrebbe essere aggiunto a www.buyaunicorn.com/magical-headbands.

- Aggiorna i tuoi parametri in Google Search Console sotto Crawl > Parametri URL.

- Disabilita gli URL duplicati nel robots.txt.

Step 2: Rivedi Google Search Console e Bing Webmaster Tools.

Tools:

- Google Search Console.

- Bing Webmaster Tools.

- Sublime Text (o qualsiasi strumento di editor di testo).

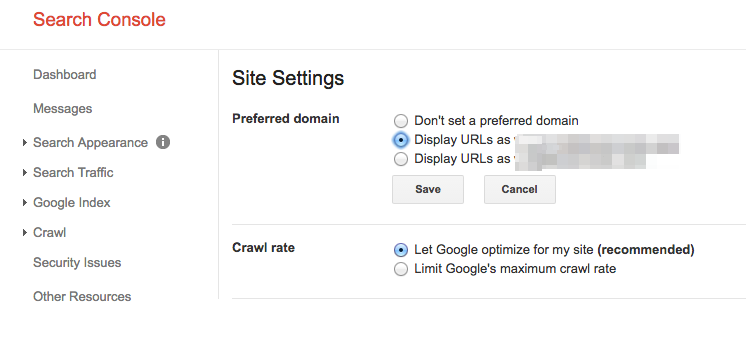

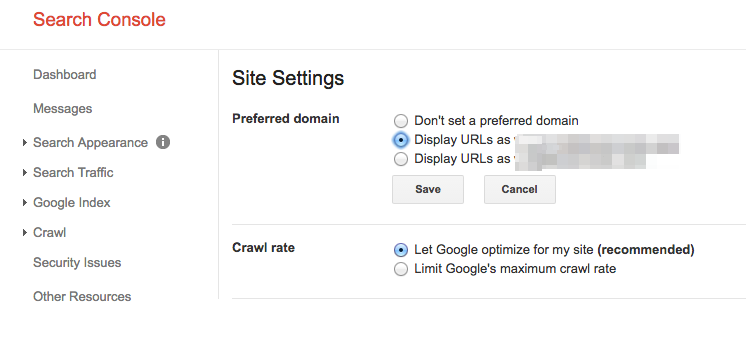

Imposta un dominio preferito

Dall’aggiornamento Panda, è utile chiarire ai motori di ricerca il dominio preferito. Aiuta anche ad assicurarsi che tutti i tuoi link stiano dando un amore extra ad un sito invece di essere sparsi su due siti.

Come risolvere:

- In Google Search Console, clicca sull’icona dell’ingranaggio nell’angolo in alto a destra.

- Scegli quale degli URL è il dominio preferito.

- Non è necessario impostare il dominio preferito in Bing Webmaster Tools, basta inviare la mappa del sito per aiutare Bing a determinare il dominio preferito.

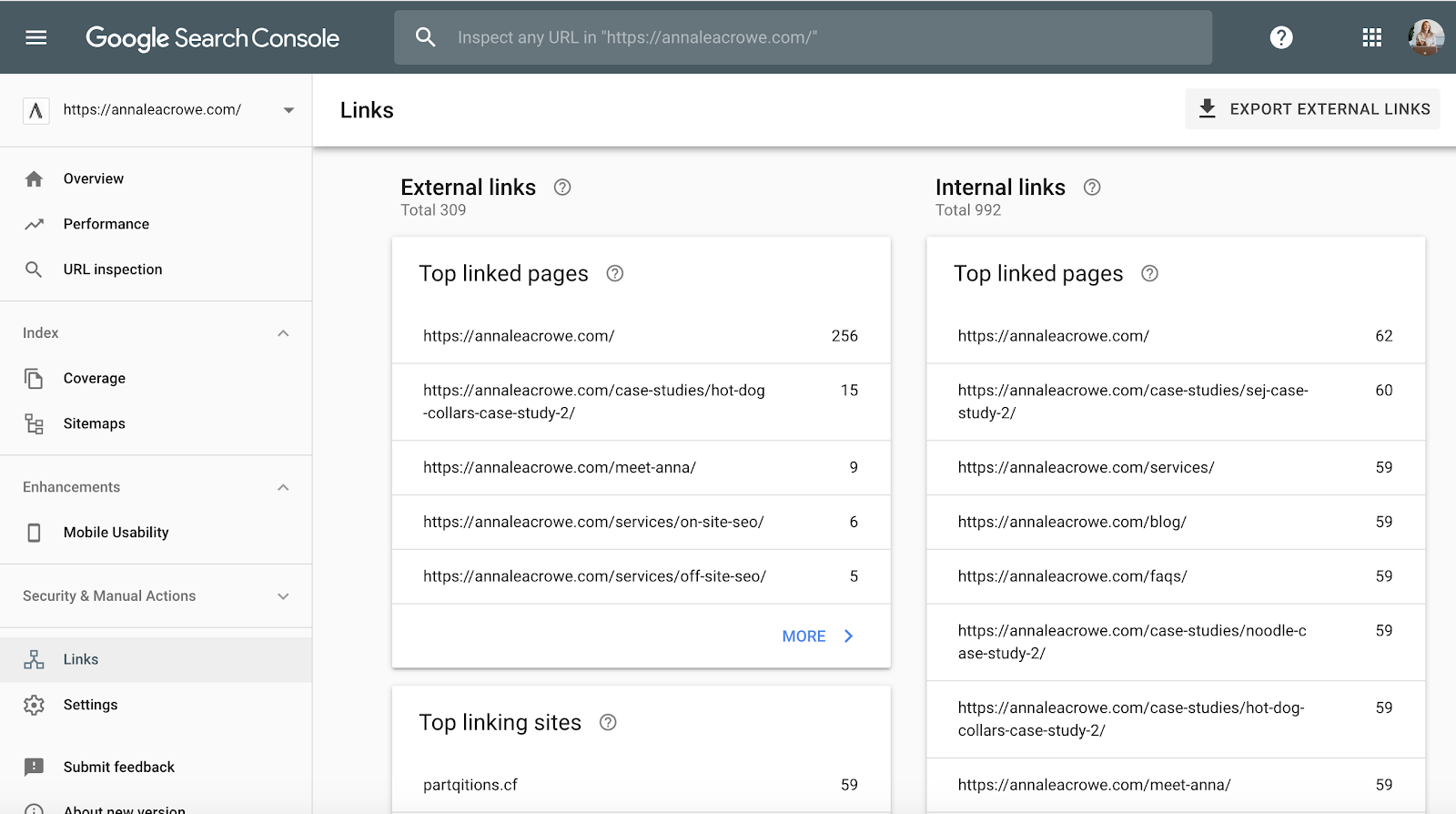

Backlinks

Con l’annuncio che Penguin è in tempo reale, è vitale che i backlinks del vostro cliente soddisfino gli standard di Google.

Se notate una grande quantità di backlinks che arrivano al sito del vostro cliente da una pagina di un sito web, vorrete prendere le misure necessarie per ripulirlo, e velocemente!

Come risolvere:

- In Google Search Console, vai a Links > poi ordina i tuoi Top linking sites.

- Contatta le aziende che ti stanno linkando da una pagina per far rimuovere i link.

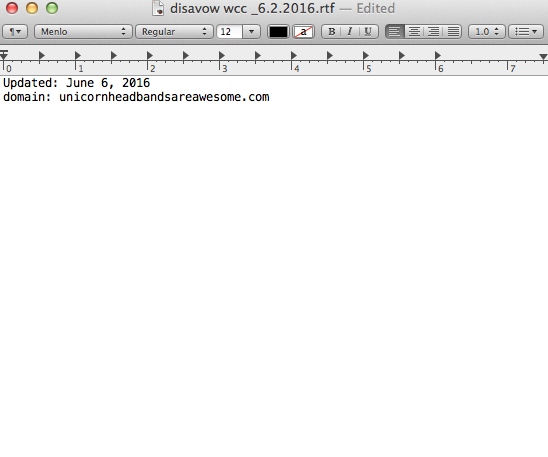

- Oppure, aggiungile alla tua lista di disavow. Quando aggiungete le aziende alla vostra lista di rinnegamento, fate molta attenzione a come e perché lo fate. Non vuoi rimuovere link preziosi.

Ecco un esempio di come appare il mio file di disavow:

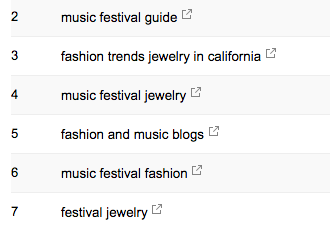

Keywords

Keywords

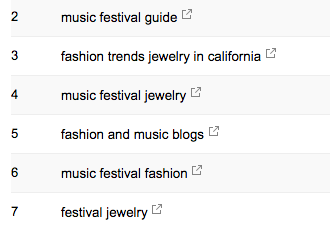

Come consulente SEO, è il mio lavoro iniziare a conoscere il panorama del mercato del mio cliente. Ho bisogno di sapere chi è il loro pubblico di riferimento, cosa cercano e come lo cercano. Per iniziare, do un’occhiata ai termini di ricerca delle parole chiave da cui stanno già ottenendo traffico.

- In Google Search Console, sotto Traffico di ricerca > Search Analytics vi mostrerà quali parole chiave stanno già inviando click al vostro cliente.

Sitemap

Sitemap

Le sitemaps sono essenziali per far sì che i motori di ricerca scansionino il sito del tuo cliente. Parlano la loro lingua. Quando si creano le sitemaps, ci sono alcune cose da sapere:

- Non includere URL di parametri nella sitemap.

- Non includere pagine non indicizzabili.

- Se il sito ha sottodomini diversi per mobile e desktop, aggiungere il tag rel=”alternate” alla sitemap.

Come risolvere:

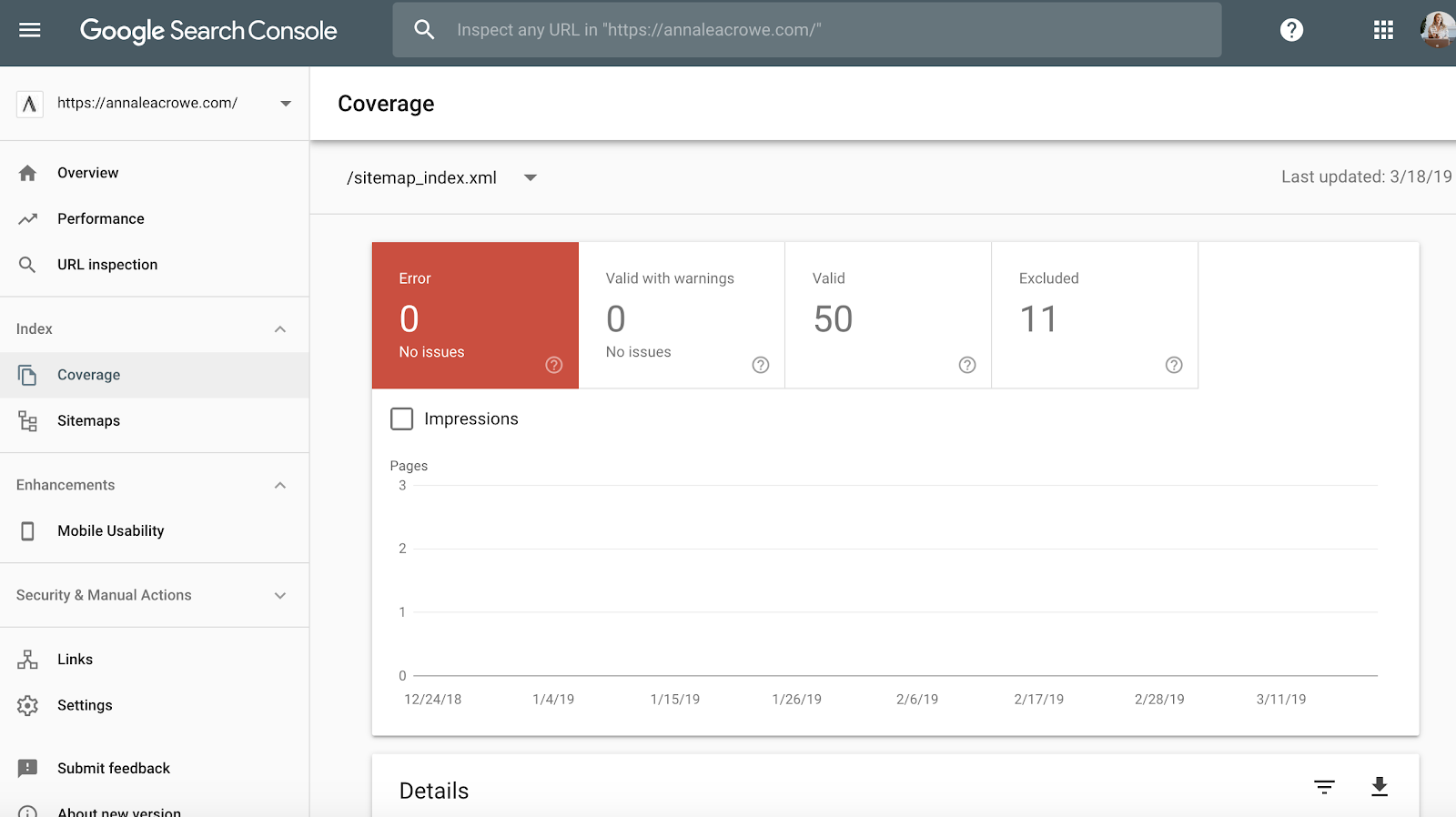

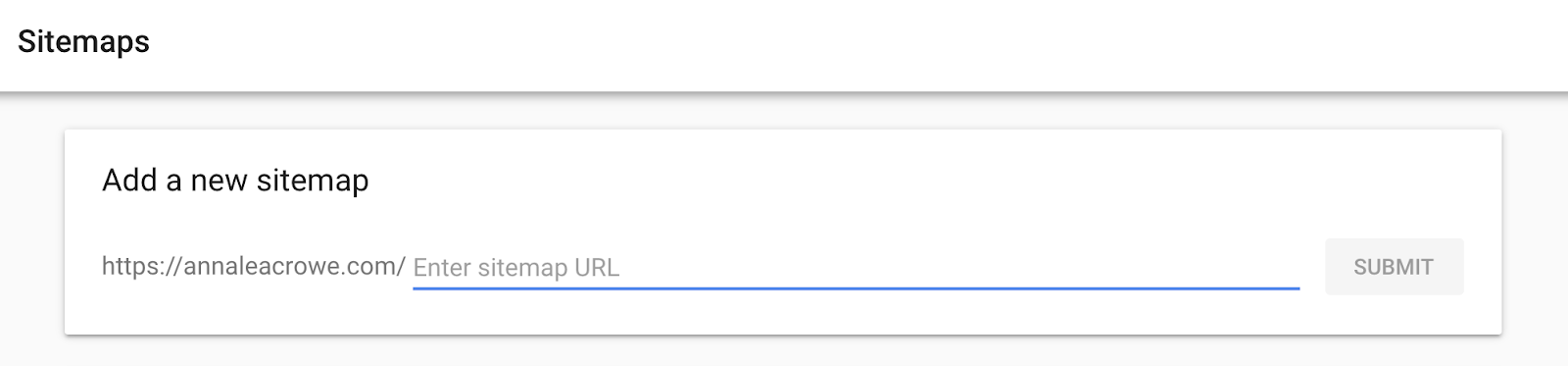

- Vai a Google Search Console > Indice > Sitemaps per confrontare gli URL indicizzati nella sitemap con gli URL nell’indice web.

- Poi, fai una ricerca manuale per determinare le pagine che non vengono indicizzate e perché.

- Se trovi vecchi URL reindirizzati nella sitemap del tuo cliente, rimuovili. Questi vecchi reindirizzamenti avranno un impatto negativo sul tuo SEO se non li rimuovi.

- Se il cliente è nuovo, invia una nuova sitemap per loro sia in Bing Webmaster Tools che in Google Search Console.

Crawl

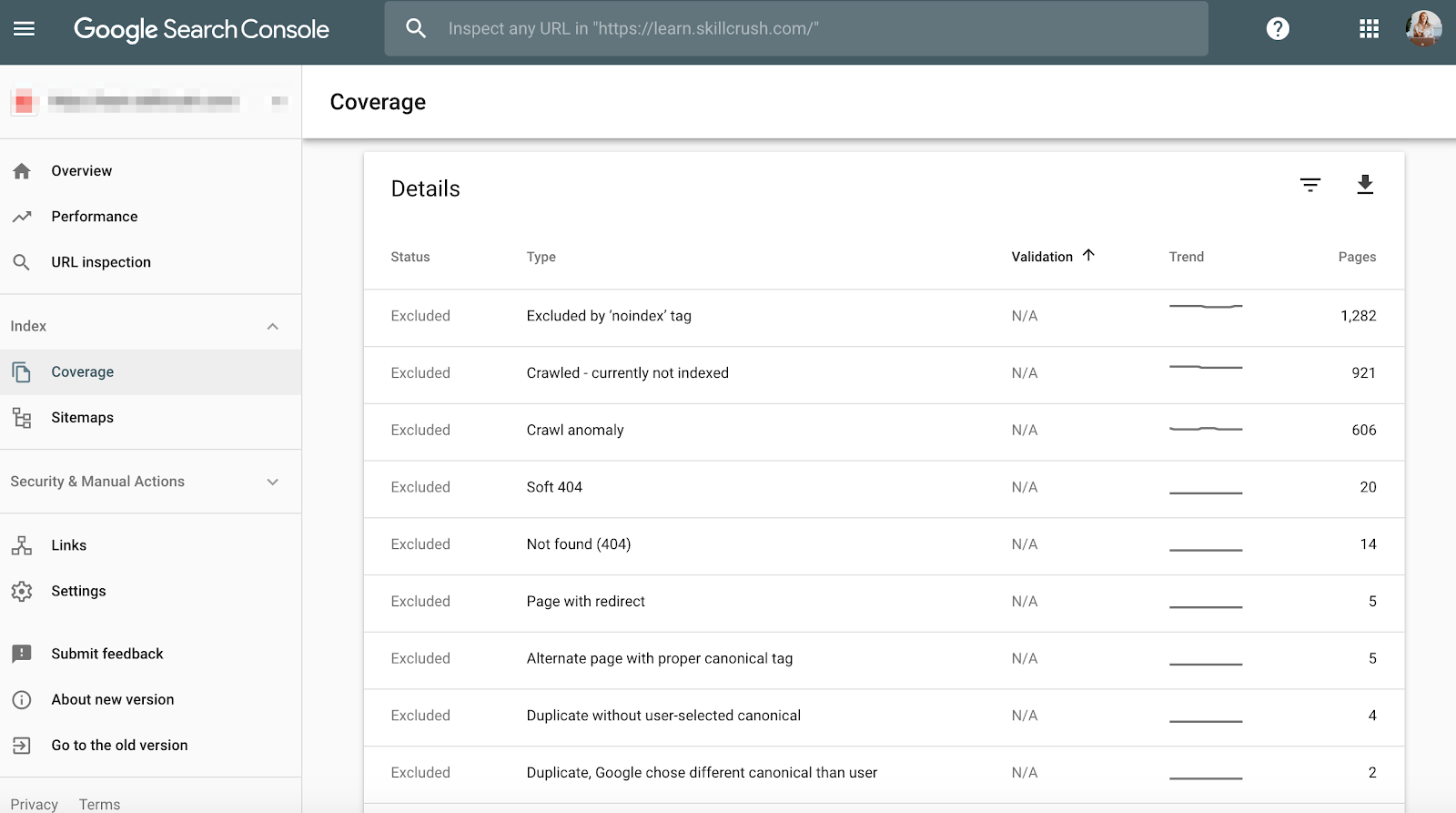

Gli errori di Crawl sono importanti da controllare perché non è solo un male per l’utente, ma è un male per il ranking del tuo sito. E, John Mueller ha dichiarato che un basso tasso di crawl può essere un segno di un sito di bassa qualità.

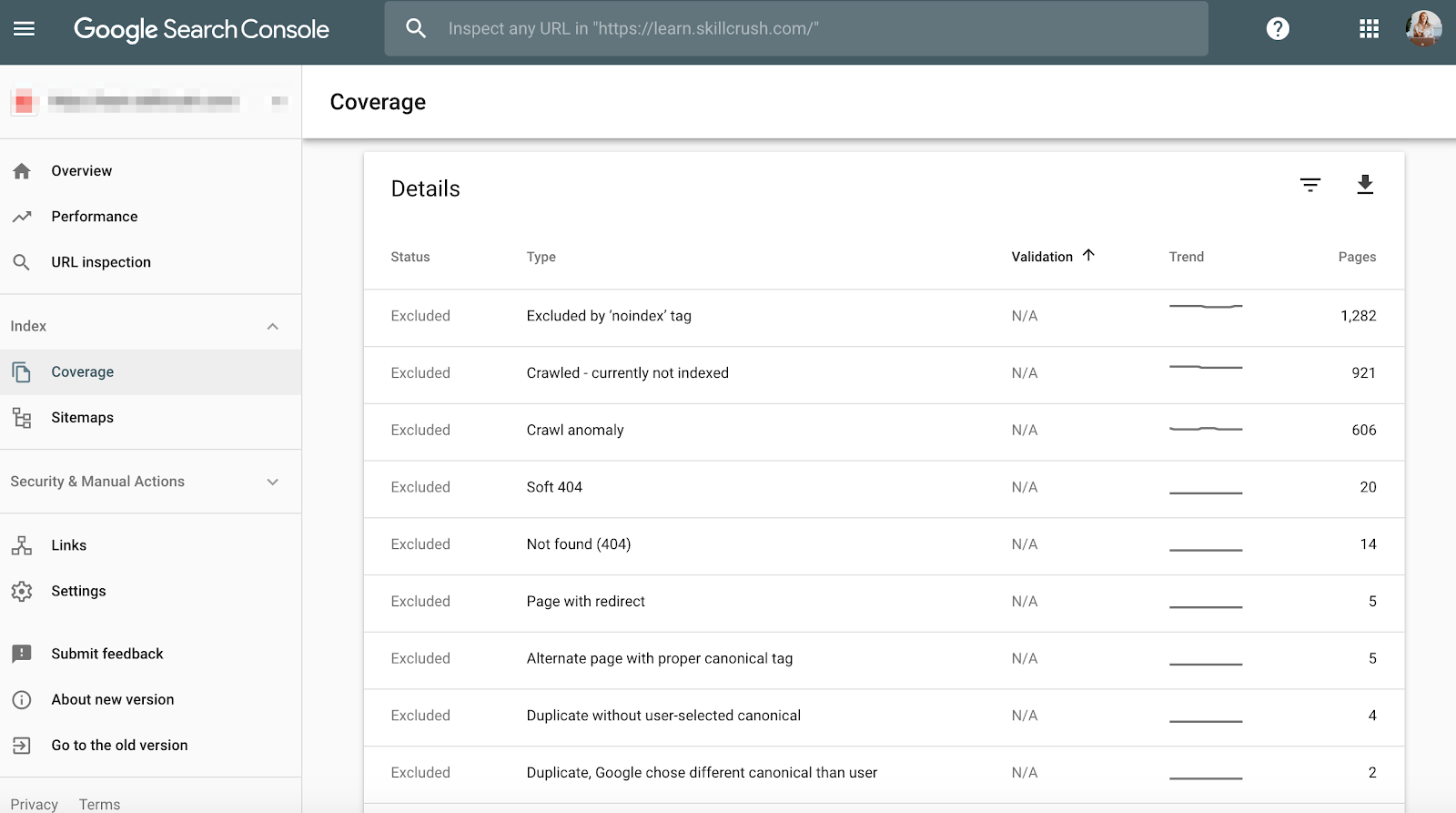

Per controllare questo in Google Search Console, vai a Copertura > Dettagli.

Per controllare questo in Bing Webmaster Tools, vai a Reports & Data > Crawl Information.

Come risolvere:

- Controlla manualmente gli errori di crawl per determinare se ci sono errori di crawl provenienti da vecchi prodotti che non esistono più o se vedi errori di crawl che dovrebbero essere vietati nel file robots.txt.

- Una volta determinato da dove provengono, è possibile implementare reindirizzamenti 301 a pagine simili che si collegano alle pagine morte.

- Vorrete anche fare un controllo incrociato delle statistiche di crawl in Google Search Console con il tempo medio di caricamento in Google Analytics per vedere se c’è una correlazione tra il tempo trascorso a scaricare e le pagine scansionate al giorno.

Dati strutturati

Come menzionato sopra nella sezione schema di Screaming Frog, puoi rivedere il markup schema del tuo cliente in Google Search Console.

Utilizza il rapporto sullo stato dei risultati ricchi individuali in Google Search Console. (Nota: il rapporto sui dati strutturati non è più disponibile).

Questo ti aiuterà a determinare quali pagine hanno errori di dati strutturati che dovrai correggere lungo la strada.

Come risolvere:

- Google Search Console vi dirà cosa manca nello schema quando testate la versione live.

- In base ai vostri codici di errore, riscrivete lo schema in un editor di testo e inviatelo al team di sviluppo web per aggiornarlo. Io uso Sublime Text per la mia modifica del testo. Gli utenti Mac ne hanno uno incorporato e gli utenti PC possono usare YouTube comprato da Google.

Step 3: Rivedere Google Analytics

Tools:

- Google Analytics.

- Google Tag Manager Assistant Chrome Extension.

- Guida all’etichettatura delle campagne di Annie Cushing.

Visualizzazioni

Quando ricevo un nuovo cliente per la prima volta, imposto 3 diverse visualizzazioni in Google Analytics.

- Vista di segnalazione.

- Vista principale.

- Vista di prova.

Queste diverse viste mi danno la flessibilità di apportare modifiche senza influenzare i dati.

Come risolvere:

- In Google Analytics, vai su Admin > View > View Settings per creare le tre diverse viste sopra.

- Assicurati di controllare la sezione Bot Filtering per escludere tutte le visite da bot e spider.

- Collega Google Ads e Google Search Console.

- Infine, assicurati che il Site search Tracking sia attivato.

Filtro

Vuoi assicurarti di aggiungere il tuo indirizzo IP e l’indirizzo IP del tuo cliente ai filtri di Google Analytics in modo da non ricevere traffico falso.

Come risolvere:

- Vai in Admin> Visualizza > Filtri

- Poi, le impostazioni dovrebbero essere impostate su Escludi > traffico dagli indirizzi IP > che sono uguali a.

Codice di tracciamento

Codice di tracciamento

Puoi controllare manualmente il codice sorgente, o puoi usare la mia tecnica Screaming Frog di sopra.

Se il codice c’è, vorrai controllare che stia sparando in tempo reale.

- Per controllare questo, vai sul sito del tuo cliente e clicca un po’ in giro sul sito.

- Poi vai su Google Analytics > Real-Time > Locations, la tua posizione dovrebbe comparire.

- Se stai usando Google Tag Manager, puoi anche controllare questo con l’estensione Chrome di Google Tag Assistant.

Come risolvere:

- Se il codice non si attiva, dovrai controllare lo snippet di codice per assicurarti che sia quello corretto. Se stai gestendo più siti, potresti aver aggiunto il codice di un altro sito.

- Prima di copiare il codice, usa un editor di testo, non un elaboratore di testi per copiare lo snippet sul sito. Questo può causare caratteri extra o spazi bianchi.

- Le funzioni sono sensibili alle maiuscole, quindi controlla che tutto sia minuscolo nel codice.

Indicizzazione

Se hai avuto la possibilità di giocare in Google Search Console, probabilmente hai notato la sezione Coverage.

Quando sto controllando un cliente, esamino la loro indicizzazione in Google Search Console rispetto a Google Analytics. Ecco come:

- In Google Search Console, vai a Copertura

- In Google Analytics, vai a Acquisizione > Canali > Ricerca organica > Landing Page.

- Una volta che sei qui, vai su Avanzate >Uso del sito > Sessioni > 9.

Come risolvere:

- Confronta i numeri di Google Search Console con i numeri di Google Analytics, se i numeri sono molto diversi, allora sai che anche se le pagine vengono indicizzate solo una frazione riceve traffico organico.

Campaign Tagging

L’ultima cosa che vorrai controllare in Google Analytics è se il tuo cliente sta usando correttamente il campaign tagging. Non vuoi non ricevere credito per il lavoro che stai facendo perché ti sei dimenticato del campaign tagging.

Come risolvere:

- Imposta una strategia di campaign tagging per Google Analytics e condividila con il tuo cliente. Annie Cushing ha messo insieme una fantastica guida al tagging delle campagne.

- Imposta l’Event Tracking se il tuo cliente sta usando annunci mobili o video.

Parole chiave

Puoi usare Google Analytics per ottenere informazioni su potenziali gemme di parole chiave per il tuo cliente. Per trovare le parole chiave in Google Analytics, segui questi passi:

Vai a Google Analytics > Comportamento > Ricerca nel sito > Termini di ricerca. Questo ti darà una visione di ciò che i clienti stanno cercando sul sito web.

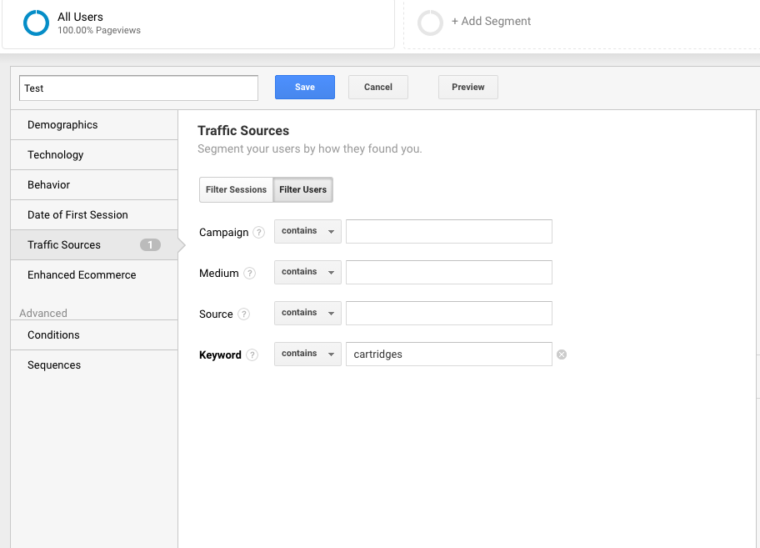

Poi, userò questi termini di ricerca per creare un nuovo segmento in Google Analytics per vedere quali pagine del sito sono già in classifica per quel particolare termine chiave.

Step 4: Controllo manuale

Strumenti:

- Google Analytics.

- Accesso al server e all’host del cliente.

- You Get Signal.

- Pingdom.

- PageSpeed Tools.

- Wayback Machine.

Una versione del sito del tuo cliente è ricercabile

Controlla tutti i diversi modi in cui puoi cercare un sito web. Per esempio:

- http://annaisaunicorn.com

- https://annaisaunicorn.com

- http://www.annaisaunicorn.com

Come direbbe Highlander, “ci può essere solo un” sito web che è ricercabile.

Come risolvere: Utilizzare un reindirizzamento 301 per tutti gli URL che non sono il sito primario al sito canonico.

Individuazione

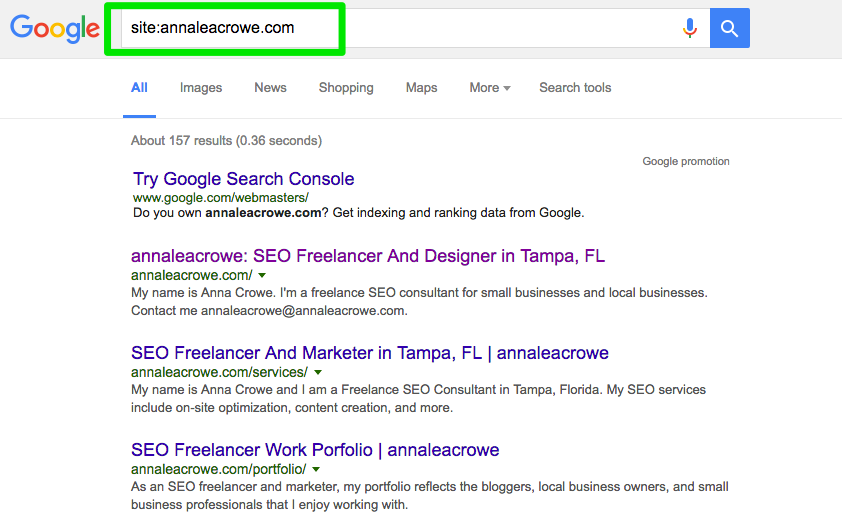

Condurre una ricerca manuale in Google e Bing per determinare quante pagine sono state indicizzate da Google. Questo numero non è sempre accurato con i dati di Google Analytics e Google Search Console, ma dovrebbe darti una stima approssimativa.

Per controllare, fai quanto segue:

- Esegui una ricerca del sito nei motori di ricerca.

- Quando cercate, fate una scansione manuale per assicurarvi che appaia solo il marchio del vostro cliente.

- Verificate che la homepage sia sulla prima pagina. John Mueller ha detto che non è necessario che la homepage appaia come primo risultato.

Come risolvere:

- Se un altro marchio appare nei risultati di ricerca, hai un problema più grande tra le mani. Vorrai immergerti nell’analisi per diagnosticare il problema.

- Se la homepage non appare come primo risultato, esegui un controllo manuale del sito per vedere cosa manca. Questo potrebbe anche significare che il sito ha una penalizzazione o una cattiva architettura del sito che è un problema più grande di riprogettazione del sito.

- Controlla il numero di pagine di destinazione organiche in Google Analytics per vedere se corrisponde al numero di risultati di ricerca che hai visto nel motore di ricerca. Questo può aiutarvi a determinare quali pagine i motori di ricerca vedono come preziose.

Caching

Eseguo un rapido controllo per vedere se le pagine più importanti vengono memorizzate nella cache da Google. Google usa queste pagine nella cache per collegare i tuoi contenuti alle query di ricerca.

Per controllare se Google sta memorizzando nella cache le pagine del tuo cliente, fai così:

http://webcache.googleusercontent.com/search?q=cache:https://www.searchenginejournal.com/pubcon-day-3-women-in-digital-amazon-analytics/176005/

Assicurati di passare alla versione solo testo.

Puoi anche controllare questo in Wayback Machine.

Come risolvere:

- Controlla il server del client per vedere se è giù o funziona più lentamente del solito. Potrebbe esserci un errore interno del server o un errore di connessione al database. Questo può accadere se più utenti stanno tentando di accedere al server contemporaneamente.

- Controlla per vedere chi altro è sul tuo server con un controllo dell’indirizzo IP inverso. Puoi usare il sito You Get Signal per questa fase. Potresti aver bisogno di aggiornare il server del tuo cliente o iniziare a usare un CDN se hai domini schizzati che condividono il server.

- Controlla se il cliente sta rimuovendo pagine specifiche dal sito.

Hosting

Mentre questo può diventare un po’ tecnico per alcuni, è vitale per il tuo successo SEO controllare il software di hosting associato al sito del tuo cliente. L’hosting può danneggiare il SEO e tutto il tuo duro lavoro sarà inutile.

Hai bisogno di accedere al server del tuo cliente per controllare manualmente qualsiasi problema. I problemi di hosting più comuni che vedo sono avere il TLD sbagliato e la velocità lenta del sito.

Come risolvere:

- Se il tuo cliente ha il TLD sbagliato, devi assicurarti che l’indirizzo IP del paese sia associato al paese in cui il tuo cliente opera maggiormente. Se il vostro cliente ha un dominio .co e anche un dominio .com, allora vorrete reindirizzare il .co al dominio primario del vostro cliente sul .com.

- Se il vostro cliente ha una velocità lenta del sito, vorrete affrontarlo rapidamente perché la velocità del sito è un fattore di ranking. Scoprite cosa sta rendendo il sito lento con strumenti come PageSpeed Tools e Pingdom. Ecco uno sguardo ad alcuni dei comuni problemi di velocità della pagina:

- Host.

- Immagini grandi.

- Video incorporati.

- Plugins.

- Ads.

- Theme.

- Widgets.

- Script ripetitivi o codice denso.

Core Web Vitals Audit

Core Web Vitals è una raccolta di tre metriche che sono rappresentative dell’esperienza utente di un sito web. Sono importanti perché Google sta aggiornando i suoi algoritmi nella primavera del 2021 per incorporare Core Web Vitals come un fattore di ranking.

Anche se il fattore di ranking dovrebbe essere un piccolo fattore, è ancora importante controllare i punteggi Core Web Vitals e identificare le aree di miglioramento.

Perché è importante includere Core Web Vitals nel tuo audit?

Migliorare i punteggi Core Web Vitals non solo aiuterà il ranking di ricerca, ma forse più importante, potrebbe ripagare con più conversioni e guadagni.

I miglioramenti della velocità e delle prestazioni della pagina sono associati a maggiori vendite, traffico e click pubblicitari.

Migliorare l’hosting web e installare un nuovo plugin può migliorare la velocità della pagina ma avrà poco (se non nessun) effetto sul Core Web Vitals.

La misurazione è fatta nel punto in cui qualcuno sta letteralmente scaricando il tuo sito sul suo cellulare.

Questo significa che il collo di bottiglia è alla loro connessione Internet e il dispositivo mobile. Un server veloce non accelererà una connessione Internet lenta su un telefono cellulare economico.

Similmente, poiché molte delle soluzioni coinvolgono la modifica del codice in un template o i file principali del sistema di gestione dei contenuti stesso, un plugin per la velocità della pagina sarà di pochissima utilità.

Ci sono molte risorse per aiutare a capire le soluzioni. Ma la maggior parte delle soluzioni richiede l’assistenza di uno sviluppatore che si senta a proprio agio nell’aggiornare e modificare i file di base del vostro sistema di gestione dei contenuti.

La risoluzione dei problemi di Core Web Vitals può essere difficile. WordPress, Drupal e altri sistemi di gestione dei contenuti (CMS) non sono stati costruiti per ottenere un buon punteggio per Core Web Vitals.

È importante notare che il processo per migliorare Core Web Vitals comporta la modifica della codifica nel nucleo di WordPress e altri CMS.

In sostanza, migliorare Core Web Vitals richiede di far fare a un sito web qualcosa che non è mai stato destinato a fare quando gli sviluppatori hanno creato un tema o un CMS.

Lo scopo di una verifica del Core Web Vitals è quello di identificare ciò che deve essere corretto e consegnare queste informazioni a uno sviluppatore che può quindi apportare le modifiche necessarie.

Cosa sono i Core Web Vitals?

I Core Web Vitals consistono in tre metriche che collettivamente identificano quanto velocemente la parte più importante della tua pagina viene caricata, quanto velocemente un utente può interagire con la pagina (esempio: cliccare un pulsante), e quanto velocemente ci vuole perché la pagina web diventi stabile senza che gli elementi della pagina si spostino.

Ci sono:

- Largest Contentful Paint (LCP).

- First Input Delay (FID).

- Cumulative Layout Shift (CLS).

Ci sono due tipi di punteggi per il Core Web Vitals:

- Dati di laboratorio.

- Dati di campo.

Dati di laboratorio

I dati di laboratorio sono quelli che vengono generati quando si esegue una pagina attraverso Google Lighthouse o in PageSpeed Insights.

I dati di laboratorio consistono in punteggi generati attraverso un dispositivo e una connessione Internet simulati. Lo scopo è quello di dare alla persona che lavora sul sito un’idea di quali parti del Core Web Vitals hanno bisogno di miglioramenti.

Il valore di uno strumento come PageSpeed Insights è che identifica il codice specifico e gli elementi della pagina che stanno causando un punteggio scarso.

Field Data

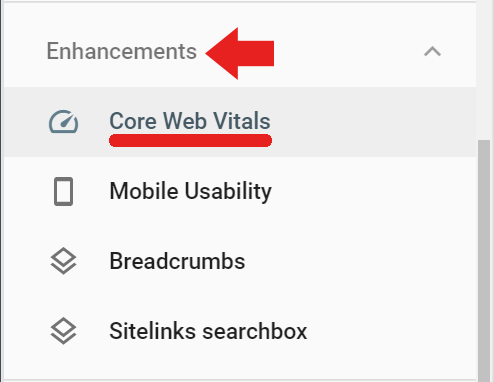

Field Data sono reali punteggi Core Web Vitals che sono stati raccolti dal browser Google Chrome per il Chrome User Experience Report (noto anche come CrUX).

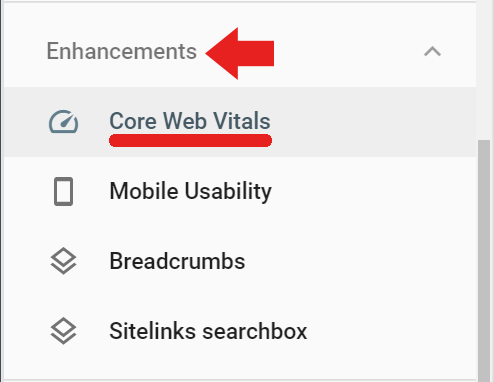

I dati di campo sono disponibili in Google Search Console sotto la scheda Miglioramenti tramite il link etichettato Core Web Vitals (i dati di campo sono accessibili anche tramite questo link) https://search.google.com/search-console/core-web-vitals.

I dati dei campi riportati in Google Search Console provengono da pagine visitate che hanno avuto una quantità minima di visite e misurazioni. Se Google non riceve abbastanza punteggi allora Google Search Console non riporterà quel punteggio.

Screaming Frog per Core Web Vitals Audit

Screaming Frog versione 14.2 ha ora la possibilità di visualizzare una valutazione Core Web Vitals passata o fallita. Hai bisogno di connettere Screaming Frog all’API di PageSpeed Insights (ottieni una chiave API qui) tramite una chiave.

Per registrare la tua chiave API di Page Speed Insights con Screaming Frog, prima naviga in Configurazione > Accesso API > PageSpeed Insights

Lì, vedrai un posto per inserire la tua chiave API e collegarla al servizio.

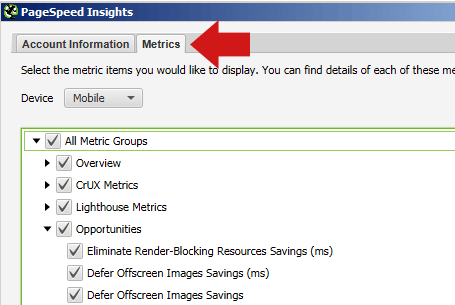

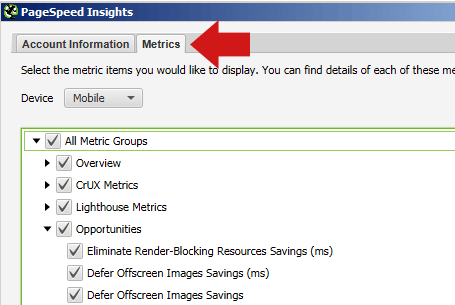

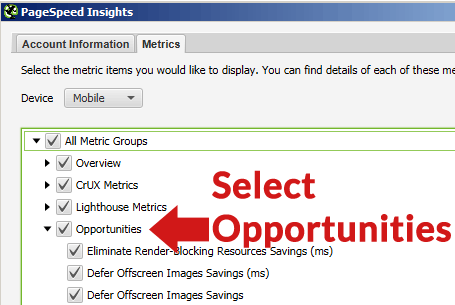

Nello stesso popup di PageSpeed Insights, puoi anche selezionare la scheda Metriche e spuntare le caselle che indicano le metriche che vorresti fossero riportate.

Assicurati di selezionare Mobile per il dispositivo, perché è la metrica che conta ai fini del ranking.

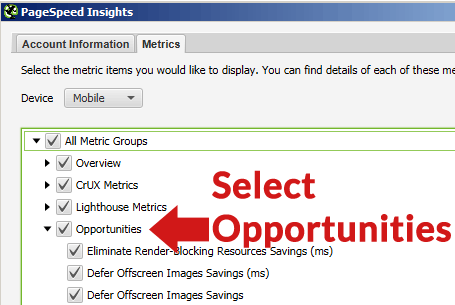

Se selezioni la scheda Opportunità, dopo il crawl Screaming Frog ti mostrerà una lista di diversi tipi di miglioramenti (come rinviare immagini fuori dallo schermo, rimuovere CSS inutilizzati, ecc.)

Nota prima della scansione

In genere non è necessario scansionare un intero sito e produrre un esaustivo resoconto pagina per pagina di ciò che non va in ogni singola pagina del sito.

Prima di eseguire la scansione, si può prendere in considerazione la scansione di un gruppo rappresentativo di pagine. Per fare questo, selezionate prima un gruppo di pagine che rappresentano i tipi di pagine comuni ad ogni sezione o categoria del sito web. Crea un foglio di calcolo, un elenco di file di testo o incolla manualmente gli URL utilizzando la scheda Carica in Screaming Frog.

La maggior parte dei siti contiene pagine e post creati con una struttura di pagina e contenuti simili. Per esempio, tutte le pagine in una categoria “notizie” saranno abbastanza simili, le pagine in una categoria “recensioni” saranno anche simili tra loro.

Potete risparmiare tempo scansionando un gruppo rappresentativo di pagine per identificare i problemi comuni alle singole categorie e i problemi comuni a tutte le pagine del sito che devono essere risolti.

A causa di queste somiglianze, i problemi scoperti saranno simili. Potrebbe essere necessario scansionare solo una manciata di pagine rappresentative di ogni tipo di categoria per identificare quali tipi di problemi sono specifici di ciascuna di queste sezioni.

I tipi di cose che vengono risolti sono tipicamente problemi dell’intero sito che sono comuni a tutto il sito, come CSS inutilizzato che viene caricato da ogni pagina o Cumulative Layout Shift causato da un’unità pubblicitaria situata nella zona sinistra delle pagine web.

Perché i siti web moderni sono templati, le correzioni avverranno a livello di template o con codifica personalizzata nel foglio di stile, ecc.

Crawl il sito con Screaming Frog

Una volta che gli URL sono completamente scansionati, è possibile fare clic sulla scheda PageSpeed e leggere tutte le raccomandazioni e visualizzare le notazioni pass/fail per le varie metriche.

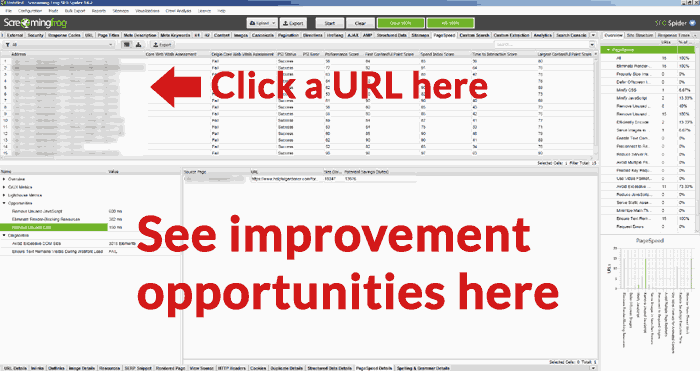

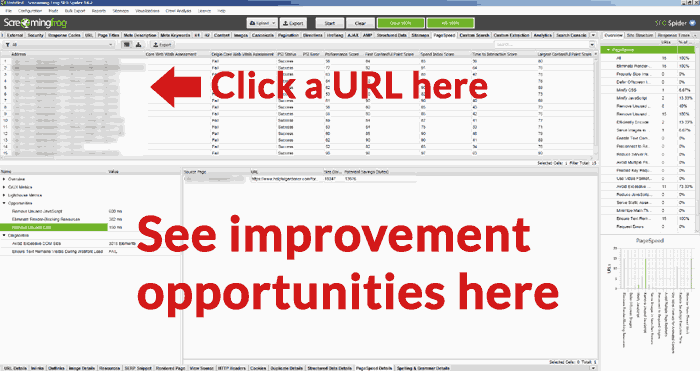

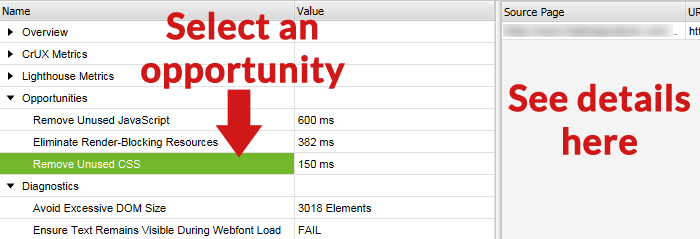

Zoom In sulle opportunità degli URL

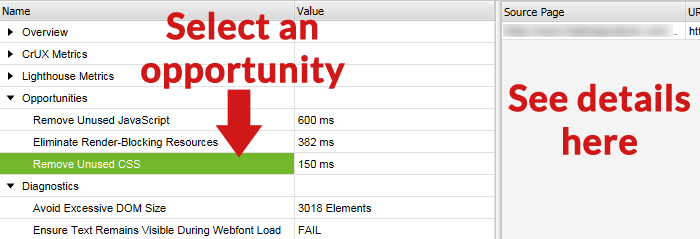

Una caratteristica utile in Screaming Frog Core Web Vitals Audit è la possibilità di selezionare un URL dalla lista degli URL nel pannello superiore e poi vedere le opportunità di miglioramento nel pannello inferiore dello schermo di Screaming Frog.

Sotto c’è uno screenshot della schermata inferiore, con un’opportunità selezionata e i dettagli di quella opportunità di miglioramento nel pannello di destra.

Tool ufficiale di Google

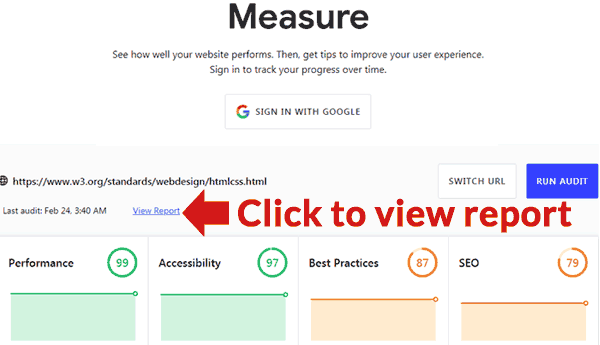

Google ha pubblicato uno strumento che può fornire un audit. Si trova qui: https://web.dev/measure/

Inserire un URL per una panoramica delle prestazioni della pagina. Se hai effettuato l’accesso, Google monitorerà la pagina per te nel tempo. Facendo clic sul link Visualizza rapporto si aprirà una nuova pagina contenente un rapporto con i dettagli di ciò che non va e i link alle guide che mostrano come risolvere ogni problema.