Jag tänker inte ljuga:

Och som SEO-konsult finns det få sötare ord än: ”Din granskning ser bra ut! När kan vi ta dig ombord?”

Även om du inte aktivt har letat efter ett nytt jobb, är det en enorm egohöjning att veta att din SEO-granskning var perfekt.

Men är du livrädd för att börja? Är detta din första SEO-granskning? Eller kanske vet du bara inte var du ska börja?

Att skicka en fantastisk SEO-revision till en potentiell kund ger dig bästa möjliga förutsättningar.

Så ta dig tid. Kom ihåg: Ditt primära mål är att ge kunden mervärde med dina webbplatsrekommendationer på både kort och lång sikt.

I den här kolumnen har jag sammanställt de nödvändiga stegen för att genomföra en SEO-granskning och en liten inblick i den första fasen av mina processer när jag först får en ny kund. Den är uppdelad i avsnitt nedan. Om du känner att du har ett bra grepp om ett visst avsnitt är du välkommen att hoppa till nästa.

När ska jag utföra en SEO-revision?

När en potentiell kund skickar mig ett e-postmeddelande där han eller hon uttrycker sitt intresse för ett samarbete och svarar på min enkät, ordnar vi ett inledande samtal (Skype eller Google Hangouts är att föredra).

För samtalet gör jag min egen mini-snabb SEO-revision (jag investerar minst en timme i manuell research) utifrån deras enkätsvar för att bekanta mig med deras marknadslandskap. Det är som att dejta någon du aldrig har träffat.

Du kommer självklart att förfölja dem på Facebook, Twitter, Instagram och alla andra kanaler som är offentliga #soIcreep.

Här är ett exempel på hur min enkät ser ut:

Det här är några nyckelfrågor som du vill ställa till klienten under det första mötet:

- Vilka är dina övergripande affärsmål? Vilka är era kanalmål (PR, sociala medier osv.)?

- Vem är er målgrupp?

- Har ni några affärspartnerskap?

- Hur ofta uppdateras webbplatsen? Har ni en webbutvecklare eller en IT-avdelning?

- Har ni arbetat med en SEO-konsult tidigare? Eller har du haft SEO-arbete tidigare?

Sujan Patel har också några bra rekommendationer om frågor att ställa till en ny SEO-kund.

Efter samtalet, om jag känner att vi passar ihop, skickar jag över mitt formella förslag och kontrakt (tack till HelloSign för att du gör det här till en enkel process för mig!).

För att börja vill jag alltid erbjuda mina klienter den första månaden som en provperiod för att se till att vi vibrerar.

Detta ger både klienten och jag en chans att bli vänner först innan vi dejtar. Under den här månaden tar jag mig tid att genomföra en djupgående SEO-revision.

Dessa SEO-revisioner kan ta mig allt från 40 timmar till 60 timmar beroende på webbplatsens storlek. Dessa revisioner är indelade i tre separata delar och presenteras med Google Slides.

- Tekniskt:

- Innehåll: Sökordsforskning, konkurrentanalys, innehållskartor, metadata etc.

- Länkar: Efter den första månaden, om kunden gillar mitt arbete, börjar vi genomföra rekommendationerna från SEO-revisionen. Och framöver utför jag en minirevision varje månad och en djupgående revision kvartalsvis.

För att sammanfatta utför jag en SEO-revision för mina kunder:

- Första månaden.

- Månadsvis (minirevision).

- Kvartalsvis (djupgående revision).

Vad du behöver från en klient före en SEO-revision

När en klient och jag börjar arbeta tillsammans delar jag ett Google Doc med dem och begär en lista över lösenord och leverantörer.

Detta inkluderar:

- Google Analytics-åtkomst och eventuella analysverktyg från tredje part.

- Google och Bing-annonser.

- Webmaster-verktyg.

- Högsta åtkomst till webbplatsens backend.

- Sociala mediekonton.

- Lista över leverantörer.

- Lista över interna teammedlemmar (inklusive allt arbete som de lägger ut på entreprenad).

Verktyg för SEO-granskning

Innan du påbörjar din SEO-granskning, kommer här en sammanfattning av de verktyg jag använder:

- Screaming Frog.

- Integrity (för Mac-användare) och Xenu Sleuth (för PC-användare).

- SEO Browser.

- Wayback Machine.

- Moz.

- BuzzSumo.

- DeepCrawl.

- Copyscape.

- Google Tag Manager.

- Google Tag Manager Chrome Extension.

- Annie Cushing’s Campaign Tagging Guide.

- Google Analytics (om tillgång ges).

- Google Search Console (om tillgång ges).

- Bing Webmaster Tools (om tillgång ges).

- You Get Signal.

- Pingdom.

- PageSpeed Tool.

- Sublime Text.

Uppförande av en teknisk SEO-granskning

Verktyg som behövs för teknisk SEO-granskning:

AdvertiseringFortsätt läsa nedan- Screaming Frog.

- DeepCrawl.

- Copyscape.

- Integrity för Mac (eller Xenu Sleuth för PC-användare).

- Google Analytics (om tillgång ges).

- Google Search Console (om tillgång ges).

- Bing Webmaster Tools (om tillgång ges).

Steg 1: Lägg till webbplatsen i DeepCrawl och Screaming Frog

Verktyg:

- DeepCrawl.

- Copyscape.

- Screaming Frog.

- Google Analytics.

- Integrity.

- Google Tag Manager.

- Google Analytics-kod.

Vad man ska leta efter när man använder DeepCrawl

Det första jag gör är att lägga till min kunds webbplats i DeepCrawl. Beroende på hur stor klientens webbplats är kan det ta en dag eller två innan resultaten kommer tillbaka.

När du får tillbaka DeepCrawl-resultaten är det här de saker jag letar efter:

ReklamFortsätt läsa nedanDuplicerat innehåll

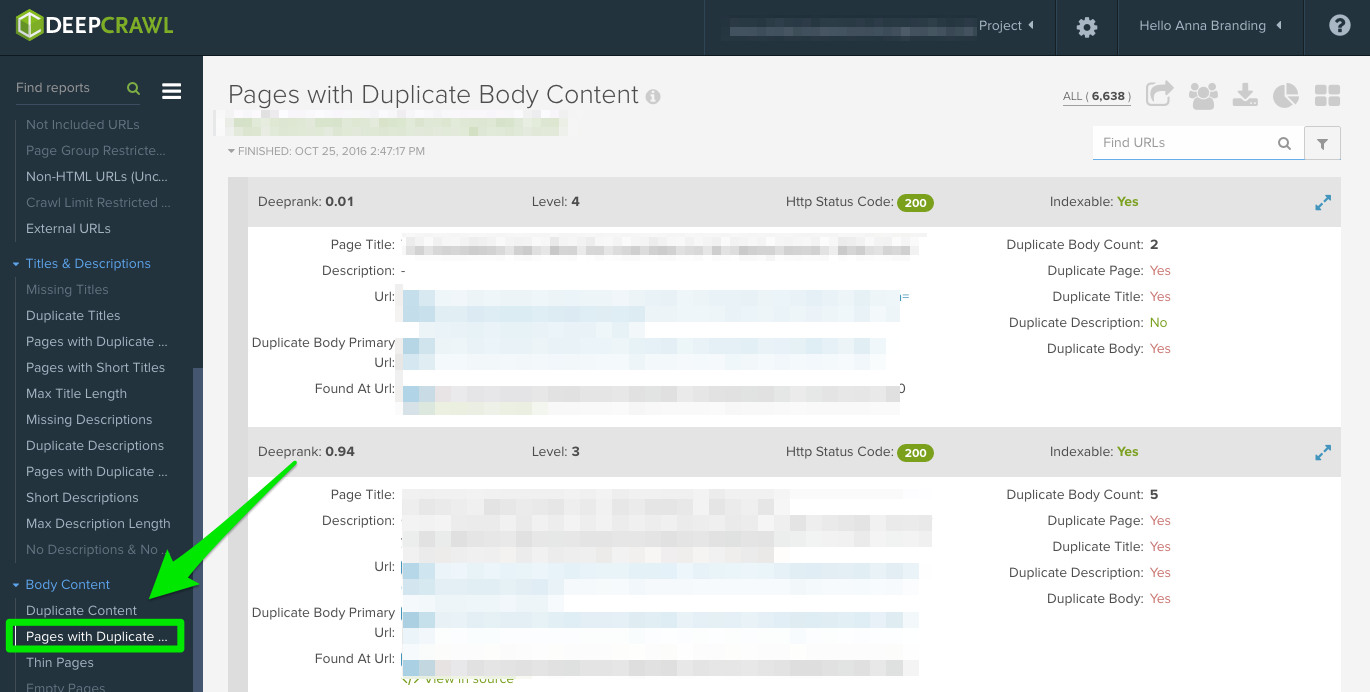

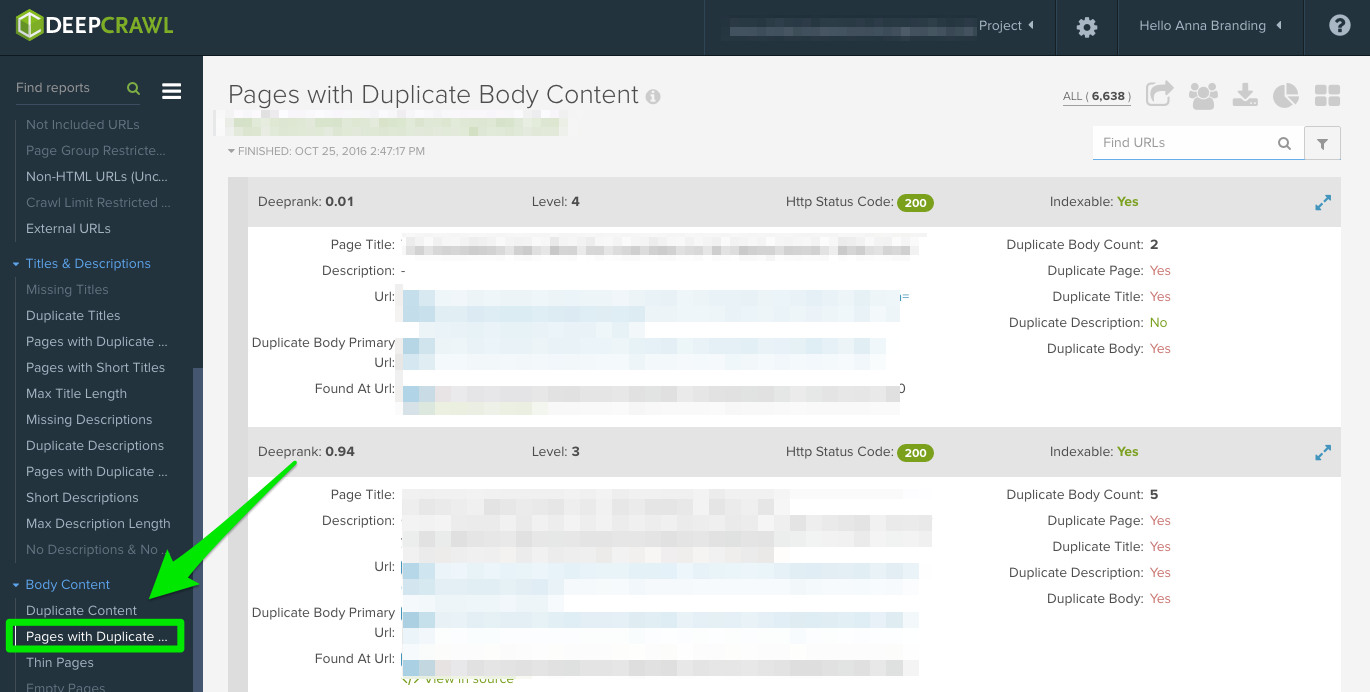

Kontrollera rapporten ”Duplicerade sidor” för att hitta duplicerat innehåll.

Om duplicerat innehåll identifieras gör jag detta till högsta prioritet i mina rekommendationer till kunden om att skriva om sidorna, och under tiden lägger jag till <meta name=”robots” content=”noindex, nofollow”>-taggen på de duplicerade sidorna.

Högre vanliga fel med duplicerat innehåll som du upptäcker:

- Duplicerade metatitlar och metabeskrivningar.

- Duplicerat kroppsinnehåll från taggade sidor (jag kommer att använda Copyscape för att avgöra om något plagieras).

- Två domäner (t.ex. yourwebsite.co, yourwebsite.com).

- Subdomäner (t.ex. jobs.yourwebsite.com).

- Samma innehåll på en annan domän.

- Otillräckligt implementerade pagineringssidor (se nedan.)

Hur du åtgärdar:

- Lägg till den kanoniska taggen på dina sidor för att låta Google veta vad du vill att din föredragna webbadress ska vara.

- Disallow felaktiga webbadresser i robotarna.txt.

- Förny skriv om innehållet (inklusive text och metadata).

Här är ett exempel på ett problem med duplicerat innehåll som jag hade med en av mina kunder. Som du kan se nedan hade de URL-parametrar utan den kanoniska taggen.

Detta är de steg som jag tog för att åtgärda problemet:

- Jag fixade eventuella 301-omdirigeringsproblem.

- Läggde till en kanonisk tagg till sidan jag vill att Google ska crawla.

- Uppdatera parameterinställningarna i Google Search Console så att parametrar som inte genererar unikt innehåll utesluts.

ReklamFortsätt läsa nedan- Lagt till disallow-funktionen till robots.txt till de felaktiga webbadresserna för att förbättra crawlbudgeten.

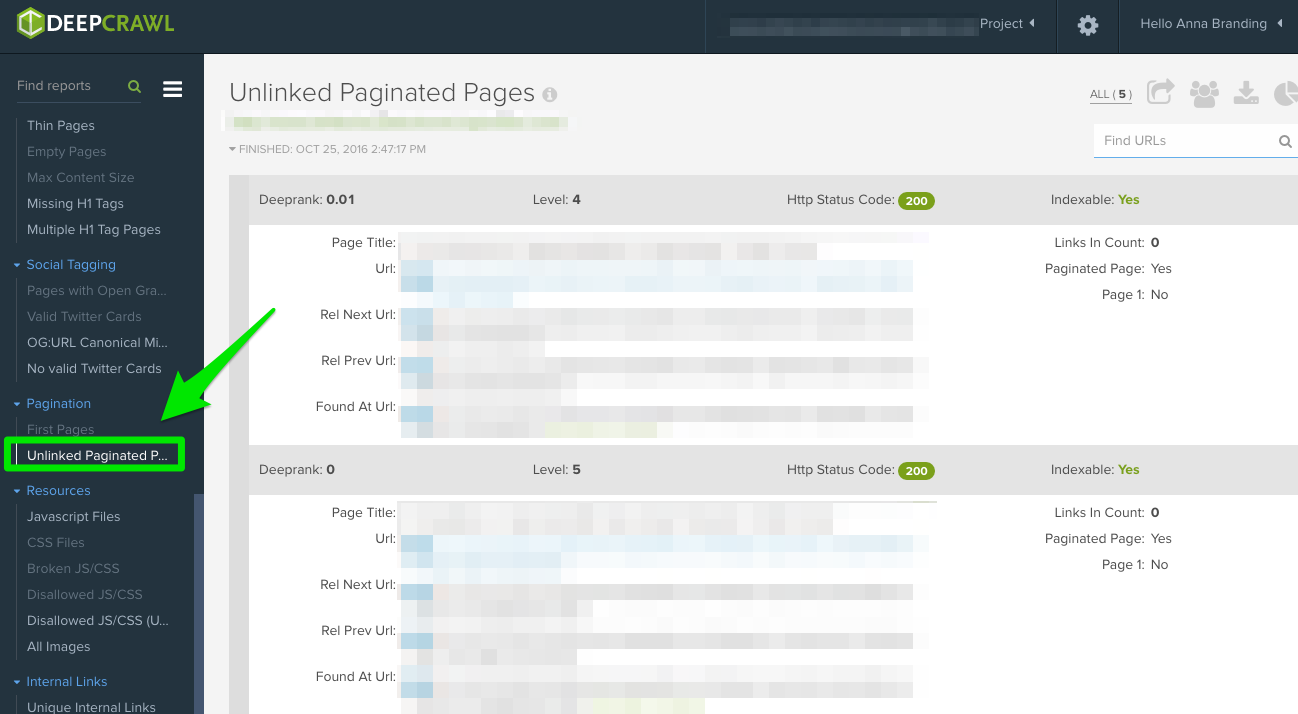

Paginering

Det finns två rapporter att kolla upp:

- First Pages: Om du vill ta reda på vilka sidor som använder sidnumrering, kan du granska rapporten ”First Pages” (första sidorna). Därefter kan du manuellt granska de sidor som använder detta på webbplatsen för att ta reda på om paginering har implementerats på rätt sätt.

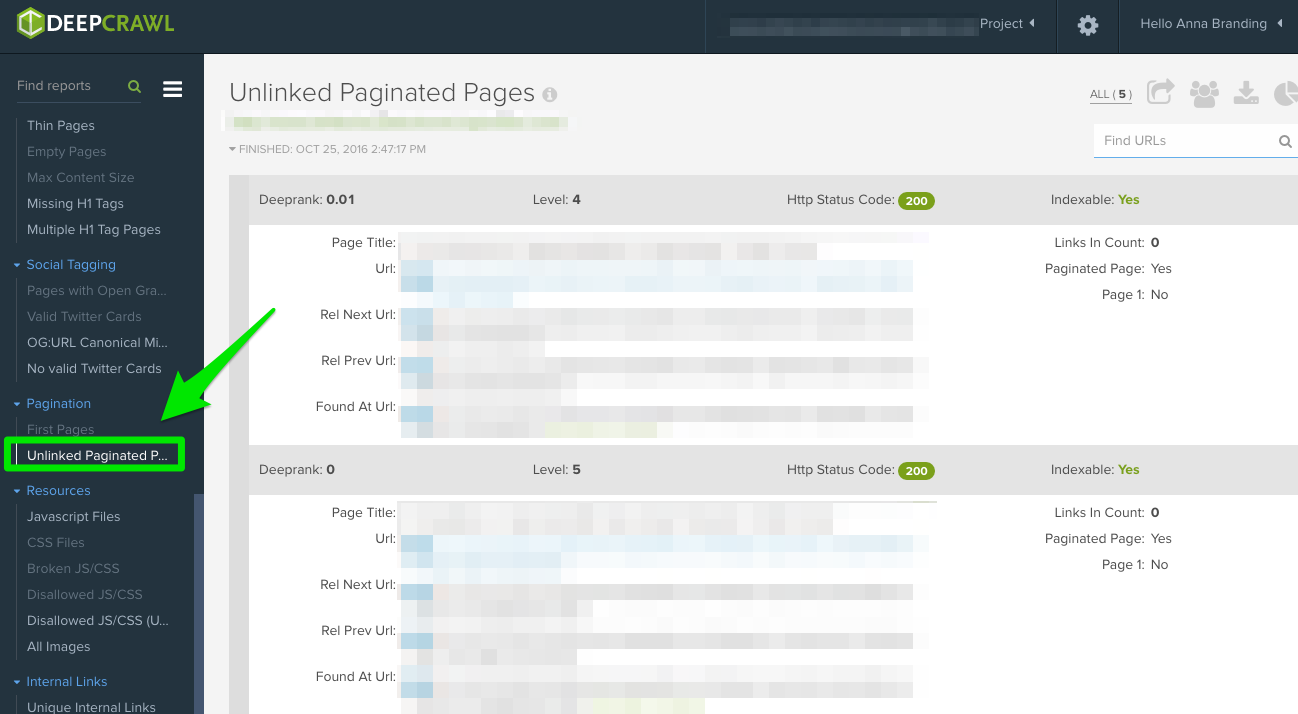

- Okopplade pagineringssidor: Om du vill ta reda på om paginering fungerar korrekt kan du med hjälp av rapporten ”Unlinked Pagination Pages” se om rel=”next” och rel=”prev” länkar till föregående och nästa sida.

I det här exemplet nedan kunde jag med hjälp av DeepCrawl konstatera att en kund hade ömsesidiga pagineringstaggar:

Hur man åtgärdar detta:

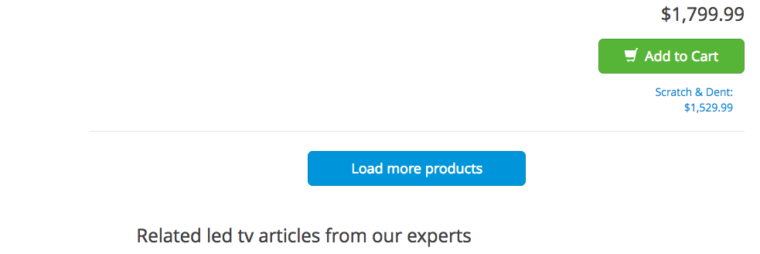

- Om du har en ”view all”- eller en ”load more”-sida, lägg till rel=”canonical”-taggen. Här är ett exempel från Crutchfield:

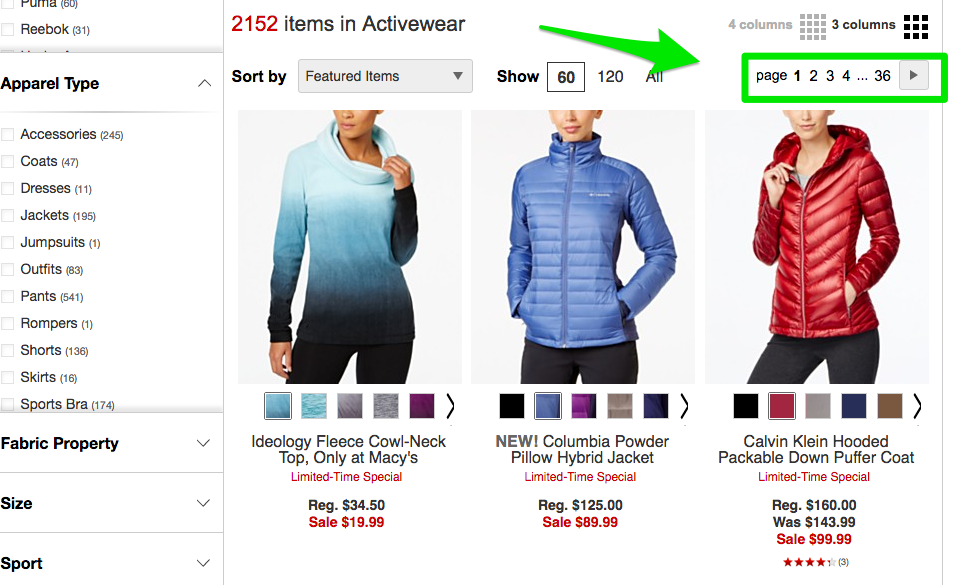

- Om du har alla dina sidor på separata sidor lägger du till standardmarkörerna rel=”next” och rel=”prev”. Här är ett exempel från Macy’s:

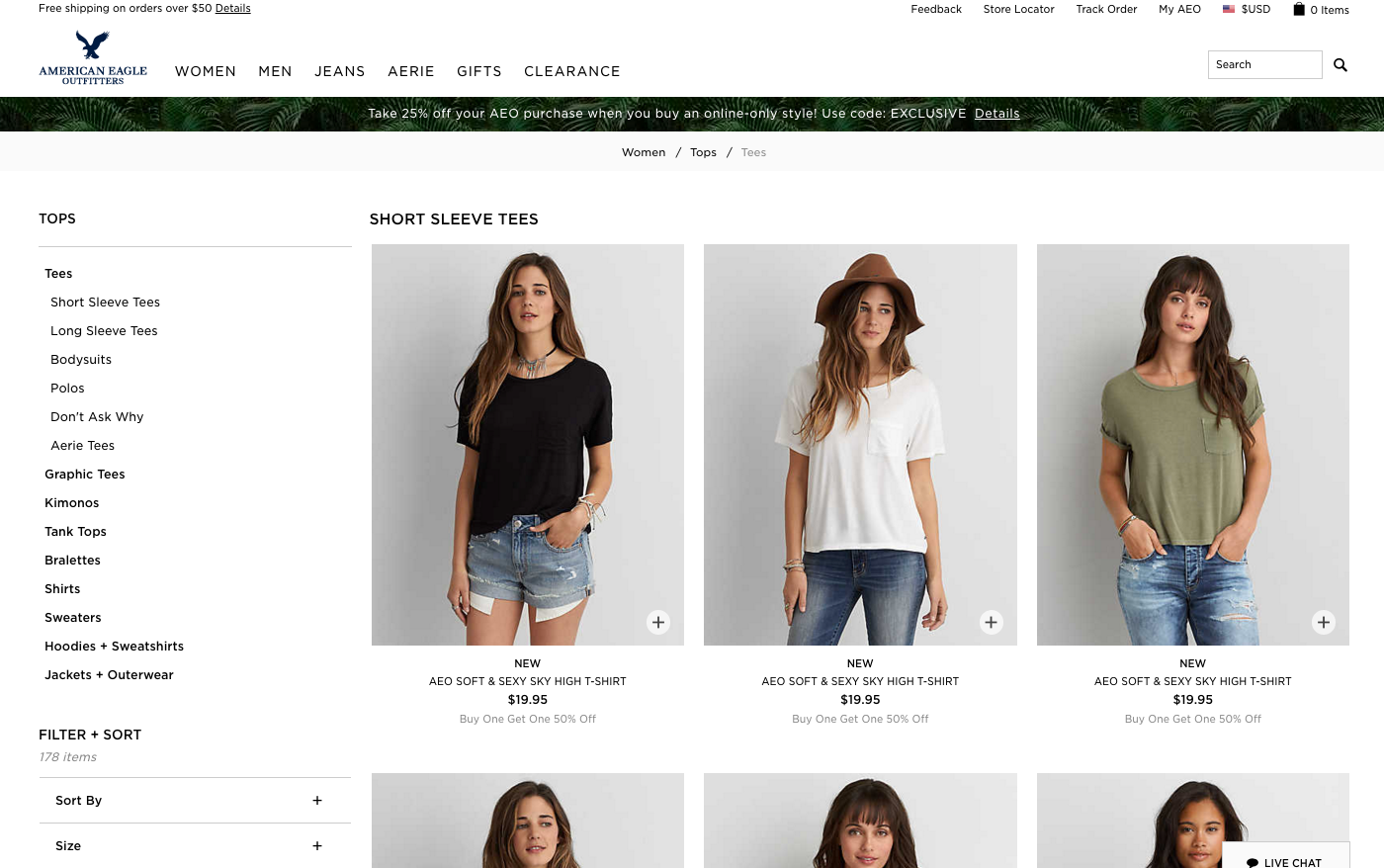

- Om du använder oändlig rullning lägger du till motsvarande URL för paginerade sidor i ditt javascript. Här är ett exempel från American Eagle.

Max Redirections

Se rapporten ”Max Redirections” för att se alla sidor som omdirigeras mer än fyra gånger. John Mueller nämnde 2015 att Google kan sluta följa omdirigeringar om de är fler än fem.

Vidare vissa hänvisar till dessa crawlfel som att de äter upp ”crawlbudgeten”, men Gary Illyes hänvisar till detta som ”värdbelastning”. Det är viktigt att se till att dina sidor återges korrekt eftersom du vill att värdbelastningen ska användas effektivt.

ReklamFortsätt läsa nedanHär är en kort översikt över de svarskoder som du kan få se:

- 301 – Det här är majoriteten av de koder som du kommer att se under hela din undersökning. 301-omdirigeringar är okej så länge det bara finns en omdirigering och ingen omdirigeringsslinga.

- 302 – Dessa koder är okej, men om de ligger kvar längre än tre månader eller så skulle jag manuellt ändra dem till 301:or så att de är permanenta. Detta är en felkod som jag ofta ser på e-handelssajter när en produkt inte finns i lager.

- 400 – Användarna kan inte komma till sidan.

- 403 – Användarna har inte behörighet att komma till sidan.

- 404 – Sidan hittas inte (vilket vanligtvis innebär att kunden raderat en sida utan 301-redirect).

- 500 – Internt serverfel som du måste kontakta webbutvecklingsteamet för att fastställa orsaken.

Hur du åtgärdar:

- Ta bort alla interna länkar som pekar på gamla 404-sidor och uppdatera dem med den omdirigerade sidans interna länk.

- Bortskaffa omdirigeringskedjorna genom att ta bort de mellersta omdirigeringarna. Om till exempel omdirigering A går till omdirigering B, C och D vill du ångra omdirigeringarna B och C. Slutresultatet blir en omdirigering A till D.

- Det finns också ett sätt att göra detta i Screaming Frog och Google Search Console nedan om du använder den versionen.

Vad man ska leta efter när man använder Screaming Frog

Det andra jag gör när jag får en ny kundwebbplats är att lägga till deras webbadress i Screaming Frog.

Avhängigt av storleken på kundens webbplats kan jag konfigurera inställningarna så att jag crawlar specifika områden av webbplatsen åt gången.

ReklamFortsätt läsa nedanHär är hur mina Screaming Frog spindelkonfigurationer ser ut:

Du kan göra detta i inställningarna för spindeln eller genom att utesluta områden på webbplatsen.

När du får tillbaka dina Screaming Frog-resultat är det här de saker jag letar efter:

Google Analytics-kod

Screaming Frog kan hjälpa dig att identifiera vilka sidor som saknar Google Analytics-kod (UA-1234568-9). För att hitta den saknade Google Analytics-koden följer du de här stegen:

AdvertissementFortsätt läsa nedan- Gå till Konfigurering i navigeringsfältet och sedan Anpassad.

- Lägg till analytics\.js till Filter 1 och ändra sedan rullgardinsmenyn till Innehåller inte.

Hur du åtgärdar detta:

- Kontakta kundens utvecklare och be dem lägga till koden på de specifika sidor där den saknas.

- För mer information om Google Analytics går du vidare till avsnittet om Google Analytics nedan.

Google Tag Manager

Screaming Frog kan också hjälpa dig att ta reda på vilka sidor som saknar Google Tag Manager-snippet med liknande steg:

- Gå till fliken Konfigurering i navigeringsfältet och sedan Anpassad.

- Lägg till <iframe src-”//www.googletagmanager.com/ med Does not contain markerad i Filter.

Hur du åtgärdar:

- Hoppa över till Google Tag Manager för att se om det finns några fel och uppdatera vid behov.

- Dela koden med kundens utvecklare för att se om de kan lägga till den igen på webbplatsen.

Schema

Du vill också kontrollera om kundens webbplats använder schemamärkning på sin webbplats. Schema eller strukturerade data hjälper sökmotorerna att förstå vad en sida är på webbplatsen.

För att kontrollera om det finns schemamärkning i Screaming Frog följer du de här stegen:

ReklamFortsätt läsa nedan- Gå till fliken Konfigurering i navigeringsfältet och sedan Anpassad.

- Lägg till itemtype=”http://schema.\.org/ med ”Contain” markerad i Filter.

Indexering

Indexering

Du vill avgöra hur många sidor som indexeras för din kund, följ detta i Screaming Frog:

- När webbplatsen har laddats i Screaming Frog går du till Directives > Filter > Index för att se om det saknas några kodbitar.

Hur man åtgärdar:

- Om webbplatsen är ny kan det hända att Google inte har indexerat den ännu.

- Kontrollera robotarna.txt-filen för att se till att du inte förbjuder något som du vill att Google ska kryssa.

- Kontrollera att du har skickat in kundens webbplatskarta till Google Search Console och Bing Webmaster Tools.

- Företa manuell sökning (se nedan).

Flash

Google meddelade 2016 att Chrome kommer att börja blockera Flash på grund av de långsamma sidladdningstiderna. Så om du gör en revision vill du identifiera om din nya kund använder Flash eller inte.

För att göra detta i Screaming Frog kan du prova detta:

AdvertisementFortsätt läsa nedan- Hoppa upp till Spindelkonfiguration i navigeringen.

- Klicka på Kontrollera SWF.

- Filtrera den interna fliken med Flash efter att krypningen är klar.

Hur du åtgärdar:

- Bädda in videor från YouTube. Google köpte YouTube 2006, det är en självklarhet.

- Och välj HTML5-standarder när du lägger till en video.

Här är ett exempel på HTML5-kod för att lägga till en video:

<video controls="controls" width="320" height="240">> <source class="hiddenSpellError" data-mce-bogus="1" />src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.mp4" type="video/mp4"> <source src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.ogg" type="video/ogg" />Your browser does not support the video tag.</video>

JavaScript

Enligt Googles tillkännagivande 2015 är det okej att använda JavaScript på din webbplats så länge du inte blockerar något i din robots.txt (vi kommer att gräva djupare i detta om en stund!). Men du vill ändå ta en titt på hur Javascript levereras till din webbplats.

ReklamFortsätt läsa nedanHur du åtgärdar:

- Se över Javascript för att se till att det inte blockeras av robotar.txt

- Se till att Javascript körs på servern (detta hjälper till att producera data i klartext jämfört med dynamisk).

- Om du kör Angular JavaScript kan du läsa den här artikeln av Ben Oren om varför det kan döda dina SEO-ansträngningar.

- I Screaming Frog går du till Spindelkonfiguration i navigeringsfältet och klickar på Kontrollera JavaScript. Efter att crawlningen är klar filtrerar du resultaten på fliken Intern efter JavaScript.

Robotar.txt

Robotar.txt

När du granskar en robots.txt för första gången vill du se om det är något viktigt som blockeras eller inte tillåts.

Till exempel om du ser den här koden:

User-agent: *Disallow: *Disallow: *Disallow: *Disallow: *Disallow: *

Din klients webbplats är blockerad från alla webcrawlers.

Men om du har något som Zappos robots.txt-fil bör du vara säker.

# Global robots.txt från och med 2012-06-19User-agent: *Disallow: /bin/Disallow: /multiview/Disallow: /product/review/add/Disallow: /cartDisallow: /cartDisallow: /loginDisallow: /logoutDisallow: /registerDisallow: /registerDisallow: /registerDisallow: /registerDisallow: /registerDisallow /account

De blockerar bara det som de inte vill att webcrawlers ska hitta. Detta innehåll som blockeras är inte relevant eller användbart för webcrawlern.

ReklamFortsätt läsa nedanHur du åtgärdar:

- Din robots.txt är skiftlägeskänslig så uppdatera den till små bokstäver.

- Ta bort alla sidor som listas som Disallow och som du vill att sökmotorerna ska kryssa.

- Screaming Frog kommer som standard inte att kunna läsa in webbadresser som är otillåtna enligt robots.txt. Om du väljer att ändra standardinställningarna i Screaming Frog kommer den att ignorera alla robots.txt.

- Du kan också visa blockerade sidor i Screaming Frog under fliken Svarskoder, och sedan filtreras av filtret Blockerad av Robots.txt efter att du har avslutat din crawl.

- Om du har en webbplats med flera underdomäner bör du ha en separat robots.txt för var och en.

- Se till att webbplatskartan finns med i robots.txt.

Crawlfel

Jag använder DeepCrawl, Screaming Frog och Googles och Bings webmastervärden för att hitta och dubbelkolla mina kunders crawlfel.

För att hitta dina crawlfel i Screaming Frog följer du de här stegen:

- När crawlningen är klar går du till Bulk Reports.

- Rulla ner till Response Codes och exportera sedan felrapporten på serversidan och felrapporten för klienten.

Hur man åtgärdar:

- Klientfelrapporterna bör du själv kunna 301-omdirigera majoriteten av 404-felen i webbplatsens backend.

- Serverfelrapporterna, samarbeta med utvecklingsteamet för att fastställa orsaken. Innan du åtgärdar dessa fel i rotkatalogen ska du se till att säkerhetskopiera webbplatsen. Du kan helt enkelt behöva skapa en ny .html-åtkomstfil eller öka minnesgränsen för PHP.

- Du vill också ta bort alla dessa permanenta omdirigeringar från webbplatskartan och alla interna eller externa länkar.

- Du kan också använda 404 i din URL för att hjälpa till att spåra i Google Analytics.

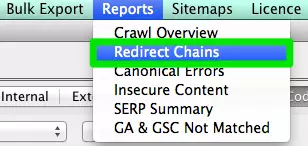

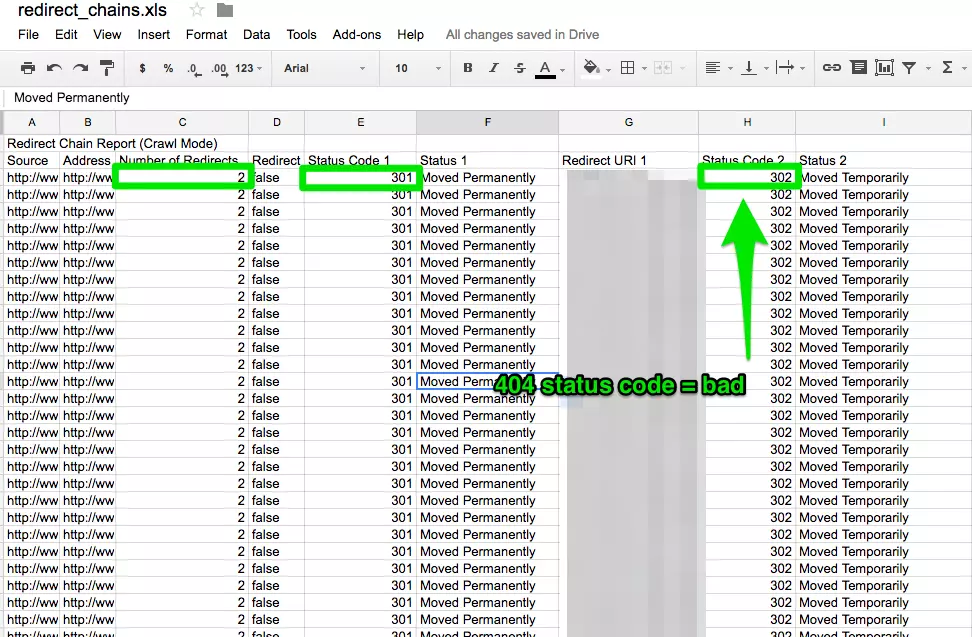

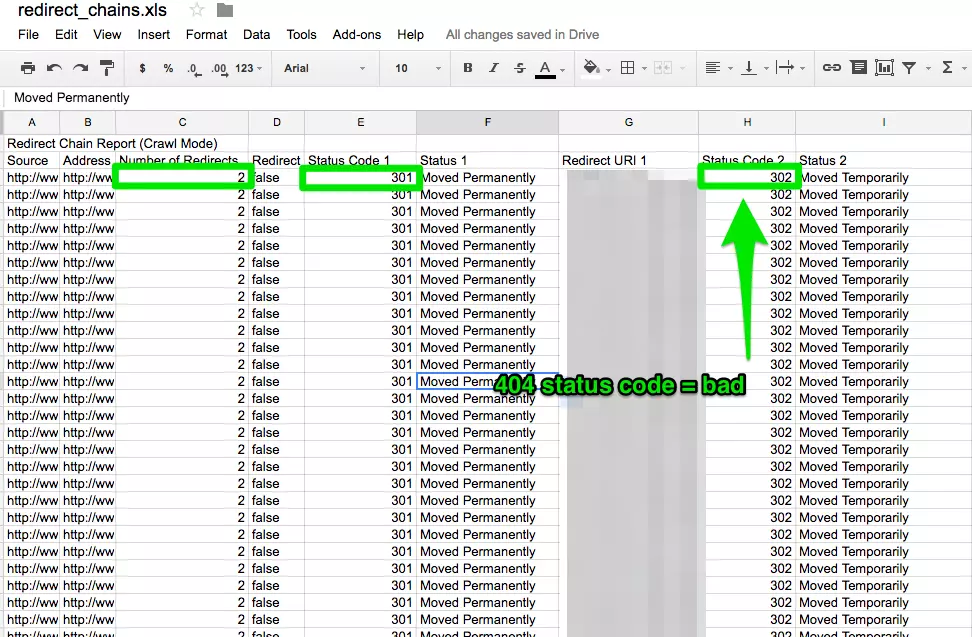

Redirect Chains

Redirect-kedjor orsakar inte bara dålig användarupplevelse, utan det saktar ner sidans hastighet, konverteringsfrekvensen sjunker och alla länkar du kan ha fått tidigare går förlorade.

ReklamFortsätt läsa nedanAtt åtgärda omdirigeringskedjor är en snabb vinst för alla företag.

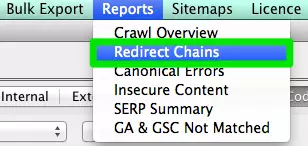

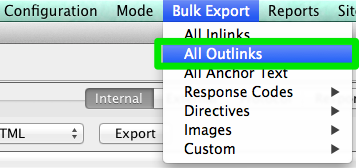

Hur du åtgärdar:

- I Screaming Frog efter att du har slutfört din crawl går du till Rapporter >Redirect Chains för att visa crawlvägen för dina omdirigeringar. I ett Excel-kalkylblad kan du spåra för att se till att dina 301-omdirigeringar är kvarvarande 301-omdirigeringar. Om du ser ett 404-fel bör du städa upp detta.

Intern & Externa länkar

När en användare klickar på en länk till din webbplats och får ett 404-fel, är det ingen bra användarupplevelse.

Och det hjälper inte heller sökmotorerna att tycka bättre om dig.

För att hitta mina trasiga interna och externa länkar använder jag Integrity for Mac. Du kan också använda Xenu Sleuth om du är PC-användare.

ReklamFortsätt läsa nedanJag visar dig också hur du hittar dessa interna och externa länkar i Screaming Frog och DeepCrawl om du använder den programvaran.

Hur du åtgärdar:

- Om du använder Integrity eller Xenu Sleuth, kör din klients webbadress så får du en fullständig lista över trasiga webbadresser. Du kan antingen uppdatera dessa manuellt själv eller om du arbetar med ett utvecklingsteam kan du be dem om hjälp.

- Om du använder Screaming Frog går du till Bulk Export i navigeringsfältet efter avslutad crawlning och sedan till All Outlinks. Du kan sortera efter URL:er och se vilka sidor som skickar en 404-signal. Upprepa samma steg med All Inlinks.

- Om du använder DeepCrawl går du till fliken Unique Broken Links under avsnittet Internal Links.

URLs

Varje gång du tar emot en ny kund vill du se över deras URL-format. Vad letar jag efter i URL:erna?

- Parametrar – Om URL:en har konstiga tecken som ?, = eller + är det en dynamisk URL som kan orsaka duplicerat innehåll om den inte optimeras.

- Användarvänligt – Jag gillar att hålla webbadresserna korta och enkla samtidigt som jag tar bort eventuella extra snedstreck.

Hur man åtgärdar:

- Du kan söka efter parameter-URL:er i Google genom att göra site:www.buyaunicorn.com/ inurl: ”

- När du har kört en crawl på Screaming Frog kan du titta på webbadresserna. Om du ser parametrar som anges och som skapar dubbletter av ditt innehåll måste du föreslå följande:

- Lägg till en kanonisk tagg till den huvudsakliga URL-sidan. Om till exempel www.buyaunicorn.com/magical-headbands är huvudsidan och jag ser www.buyaunicorn.com/magical-headbands/?dir=mode123$ måste den kanoniska taggen läggas till på www.buyaunicorn.com/magical-headbands.

- Uppdatera dina parametrar i Google Search Console under Crawl > URL-parametrar.

- Disallow the duplicate URLs in the robots.txt.

Steg 2: Granska Google Search Console och Bing Webmaster Tools.

Verktyg:

- Google Search Console.

- Bing Webmaster Tools.

- Sublime Text (eller något annat textredigeringsverktyg).

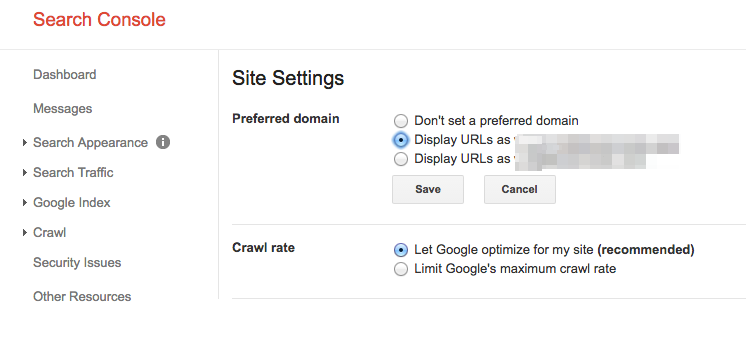

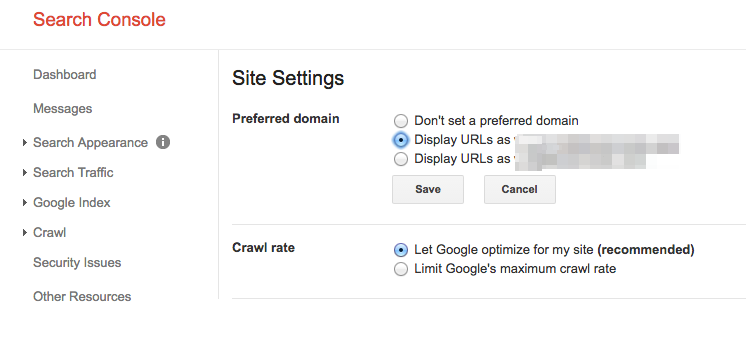

Sätt en föredragen domän

AdvertiseringFortsätt läsa nedanSedan Panda-uppdateringen är det fördelaktigt att klargöra för sökmotorerna vilken domän som föredras. Det hjälper också till att se till att alla dina länkar ger en webbplats extra kärlek i stället för att spridas över två webbplatser.

Hur du åtgärdar:

- I Google Search Console klickar du på kugghjulsikonen i det övre högra hörnet.

- Välj vilken av webbadresserna som är den föredragna domänen.

- Du behöver inte ställa in den föredragna domänen i Bing Webmaster Tools, du behöver bara skicka in din webbplatskarta för att Bing ska kunna fastställa din föredragna domän.

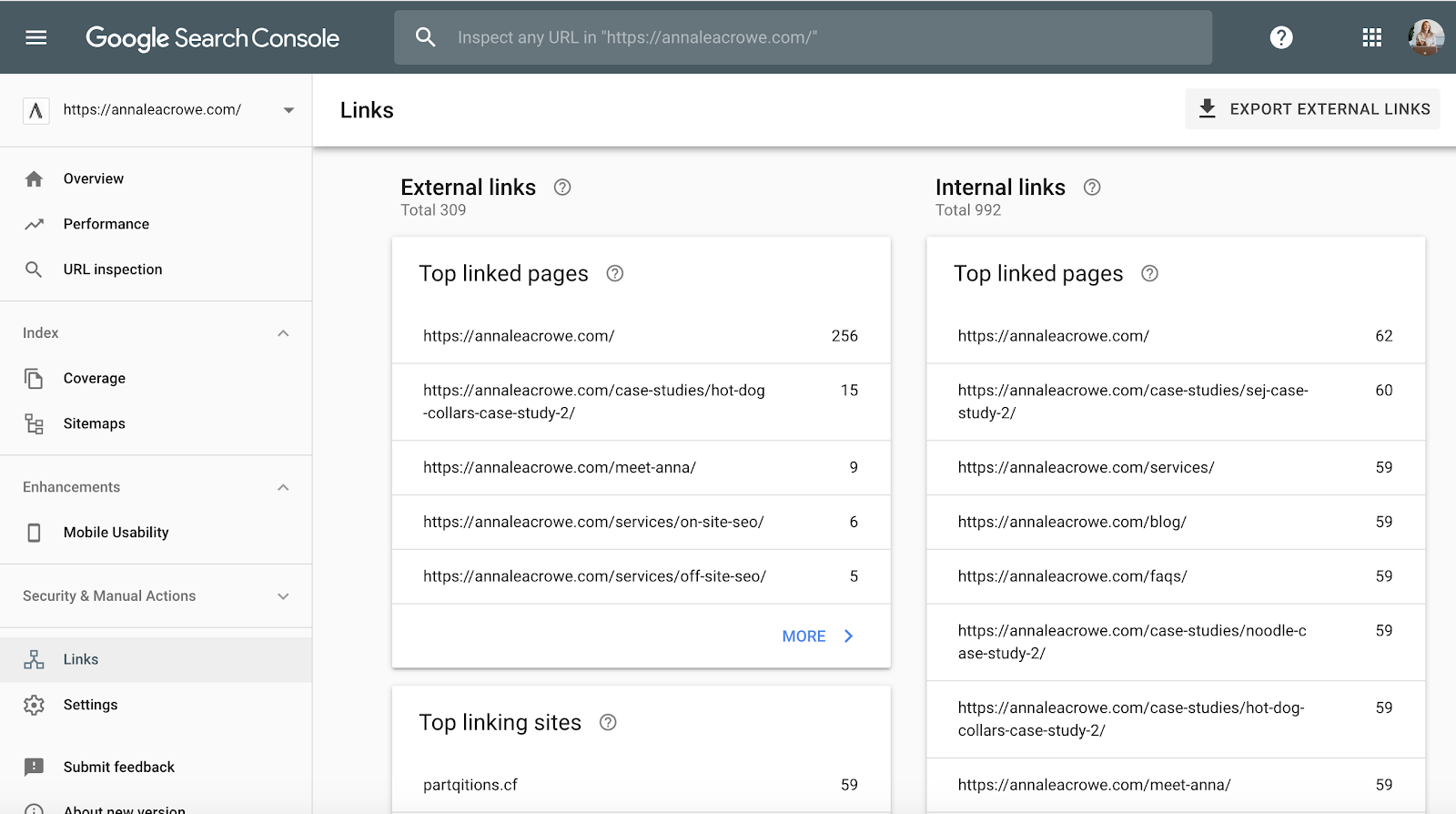

Backlinks

Med tillkännagivandet att Penguin är i realtid är det viktigt att din klients backlinks uppfyller Googles standarder.

Om du märker att en stor mängd backlinks kommer till din klients webbplats från en sida på en webbplats, vill du vidta nödvändiga åtgärder för att städa upp, och det SNABBT!

ReklamFortsätt läsa nedanHur du åtgärdar:

- I Google Search Console går du till Länkar > och sorterar sedan dina topplänkar.

- Kontakta de företag som länkar till dig från en sida för att få dem att ta bort länkarna.

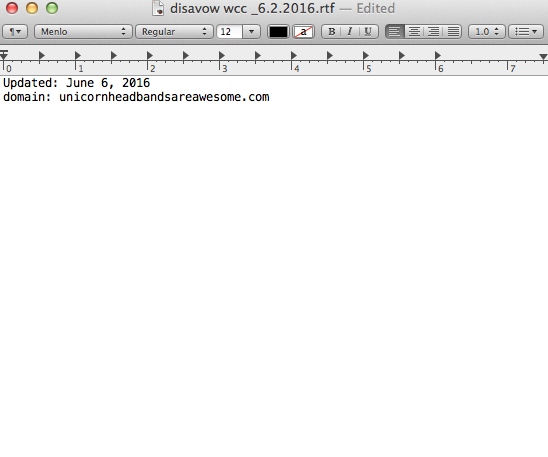

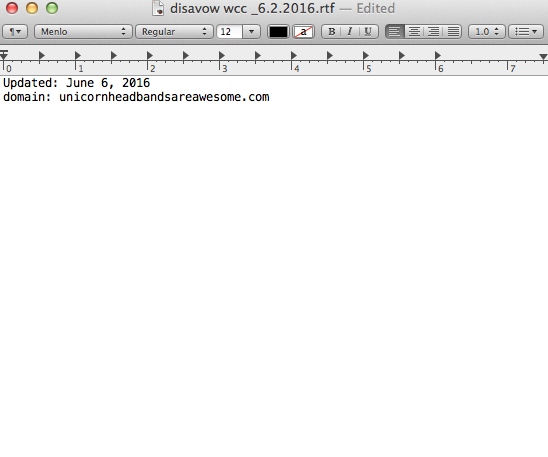

- Och lägg till dem i din disavow-lista. När du lägger till företag på din disavow-lista ska du vara mycket försiktig med hur och varför du gör det. Du vill inte ta bort värdefulla länkar.

Här är ett exempel på hur min disavow-fil ser ut:

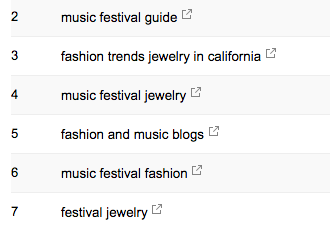

Keywords

Keywords

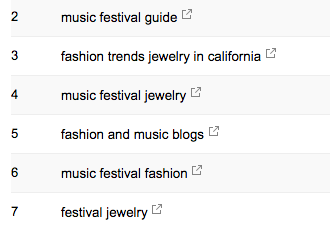

Som SEO-konsult är det mitt jobb att börja lära mig marknadslandskapet för min kund. Jag måste veta vem deras målgrupp är, vad de söker efter och hur de söker. Till att börja med tar jag en titt på de sökord som de redan får trafik från.

AdvertiseringFortsätt läsa nedan- I Google Search Console, under Search Traffic > Search Analytics visar vilka sökord som redan skickar klick till din klient.

Sitemap

Sitemap

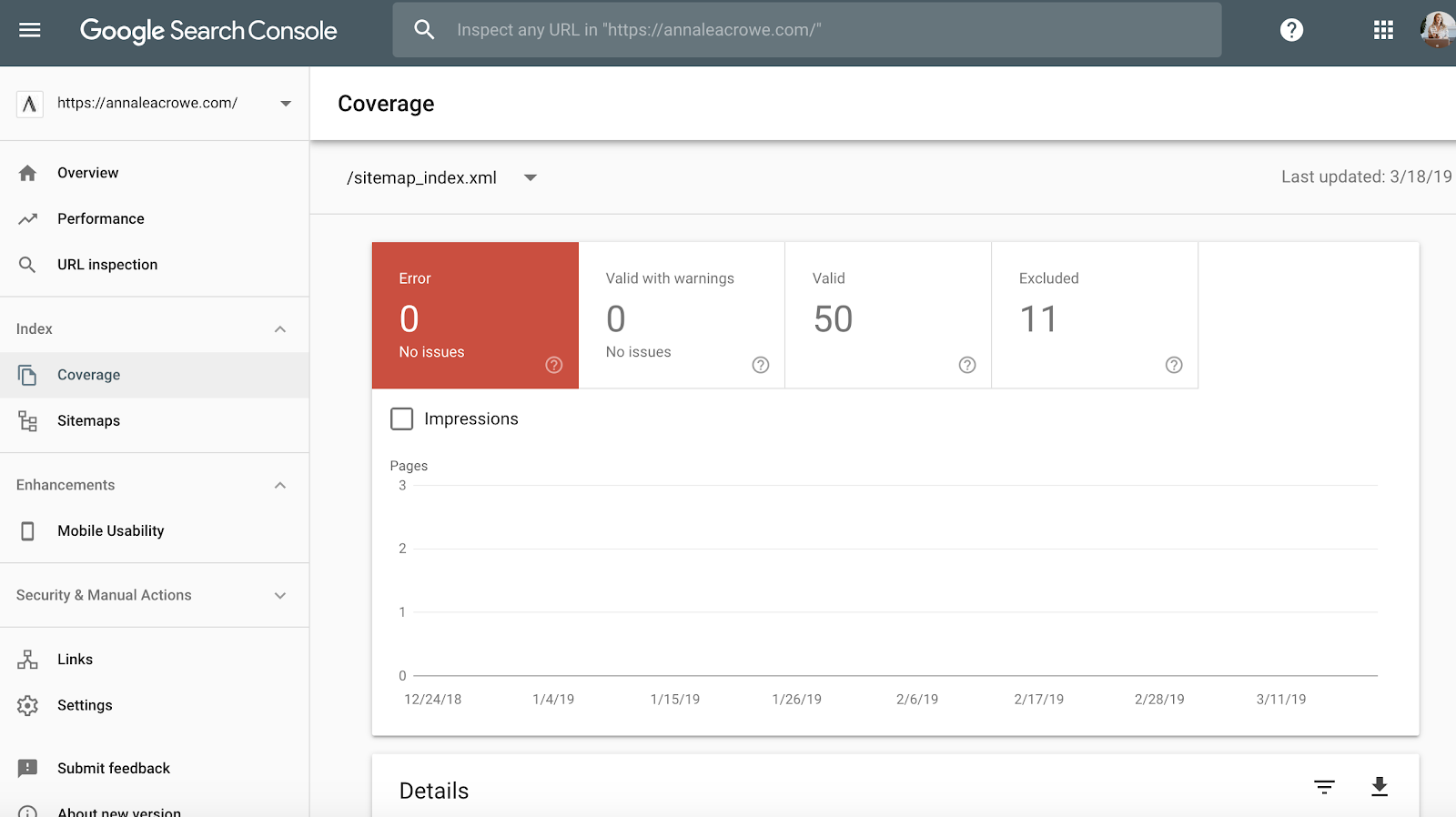

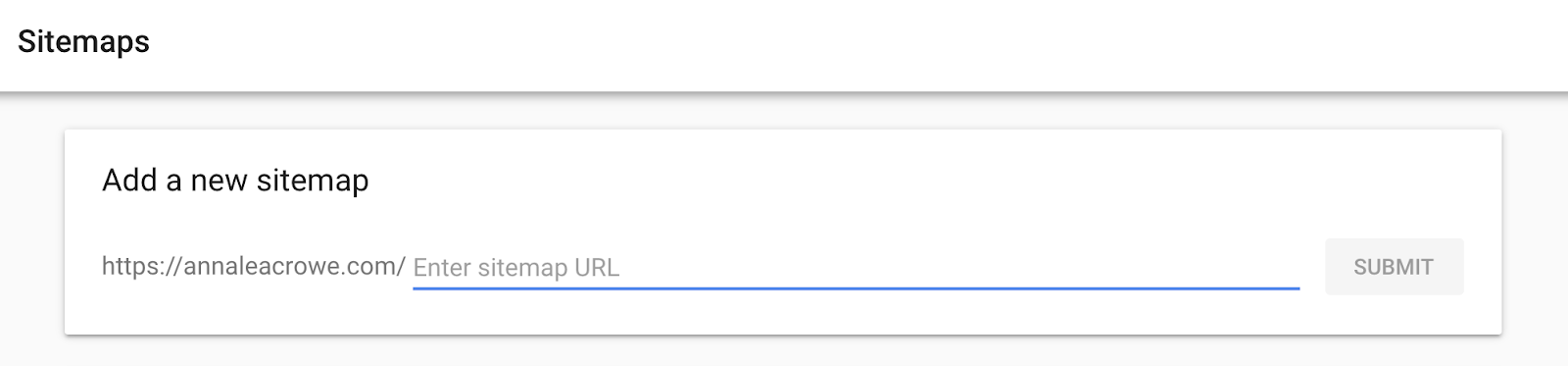

Sitemaps är viktiga för att få sökmotorerna att kryssa din kunds webbplats. Den talar deras språk. När du skapar sitemaps finns det några saker att känna till:

- Inkludera inte parameter-URL:er i din sitemap.

- Inkludera inga sidor som inte kan indexeras.

- Om webbplatsen har olika underdomäner för mobiler och stationära datorer ska du lägga till taggen rel=”alternate” i sitemaps.

Hur du åtgärdar:

- Gå till Google Search Console > Index > Sitemaps för att jämföra de webbadresser som indexeras i sitemaps med webbadresserna i webbindexet.

- Gör sedan en manuell sökning för att fastställa vilka sidor som inte indexeras och varför.

- Om du hittar gamla omdirigerade webbadresser i kundens sitemap tar du bort dem. Dessa gamla omdirigeringar kommer att ha en negativ inverkan på din SEO om du inte tar bort dem.

- Om kunden är ny, skicka in en ny sitemap för dem i både Bing Webmaster Tools och Google Search Console.

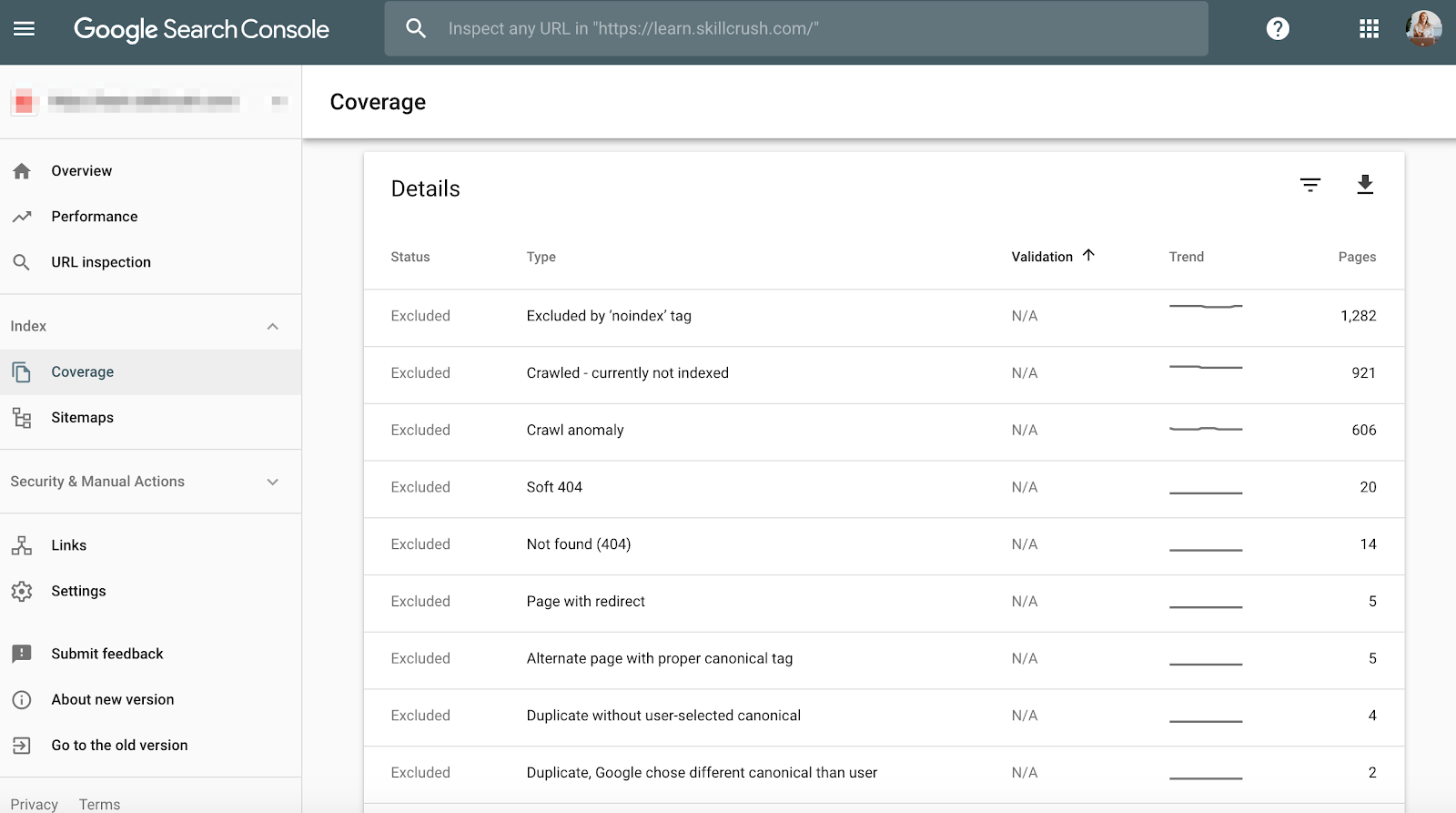

Crawl

Crawlfel är viktiga att kontrollera eftersom det inte bara är dåligt för användaren utan även för din webbplats rankning. Och John Mueller uppgav att låg crawlfrekvens kan vara ett tecken på en webbplats av låg kvalitet.

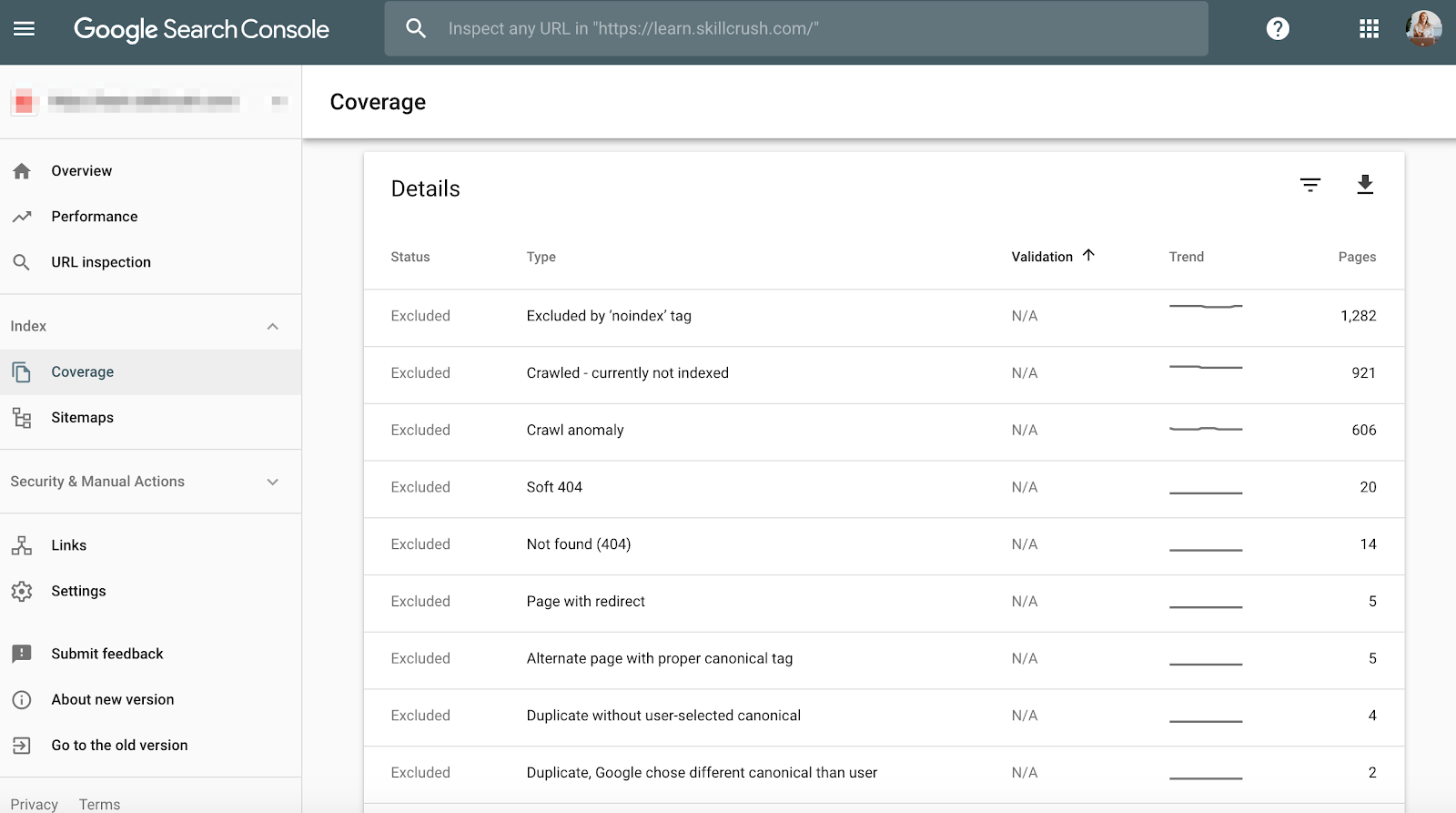

ReklamFortsätt läsa nedanFör att kontrollera detta i Google Search Console går du till Täckning > Detaljer.

För att kontrollera detta i Bing Webmaster Tools, gå till Rapporter & Data > Crawlinformation.

Hur du åtgärdar detta:

- Kontrollera dina crawlfel manuellt för att avgöra om det finns crawlfel som kommer från gamla produkter som inte längre existerar, eller om du ser crawlfel som inte bör tillåtas i robotarna.txt-filen.

- När du har fastställt varifrån de kommer kan du implementera 301-omdirigeringar till liknande sidor som länkar till de döda sidorna.

- Du vill också dubbelkontrollera statistiken för crawlning i Google Search Console med den genomsnittliga laddningstiden i Google Analytics för att se om det finns ett samband mellan den tid som spenderas med att ladda ner och de sidor som crawlas per dag.

Strukturerade data

Som nämnts ovan i avsnittet om schema i Screaming Frog kan du granska din kunds schemamärkning i Google Search Console.

Använd statusrapporten för enskilda rika resultat i Google Search Console. (Observera: Rapporten om strukturerade data är inte längre tillgänglig).

AdvertiseringFortsätt läsa nedanDetta hjälper dig att avgöra vilka sidor som har strukturerade datafel som du måste åtgärda längre fram.

Hur du åtgärdar:

- Google Search Console berättar vad som saknas i schemat när du testar liveversionen.

- Baserat på dina felkoder skriver du om schemat i en textredigerare och skickar det till webbutvecklingsteamet för uppdatering. Jag använder Sublime Text för min textredigering. Mac-användare har en inbyggd och PC-användare kan använda Google köpte YouTube.

Steg 3: Granska Google Analytics

Verktyg:

- Google Analytics.

- Google Tag Manager Assistant Chrome Extension.

- Annie Cushing Campaign Tagging Guide.

Vyer

När jag först får en ny kund ställer jag in tre olika vyer i Google Analytics.

- Rapporteringsvyn.

- Mastervyn.

- Testvyn.

Dessa olika vyer ger mig flexibiliteten att göra ändringar utan att påverka data.

Sättet att åtgärda:

- I Google Analytics går du till Admin > View > View Settings (Admin > Vy-inställningar) för att skapa de tre olika vyerna ovan.

- Se till att kontrollera avsnittet Botfiltrering för att utesluta alla träffar från botar och spindlar.

- Länk Google Ads och Google Search Console.

- Sist ska du se till att spårning av webbplatsens sökning är aktiverad.

Filter

Du ska se till att lägga till din IP-adress och kundens IP-adress i filtren i Google Analytics så att du inte får någon falsk trafik.

ReklamFortsätt läsa nedanHur du åtgärdar:

- Gå till Admin> Visa >Filter

- Därefter ska inställningarna ställas in så att Exkludera >trafik från IP-adresser > som är lika med.

Spårningskod

Spårningskod

Du kan kontrollera källkoden manuellt, eller så kan du använda min Screaming Frog-teknik från ovan.

Om koden finns där vill du spåra att den avfyras i realtid.

- För att kontrollera detta går du till din kunds webbplats och klickar runt lite på webbplatsen.

- Därefter går du till Google Analytics > Realtid > Platser, din plats bör fyllas på.

- Om du använder Google Tag Manager kan du också kontrollera detta med Google Tag Assistant Chrome-tillägget.

Hur du åtgärdar:

- Om koden inte fungerar vill du kontrollera kodutdraget för att se till att det är rätt. Om du hanterar flera webbplatser kan du ha lagt till koden för en annan webbplats.

- Innan du kopierar koden ska du använda en textredigerare, inte en ordbehandlare, för att kopiera utdraget till webbplatsen. Detta kan orsaka extra tecken eller whitespace.

- Funktionerna är skiftlägeskänsliga så kontrollera att allt är små bokstäver i koden.

Indexering

Om du har haft möjlighet att leka lite i Google Search Console har du antagligen lagt märke till avsnittet Täckning.

När jag granskar en klient granskar jag deras indexering i Google Search Console jämfört med Google Analytics. Så här går det till:

- I Google Search Console, gå till Coverage

- I Google Analytics, gå till Acquisition > Channels > Organic Search > Landing Page.

- När du är här går du till Avancerat > Webbplatsanvändning > Sessioner > 9.

AdvertisingFortsätt läsa nedanHur du åtgärdar:

- Genomför siffrorna från Google Search Console med siffrorna från Google Analytics, om siffrorna skiljer sig mycket åt vet du att även om sidorna indexeras är det bara en bråkdel som får organisk trafik.

Kampanjtaggning

Det sista du vill kontrollera i Google Analytics är om din kund använder kampanjtaggning på rätt sätt. Du vill inte att du inte ska få kredit för det arbete du utför för att du har glömt bort kampanjtaggning.

Hur du åtgärdar:

- Sätt upp en strategi för kampanjtaggning i Google Analytics och dela den med din klient. Annie Cushing har sammanställt en fantastisk guide för kampanjtaggning.

- Inställ händelsespårning om din klient använder mobilannonser eller video.

Nyckelord

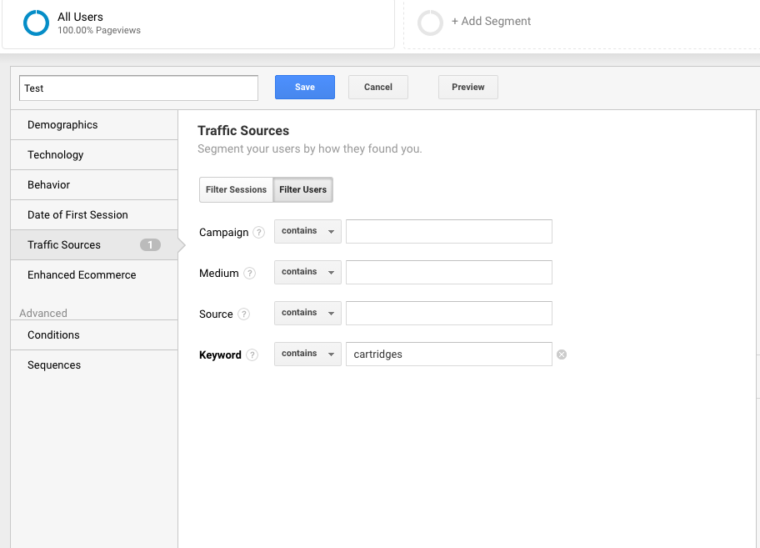

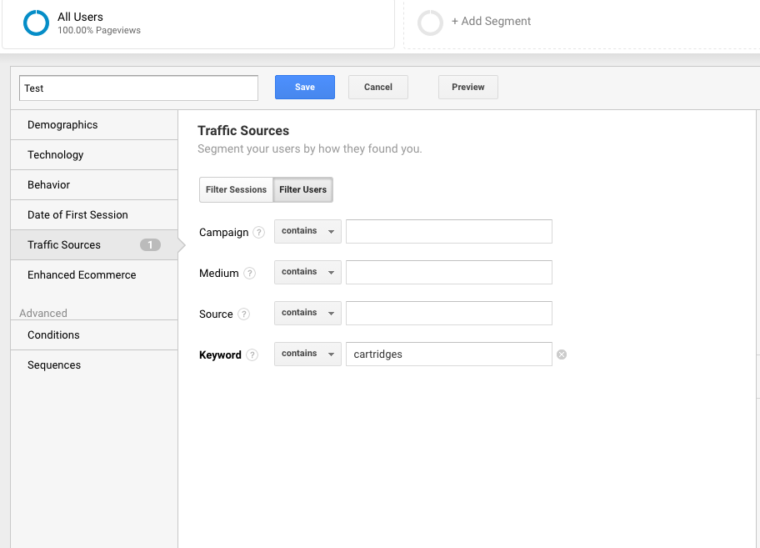

Du kan använda Google Analytics för att få insikt i potentiella nyckelordspärlor för din klient. Följ de här stegen för att hitta nyckelord i Google Analytics:

Gå till Google Analytics > Beteende > Webbplatssökning > Söktermer. På så sätt får du en bild av vad kunderna söker efter på webbplatsen.

Nästan använder jag dessa söktermer för att skapa ett nytt segment i Google Analytics för att se vilka sidor på webbplatsen som redan rankas för just den sökordstermen.

Steg 4: Manuell kontroll

Verktyg:

AdvertiseringFortsätt läsa nedan- Google Analytics.

- Access till kundens server och värd.

- You Get Signal.

- Pingdom.

- PageSpeed Tools.

- Wayback Machine.

En version av kundens webbplats är sökbar

Kontrollera alla olika sätt att söka efter en webbplats. Till exempel:

- http://annaisaunicorn.com

- https://annaisaunicorn.com

- http://www.annaisaunicorn.com

Som Highlander skulle säga, ”det kan bara finnas en” webbplats som är sökbar.

Hur man åtgärdar: Använd en 301-omdirigering för alla webbadresser som inte är den primära webbplatsen till den kanoniska webbplatsen.

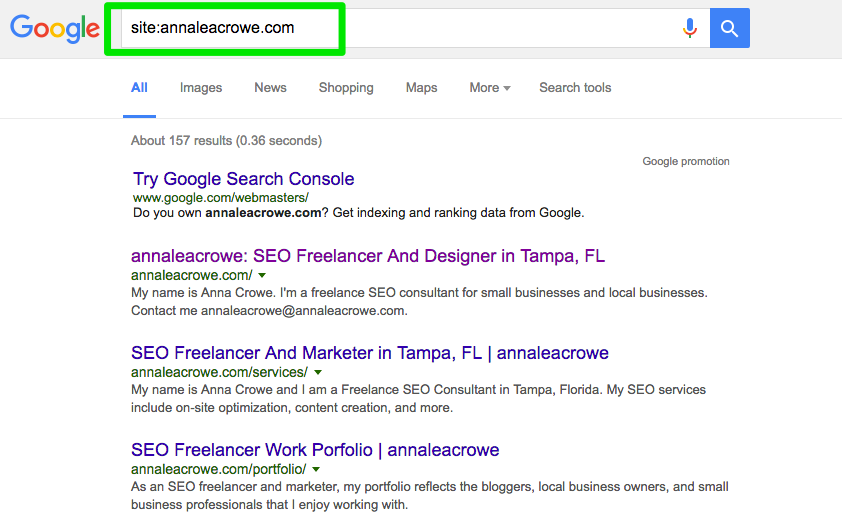

Indexering

Gör en manuell sökning i Google och Bing för att avgöra hur många sidor som indexeras av Google. Denna siffra är inte alltid korrekt med data från Google Analytics och Google Search Console, men den bör ge dig en grov uppskattning.

ReklamFortsätt läsa nedanFör att kontrollera detta gör du följande:

- Uppför en sökning på webbplatsen i sökmotorerna.

- När du söker, gör en manuell sökning för att se till att endast kundens varumärke visas.

- Kontrollera att hemsidan finns på första sidan. John Mueller sa att det inte är nödvändigt att hemsidan visas som första resultat.

Hur man åtgärdar:

- Om ett annat varumärke visas i sökresultaten har du ett större problem. Du bör titta på analysen för att diagnostisera problemet.

- Om hemsidan inte visas som det första resultatet bör du göra en manuell kontroll av webbplatsen för att se vad den saknar. Det kan också betyda att webbplatsen har ett straff eller dålig webbplatsarkitektur, vilket är ett större problem med att göra om webbplatsen.

- Kontrollera antalet organiska landningssidor i Google Analytics för att se om det stämmer överens med antalet sökresultat som du såg i sökmotorn. Detta kan hjälpa dig att avgöra vilka sidor som sökmotorerna ser som värdefulla.

Caching

Jag kör en snabb kontroll för att se om de bästa sidorna cachas av Google. Google använder dessa cachade sidor för att koppla ihop ditt innehåll med sökfrågor.

För att kontrollera om Google cachar din klients sidor gör du så här:

http://webcache.googleusercontent.com/search?q=cache:https://www.searchenginejournal.com/pubcon-day-3-women-in-digital-amazon-analytics/176005/

Se till att växla över till den textbaserade versionen.

AdvertiseringFortsätt läsa nedanDu kan också kontrollera detta i Wayback Machine.

Hur du åtgärdar detta:

- Kontrollera klientens server för att se om den ligger nere eller fungerar långsammare än vanligt. Det kan vara ett internt serverfel eller ett fel på en databasanslutning. Detta kan hända om flera användare försöker få tillgång till servern samtidigt.

- Kontrollera vem som annars finns på din server med en kontroll av omvänd IP-adress. Du kan använda webbplatsen You Get Signal för den här fasen. Du kan behöva uppgradera kundens server eller börja använda en CDN om du har skissartade domäner som delar servern.

- Kontrollera om kunden tar bort specifika sidor från webbplatsen.

Hosting

Det här kan bli lite tekniskt för vissa, men det är viktigt för din SEO-succé att kontrollera den hostingprogramvara som är kopplad till kundens webbplats. Hosting kan skada SEO och allt ditt hårda arbete kommer att vara förgäves.

Du behöver tillgång till din kunds server för att manuellt kontrollera eventuella problem. De vanligaste hostingproblemen jag ser är att ha fel TLD och långsam webbplatshastighet.

Hur man åtgärdar:

- Om din klient har fel TLD måste du se till att land-IP-adressen är associerad med det land som din klient är verksam i mest. Om din kund har en .co-domän och även en .com-domän ska du omdirigera .co-domänen till din kunds primära domän på .com-domänen.

- Om din kund har långsam webbplatshastighet ska du åtgärda detta snabbt eftersom webbplatsens hastighet är en rankingfaktor. Ta reda på vad som gör webbplatsen långsam med hjälp av verktyg som PageSpeed Tools och Pingdom. Här är en titt på några av de vanligaste problemen med sidans hastighet:

- Host.

- Stora bilder.

- Inbäddade videor.

- Plugins.

- Ads.

- Tema.

- Widgetar.

- Repeterande skript eller tät kod.

ReklamFortsätt läsa nedanCore Web Vitals Audit

Core Web Vitals är en samling av tre mätvärden som är representativa för en webbplats användarupplevelse. De är viktiga eftersom Google uppdaterar sina algoritmer under våren 2021 för att införliva Core Web Vitals som en rankingfaktor.

Även om rankingfaktorn förväntas vara en liten faktor är det fortfarande viktigt att granska Core Web Vitals-poängen och identifiera områden som kan förbättras.

Varför är det viktigt att inkludera Core Web Vitals i din granskning?

En förbättring av Core Web Vitals-poängen kommer inte bara att hjälpa sökrankningen, utan kanske ännu viktigare är att det kan betala sig i form av fler konverteringar och intäkter.

Förbättringar av hastigheten och sidans prestanda är förknippade med högre försäljning, trafik och annonsklick.

En uppgradering av webbhotellet och installation av en ny insticksmodul kan förbättra sidans hastighet, men kommer att ha liten (om ens någon) effekt på Core Web Vitals.

ReklamFortsätt läsa nedanMätningen görs vid den punkt där någon bokstavligen laddar ner din webbplats på sin mobiltelefon.

Det innebär att flaskhalsen finns vid deras internetanslutning och den mobila enheten. En snabb server kommer inte att snabba upp en långsam Internetanslutning på en budgetmobil.

Samma, eftersom många av lösningarna innebär att koden i en mall eller kärnfilerna i själva innehållshanteringssystemet måste ändras, kommer ett plugin för sidhastighet att vara till mycket liten nytta.

Det finns många resurser för att hjälpa till att förstå lösningarna. Men de flesta lösningar kräver hjälp av en utvecklare som känner sig bekväm med att uppdatera och ändra kärnfiler i ditt innehållshanteringssystem.

Fixing Core Web Vitals-problem kan vara svårt. WordPress, Drupal och andra innehållshanteringssystem (CMS) byggdes inte för att få bra resultat för Core Web Vitals.

Det är viktigt att notera att processen för att förbättra Core Web Vitals innebär att ändra kodningen i kärnan av WordPress och andra CMS.

ReklamFortsätt läsa nedanFör att förbättra Core Web Vitals krävs i princip att man får en webbplats att göra något som den aldrig var tänkt att göra när utvecklarna skapade ett tema eller CMS.

Syftet med en revision av Core Web Vitals är att identifiera vad som behöver åtgärdas och överlämna den informationen till en utvecklare som sedan kan göra de nödvändiga ändringarna.

Vad är Core Web Vitals?

Core Web Vitals består av tre mätvärden som tillsammans identifierar hur snabbt den viktigaste delen av din sida laddas, hur snabbt en användare kan interagera med sidan (t.ex. klicka på en knapp) och hur snabbt det tar för webbsidan att bli stabil utan att sidelement flyttas runt.

Det finns:

- Largest Contentful Paint (LCP).

- First Input Delay (FID).

- Cumulative Layout Shift (CLS).

Det finns två typer av poäng för Core Web Vitals:

- Labbdata.

- Fältdata.

AdvertisingFortsätt läsa nedanLabdata

Labdata är det som genereras när du kör en sida genom Google Lighthouse eller i PageSpeed Insights.

Labdata består av poäng som genereras genom en simulerad enhet och internetanslutning. Syftet är att ge den som arbetar med webbplatsen en uppfattning om vilka delar av Core Web Vitals som behöver förbättras.

Värdet av ett verktyg som PageSpeed Insights är att det identifierar specifik kod och sidelement som gör att en sida får dålig poäng.

Fältdata

Fältdata är faktiska Core Web Vitals-poäng som har samlats in av webbläsaren Google Chrome för rapporten Chrome User Experience Report (även känd som CrUX).

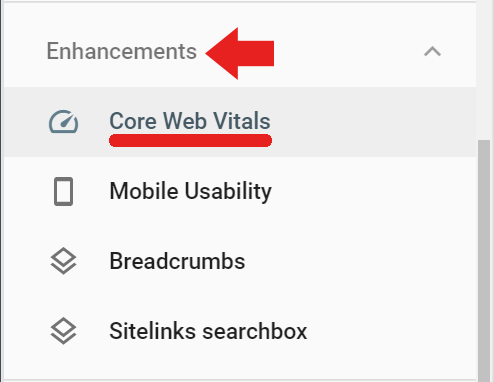

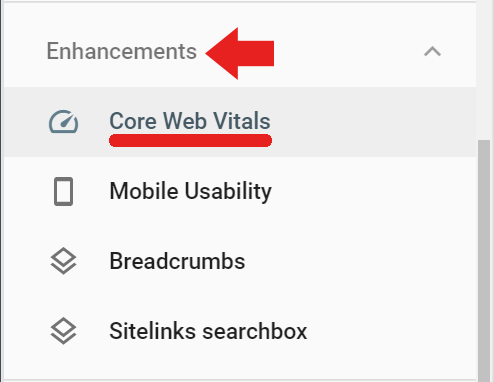

Fältdata finns i Google Search Console under fliken Förbättringar via länken Core Web Vitals (fältdata kan också nås via denna länk) https://search.google.com/search-console/core-web-vitals.

Fältdata som rapporteras i Google Search Console kommer från besökta sidor som har haft ett minsta antal besök och mätningar. Om Google inte får tillräckligt många poäng kommer Google Search Console inte att rapportera det resultatet.

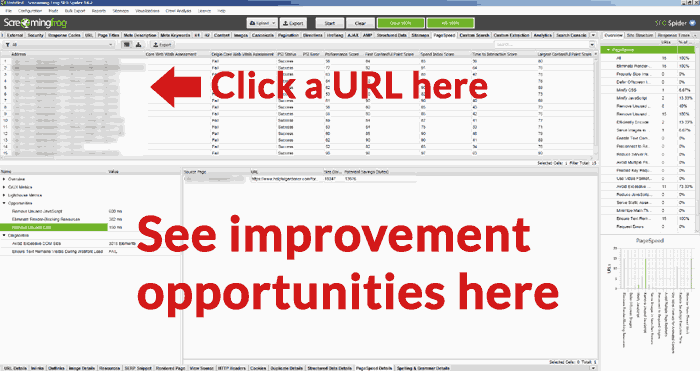

ReklamFortsätt läsa nedanScreaming Frog för Core Web Vitals Audit

Screaming Frog version 14.2 har nu möjlighet att visa en godkänd eller underkänd Core Web Vitals bedömning. Du måste ansluta Screaming Frog till PageSpeed Insights API (få en API-nyckel här) via en nyckel.

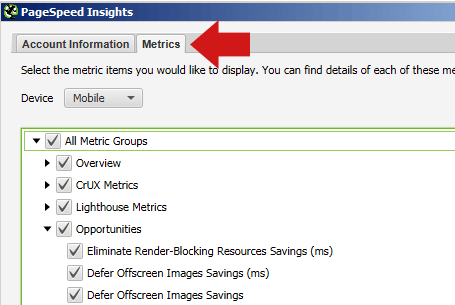

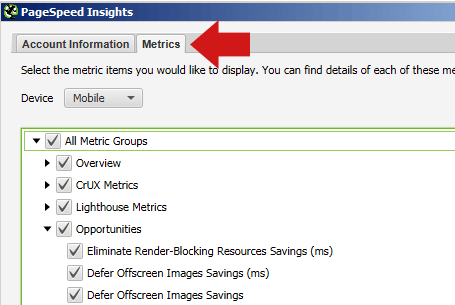

För att registrera din Page Speed Insights API-nyckel med Screaming Frog, navigerar du först till Konfiguration > API-åtkomst > PageSpeed Insights

Där ser du en plats där du kan ange din API-nyckel och ansluta den till tjänsten.

I samma popup-fönster för PageSpeed Insights kan du också välja fliken Metrics (mätvärden) och kryssa i rutorna som anger vilka mätvärden du vill ha rapporterade.

Se till att välja Mobile (mobil) för enheten eftersom det är det mätvärdet som har betydelse för rankingen.

Om du väljer fliken Möjligheter kommer Screaming Frog efter genomsökningen att visa dig en lista med olika typer av förbättringar (som att skjuta upp bilder som inte visas på skärmen, ta bort oanvänt CSS, etc.).

Hur man utför en djupgående teknisk SEO-granskning

Hur man utför en djupgående teknisk SEO-granskningHur man utför en djupgående teknisk SEO-granskning.Djupgående teknisk SEO-granskningNote Before Crawling

AdvertisementContinue Reading BelowDet finns i allmänhet inget behov av att crawla en hel webbplats och producera en uttömmande sida för sida redovisning av vad som är fel på varje enskild sida på webbplatsen.

Innan du crawlar kan du överväga att crawla en representativ uppsättning sidor. För att göra detta väljer du först en grupp sidor som representerar de typer av sidor som är gemensamma för varje avsnitt eller kategori på webbplatsen. Skapa ett kalkylblad, en textfilslista eller klistra in URL:erna manuellt med hjälp av fliken Ladda upp i Screaming Frog.

De flesta webbplatser innehöll sidor och inlägg som skapats med liknande sidstruktur och innehåll. Till exempel kommer alla sidor i en kategori ”nyheter” att vara ganska lika varandra, och sidor i en kategori ”recensioner” kommer också att vara lika varandra.

Du kan spara tid genom att söka igenom en representativ grupp av sidor för att identifiera problem som är gemensamma för enskilda kategorier samt problem som är gemensamma för alla sidor i hela webbplatsen och som behöver åtgärdas.

På grund av dessa likheter kommer de problem som upptäcks att vara likartade. Det kanske bara är nödvändigt att kryssa en handfull representativa sidor från varje typ av kategori för att identifiera vilka typer av problem som är specifika för var och en av dessa sektioner.

AdvertiseringFortsätt läsa nedanDen typ av saker som åtgärdas är vanligtvis problem som gäller hela webbplatsen och som är gemensamma för hela webbplatsen, till exempel oanvänt CSS som laddas från varje sida eller kumulativ layoutförskjutning som orsakas av en annonsenhet som är placerad i det vänstra området av webbsidorna.

Om moderna webbplatser är mallade kommer rättelserna att ske på mallnivå eller med anpassad kodning i formatmallarna etc.

Crawl webbplatsen med Screaming Frog

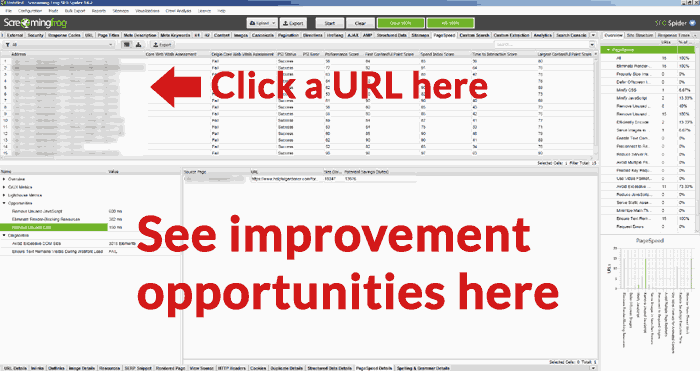

När URL:erna är helt crawlade kan du klicka på fliken PageSpeed och läsa alla rekommendationer och se noteringarna för godkänt/underkänt för de olika mätvärdena.

Zoom In on URL Opportunities

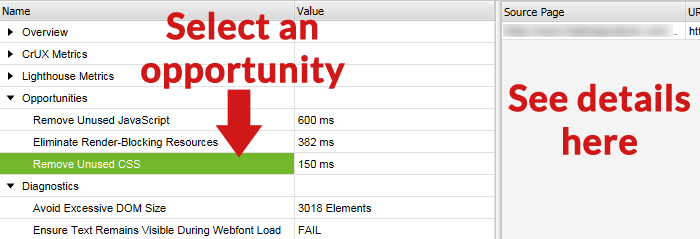

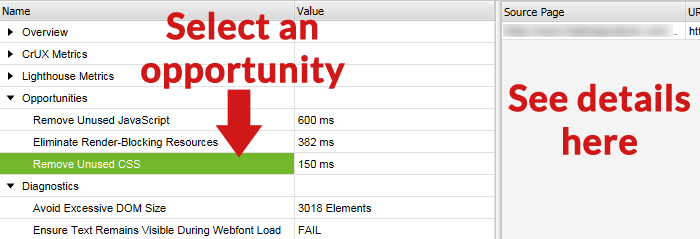

En användbar funktion i Screaming Frog Core Web Vitals Audit är möjligheten att välja en URL från listan över URL:er i den övre rutan och sedan se förbättringsmöjligheterna i den nedre rutan på Screaming Frog-skärmen.

Nedan visas en skärmdump av den nedre skärmen, med en möjlighet vald och detaljerna för den förbättringsmöjligheten i den högra rutan.

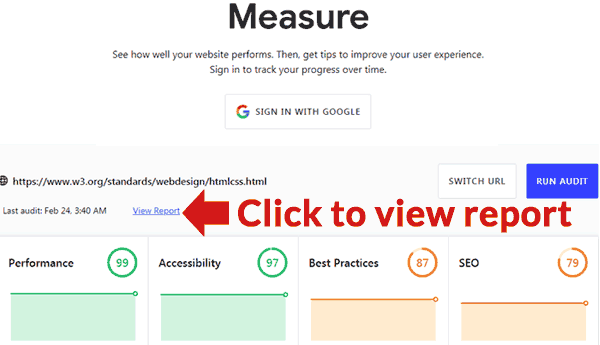

Officiella Google-verktyget

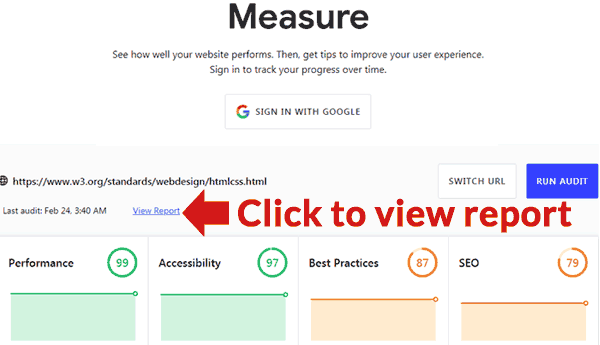

Google har publicerat ett verktyg som kan ge en granskning. Det finns här: https://web.dev/measure/

Insätt en URL för att få en översikt över sidans prestanda. Om du är inloggad spårar Google sidan åt dig över tid. Om du klickar på länken Visa rapport öppnas en ny sida med en rapport som beskriver vad som är fel och länkar till guider som visar hur du åtgärdar varje problem.

ReklamFortsätt läsa nedan.