Ich werde nicht lügen: Die Durchführung eines detaillierten SEO-Audits ist eine große Sache.

Und als SEO-Berater gibt es nur wenige schönere Worte als: „Ihr Audit sieht großartig aus! Wann können wir Sie an Bord holen?“

Selbst wenn Sie nicht aktiv nach einem neuen Auftrag gesucht haben, ist das Wissen, dass Ihr SEO-Audit erfolgreich war, ein riesiger Ego-Schub.

Aber haben Sie Angst, anzufangen? Ist dies Ihr erstes SEO-Audit? Oder wissen Sie einfach nicht, wo Sie anfangen sollen?

Wenn Sie einem potenziellen Kunden ein fantastisches SEO-Audit schicken, sind Sie in der bestmöglichen Position.

So nehmen Sie sich Zeit. Denken Sie daran: Ihr primäres Ziel ist es, Ihrem Kunden mit Ihren Website-Empfehlungen sowohl kurzfristig als auch langfristig einen Mehrwert zu bieten.

In dieser Kolumne habe ich die notwendigen Schritte für die Durchführung eines SEO-Audits und einen kleinen Einblick in die erste Phase meiner Prozesse zusammengestellt, wenn ich einen neuen Kunden bekomme. Er ist in die folgenden Abschnitte unterteilt. Wenn Sie das Gefühl haben, dass Sie einen bestimmten Abschnitt gut verstanden haben, können Sie gerne zum nächsten springen.

Wann sollte ich ein SEO-Audit durchführen?

Nachdem mir ein potenzieller Kunde eine E-Mail geschickt hat, in der er sein Interesse an einer Zusammenarbeit bekundet, und meine Umfrage beantwortet hat, vereinbaren wir ein Vorgespräch (vorzugsweise über Skype oder Google Hangouts).

Vor dem Gespräch führe ich auf der Grundlage der Antworten auf die Umfrage ein kleines SEO-Audit durch (ich investiere mindestens eine Stunde in die manuelle Recherche), um mich mit seiner Marktlandschaft vertraut zu machen. Es ist, als würde man sich mit jemandem verabreden, den man noch nie getroffen hat.

Natürlich stalken Sie sie auf Facebook, Twitter, Instagram und allen anderen Kanälen, die öffentlich sind #soIcreep.

Hier ist ein Beispiel dafür, wie meine Umfrage aussieht:

Hier sind einige Schlüsselfragen, die Sie dem Kunden während des ersten Treffens stellen sollten:

- Was sind Ihre allgemeinen Geschäftsziele? Welche Ziele verfolgen Sie mit Ihren Kanälen (PR, soziale Netzwerke usw.)?

- Wer ist Ihre Zielgruppe?

- Haben Sie Geschäftspartnerschaften?

- Wie oft wird die Website aktualisiert? Haben Sie einen Webentwickler oder eine IT-Abteilung?

- Haben Sie schon einmal mit einem SEO-Berater gearbeitet?

Sujan Patel hat auch einige großartige Empfehlungen zu Fragen, die man einem neuen SEO-Kunden stellen sollte.

Nach dem Gespräch, wenn ich das Gefühl habe, dass wir gut zusammenpassen, schicke ich Ihnen mein formelles Angebot und den Vertrag (vielen Dank an HelloSign, dass Sie diesen Prozess für mich so einfach machen!).

Zu Beginn biete ich meinen Kunden immer den ersten Monat als Probezeit an, um sicherzugehen, dass wir zusammenpassen.

Das gibt sowohl dem Kunden als auch mir die Möglichkeit, zunächst Freunde zu werden, bevor wir uns verabreden. In diesem Monat nehme ich mir die Zeit, ein ausführliches SEO-Audit durchzuführen.

Diese SEO-Audits können je nach Größe der Website zwischen 40 und 60 Stunden dauern. Diese Audits werden in drei separate Teile aufgeteilt und mit Google Slides präsentiert.

- Technisch: Crawl-Fehler, Indexierung, Hosting usw.

- Inhalt: Keyword-Recherche, Konkurrenzanalyse, Content Maps, Metadaten, etc.

- Links: Analyse des Backlinkprofils, Wachstumstaktiken usw.

Nach dem ersten Monat, wenn dem Kunden meine Arbeit gefällt, beginnen wir mit der Umsetzung der Empfehlungen aus dem SEO-Audit. In Zukunft führe ich monatlich ein Mini-Audit und vierteljährlich ein ausführliches Audit durch.

Zur Erinnerung: Ich führe für meine Kunden ein SEO-Audit durch:

- Erster Monat.

- Monatlich (Mini-Audit).

- Quartalsweise (ausführliches Audit).

Was Sie von einem Kunden vor einem SEO-Audit benötigen

Wenn ein Kunde und ich anfangen, zusammenzuarbeiten, teile ich ihm ein Google Doc mit, in dem ich eine Liste von Passwörtern und Anbietern anfordere.

Dazu gehören:

- Google Analytics-Zugang und alle Analysetools von Drittanbietern.

- Google- und Bing-Anzeigen.

- Webmaster-Tools.

- Zugang zum Backend der Website.

- Social-Media-Konten.

- Liste der Anbieter.

- Liste der internen Teammitglieder (einschließlich aller Arbeiten, die sie auslagern).

Tools für SEO-Audit

Bevor Sie mit Ihrem SEO-Audit beginnen, hier eine Zusammenfassung der Tools, die ich verwende:

- Screaming Frog.

- Integrity (für Mac-Nutzer) und Xenu Sleuth (für PC-Nutzer).

- SEO Browser.

- Wayback Machine.

- Moz.

- BuzzSumo.

- DeepCrawl.

- Copyscape.

- Google Tag Manager.

- Google Tag Manager Chrome Extension.

- Annie Cushing’s Campaign Tagging Guide.

- Google Analytics (falls Zugriff gewährt).

- Google Search Console (falls Zugriff gewährt).

- Bing Webmaster Tools (falls Zugriff gewährt).

- You Get Signal.

- Pingdom.

- PageSpeed Tool.

- Sublime Text.

Durchführen eines technischen SEO-Audits

Werkzeuge, die für ein technisches SEO-Audit benötigt werden:

- Screaming Frog.

- DeepCrawl.

- Copyscape.

- Integrity für Mac (oder Xenu Sleuth für PC-Benutzer).

- Google Analytics (falls Zugang gewährt).

- Google Search Console (falls Zugang gewährt).

- Bing Webmaster Tools (wenn Zugang gewährt wird).

Schritt 1: Website zu DeepCrawl und Screaming Frog hinzufügen

Tools:

- DeepCrawl.

- Copyscape.

- Screaming Frog.

- Google Analytics.

- Integrity.

- Google Tag Manager.

- Google Analytics Code.

Worauf Sie bei der Verwendung von DeepCrawl achten sollten

Das erste, was ich tue, ist, die Website meines Kunden zu DeepCrawl hinzuzufügen. Je nach Größe der Website Ihres Kunden kann der Crawl ein oder zwei Tage dauern, bis die Ergebnisse vorliegen.

Nachdem Sie die DeepCrawl-Ergebnisse erhalten haben, suche ich nach folgenden Dingen:

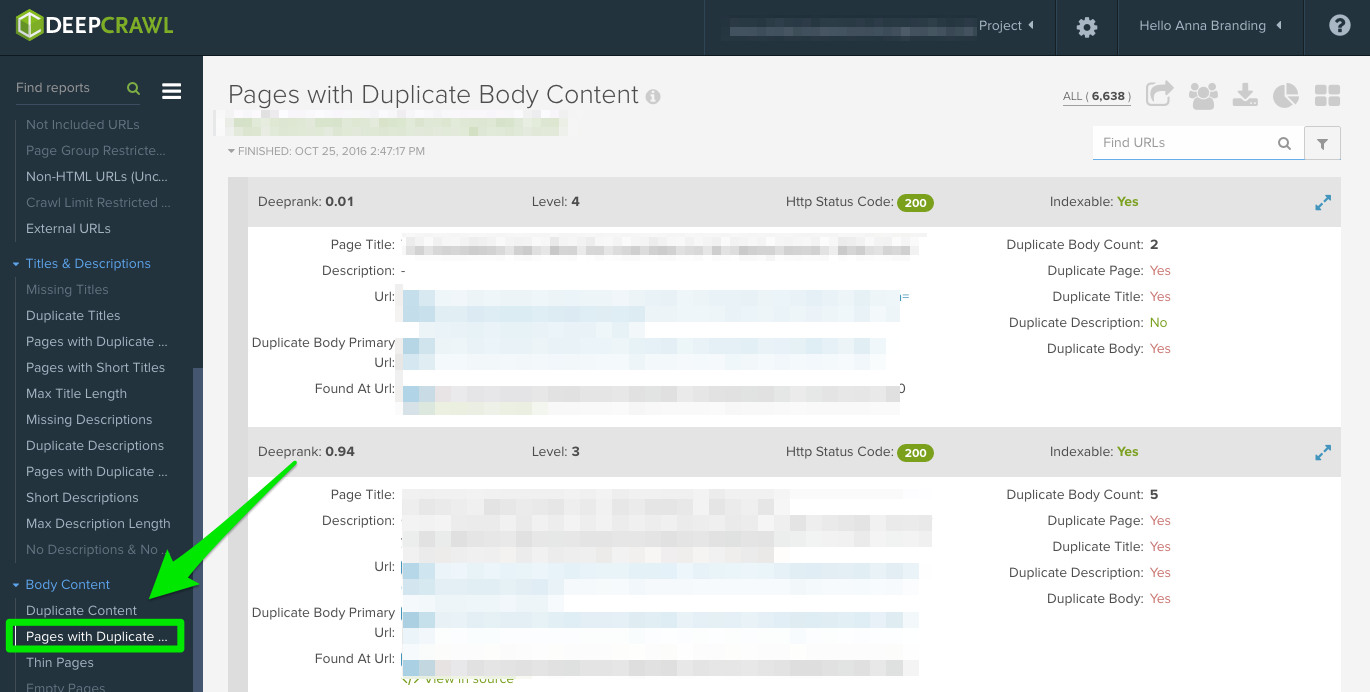

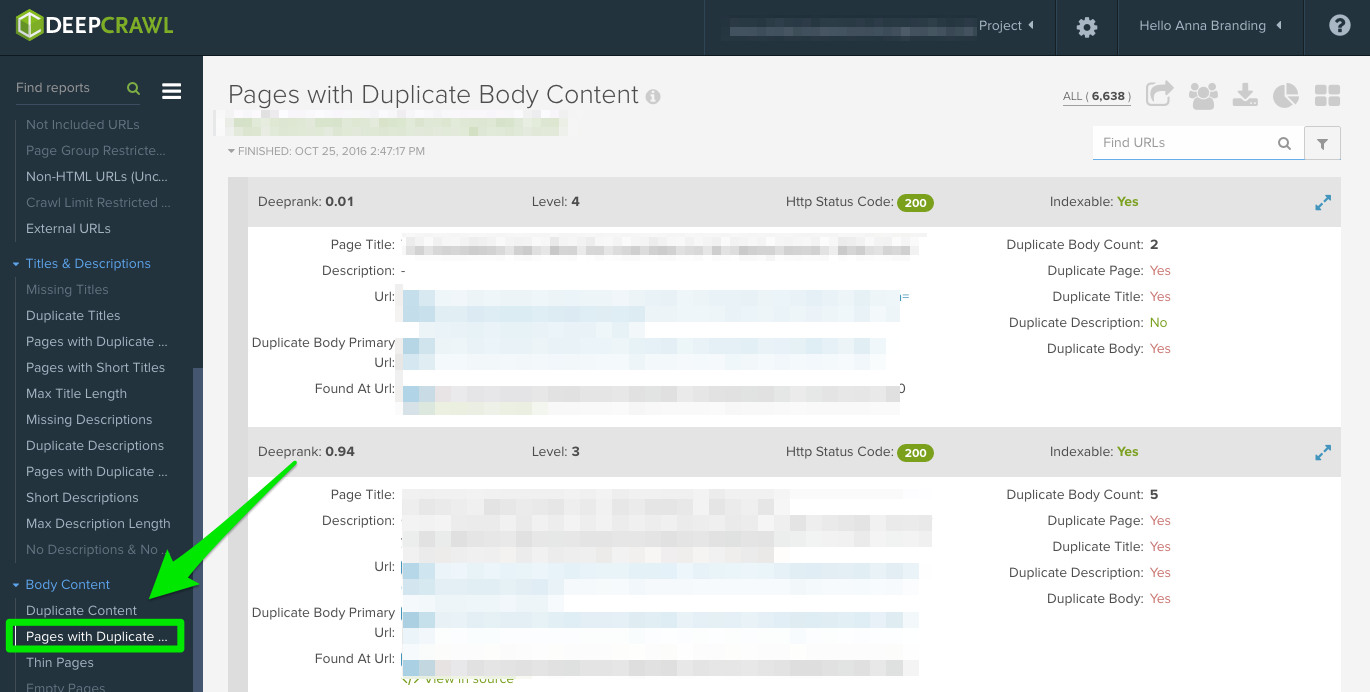

Doppelte Inhalte

Prüfen Sie den Bericht „Doppelte Seiten“, um doppelte Inhalte zu finden.

Wenn doppelte Inhalte identifiziert werden, werde ich dies zu einer Top-Priorität in meinen Empfehlungen an den Kunden machen, um diese Seiten neu zu schreiben, und in der Zwischenzeit werde ich das <meta name=“robots“ content=“noindex, nofollow“> Tag zu den doppelten Seiten hinzufügen.

Gängige Fehler bei doppelten Inhalten, die Sie entdecken werden:

- Doppelte Meta-Titel und Meta-Beschreibungen.

- Doppelte Inhalte von Tag-Seiten (ich verwende Copyscape, um festzustellen, ob etwas plagiiert wird).

- Zwei Domains (z. B. yourwebsite.co, yourwebsite.com).

- Subdomains (z. B. jobs.yourwebsite.com).

- Ähnliche Inhalte auf einer anderen Domain.

- Unzureichend implementierter Seitenumbruch (siehe unten.)

Lösung:

- Fügen Sie das Canonical-Tag auf Ihren Seiten hinzu, um Google mitzuteilen, wie Ihre bevorzugte URL lauten soll.

- Lassen Sie falsche URLs in der robots.txt.

- Neue Inhalte (einschließlich Textkörper und Metadaten).

Hier ein Beispiel für ein Problem mit doppelten Inhalten, das ich mit einem meiner Kunden hatte. Wie Sie unten sehen können, gab es URL-Parameter ohne den kanonischen Tag.

Nachfolgend die Schritte, die ich unternommen habe, um das Problem zu beheben:

- Ich habe alle 301-Weiterleitungsprobleme behoben.

- Hinzufügen ist ein kanonisches Tag für die Seite, die Google crawlen soll.

- Aktualisieren Sie die Parametereinstellungen in der Google Search Console, um alle Parameter auszuschließen, die keinen eindeutigen Inhalt generieren.

- Hinzufügen der disallow-Funktion in der robots.txt zu den falschen URLs hinzugefügt, um das Crawl-Budget zu verbessern.

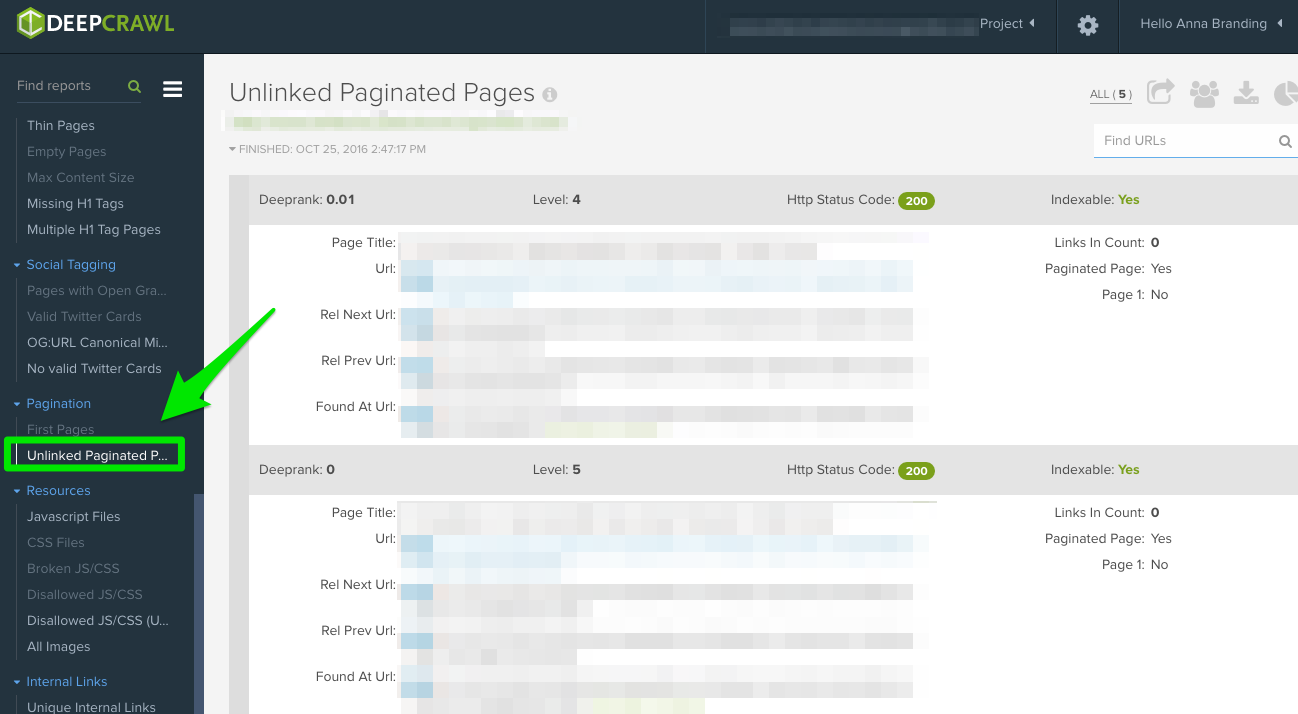

Paginierung

Es gibt zwei Berichte, die Sie sich ansehen sollten:

- Erste Seiten: Um herauszufinden, welche Seiten die Paginierung verwenden, überprüfen Sie den Bericht „Erste Seiten“. Anschließend können Sie die Seiten, die dies auf der Website verwenden, manuell überprüfen, um festzustellen, ob die Paginierung korrekt implementiert ist.

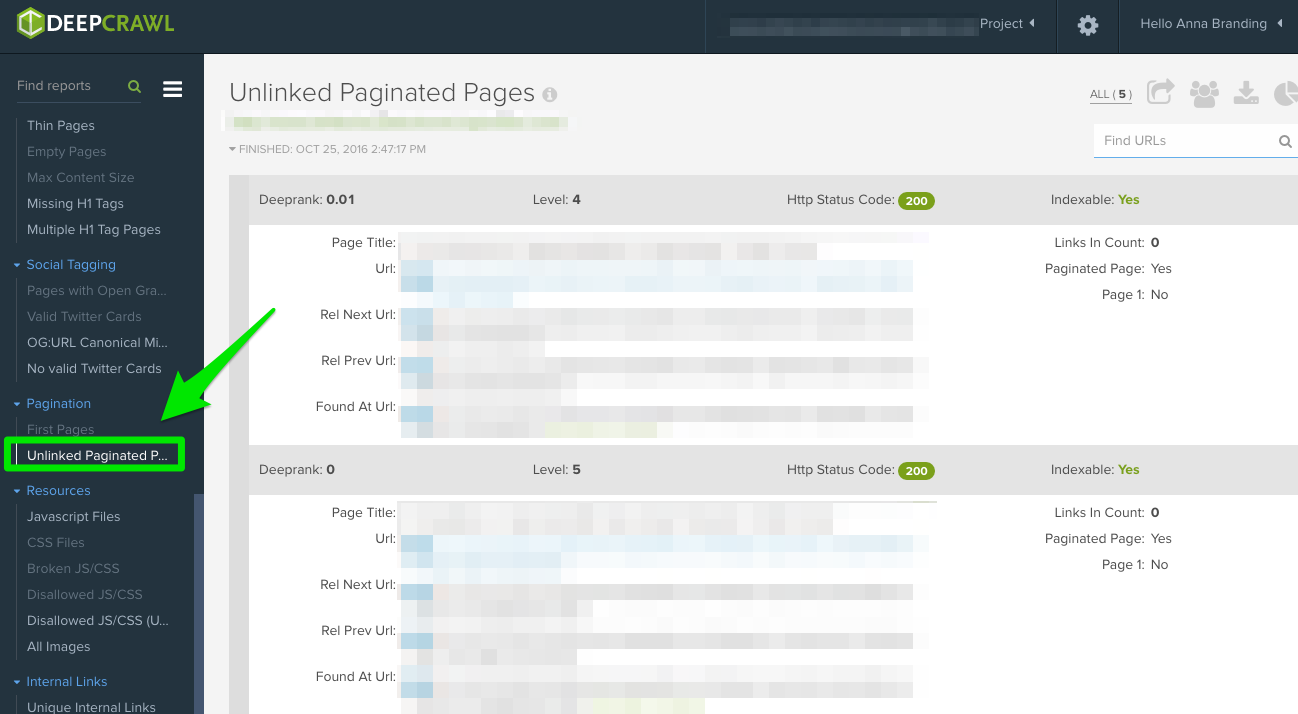

- Unverknüpfte Seiten mit Paginierung: Um herauszufinden, ob die Paginierung korrekt funktioniert, zeigt Ihnen der Bericht „Unverlinkte Paginierungsseiten“, ob rel=“next“ und rel=“prev“ auf die vorherigen und nächsten Seiten verlinken.

In diesem Beispiel unten konnte ich mit DeepCrawl feststellen, dass ein Kunde reziproke Paginierungs-Tags hatte:

Wie man das beheben kann:

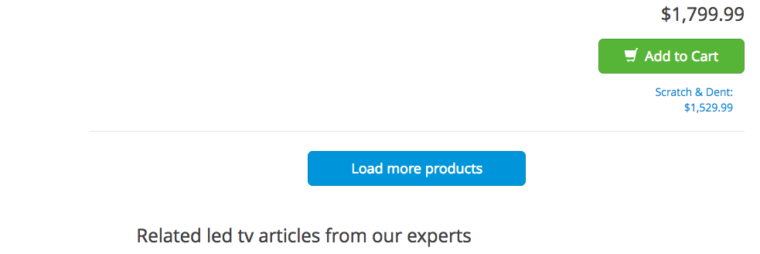

- Wenn Sie eine „Alles anzeigen“- oder eine „Mehr laden“-Seite haben, fügen Sie rel=“canonical“ Tag hinzu. Hier ein Beispiel von Crutchfield:

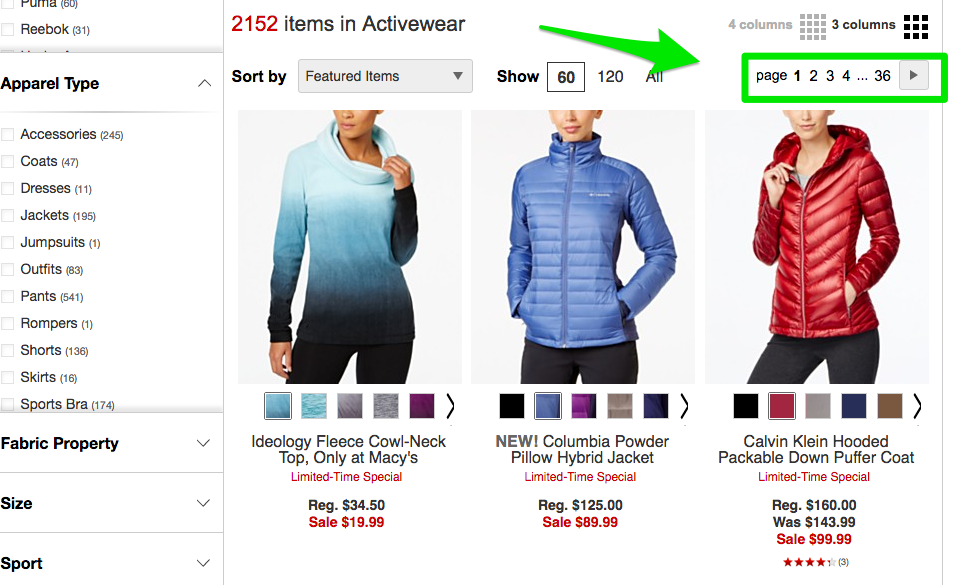

- Wenn Sie alle Ihre Seiten auf separaten Seiten haben, dann fügen Sie die Standardauszeichnung rel=“next“ und rel=“prev“ hinzu. Hier ein Beispiel von Macy’s:

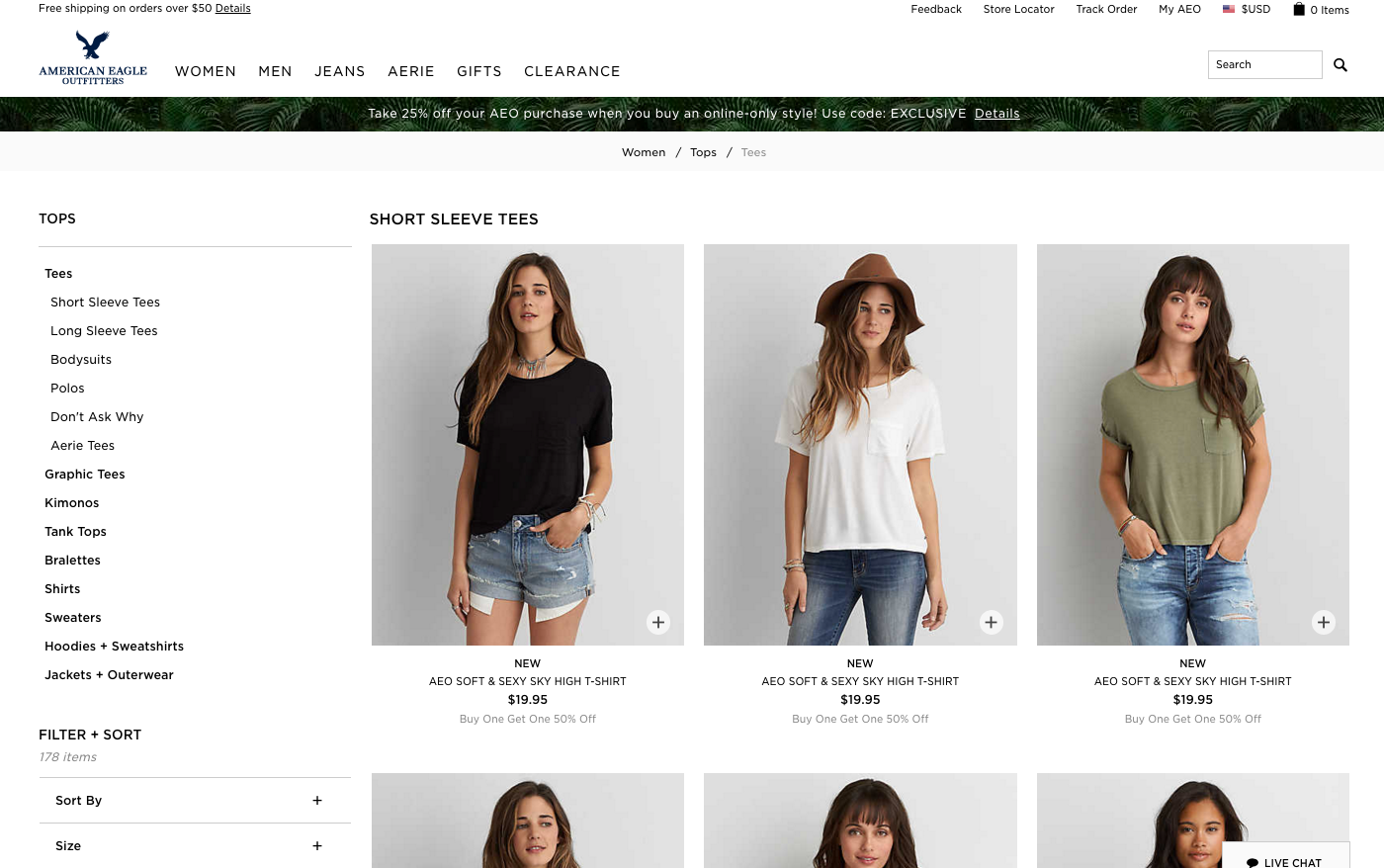

- Wenn Sie einen unendlichen Bildlauf verwenden, fügen Sie die entsprechende URL der paginierten Seite in Ihr Javascript ein. Hier ein Beispiel von American Eagle.

Max Redirections

Überprüfen Sie den „Max Redirections“-Bericht, um alle Seiten zu sehen, die mehr als 4 Mal weitergeleitet werden. John Mueller erwähnte 2015, dass Google bei mehr als fünf Weiterleitungen aufhören kann, diese zu verfolgen.

Während einige Leute diese Crawl-Fehler als Auffressen des „Crawl-Budgets“ bezeichnen, bezeichnet Gary Illyes dies als „Host-Last“. Es ist wichtig, dafür zu sorgen, dass Ihre Seiten richtig gerendert werden, denn Sie wollen, dass Ihre Host-Last effizient genutzt wird.

Hier ist ein kurzer Überblick über die Antwortcodes, die Sie sehen könnten:

- 301 – Dies sind die meisten Codes, die Sie während Ihrer Recherche sehen werden. 301-Weiterleitungen sind in Ordnung, solange es nur eine Weiterleitung und keine Weiterleitungsschleife gibt.

- 302 – Diese Codes sind in Ordnung, aber wenn sie länger als 3 Monate oder so bestehen bleiben, würde ich sie manuell in 301-Weiterleitungen ändern, damit sie dauerhaft sind. Dies ist ein Fehlercode, den ich oft bei E-Commerce-Websites sehe, wenn ein Produkt nicht mehr vorrätig ist.

- 400 – Benutzer können die Seite nicht aufrufen.

- 403 – Benutzer sind nicht berechtigt, auf die Seite zuzugreifen.

- 404 – Die Seite wird nicht gefunden (was normalerweise bedeutet, dass der Kunde eine Seite ohne 301-Weiterleitung gelöscht hat).

- 500 – Interner Serverfehler, bei dem Sie sich mit dem Web-Entwicklungsteam in Verbindung setzen müssen, um die Ursache zu ermitteln.

Lösung:

- Entfernen Sie alle internen Links, die auf alte 404-Seiten verweisen, und aktualisieren Sie sie mit dem internen Link der umgeleiteten Seite.

- Lösen Sie die Umleitungsketten auf, indem Sie die mittleren Umleitungen entfernen. Wenn z.B. die Weiterleitung A zu den Weiterleitungen B, C und D führt, sollten Sie die Weiterleitungen B und C rückgängig machen. Das Endergebnis wird eine Weiterleitung A zu D sein.

- Es gibt auch eine Möglichkeit, dies in Screaming Frog und Google Search Console zu tun, wenn Sie diese Version verwenden.

Worauf man bei der Verwendung von Screaming Frog achten sollte

Das zweite, was ich tue, wenn ich eine neue Kundenseite erhalte, ist, ihre URL zu Screaming Frog hinzuzufügen.

Abhängig von der Größe der Kundenseite kann ich die Einstellungen so konfigurieren, dass bestimmte Bereiche der Seite auf einmal gecrawlt werden.

So sehen meine Screaming Frog Spider Konfigurationen aus:

Sie können dies in Ihren Spider-Einstellungen oder durch Ausschluss von Bereichen der Website tun.

Nachdem Sie die Ergebnisse von Screaming Frog erhalten haben, sind hier die Dinge, nach denen ich suche:

Google Analytics Code

Screaming Frog kann Ihnen helfen, herauszufinden, auf welchen Seiten der Google Analytics Code (UA-1234568-9) fehlt. Um den fehlenden Google Analytics Code zu finden, folgen Sie diesen Schritten:

- Gehen Sie zu Konfiguration in der Navigationsleiste, dann Benutzerdefiniert.

- Fügen Sie analytics\.js zu Filter 1 hinzu, dann ändern Sie das Drop-Down zu Enthält nicht.

Lösung:

- Kontaktieren Sie die Entwickler Ihres Kunden und bitten Sie sie, den Code zu den Seiten hinzuzufügen, auf denen er fehlt.

- Weitere Informationen zu Google Analytics finden Sie weiter unten im Abschnitt zu Google Analytics.

Google Tag Manager

Screaming Frog kann Ihnen auch helfen, herauszufinden, auf welchen Seiten das Google Tag Manager Snippet fehlt, mit ähnlichen Schritten:

- Gehen Sie zum Reiter Konfiguration in der Navigationsleiste, dann Benutzerdefiniert.

- Fügen Sie <iframe src-„//www.googletagmanager.com/ mit Does not contain im Filter ausgewählt.

Behebung:

- Gehen Sie zum Google Tag Manager, um zu sehen, ob es Fehler gibt und aktualisieren Sie diese bei Bedarf.

- Teilen Sie den Code mit den Entwicklern Ihres Kunden, um zu sehen, ob sie ihn wieder in die Website einfügen können.

Schema

Sie sollten auch überprüfen, ob die Website Ihres Kunden Schema-Markup auf ihrer Website verwendet. Schema oder strukturierte Daten helfen Suchmaschinen zu verstehen, was eine Seite auf der Website ist.

Um in Screaming Frog auf Schema Markup zu prüfen, folgen Sie diesen Schritten:

- Gehen Sie zum Reiter Konfiguration in der Navigationsleiste, dann Benutzerdefiniert.

- Geben Sie itemtype=“http://schema.\.org/ mit ‚Contain‘ im Filter ausgewählt.

Indizierung

Indizierung

Sie wollen bestimmen, wie viele Seiten für Ihren Kunden indiziert werden, folgen Sie diesem in Screaming Frog:

- Nachdem Ihre Seite in Screaming Frog geladen wurde, gehen Sie zu Direktiven > Filter > Index, um zu überprüfen, ob es irgendwelche fehlenden Codestücke gibt.

Wie man das beheben kann:

- Wenn die Seite neu ist, kann es sein, dass Google sie noch nicht indiziert hat.

- Überprüfen Sie die robots.txt-Datei, um sicherzustellen, dass Sie nichts verbieten, was Google crawlen soll.

- Überprüfen Sie, ob Sie die Sitemap Ihres Kunden an Google Search Console und Bing Webmaster Tools übermittelt haben.

- Führen Sie manuelle Recherchen durch (siehe unten).

Flash

Google kündigte 2016 an, dass Chrome Flash aufgrund der langsamen Seitenladezeiten blockieren wird. Wenn Sie also ein Audit durchführen, möchten Sie herausfinden, ob Ihr neuer Client Flash verwendet oder nicht.

Um dies in Screaming Frog zu tun, versuchen Sie Folgendes:

- Gehen Sie zur Spider-Konfiguration in der Navigation.

- Klicken Sie auf SWF prüfen.

- Filtern Sie die interne Registerkarte nach Flash, nachdem der Crawl abgeschlossen ist.

Wie man es behebt:

- Einbetten von Videos von YouTube. Google hat YouTube im Jahr 2006 gekauft, das ist kein Problem.

- Oder, entscheiden Sie sich für HTML5-Standards, wenn Sie ein Video hinzufügen.

Hier ein Beispiel für HTML5-Code zum Hinzufügen eines Videos:

<video controls="controls" width="320" height="240">> <source class="hiddenSpellError" data-mce-bogus="1" />src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.mp4" type="video/mp4"> <source src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.ogg" type="video/ogg" />Your browser does not support the video tag.</video>

JavaScript

Nach der Ankündigung von Google im Jahr 2015 ist die Verwendung von JavaScript für Ihre Website in Ordnung, solange Sie in Ihrer robots.txt nichts blockieren (darauf gehen wir gleich noch näher ein!). Dennoch sollten Sie einen Blick darauf werfen, wie das Javascript an Ihre Website übermittelt wird.

Wie Sie das Problem beheben können:

- Überprüfen Sie Javascript, um sicherzustellen, dass es nicht von robots.txt

- Stellen Sie sicher, dass Javascript auf dem Server läuft (dies hilft, Klartextdaten im Vergleich zu dynamischen Daten zu produzieren).

- Wenn Sie Angular JavaScript verwenden, lesen Sie diesen Artikel von Ben Oren darüber, warum es Ihre SEO-Bemühungen zerstören könnte.

- In Screaming Frog, gehen Sie zur Spider-Konfiguration in der Navigationsleiste und klicken Sie auf JavaScript überprüfen. Nachdem der Crawl abgeschlossen ist, filtern Sie Ihre Ergebnisse auf der Registerkarte Intern nach JavaScript.

Robots.txt

Robots.txt

Wenn Sie eine robots.txt zum ersten Mal überprüfen, sollten Sie nachsehen, ob irgendetwas Wichtiges blockiert oder nicht zugelassen wird.

Wenn Sie zum Beispiel diesen Code sehen:

Benutzer-Agent: *Disallow: /

Die Website Ihres Kunden ist für alle Web-Crawler blockiert.

Wenn Sie aber eine Datei wie die robots.txt von Zappos haben, sollte alles in Ordnung sein.

# Global robots.txt as of 2012-06-19User-agent: *Disallow: /bin/Disallow: /multiview/Disallow: /product/review/add/Disallow: /cartDisallow: /loginDisallow: /logoutDisallow: /registerDisallow: /account

Sie blockieren nur das, was die Webcrawler nicht finden sollen. Dieser Inhalt, der blockiert wird, ist für den Web-Crawler nicht relevant oder nützlich.

Lösung:

- Ihre robots.txt unterscheidet zwischen Groß- und Kleinschreibung, also aktualisieren Sie diese auf Kleinbuchstaben.

- Entfernen Sie alle Seiten, die als „Disallow“ aufgelistet sind und von den Suchmaschinen gecrawlt werden sollen.

- Screaming Frog ist standardmäßig nicht in der Lage, URLs zu laden, die von robots.txt verboten wurden. Wenn Sie die Standardeinstellungen in Screaming Frog ändern, wird es alle robots.txt ignorieren.

- Sie können auch gesperrte Seiten in Screaming Frog unter der Registerkarte Response Codes sehen, dann gefiltert nach Blocked by Robots.txt filter, nachdem Sie Ihren Crawl abgeschlossen haben.

- Wenn Sie eine Website mit mehreren Subdomains haben, sollten Sie für jede eine eigene robots.txt haben.

- Stellen Sie sicher, dass die Sitemap in der robots.txt aufgeführt ist.

Crawl-Fehler

Ich verwende DeepCrawl, Screaming Frog und Google und Bing Webmaster Tools, um die Crawl-Fehler meiner Kunden zu finden und zu überprüfen.

Um Ihre Crawl-Fehler in Screaming Frog zu finden, folgen Sie diesen Schritten:

- Nachdem der Crawl abgeschlossen ist, gehen Sie zu Bulk Reports.

- Scrollen Sie nach unten zu Response Codes, dann exportieren Sie den Server-seitigen Fehlerbericht und den Client-Fehlerbericht.

Behebung:

- Bei den Client-Fehlerberichten sollten Sie in der Lage sein, die meisten 404-Fehler im Backend der Website selbst per 301-Weiterleitung zu beheben.

- Bei den Server-Fehlerberichten sollten Sie mit dem Entwicklungsteam zusammenarbeiten, um die Ursache zu ermitteln. Bevor Sie diese Fehler im Stammverzeichnis beheben, sollten Sie unbedingt ein Backup der Website erstellen. Möglicherweise müssen Sie einfach eine neue .html-Zugangsdatei erstellen oder das PHP-Speicherlimit erhöhen.

- Sie sollten auch alle diese permanenten Weiterleitungen aus der Sitemap und allen internen oder externen Links entfernen.

- Sie können auch 404 in Ihrer URL verwenden, um die Nachverfolgung in Google Analytics zu erleichtern.

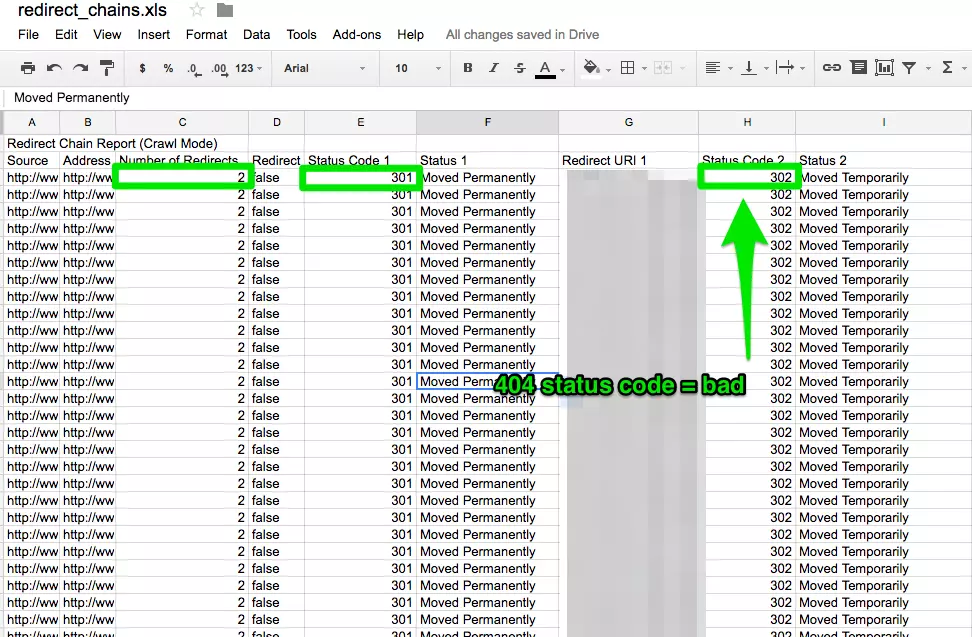

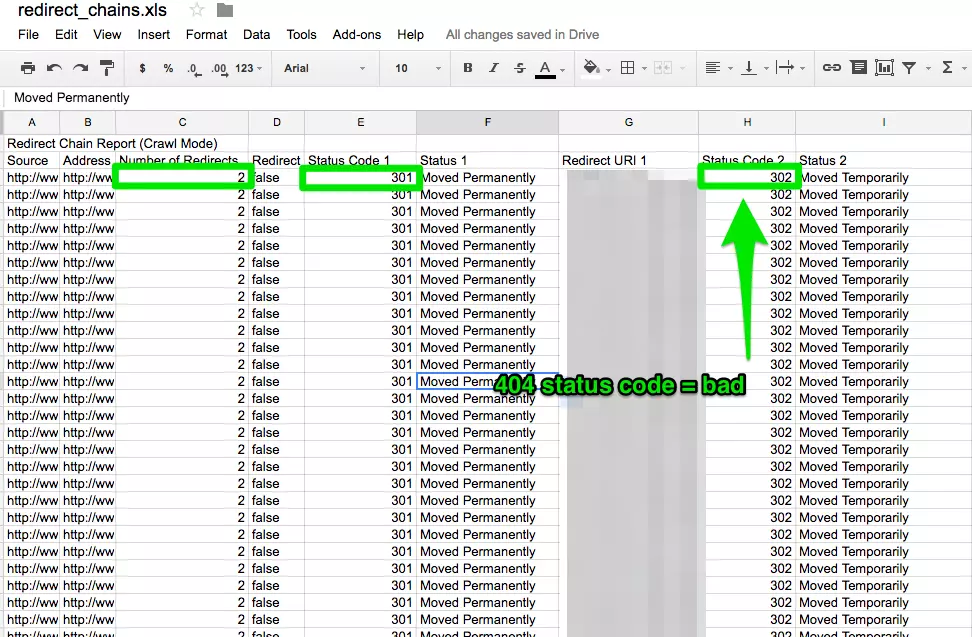

Weiterleitungsketten

Weiterleitungsketten verursachen nicht nur ein schlechtes Nutzererlebnis, sondern verlangsamen auch die Seitengeschwindigkeit, die Konversionsraten sinken und jegliche Linkliebe, die Sie zuvor erhalten haben, geht verloren.

Weiterleitungsketten zu beheben ist ein schneller Gewinn für jedes Unternehmen.

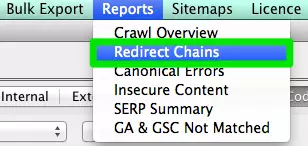

Wie man sie behebt:

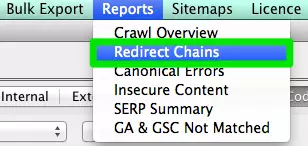

- In Screaming Frog, nachdem Sie Ihren Crawl abgeschlossen haben, gehen Sie zu Reports > Redirect Chains, um den Crawl-Pfad Ihrer Weiterleitungen zu sehen. In einer Excel-Tabelle können Sie verfolgen, ob Ihre 301 Weiterleitungen auch 301 Weiterleitungen bleiben. Wenn Sie einen 404-Fehler sehen, sollten Sie diesen bereinigen.

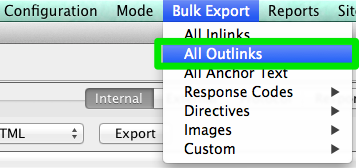

Interne & Externe Links

Wenn ein Benutzer auf einen Link zu Ihrer Website klickt und einen 404 Fehler erhält, ist das keine gute Benutzererfahrung.

Und es hilft den Suchmaschinen auch nicht, Sie besser zu finden.

Um meine defekten internen und externen Links zu finden, verwende ich Integrity für Mac. Sie können auch Xenu Sleuth verwenden, wenn Sie ein PC-Benutzer sind.

Ich zeige Ihnen auch, wie Sie diese internen und externen Links in Screaming Frog und DeepCrawl finden, wenn Sie diese Software verwenden.

Lösung:

- Wenn Sie Integrity oder Xenu Sleuth verwenden, rufen Sie die URL der Website Ihres Kunden auf und Sie erhalten eine vollständige Liste der fehlerhaften URLs. Sie können diese entweder selbst manuell aktualisieren oder, wenn Sie mit einem Entwicklerteam zusammenarbeiten, dieses um Hilfe bitten.

- Wenn Sie Screaming Frog verwenden, gehen Sie nach Abschluss des Crawls in der Navigationsleiste auf Bulk Export und dann auf All Outlinks. Sie können nach URLs sortieren und sehen, welche Seiten ein 404-Signal senden. Wiederholen Sie den gleichen Schritt mit All Inlinks.

- Wenn Sie DeepCrawl benutzen, gehen Sie auf die Registerkarte Unique Broken Links unter dem Abschnitt Internal Links.

URLs

Jedes Mal, wenn Sie einen neuen Kunden übernehmen, möchten Sie dessen URL-Format überprüfen. Worauf muss ich bei den URLs achten?

- Parameter – Wenn die URL seltsame Zeichen wie ?, = oder + enthält, handelt es sich um eine dynamische URL, die zu doppeltem Inhalt führen kann, wenn sie nicht optimiert wird.

- Benutzerfreundlich – Ich halte die URLs gerne kurz und einfach und entferne alle zusätzlichen Schrägstriche.

Wie man das behebt:

- Sie können in Google nach Parameter-URLs suchen, indem Sie site:www.buyaunicorn.com/ inurl: „?“ oder was auch immer Sie denken, dass der Parameter enthalten könnte.

- Nachdem Sie den Crawl mit Screaming Frog durchgeführt haben, schauen Sie sich die URLs an. Wenn Sie Parameter sehen, die Duplikate Ihres Inhalts erzeugen, müssen Sie Folgendes vorschlagen:

- Fügen Sie ein kanonisches Tag zur Haupt-URL-Seite hinzu. Zum Beispiel ist www.buyaunicorn.com/magical-headbands die Hauptseite und ich sehe www.buyaunicorn.com/magical-headbands/?dir=mode123$, dann müsste das kanonische Tag zu www.buyaunicorn.com/magical-headbands hinzugefügt werden.

- Aktualisieren Sie Ihre Parameter in Google Search Console unter Crawl > URL-Parameter.

- Lassen Sie die doppelten URLs in der robots.txt.

Schritt 2: Überprüfen Sie Google Search Console und Bing Webmaster Tools.

Tools:

- Google Search Console.

- Bing Webmaster Tools.

- Sublime Text (oder ein beliebiges Texteditor-Tool).

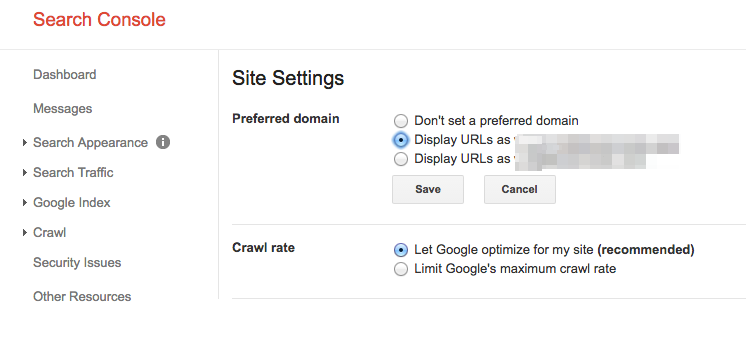

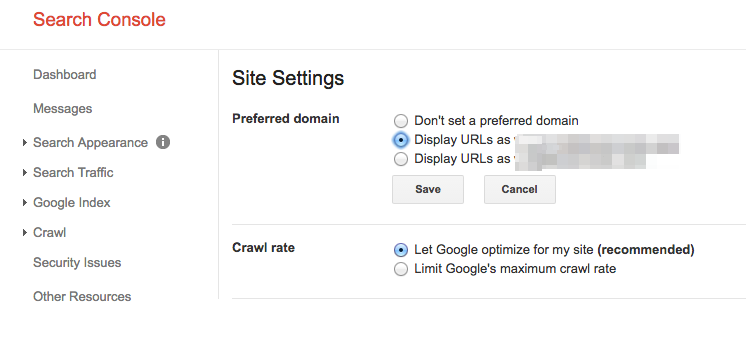

Setzen Sie eine bevorzugte Domain

Seit dem Panda-Update ist es von Vorteil, den Suchmaschinen die bevorzugte Domain zu verdeutlichen. So können Sie auch sicherstellen, dass alle Ihre Links einer einzigen Website zugute kommen, anstatt auf zwei Websites verteilt zu sein.

Lösung:

- Klicken Sie in der Google Search Console auf das Zahnradsymbol in der oberen rechten Ecke.

- Wählen Sie aus, welche der URLs die bevorzugte Domain ist.

- Sie müssen die bevorzugte Domain nicht in den Bing Webmaster Tools festlegen, sondern nur Ihre Sitemap übermitteln, damit Bing Ihre bevorzugte Domain ermitteln kann.

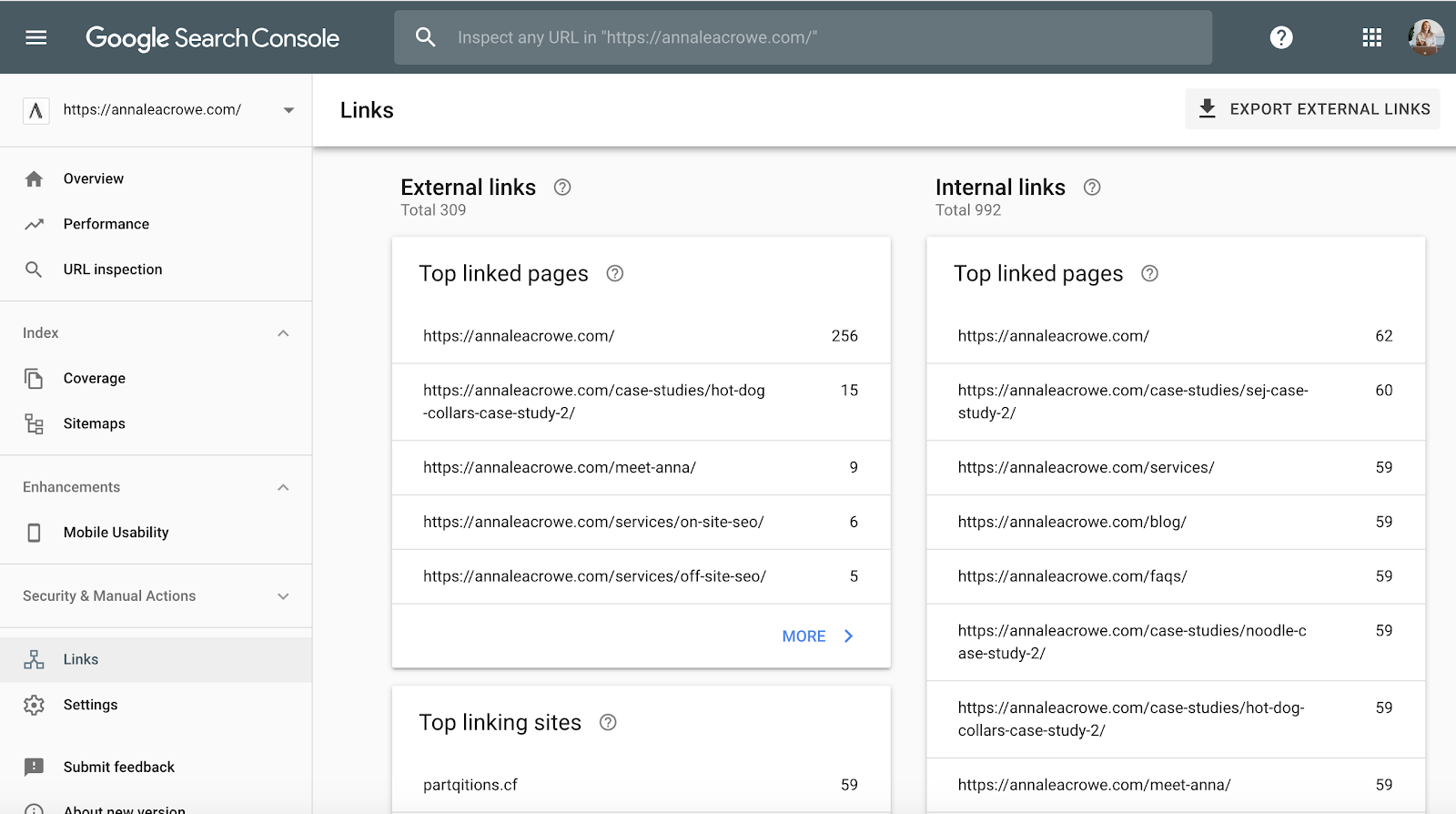

Backlinks

Mit der Ankündigung, dass Pinguin in Echtzeit kommt, ist es von entscheidender Bedeutung, dass die Backlinks Ihres Kunden den Google-Standards entsprechen.

Wenn Sie feststellen, dass ein großer Teil der Backlinks von einer Seite einer Website auf die Website Ihres Kunden verweist, sollten Sie die notwendigen Schritte unternehmen, um dies zu bereinigen, und zwar SCHNELL!

Wie Sie das Problem beheben können:

- In der Google Search Console gehen Sie auf Links > und sortieren Sie dann Ihre Top-Link-Seiten.

- Kontaktieren Sie die Unternehmen, die von einer Seite auf Sie verlinken, damit sie die Links entfernen.

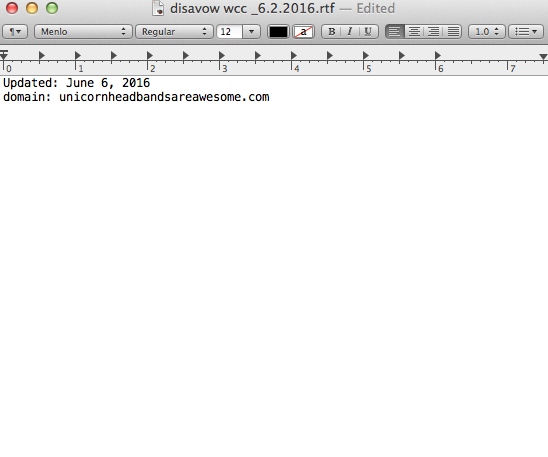

- Oder fügen Sie sie zu Ihrer Disavow-Liste hinzu. Wenn Sie Unternehmen zu Ihrer Disavow-Liste hinzufügen, seien Sie sehr vorsichtig, wie und warum Sie dies tun. Sie wollen keine wertvollen Links entfernen.

Hier ist ein Beispiel dafür, wie meine Disavow-Datei aussieht:

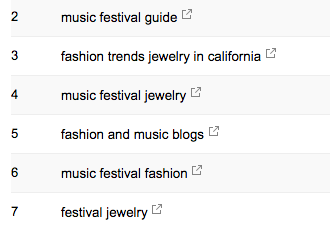

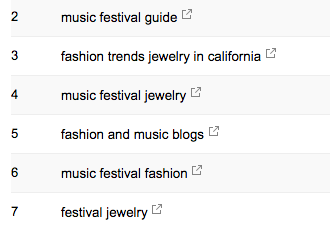

Schlüsselwörter

Schlüsselwörter

Als SEO-Berater ist es meine Aufgabe, die Marktlandschaft meines Kunden kennen zu lernen. Ich muss wissen, wer seine Zielgruppe ist, wonach sie sucht und wie sie sucht. Zu Beginn werfe ich einen Blick auf die Suchbegriffe, von denen sie bereits Traffic erhalten.

- In der Google Search Console zeigt Ihnen Search Analytics unter Search Traffic >, welche Keywords Ihrem Kunden bereits Klicks bescheren.

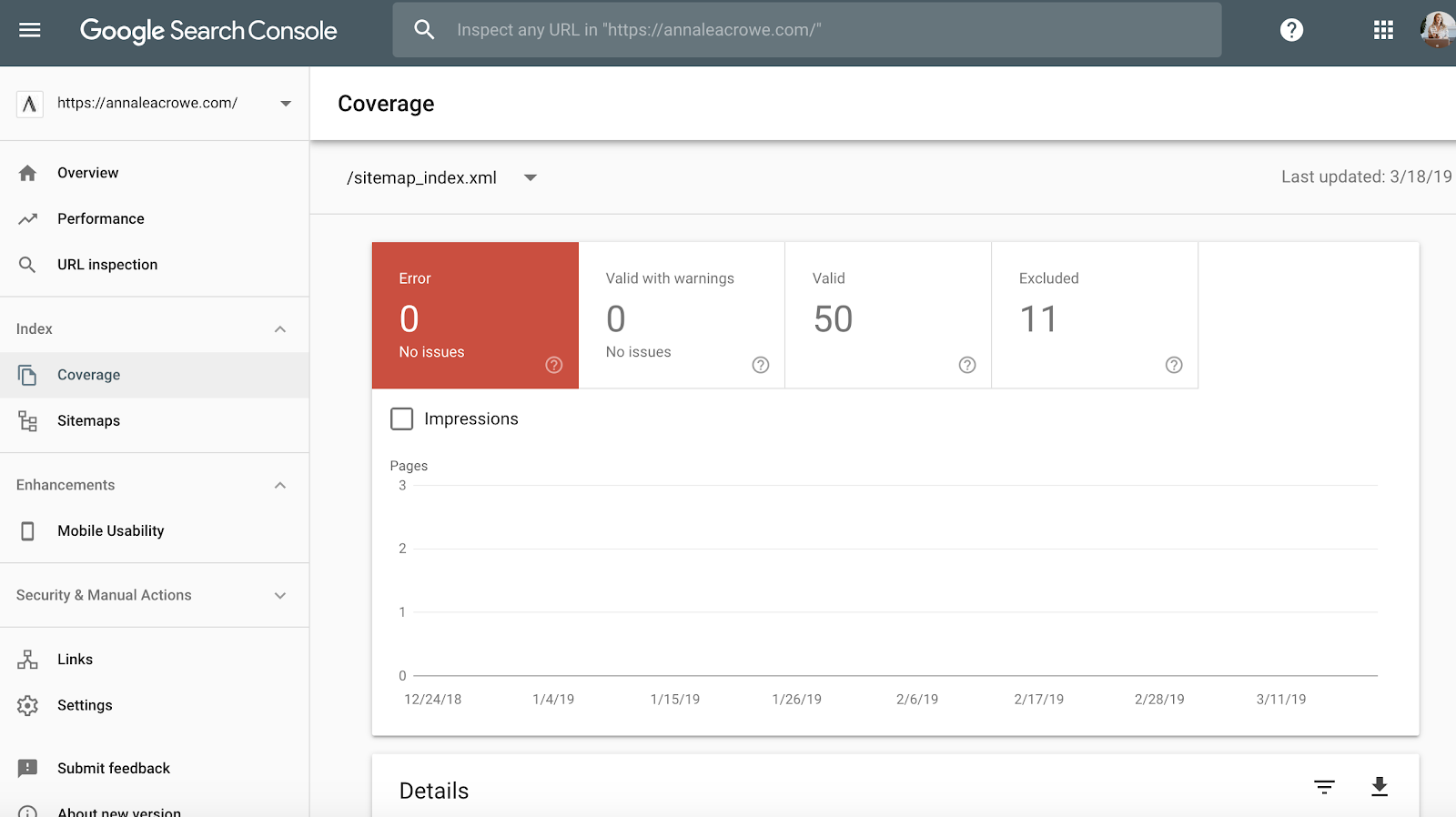

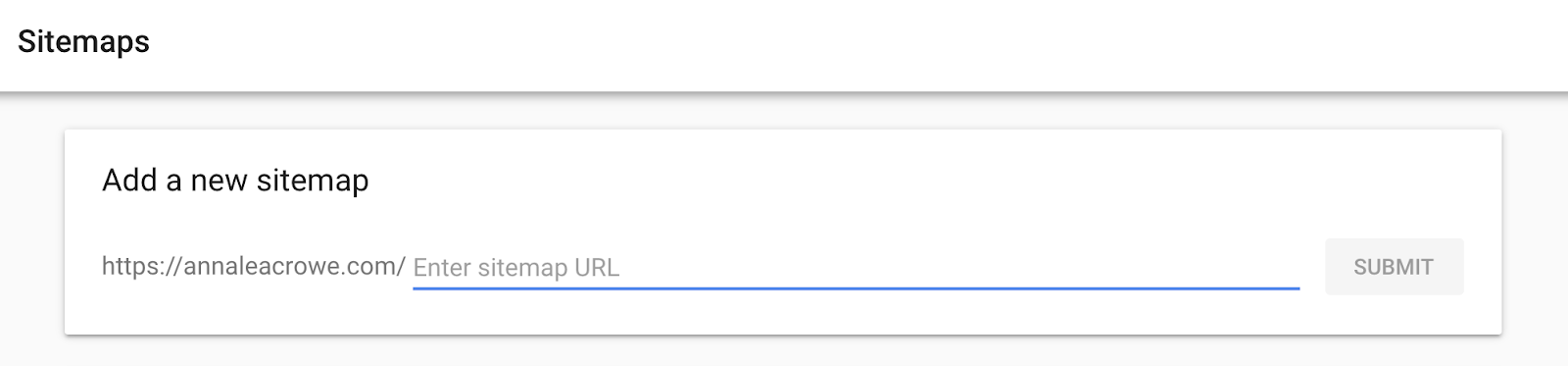

Sitemap

Sitemap

Sitemaps sind wichtig, damit die Suchmaschinen die Website Ihres Kunden crawlen. Sie sprechen ihre Sprache. Bei der Erstellung von Sitemaps sind einige Dinge zu beachten:

- Fügen Sie keine Parameter-URLs in Ihre Sitemap ein.

- Fügen Sie keine nicht indizierbaren Seiten ein.

- Wenn die Website unterschiedliche Subdomains für Mobilgeräte und Desktop hat, fügen Sie den rel=“alternate“-Tag in die Sitemap ein.

Lösung:

- Gehen Sie zu Google Search Console > Index > Sitemaps, um die in der Sitemap indizierten URLs mit den URLs im Webindex zu vergleichen.

- Dann führen Sie eine manuelle Suche durch, um festzustellen, welche Seiten nicht indiziert werden und warum.

- Wenn Sie in der Sitemap Ihres Kunden alte weitergeleitete URLs finden, entfernen Sie diese. Diese alten Weiterleitungen werden sich negativ auf Ihre Suchmaschinenoptimierung auswirken, wenn Sie sie nicht entfernen.

- Wenn der Kunde neu ist, reichen Sie eine neue Sitemap für ihn sowohl in den Bing Webmaster Tools als auch in der Google Search Console ein.

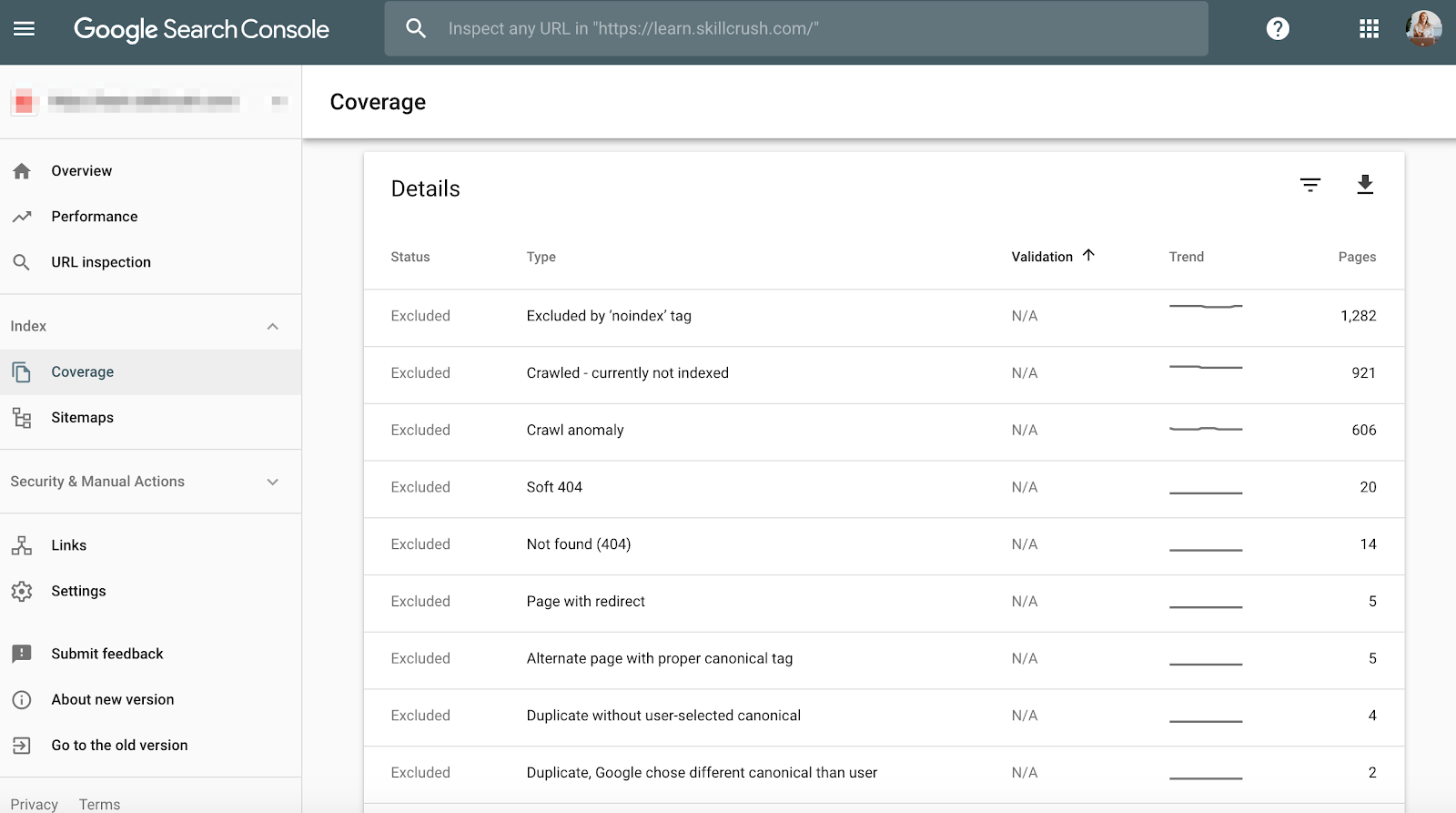

Crawl

Crawl-Fehler sind wichtig, denn sie sind nicht nur schlecht für den Nutzer, sondern auch für die Platzierung Ihrer Website. Und John Mueller erklärte, dass eine niedrige Crawl-Rate ein Zeichen für eine qualitativ schlechte Website sein kann.

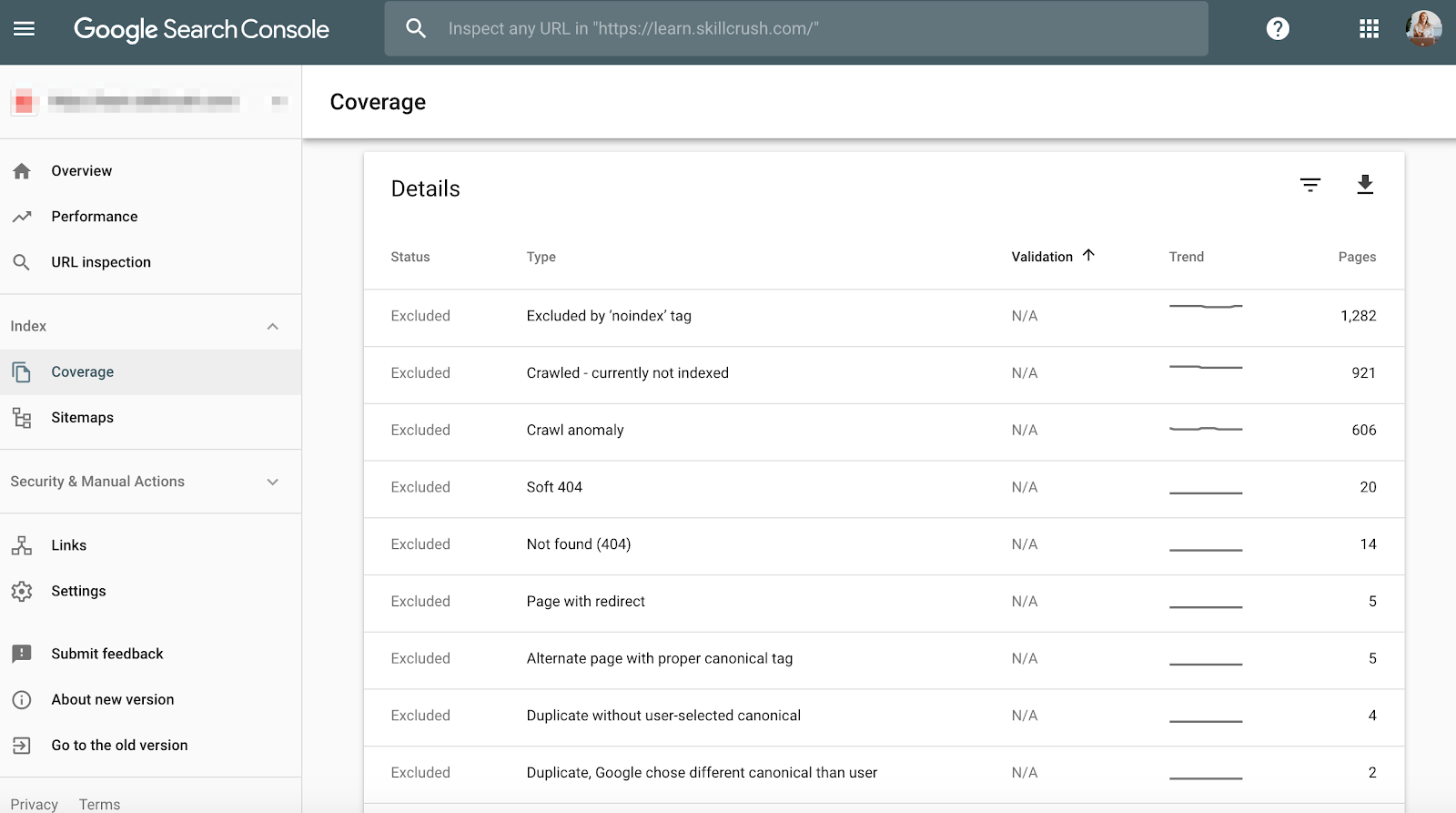

Um dies in der Google Search Console zu überprüfen, gehen Sie zu Coverage > Details.

Um dies in den Bing Webmaster Tools zu überprüfen, gehen Sie zu Berichte & Daten > Crawl-Informationen.

Lösung:

- Überprüfen Sie Ihre Crawl-Fehler manuell, um festzustellen, ob es Crawl-Fehler gibt, die von alten Produkten stammen, die nicht mehr existieren, oder ob Sie Crawl-Fehler sehen, die in der robots.txt-Datei verboten werden sollten.

- Wenn Sie herausgefunden haben, woher die Crawl-Fehler kommen, können Sie 301-Weiterleitungen zu ähnlichen Seiten einrichten, die auf die toten Seiten verweisen.

- Sie sollten auch die Crawl-Statistiken in der Google Search Console mit der durchschnittlichen Ladezeit in Google Analytics abgleichen, um zu sehen, ob es eine Korrelation zwischen der Ladezeit und den pro Tag gecrawlten Seiten gibt.

Strukturierte Daten

Wie oben im Schema-Abschnitt von Screaming Frog erwähnt, können Sie das Schema-Markup Ihres Kunden in Google Search Console überprüfen.

Verwenden Sie den individuellen Rich-Results-Statusbericht in Google Search Console. (Hinweis: Der Bericht über strukturierte Daten ist nicht mehr verfügbar).

So können Sie feststellen, welche Seiten Fehler in den strukturierten Daten aufweisen, die Sie später beheben müssen.

Fehlerbehebung:

- Google Search Console teilt Ihnen mit, was im Schema fehlt, wenn Sie die Live-Version testen.

- Schreiben Sie das Schema auf der Grundlage Ihrer Fehlercodes in einem Texteditor neu und senden Sie es zur Aktualisierung an das Web-Entwicklungsteam. Ich verwende Sublime Text für meine Textbearbeitung. Mac-Benutzer haben einen eingebauten und PC-Benutzer können das von Google gekaufte YouTube verwenden.

Schritt 3: Überprüfen Sie Google Analytics

Tools:

- Google Analytics.

- Google Tag Manager Assistant Chrome Extension.

- Annie Cushing Campaign Tagging Guide.

Ansichten

Wenn ich einen neuen Kunden bekomme, richte ich 3 verschiedene Ansichten in Google Analytics ein.

- Berichtsansicht.

- Master-Ansicht.

- Testansicht.

Diese verschiedenen Ansichten geben mir die Flexibilität, Änderungen vorzunehmen, ohne die Daten zu beeinträchtigen.

So wird’s gemacht:

- Gehen Sie in Google Analytics zu Admin > Ansicht > Ansichtseinstellungen, um die drei verschiedenen Ansichten oben zu erstellen.

- Stellen Sie sicher, dass der Abschnitt Bot-Filterung aktiviert ist, um alle Treffer von Bots und Spiders auszuschließen.

- Verknüpfen Sie Google Ads und Google Search Console.

- Letzen Endes sollten Sie sicherstellen, dass das Site Search Tracking aktiviert ist.

Filter

Sie sollten sicherstellen, dass Sie Ihre IP-Adresse und die IP-Adresse Ihres Kunden zu den Filtern in Google Analytics hinzufügen, damit Sie keinen falschen Traffic erhalten.

Wie man das behebt:

- Gehen Sie zu Admin> Ansicht > Filter

- Dann sollten die Einstellungen so gesetzt werden, dass > Traffic von den IP-Adressen > ausgeschlossen wird, die gleich sind.

Tracking Code

Tracking Code

Sie können den Quellcode manuell überprüfen, oder Sie können meine Screaming Frog Technik von oben verwenden.

Wenn der Code vorhanden ist, sollten Sie überprüfen, ob er in Echtzeit ausgelöst wird.

- Um dies zu überprüfen, gehen Sie auf die Website Ihres Kunden und klicken Sie ein wenig auf der Website herum.

- Gehen Sie dann zu Google Analytics > Echtzeit > Standorte, Ihr Standort sollte angezeigt werden.

- Wenn Sie Google Tag Manager verwenden, können Sie dies auch mit der Chrome-Erweiterung Google Tag Assistant überprüfen.

Wie Sie das Problem beheben können:

- Wenn der Code nicht funktioniert, sollten Sie das Code-Snippet überprüfen, um sicherzustellen, dass es das richtige ist. Wenn Sie mehrere Websites verwalten, haben Sie möglicherweise den Code einer anderen Website hinzugefügt.

- Bevor Sie den Code kopieren, verwenden Sie einen Texteditor und kein Textverarbeitungsprogramm, um das Snippet auf die Website zu kopieren. Dies kann zu zusätzlichen Zeichen oder Leerzeichen führen.

- Die Funktionen unterscheiden Groß- und Kleinschreibung, stellen Sie also sicher, dass im Code alles klein geschrieben wird.

Indexierung

Wenn Sie die Gelegenheit hatten, in der Google Search Console herumzuspielen, ist Ihnen wahrscheinlich der Abschnitt Coverage aufgefallen.

Wenn ich einen Kunden prüfe, überprüfe ich seine Indexierung in der Google Search Console im Vergleich zu Google Analytics. So geht’s:

- In Google Search Console gehen Sie zu Abdeckung

- In Google Analytics gehen Sie zu Akquisition > Kanäle > Organische Suche > Landing Page.

- Wenn Sie hier sind, gehen Sie zu Erweitert > Site Usage > Sessions > 9.

Wie Sie das Problem beheben können:

- Vergleichen Sie die Zahlen aus der Google Search Console mit den Zahlen aus Google Analytics, wenn die Zahlen stark voneinander abweichen, dann wissen Sie, dass, obwohl die Seiten indiziert werden, nur ein Bruchteil organischen Traffic erhält.

Kampagnen-Tagging

Das letzte, was Sie in Google Analytics überprüfen sollten, ist, ob Ihr Kunde das Kampagnen-Tagging richtig einsetzt. Sie möchten nicht, dass Ihre Arbeit nicht gewürdigt wird, weil Sie das Kampagnen-Tagging vergessen haben.

Lösung:

- Stellen Sie eine Kampagnen-Tagging-Strategie für Google Analytics auf und teilen Sie diese mit Ihrem Kunden. Annie Cushing hat einen großartigen Leitfaden für Kampagnen-Tagging zusammengestellt.

- Richten Sie Event Tracking ein, wenn Ihr Kunde mobile Anzeigen oder Videos verwendet.

Keywords

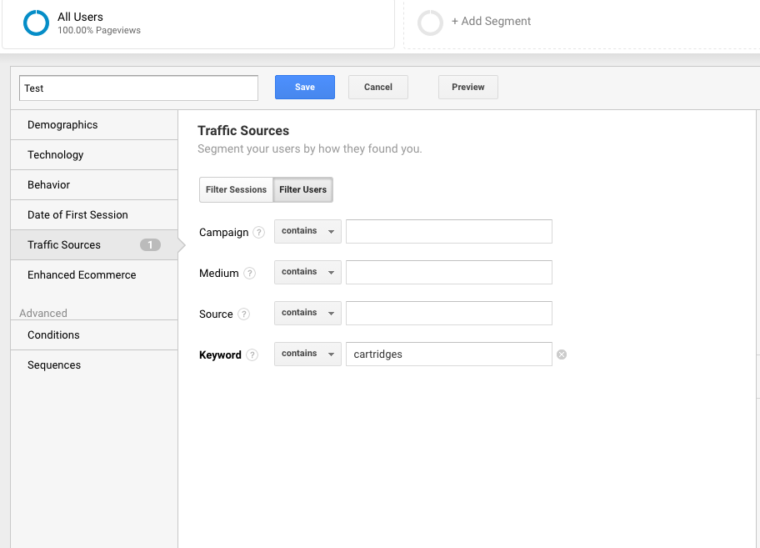

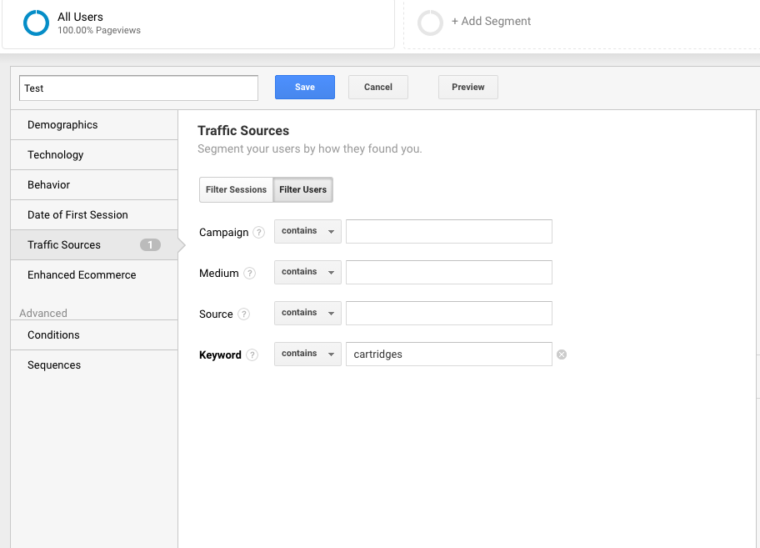

Sie können Google Analytics nutzen, um Einblicke in potenzielle Keyword-Perlen für Ihren Kunden zu erhalten. Um Schlüsselwörter in Google Analytics zu finden, gehen Sie folgendermaßen vor:

Gehen Sie zu Google Analytics > Verhalten > Website-Suche > Suchbegriffe. So erhalten Sie einen Überblick darüber, wonach Kunden auf der Website suchen.

Als Nächstes verwende ich diese Suchbegriffe, um ein neues Segment in Google Analytics zu erstellen, um zu sehen, welche Seiten auf der Website bereits für diesen bestimmten Schlüsselbegriff ranken.

Schritt 4: Manuelle Überprüfung

Tools:

- Google Analytics.

- Zugang zu Server und Host des Kunden.

- You Get Signal.

- Pingdom.

- PageSpeed Tools.

- Wayback Machine.

Eine Version der Website Ihres Kunden ist durchsuchbar

Suchen Sie auf alle möglichen Arten nach einer Website. Zum Beispiel:

- http://annaisaunicorn.com

- https://annaisaunicorn.com

- http://www.annaisaunicorn.com

Wie Highlander sagen würde, kann es „nur eine“ Website geben, die durchsuchbar ist.

Wie man das beheben kann: Verwenden Sie eine 301-Weiterleitung für alle URLs, die nicht die primäre Website sind, auf die kanonische Website.

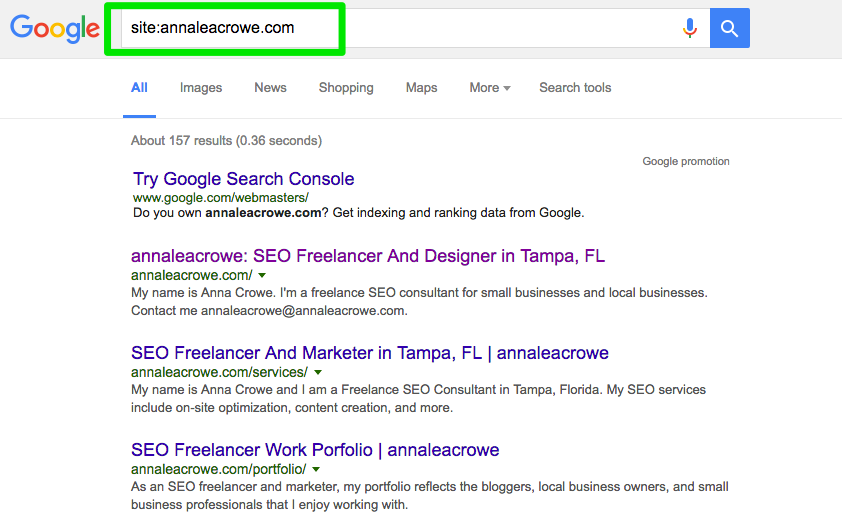

Indexierung

Führen Sie eine manuelle Suche in Google und Bing durch, um festzustellen, wie viele Seiten von Google indexiert werden. Diese Zahl stimmt nicht immer mit den Daten von Google Analytics und Google Search Console überein, sollte Ihnen aber eine grobe Schätzung ermöglichen.

Für die Überprüfung gehen Sie wie folgt vor:

- Suchen Sie eine Website in den Suchmaschinen.

- Suchen Sie manuell, um sicherzustellen, dass nur die Marke Ihres Kunden erscheint.

- Überprüfen Sie, ob die Homepage auf der ersten Seite steht. John Mueller sagte, es sei nicht notwendig, dass die Homepage als erstes Ergebnis erscheint.

Lösung:

- Wenn eine andere Marke in den Suchergebnissen auftaucht, haben Sie ein größeres Problem. Schauen Sie sich die Analysen an, um das Problem zu diagnostizieren.

- Wenn die Homepage nicht als erstes Ergebnis angezeigt wird, führen Sie eine manuelle Überprüfung der Website durch, um zu sehen, was fehlt. Dies könnte auch bedeuten, dass die Website eine Abstrafung oder eine schlechte Website-Architektur aufweist, was ein größeres Problem bei der Neugestaltung der Website darstellt.

- Überprüfen Sie die Anzahl der organischen Zielseiten in Google Analytics, um zu sehen, ob sie mit der Anzahl der Suchergebnisse übereinstimmt, die Sie in der Suchmaschine gesehen haben. So können Sie feststellen, welche Seiten von den Suchmaschinen als wertvoll eingestuft werden.

Caching

Ich führe eine kurze Überprüfung durch, um zu sehen, ob die Top-Seiten von Google zwischengespeichert werden. Google verwendet diese zwischengespeicherten Seiten, um Ihre Inhalte mit Suchanfragen zu verknüpfen.

Um zu prüfen, ob Google die Seiten Ihres Kunden zwischengespeichert hat, gehen Sie wie folgt vor:

http://webcache.googleusercontent.com/search?q=cache:https://www.searchenginejournal.com/pubcon-day-3-women-in-digital-amazon-analytics/176005/

Auf jeden Fall zur Nur-Text-Version wechseln.

Sie können dies auch in der Wayback Machine überprüfen.

Behebung:

- Überprüfen Sie den Server des Clients, um zu sehen, ob er nicht funktioniert oder langsamer als gewöhnlich arbeitet. Möglicherweise liegt ein interner Serverfehler oder ein Datenbankverbindungsfehler vor. Dies kann passieren, wenn mehrere Benutzer gleichzeitig versuchen, auf den Server zuzugreifen.

- Prüfen Sie mit einem Reverse-IP-Adress-Check, wer noch auf Ihrem Server ist. Sie können für diese Phase die You Get Signal-Website verwenden. Möglicherweise müssen Sie den Server Ihres Kunden aufrüsten oder ein CDN verwenden, wenn sich zweifelhafte Domains den Server teilen.

- Prüfen Sie, ob der Kunde bestimmte Seiten von der Website entfernt.

Hosting

Auch wenn dies für manche ein wenig technisch wird, ist es für Ihren SEO-Erfolg unerlässlich, die mit der Website Ihres Kunden verbundene Hosting-Software zu überprüfen. Das Hosting kann der Suchmaschinenoptimierung schaden, und all Ihre harte Arbeit wäre umsonst.

Sie müssen Zugang zum Server Ihres Kunden haben, um manuell alle Probleme zu überprüfen. Die häufigsten Hosting-Probleme, die ich sehe, sind die falsche TLD und eine langsame Website-Geschwindigkeit.

Wie man sie behebt:

- Wenn Ihr Kunde die falsche TLD hat, müssen Sie sicherstellen, dass die Länder-IP-Adresse mit dem Land verbunden ist, in dem Ihr Kunde am meisten arbeitet. Wenn Ihr Kunde eine .co-Domäne und eine .com-Domäne hat, sollten Sie die .co-Domäne auf die primäre Domäne Ihres Kunden auf der .com-Domäne umleiten.

- Wenn Ihr Kunde eine langsame Website-Geschwindigkeit hat, sollten Sie sich schnell darum kümmern, denn die Website-Geschwindigkeit ist ein Rankingfaktor. Finden Sie mit Tools wie PageSpeed Tools und Pingdom heraus, was die Website langsam macht. Hier ein Blick auf einige der häufigsten Probleme mit der Seitengeschwindigkeit:

- Host.

- Große Bilder.

- Eingebettete Videos.

- Plugins.

- Anzeigen.

- Theme.

- Widgets.

- Wiederholtes Skript oder dichter Code.

Core Web Vitals Audit

Core Web Vitals ist eine Sammlung von drei Metriken, die für die Nutzererfahrung einer Website repräsentativ sind. Sie sind wichtig, weil Google seine Algorithmen im Frühjahr 2021 aktualisiert, um Core Web Vitals als Ranking-Faktor einzubeziehen.

Auch wenn der Ranking-Faktor voraussichtlich nur ein kleiner Faktor sein wird, ist es dennoch wichtig, die Core Web Vitals-Werte zu überprüfen und Bereiche mit Verbesserungspotenzial zu ermitteln.

Warum ist es wichtig, Core Web Vitals in Ihr Audit einzubeziehen?

Die Verbesserung der Core Web Vitals-Werte wird nicht nur das Suchranking verbessern, sondern, was vielleicht noch wichtiger ist, sich durch mehr Konversionen und Einnahmen auszahlen.

Verbesserungen der Geschwindigkeit und der Seitenleistung werden mit höheren Verkäufen, mehr Verkehr und mehr Anzeigenklicks in Verbindung gebracht.

Ein Upgrade des Webhostings und die Installation eines neuen Plugins können die Seitengeschwindigkeit verbessern, haben aber wenig (wenn überhaupt) Auswirkungen auf die Core Web Vitals.

Die Messung erfolgt an dem Punkt, an dem jemand Ihre Website buchstäblich auf sein Mobiltelefon herunterlädt.

Das bedeutet, dass der Engpass bei der Internetverbindung und dem mobilen Gerät liegt. Ein schneller Server wird eine langsame Internetverbindung auf einem preisgünstigen Mobiltelefon nicht beschleunigen.

Da viele der Lösungen eine Änderung des Codes in einer Vorlage oder der Kerndateien des Content Management Systems selbst erfordern, wird ein Plugin für die Seitengeschwindigkeit nur von geringem Nutzen sein.

Es gibt viele Ressourcen, die helfen, Lösungen zu verstehen. Die meisten Lösungen erfordern jedoch die Unterstützung eines Entwicklers, der sich mit dem Aktualisieren und Ändern von Kerndateien in Ihrem Content-Management-System auskennt.

Die Behebung von Problemen mit Core Web Vitals kann schwierig sein. WordPress, Drupal und andere Content-Management-Systeme (CMS) wurden nicht für Core Web Vitals entwickelt.

Es ist wichtig zu wissen, dass der Prozess zur Verbesserung von Core Web Vitals die Änderung der Codierung im Kern von WordPress und anderen CMS beinhaltet.

Im Wesentlichen erfordert die Verbesserung von Core Web Vitals, dass eine Website etwas tut, wofür sie nie gedacht war, als die Entwickler ein Theme oder CMS erstellten.

Der Zweck eines Core Web Vitals-Audits ist es, festzustellen, was behoben werden muss, und diese Informationen an einen Entwickler weiterzugeben, der dann die notwendigen Änderungen vornehmen kann.

Was sind Core Web Vitals?

Core Web Vitals bestehen aus drei Messgrößen, die zusammen ermitteln, wie schnell der wichtigste Teil Ihrer Seite geladen wird, wie schnell ein Benutzer mit der Seite interagieren kann (Beispiel: Klicken auf eine Schaltfläche) und wie schnell die Webseite stabil wird, ohne dass sich Seitenelemente verschieben.

Es gibt:

- Largest Contentful Paint (LCP).

- First Input Delay (FID).

- Cumulative Layout Shift (CLS).

Es gibt zwei Arten von Scores für die Core Web Vitals:

- Labordaten.

- Felddaten.

Labdaten

Labdaten werden generiert, wenn Sie eine Seite durch Google Lighthouse oder in PageSpeed Insights laufen lassen.

Labdaten bestehen aus Scores, die durch ein simuliertes Gerät und eine Internetverbindung generiert werden. Der Zweck besteht darin, der Person, die an der Website arbeitet, eine Vorstellung davon zu geben, welche Teile der Core Web Vitals verbessert werden müssen.

Der Wert eines Tools wie PageSpeed Insights besteht darin, dass es spezifischen Code und Seitenelemente identifiziert, die eine schlechte Bewertung einer Seite verursachen.

Felddaten

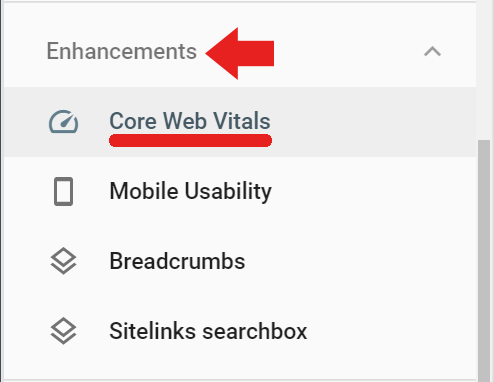

Felddaten sind tatsächliche Core Web Vitals-Bewertungen, die vom Google Chrome-Browser für den Chrome User Experience Report (auch bekannt als CrUX) gesammelt wurden.

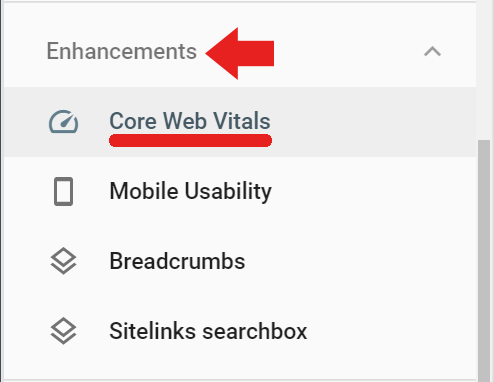

Die Felddaten sind in der Google Search Console unter der Registerkarte „Erweiterungen“ über den Link „Core Web Vitals“ verfügbar (auf die Felddaten kann auch über diesen Link zugegriffen werden) https://search.google.com/search-console/core-web-vitals.

Die in Google Search Console gemeldeten Felddaten stammen von besuchten Seiten, die eine Mindestanzahl an Besuchen und Messungen hatten. Wenn Google nicht genügend Bewertungen erhält, dann wird Google Search Console diese Bewertung nicht melden.

Screaming Frog für Core Web Vitals Audit

Screaming Frog Version 14.2 hat jetzt die Möglichkeit, eine bestandene oder nicht bestandene Core Web Vitals Bewertung anzuzeigen. Sie müssen Screaming Frog über einen Schlüssel mit der PageSpeed Insights API (erhalten Sie hier einen API-Schlüssel) verbinden.

Um Ihren Page Speed Insights API-Schlüssel bei Screaming Frog zu registrieren, navigieren Sie zuerst zu Konfiguration > API-Zugang > PageSpeed Insights

Dort sehen Sie einen Platz, um Ihren API-Schlüssel einzugeben und ihn mit dem Service zu verbinden.

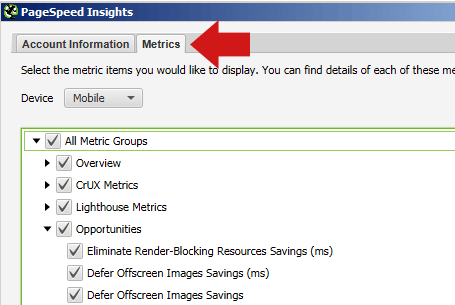

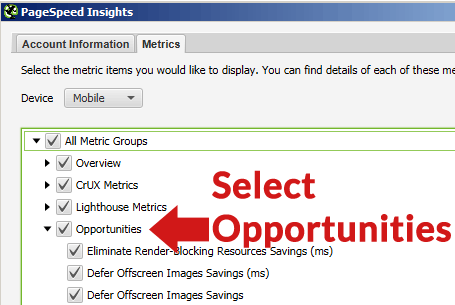

Im gleichen PageSpeed Insights-Popup können Sie auch die Registerkarte „Metrics“ auswählen und die Kästchen ankreuzen, die angeben, welche Metriken Sie gemeldet haben möchten.

Wählen Sie unbedingt „Mobile“ für das Gerät aus, da dies die Metrik ist, die für Ranking-Zwecke wichtig ist.

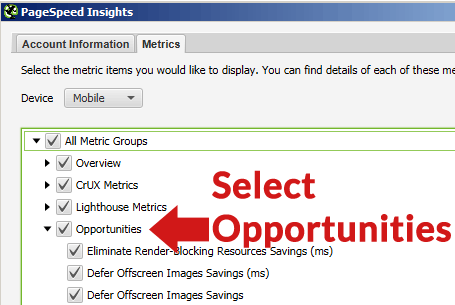

Wenn Sie den Reiter „Möglichkeiten“ auswählen, zeigt Ihnen Screaming Frog nach dem Crawl eine Liste mit verschiedenen Arten von Verbesserungen (wie z.B. Offscreen-Bilder verschieben, unbenutzte CSS entfernen, etc.).

Vor dem Crawling beachten

Es ist in der Regel nicht nötig, eine ganze Website zu crawlen und eine erschöpfende seitenweise Auflistung dessen zu erstellen, was mit jeder einzelnen Seite der Website nicht stimmt.

Vor dem Crawlen sollten Sie sich überlegen, ob Sie nicht eine repräsentative Gruppe von Seiten crawlen wollen. Wählen Sie dazu zunächst eine Gruppe von Seiten aus, die für jeden Abschnitt oder jede Kategorie der Website repräsentativ sind. Erstellen Sie eine Tabellenkalkulation, eine Textdateiliste oder fügen Sie die URLs manuell über die Registerkarte Upload in Screaming Frog ein.

Die meisten Websites enthielten Seiten und Beiträge, die mit ähnlicher Seitenstruktur und Inhalt erstellt wurden. Zum Beispiel werden alle Seiten in einer „News“-Kategorie ziemlich ähnlich sein, Seiten in einer „Reviews“-Kategorie werden sich ebenfalls ähneln.

Sie können Zeit sparen, indem Sie eine repräsentative Gruppe von Seiten crawlen, um Probleme zu identifizieren, die in den einzelnen Kategorien auftreten, sowie Probleme, die allen Seiten gemein sind und die behoben werden müssen.

Aufgrund dieser Ähnlichkeiten werden auch die entdeckten Probleme ähnlich sein. Möglicherweise ist es nur notwendig, eine Handvoll repräsentativer Seiten aus jeder Kategorie zu crawlen, um herauszufinden, welche Arten von Problemen für jeden dieser Bereiche spezifisch sind.

Die Dinge, die behoben werden, sind in der Regel standortweite Probleme, die auf der gesamten Website auftreten, wie z. B. ungenutztes CSS, das von jeder Seite geladen wird, oder kumulative Layout-Verschiebung, die durch einen Anzeigenblock im linken Bereich der Webseiten verursacht wird.

Da moderne Websites mit Templates ausgestattet sind, werden die Fehler auf Template-Ebene oder durch benutzerdefinierte Kodierung im Stylesheet usw. behoben.

Crawlen Sie die Website mit Screaming Frog

Sobald die URLs vollständig gecrawlt sind, können Sie auf die Registerkarte PageSpeed klicken und alle Empfehlungen lesen sowie die Pass/Fail-Notierungen für die verschiedenen Metriken einsehen.

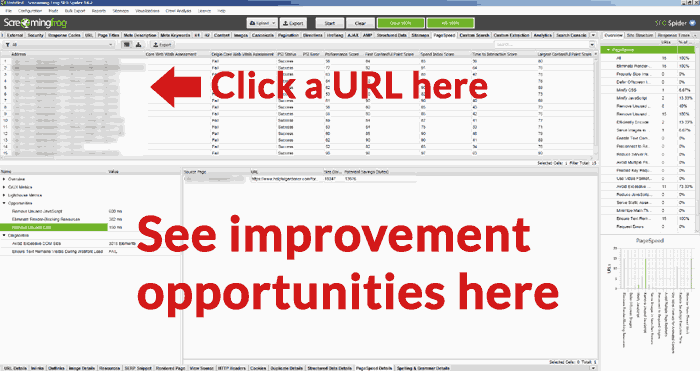

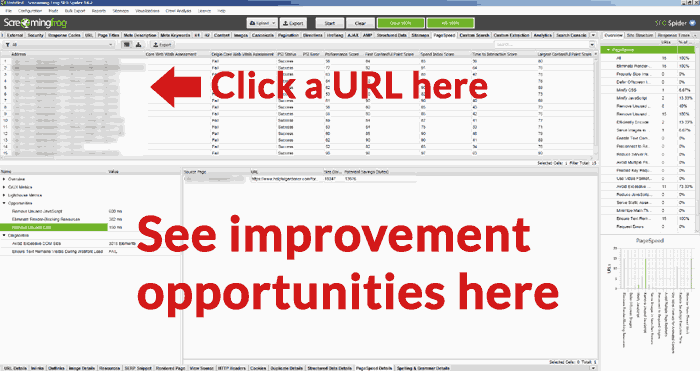

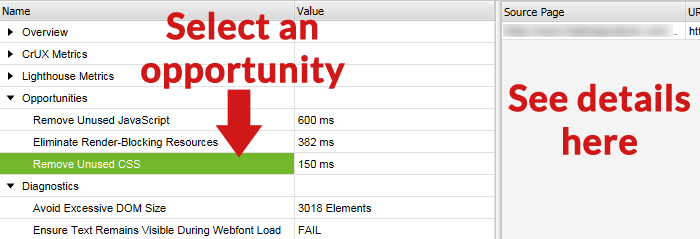

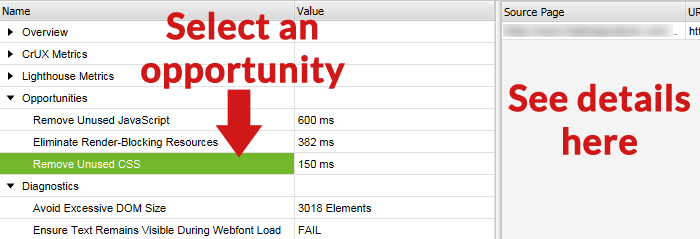

Zoom In on URL Opportunities

Eine nützliche Funktion im Screaming Frog Core Web Vitals Audit ist die Möglichkeit, eine URL aus der Liste der URLs im oberen Bereich auszuwählen und dann die Verbesserungsmöglichkeiten im unteren Bereich des Screaming Frog Bildschirms zu sehen.

Unten ist ein Screenshot des unteren Bildschirms, mit einer ausgewählten Möglichkeit und den Details dieser Verbesserungsmöglichkeit im rechten Fensterbereich.

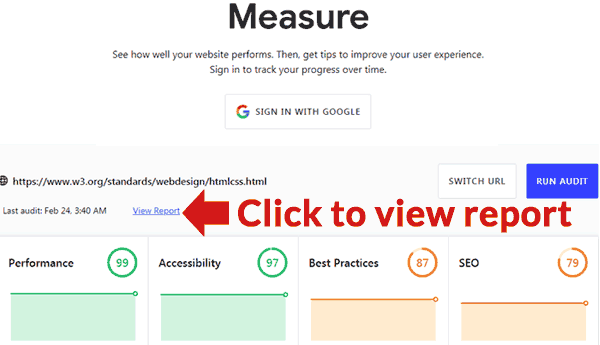

Offizielles Google-Tool

Google hat ein Tool veröffentlicht, das ein Audit durchführen kann. Es befindet sich hier: https://web.dev/measure/

Fügen Sie eine URL ein, um einen Überblick über die Leistung der Seite zu erhalten. Wenn Sie angemeldet sind, wird Google die Seite für Sie im Laufe der Zeit verfolgen. Wenn Sie auf den Link Bericht anzeigen klicken, öffnet sich eine neue Seite mit einem Bericht, in dem detailliert beschrieben wird, was falsch ist, und mit Links zu Anleitungen, die zeigen, wie jedes Problem behoben werden kann.