Je ne vais pas mentir : Réaliser un audit SEO approfondi est une affaire importante.

Et, en tant que consultant SEO, il y a peu de mots plus doux que « Votre audit a l’air génial ! Quand pouvons-nous vous amener à bord ? »

Même si vous n’avez pas été activement à la recherche d’un nouveau concert, sachant que votre audit SEO cloué est un énorme ego boost.

Mais, êtes-vous terrifié de commencer ? Est-ce votre premier audit de référencement ? Ou, peut-être que vous ne savez pas par où commencer ?

Envoyer un audit SEO fantastique à un client potentiel vous met dans la meilleure position possible.

Donc, prenez votre temps. Rappelez-vous : votre objectif principal est d’ajouter de la valeur à votre client avec vos recommandations de site à la fois à court et à long terme.

Dans cette colonne, j’ai rassemblé les étapes nécessaires à savoir pour effectuer un audit de référencement et un petit aperçu de la première phase de mes processus lorsque je reçois un nouveau client. Elle est divisée en sections ci-dessous. Si vous avez l’impression de bien maîtriser une section particulière, n’hésitez pas à passer à la suivante.

Quand dois-je effectuer un audit de référencement ?

Après qu’un client potentiel m’ait envoyé un email exprimant son intérêt à travailler ensemble et qu’il ait répondu à mon enquête, nous mettons en place un appel d’introduction (Skype ou Google Hangouts est préférable).

Avant l’appel, je fais mon propre mini audit SEO rapide (j’investis au moins une heure à la recherche manuelle) basé sur leurs réponses à l’enquête pour se familiariser avec leur paysage de marché. C’est comme sortir avec quelqu’un que vous n’avez jamais rencontré.

Vous allez évidemment les harceler sur Facebook, Twitter, Instagram et tous les autres canaux qui sont publics #soIcreep.

Voici un exemple de ce à quoi ressemble mon enquête:

Voici quelques questions clés que vous voudrez poser au client lors de la première réunion:

- Quels sont vos objectifs commerciaux globaux ? Quels sont vos objectifs en matière de canaux (RP, social, etc.) ?

- Qui est votre public cible ?

- Avez-vous des partenariats commerciaux ?

- À quelle fréquence le site Web est-il mis à jour ? Avez-vous un développeur web ou un service informatique ?

- Avez-vous déjà travaillé avec un consultant en référencement ? Ou, aviez un travail de référencement effectué auparavant?

Sujan Patel a également d’excellentes recommandations sur les questions à poser à un nouveau client SEO.

Après l’appel, si je sens que nous sommes un bon match, je vais envoyer ma proposition formelle et le contrat (merci HelloSign pour rendre ce processus facile pour moi !).

Pour commencer, j’aime toujours offrir à mes clients le premier mois comme période d’essai pour s’assurer que nous vibrons.

Cela donne à la fois au client et à moi une chance de devenir amis d’abord avant de sortir ensemble. Pendant ce mois, je prendrai mon temps pour effectuer un audit SEO approfondi.

Ces audits SEO peuvent me prendre entre 40 heures et 60 heures selon la taille du site web. Ces audits sont bouclés en trois parties distinctes et présentés avec des Google Slides.

- Technique : Erreurs de crawl, indexation, hébergement, etc.

- Contenu : Recherche de mots-clés, analyse de la concurrence, cartes de contenu, méta-données, etc.

- Liens : Analyse du profil des backlinks, tactiques de croissance, etc.

Après ce premier mois, si le client aime mon travail, nous commencerons à mettre en œuvre les recommandations de l’audit SEO. Et à l’avenir, j’effectuerai un mini-audit mensuel et un audit approfondi trimestriel.

Pour récapituler, j’effectue un audit SEO pour mes clients :

- Premier mois.

- Mensuel (mini-audit).

- Trimestriel (audit approfondi).

Ce dont vous avez besoin d’un client avant un audit de référencement

Lorsqu’un client et moi commençons à travailler ensemble, je partagerai avec lui un Google Doc demandant une liste de mots de passe et de fournisseurs.

Cela comprend :

- L’accès à Google Analytics et à tout outil d’analyse tiers.

- Les publicités Google et Bing.

- Outils pour webmaster.

- Accès au backend du site web.

- Comptes de médias sociaux.

- Liste des fournisseurs.

- Liste des membres de l’équipe interne (y compris tout travail qu’ils sous-traitent).

Outils pour l’audit SEO

Avant de commencer votre audit SEO, voici un récapitulatif des outils que j’utilise :

- Screaming Frog.

- Integrity (pour les utilisateurs Mac) et Xenu Sleuth (pour les utilisateurs PC).

- SEO Browser.

- Wayback Machine.

- Moz.

- BuzzSumo.

- DeepCrawl.

- Copyscape.

- Google Tag Manager.

- Extension Chrome de Google Tag Manager.

- Guide de balisage de campagnes d’Annie Cushing.

- Google Analytics (si accès autorisé).

- Google Search Console (si accès autorisé).

- Bing Webmaster Tools (si accès autorisé).

- You Get Signal.

- Pingdom.

- PageSpeed Tool.

- Sublime Text.

Conduire un audit technique de référencement

Outils nécessaires à l’audit technique de référencement :

- Screaming Frog.

- DeepCrawl.

- Copyscape.

- Integrity pour Mac (ou Xenu Sleuth pour les utilisateurs de PC).

- Google Analytics (si accès donné).

- Google Search Console (si accès donné).

- Bing Webmaster Tools (si accès donné).

Étape 1 : ajouter le site à DeepCrawl et Screaming Frog

Outils :

- DeepCrawl.

- Copyscape.

- Screaming Frog.

- Google Analytics.

- Integrity.

- Google Tag Manager.

- Google Analytics code.

Que rechercher en utilisant DeepCrawl

La première chose que je fais est d’ajouter le site de mon client à DeepCrawl. Selon la taille du site de votre client, le crawl peut prendre un jour ou deux pour obtenir les résultats.

Une fois que vous avez récupéré les résultats de DeepCrawl, voici les éléments que je recherche :

Contenu dupliqué

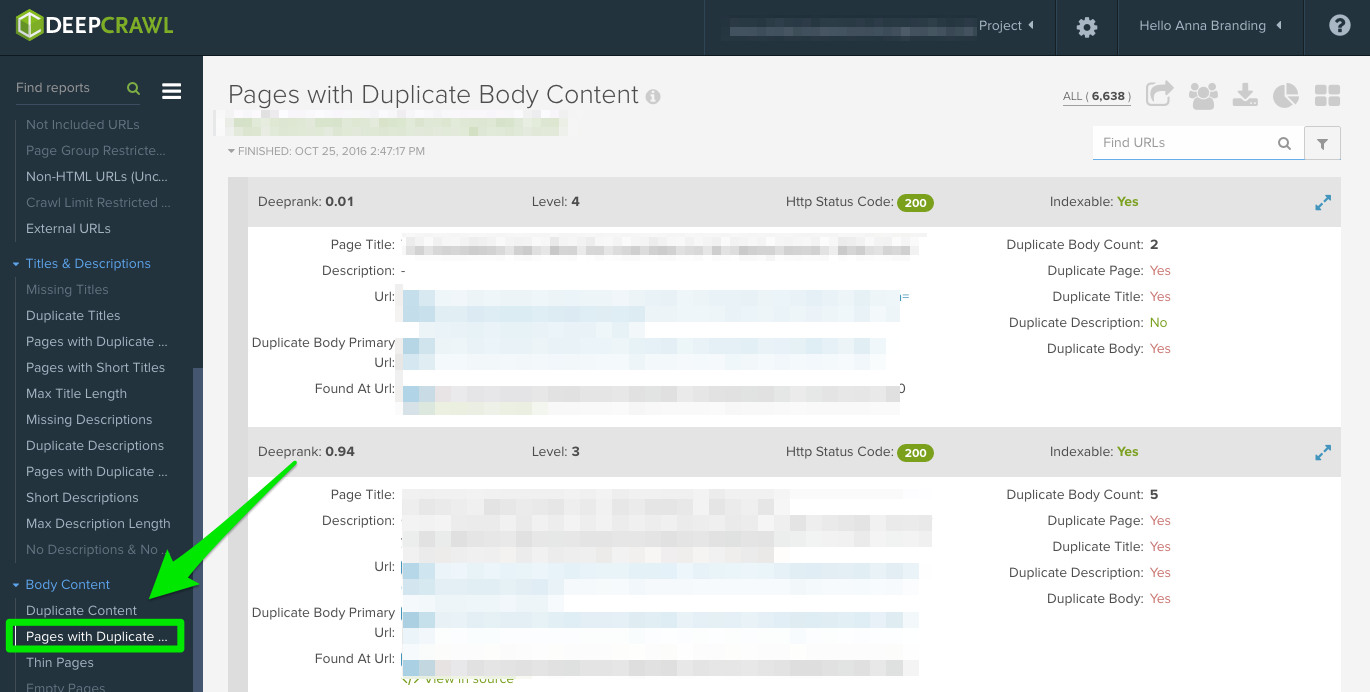

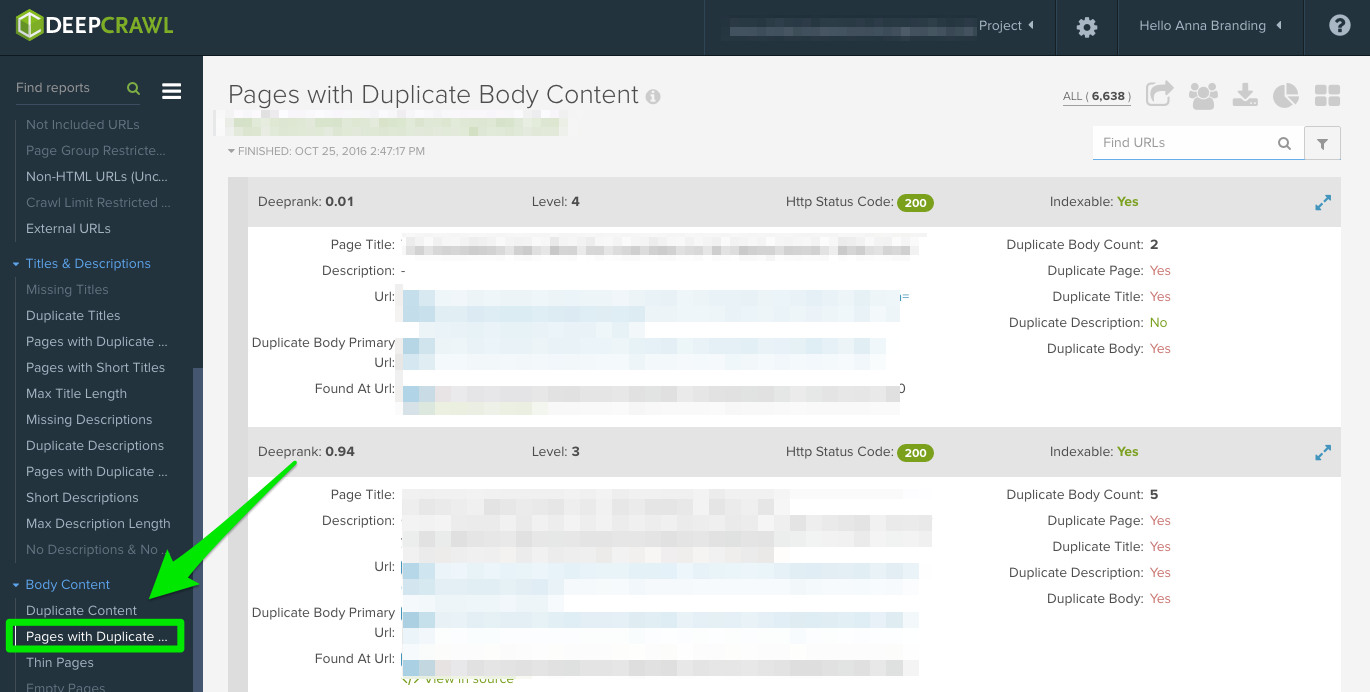

Vérifiez le rapport » Pages dupliquées » pour localiser le contenu dupliqué.

Si le contenu dupliqué est identifié, j’en ferai une priorité absolue dans mes recommandations au client pour réécrire ces pages, et en attendant, j’ajouterai la balise <meta name= »robots » content= »noindex, nofollow »> aux pages dupliquées.

Des erreurs communes de contenu dupliqué que vous découvrirez :

- Des titres et des descriptions méta dupliqués.

- Duplicité du contenu du corps des pages de balises (j’utiliserai Copyscape pour aider à déterminer si quelque chose est plagié).

- Deux domaines (ex : yourwebsite.co, yourwebsite.com).

- Sous-domaines (ex : jobs.yourwebsite.com).

- Contenu similaire sur un domaine différent.

- Pages de pagination mal implémentées (voir ci-dessous.)

Comment y remédier :

- Ajouter la balise canonique sur vos pages pour indiquer à Google ce que vous voulez que votre URL préférée soit.

- Désactiver les URL incorrectes dans les robots.txt.

- Réécrire le contenu (y compris le corps du texte et les métadonnées).

Voici un exemple de problème de contenu dupliqué que j’ai eu avec un de mes clients. Comme vous pouvez le voir ci-dessous, ils avaient des paramètres URL sans la balise canonique.

Voici les étapes que j’ai suivies pour régler le problème :

- J’ai réglé tous les problèmes de redirection 301.

- J’ai ajouté une balise canonique à la page que je veux que Google crawle.

- Mise à jour des paramètres de Google Search Console pour exclure tous les paramètres qui ne génèrent pas de contenu unique.

- Ajouté la fonction disallow aux robots.txt aux URL incorrectes pour améliorer le budget de crawl.

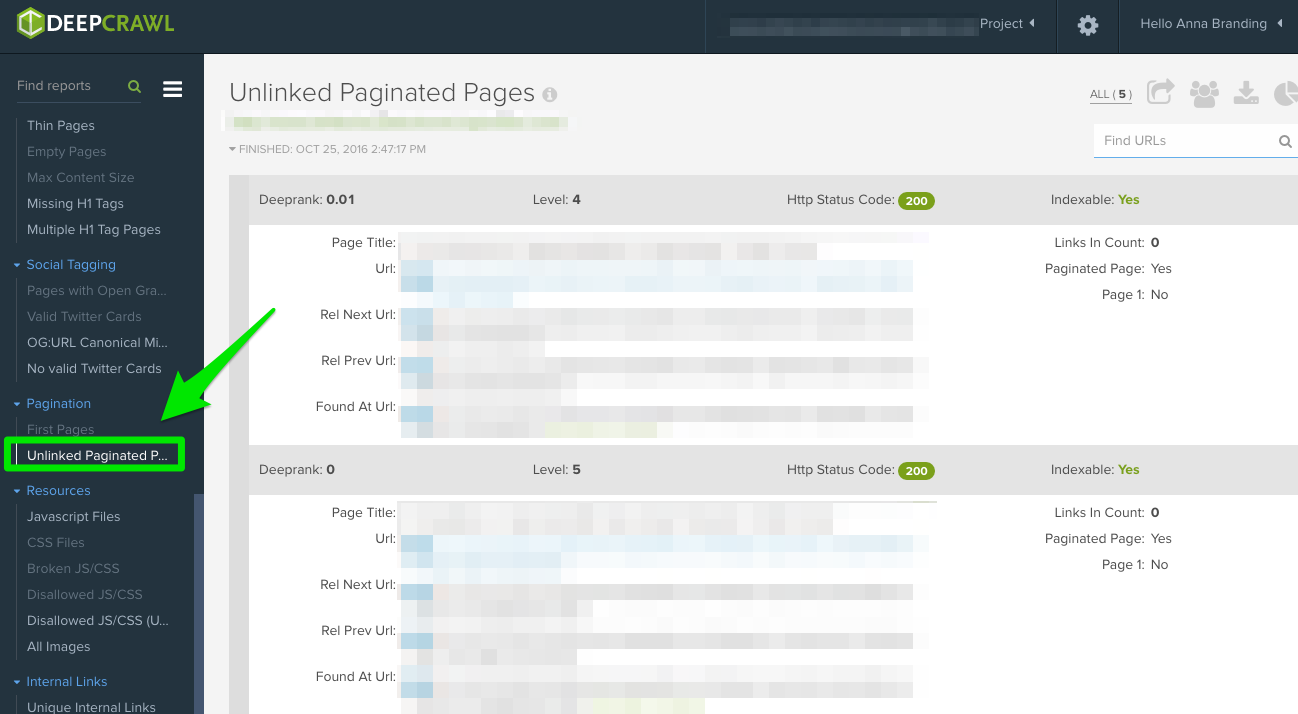

Pagination

Il y a deux rapports à vérifier :

- Premières pages : Pour savoir quelles pages utilisent la pagination, examinez le rapport « First Pages ». Ensuite, vous pouvez examiner manuellement les pages qui l’utilisent sur le site pour découvrir si la pagination est mise en œuvre correctement.

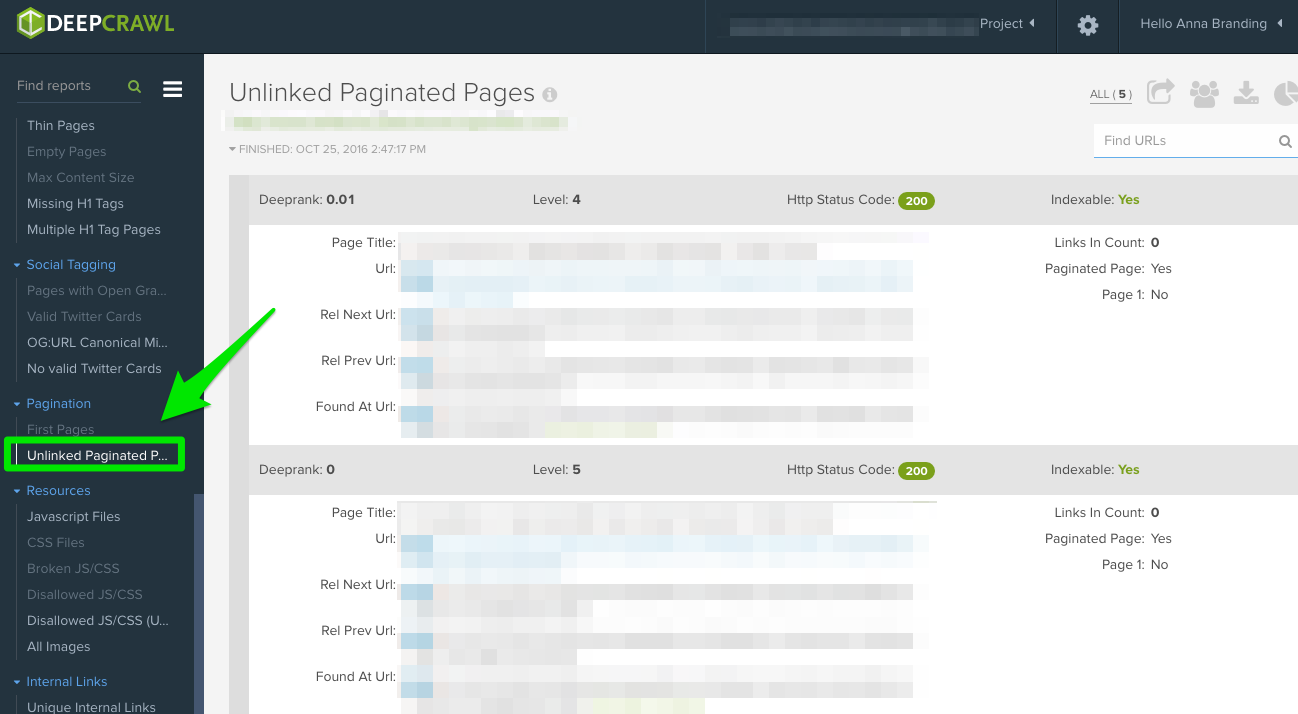

- Pages de pagination non liées : Pour savoir si la pagination fonctionne correctement, le rapport « Unlinked Pagination Pages » vous indiquera si les rel= »next » et rel= »prev » renvoient aux pages précédentes et suivantes.

Dans cet exemple ci-dessous, j’ai pu trouver qu’un client avait des balises de pagination réciproque en utilisant DeepCrawl :

Comment corriger:

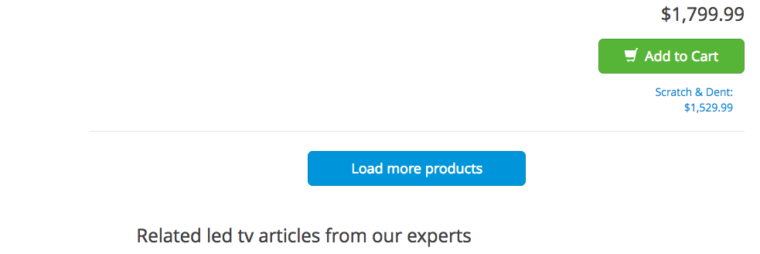

- Si vous avez une page « view all » ou une page « load more », ajoutez la balise rel= »canonical ». Voici un exemple de Crutchfield:

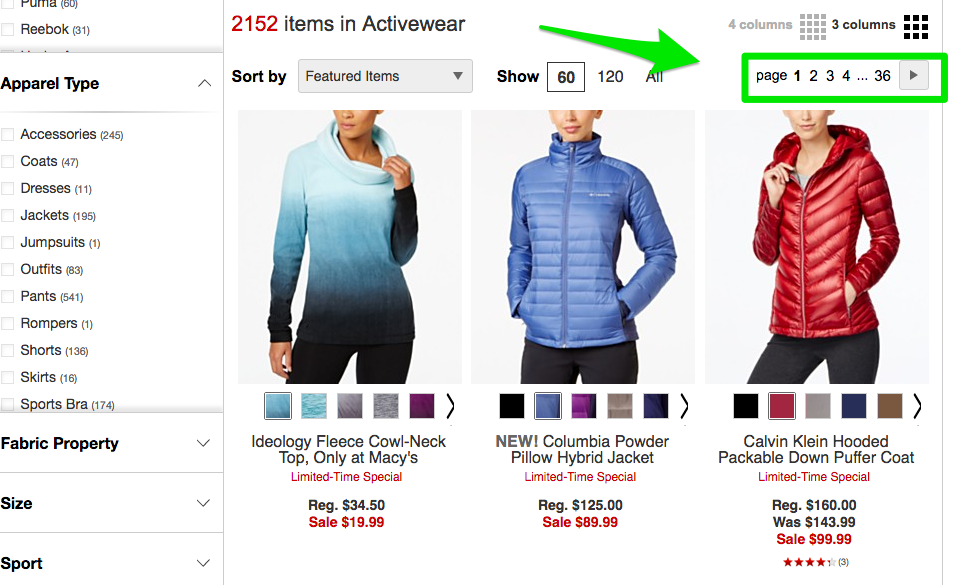

- Si vous avez toutes vos pages sur des pages séparées, alors ajoutez le balisage standard rel= »next » et rel= »prev ». Voici un exemple de Macy’s:

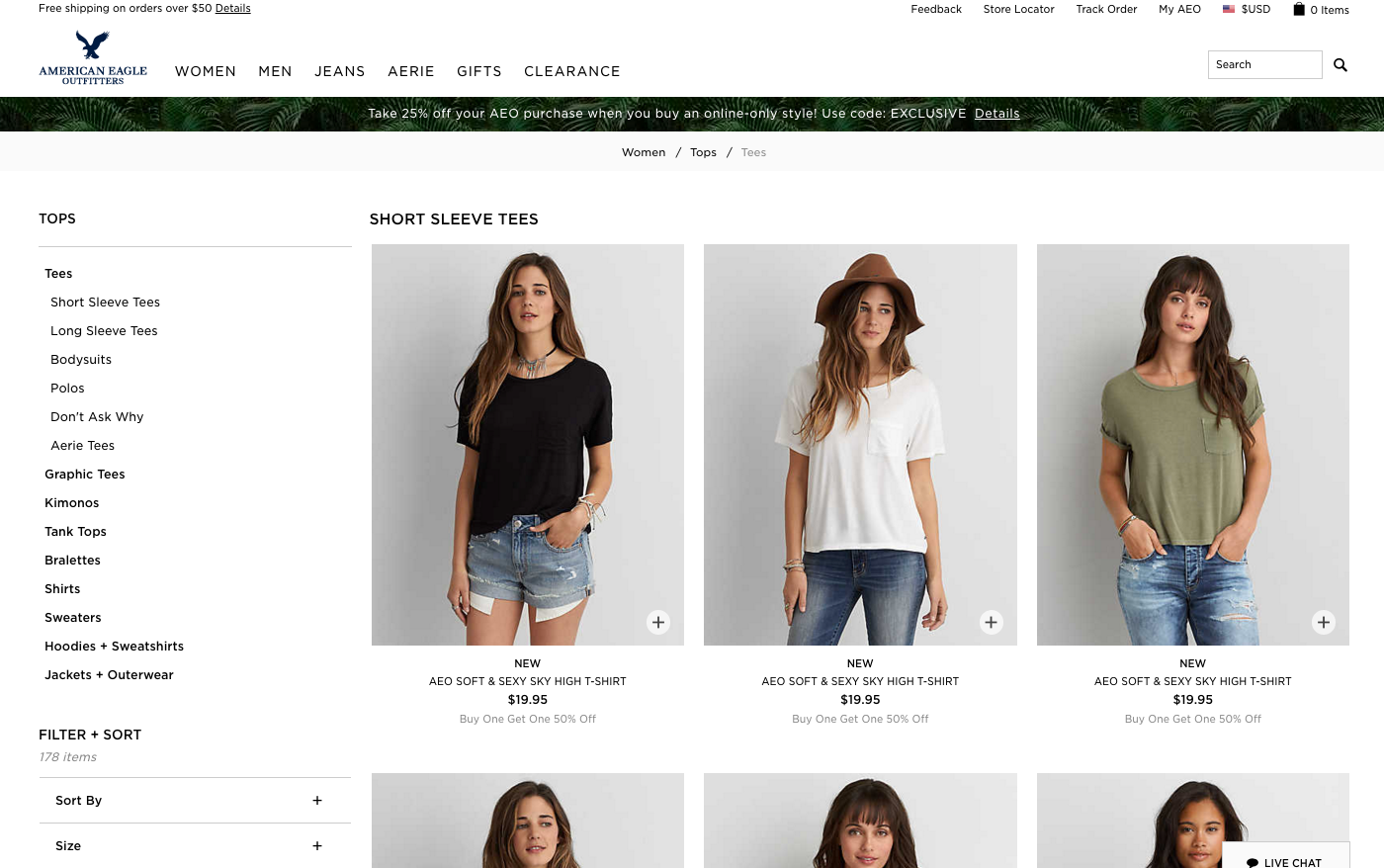

- Si vous utilisez le défilement infini, ajoutez l’URL de la page paginée équivalente dans votre javascript. Voici un exemple d’American Eagle.

Max Redirections

Revoir le rapport « Max Redirections » pour voir toutes les pages qui redirigent plus de 4 fois. John Mueller a mentionné en 2015 que Google peut arrêter de suivre les redirections s’il y en a plus de cinq.

Alors que certaines personnes considèrent que ces erreurs de crawl mangent le « budget de crawl », Gary Illyes parle de « charge de l’hôte ». Il est important de s’assurer que vos pages s’affichent correctement car vous voulez que la charge de votre hôte soit utilisée efficacement.

Voici un bref aperçu des codes de réponse que vous pourriez voir :

- 301 – Ce sont la majorité des codes que vous verrez tout au long de votre recherche. Les redirections 301 sont correctes tant qu’il n’y a qu’une seule redirection et aucune boucle de redirection.

- 302 – Ces codes sont corrects, mais s’ils sont laissés plus de 3 mois environ, je les changerais manuellement en 301 pour qu’ils soient permanents. C’est un code d’erreur que je verrai souvent avec les sites de commerce électronique lorsqu’un produit est en rupture de stock.

- 400 – Les utilisateurs ne peuvent pas accéder à la page.

- 403 – Les utilisateurs ne sont pas autorisés à accéder à la page.

- 404 – La page est introuvable (ce qui signifie généralement que le client a supprimé une page sans redirection 301).

- 500 – Erreur interne du serveur que vous devrez connecter avec l’équipe de développement web pour déterminer la cause.

Comment réparer :

- Supprimez tous les liens internes pointant vers les anciennes pages 404 et mettez-les à jour avec le lien interne de la page redirigée.

- Défaire les chaînes de redirection en supprimant les redirections intermédiaires. Par exemple, si la redirection A va vers la redirection B, C et D, alors vous voudrez défaire les redirections B et C. Le résultat final sera une redirection A vers D.

- Il y a aussi un moyen de faire cela dans Screaming Frog et Google Search Console ci-dessous si vous utilisez cette version.

Ce que vous devez rechercher lorsque vous utilisez Screaming Frog

La deuxième chose que je fais lorsque j’obtiens le site d’un nouveau client est d’ajouter son URL à Screaming Frog.

Selon la taille du site de votre client, je peux configurer les paramètres pour crawler des zones spécifiques du site à la fois.

Voici à quoi ressemblent les configurations de mon araignée Screaming Frog :

Vous pouvez le faire dans les paramètres de votre spider ou en excluant des zones du site.

Une fois que vous avez récupéré vos résultats Screaming Frog, voici les éléments que je recherche :

Code Google Analytics

Screaming Frog peut vous aider à identifier les pages auxquelles il manque le code Google Analytics (UA-1234568-9). Pour trouver le code Google Analytics manquant, suivez ces étapes :

- Allez dans Configuration dans la barre de navigation, puis Personnalisé.

- Ajouter analytics\.js au Filtre 1, puis changer la liste déroulante pour Ne contient pas.

Comment réparer:

- Contactez les développeurs de votre client et demandez-leur d’ajouter le code aux pages spécifiques qui en sont dépourvues.

- Pour plus d’informations sur Google Analytics, passez directement à cette section Google Analytics ci-dessous.

Google Tag Manager

Screaming Frog peut également vous aider à trouver quelles pages sont dépourvues de l’extrait de Google Tag Manager avec des étapes similaires :

- Aller à l’onglet Configuration dans la barre de navigation, puis Personnaliser.

- Ajouter <iframe src-« //www.googletagmanager.com/ avec Does not contain sélectionné dans le Filtre.

Comment corriger:

- Allez sur Google Tag Manager pour voir s’il y a des erreurs et mettez à jour si nécessaire.

- Partagez le code avec les développeurs de votre client pour voir s’ils peuvent le rajouter au site.

Schema

Vous voudrez également vérifier si le site de votre client utilise le balisage schema sur son site. Le schéma ou les données structurées aident les moteurs de recherche à comprendre ce qu’est une page sur le site.

Pour vérifier le balisage du schéma dans Screaming Frog, suivez ces étapes :

- Allez dans l’onglet Configuration de la barre de navigation, puis Personnaliser.

- Ajouter itemtype= »http://schema.\.org/ avec ‘Contenir’ sélectionné dans le Filtre.

Indexation

Indexation

Vous voulez déterminer combien de pages sont indexées pour votre client, suivez ceci dans Screaming Frog :

- Après le chargement de votre site dans Screaming Frog, allez dans Directives > Filtre > Index pour examiner s’il y a des morceaux de code manquants.

Comment corriger:

- Si le site est nouveau, il se peut que Google ne l’ait pas encore indexé.

- Vérifiez le fichier robots.txt pour vous assurer que vous ne désactivez rien de ce que vous voulez que Google explore.

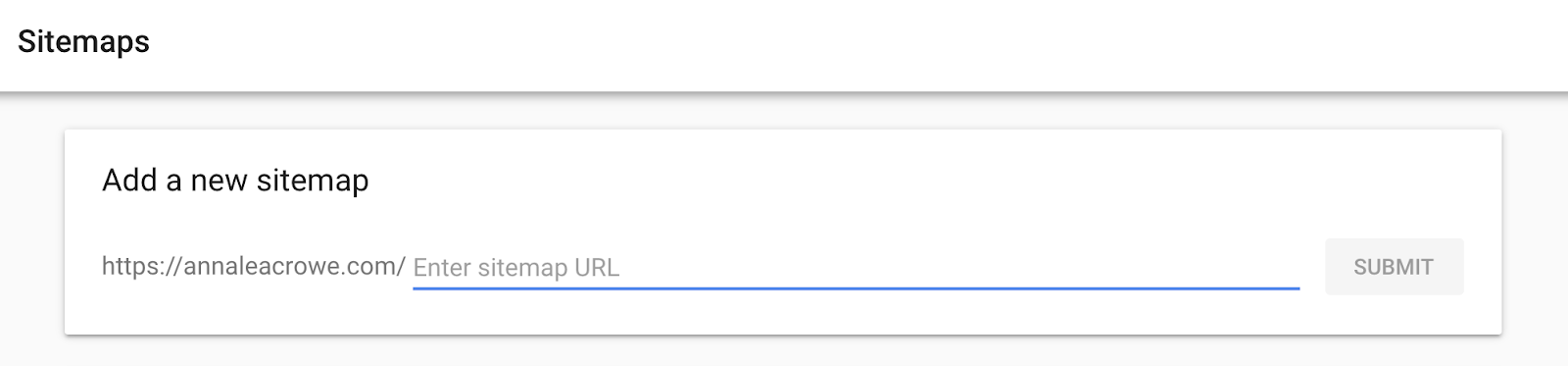

- Vérifiez que vous avez soumis le sitemap de votre client à Google Search Console et aux Bing Webmaster Tools.

- Faites une recherche manuelle (vue ci-dessous).

Flash

Google a annoncé en 2016 que Chrome va commencer à bloquer Flash en raison de la lenteur du chargement des pages. Donc, si vous faites un audit, vous voulez identifier si votre nouveau client utilise Flash ou non.

Pour faire cela dans Screaming Frog, essayez ceci :

- Allez à la configuration du Spider dans la navigation.

- Cliquez sur Vérifier le SWF.

- Filtrez l’onglet Interne par Flash après que le crawl soit fait.

Comment réparer:

- Imbriquer des vidéos de YouTube. Google a acheté YouTube en 2006, pas de problème ici.

- Ou, optez pour les normes HTML5 lors de l’ajout d’une vidéo.

Voici un exemple de code HTML5 pour l’ajout d’une vidéo :

<video controls="controls" width="320" height="240">> <source class="hiddenSpellError" data-mce-bogus="1" />src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.mp4" type="video/mp4"> <source src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.ogg" type="video/ogg" />Your browser does not support the video tag.</video>

JavaScript

Selon l’annonce de Google en 2015, JavaScript peut être utilisé pour votre site Web tant que vous ne bloquez rien dans votre robots.txt (nous creuserons cela plus en profondeur dans un peu !). Mais, vous voulez toujours jeter un coup d’œil à la façon dont le Javascript est livré à votre site.

Comment réparer:

- Revoir le Javascript pour s’assurer qu’il n’est pas bloqué par les robots.txt

- Vérifiez que Javascript est exécuté sur le serveur (cela aide à produire des données en texte brut par rapport à des données dynamiques).

- Si vous exécutez Angular JavaScript, consultez cet article de Ben Oren sur la raison pour laquelle il pourrait tuer vos efforts de référencement.

- Dans Screaming Frog, allez à la Configuration du Spider dans la barre de navigation et cliquez sur Vérifier JavaScript. Une fois le crawl effectué, filtrez vos résultats dans l’onglet Interne par JavaScript.

Robots.txt

Robots.txt

Lorsque vous examinez un robots.txt pour la première fois, vous voulez voir si quelque chose d’important est bloqué ou interdit.

Par exemple, si vous voyez ce code:

User-agent : *Disallow : /

Le site web de votre client est bloqué pour tous les crawlers web.

Mais, si vous avez quelque chose comme le fichier robots.txt de Zappos, vous devriez être bon pour aller.

# Global robots.txt as of 2012-06-19User-agent : *Disallow : /bin/Disallow : /multiview/Disallow : /produit/revue/add/Disallow : /cartDisallow : /loginDisallow : /loginDisallow : /logoutDisallow : /registerDisallow : /account

Ils ne bloquent que ce qu’ils ne veulent pas que les robots d’exploration du web localisent. Ce contenu qui est bloqué n’est pas pertinent ou utile pour le crawler web.

Comment corriger:

- Votre robots.txt est sensible à la casse, mettez-le à jour pour qu’il soit tout en minuscules.

- Supprimez toutes les pages listées comme Disallow que vous voulez que les moteurs de recherche explorent.

- Screaming Frog par défaut ne sera pas en mesure de charger toutes les URLs interdites par robots.txt. Si vous choisissez de modifier les paramètres par défaut dans Screaming Frog, il ignorera tous les robots.txt.

- Vous pouvez également afficher les pages bloquées dans Screaming Frog sous l’onglet Response Codes, puis filtrées par le filtre Blocked by Robots.txt après avoir terminé votre crawl.

- Si vous avez un site avec plusieurs sous-domaines, vous devriez avoir un robots.txt distinct pour chacun.

- Veuillez vous assurer que le sitemap est répertorié dans le robots.txt.

Erreurs de crawl

J’utilise DeepCrawl, Screaming Frog et les outils pour webmasters de Google et Bing pour trouver et recouper les erreurs de crawl de mon client.

Pour trouver vos erreurs de crawl dans Screaming Frog, suivez ces étapes :

- Une fois le crawl terminé, allez dans Rapports en vrac.

- Défilez jusqu’à Codes de réponse, puis exportez le rapport d’erreurs côté serveur et le rapport d’erreurs côté client.

Comment réparer :

- Les rapports d’erreurs client, vous devriez être en mesure de rediriger 301 la majorité des erreurs 404 dans le backend du site vous-même.

- Les rapports d’erreurs serveur, collaborez avec l’équipe de développement pour déterminer la cause. Avant de réparer ces erreurs sur le répertoire racine, assurez-vous de sauvegarder le site. Vous pouvez simplement avoir besoin de créer un nouveau fichier d’accès .html ou d’augmenter la limite de mémoire PHP.

- Vous voudrez également supprimer toutes ces redirections permanentes du sitemap et de tous les liens internes ou externes.

- Vous pouvez également utiliser 404 dans votre URL pour aider au suivi dans Google Analytics.

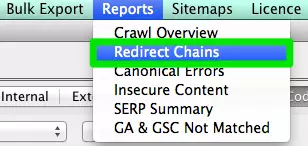

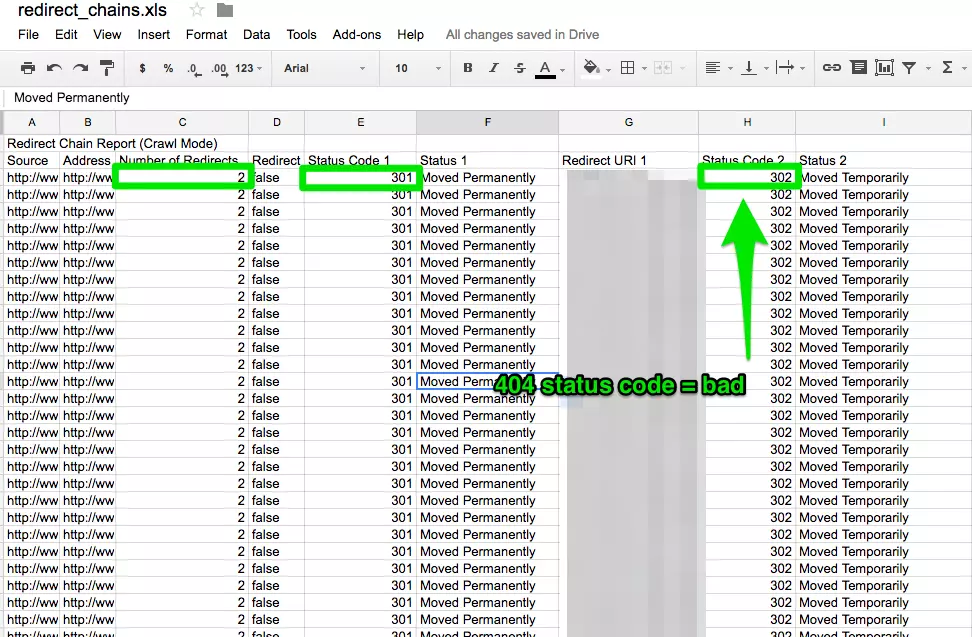

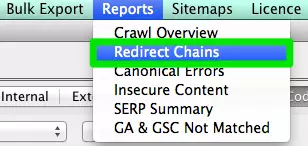

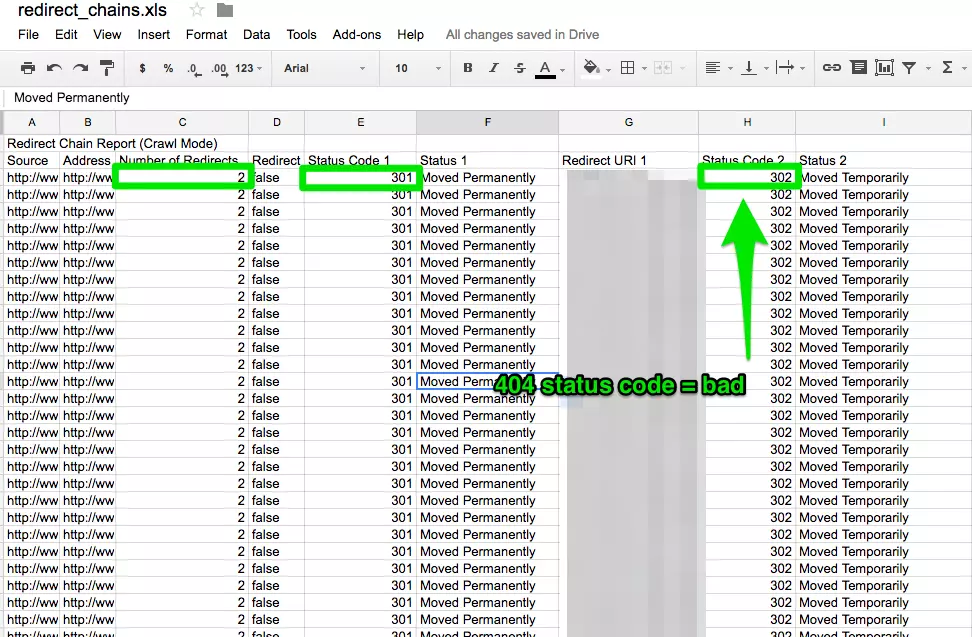

Chaînes de redirection

Les chaînes de redirection ne causent pas seulement une mauvaise expérience utilisateur, mais elles ralentissent la vitesse des pages, les taux de conversion chutent et tout amour de lien que vous avez pu recevoir auparavant est perdu.

Réparer les chaînes de redirection est un gain rapide pour toute entreprise.

Comment réparer:

- Dans Screaming Frog après avoir terminé votre crawl, allez dans Rapports > Chaînes de redirection pour voir le chemin de crawl de vos redirections. Dans une feuille de calcul excel, vous pouvez suivre pour vous assurer que vos redirections 301 restent des redirections 301. Si vous voyez une erreur 404, vous voudrez nettoyer cela.

.

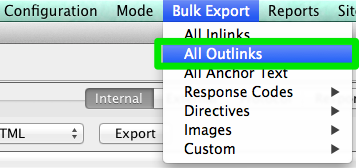

Internal & External Links

Lorsqu’un utilisateur clique sur un lien vers votre site et obtient une erreur 404, ce n’est pas une bonne expérience utilisateur.

Et, cela n’aide pas non plus les moteurs de recherche à mieux vous aimer.

Pour trouver mes liens internes et externes brisés, j’utilise Integrity pour Mac. Vous pouvez également utiliser Xenu Sleuth si vous êtes un utilisateur de PC.

Je vous montrerai également comment trouver ces liens internes et externes dans Screaming Frog et DeepCrawl si vous utilisez ces logiciels.

Comment réparer :

- Si vous utilisez Integrity ou Xenu Sleuth, exécutez l’URL du site de votre client et vous obtiendrez une liste complète des URL cassées. Vous pouvez les mettre à jour manuellement vous-même ou, si vous travaillez avec une équipe de développement, leur demander de l’aide.

- Si vous utilisez Screaming Frog, une fois le crawl terminé, allez dans Bulk Export dans la barre de navigation, puis All Outlinks. Vous pouvez trier par URL et voir quelles sont les pages qui envoient un signal 404. Répétez la même étape avec All Inlinks.

- Si vous utilisez DeepCrawl, allez dans l’onglet Unique Broken Links sous la section Internal Links.

URLs

Chaque fois que vous prenez un nouveau client, vous voulez examiner son format d’URL. Que dois-je rechercher dans les URL ?

- Paramètres – Si l’URL a des caractères bizarres comme ?, = ou +, c’est une URL dynamique qui peut causer du contenu dupliqué si elle n’est pas optimisée.

- Facile à utiliser – J’aime garder les URL courtes et simples tout en supprimant les barres obliques supplémentaires.

Comment corriger:

- Vous pouvez rechercher les URL de paramètres dans Google en faisant site:www.buyaunicorn.com/ inurl : » ? » ou tout ce que vous pensez que le paramètre pourrait inclure.

- Après avoir exécuté le crawl sur Screaming Frog, jetez un œil aux URL. Si vous voyez des paramètres listés qui créent des doublons de votre contenu, vous devez suggérer ce qui suit :

- Ajouter une balise canonique à la page URL principale. Par exemple, www.buyaunicorn.com/magical-headbands est la page principale et je vois www.buyaunicorn.com/magical-headbands/?dir=mode123$, alors la balise canonique devrait être ajoutée à www.buyaunicorn.com/magical-headbands.

- Mettez à jour vos paramètres dans Google Search Console sous Crawl > Paramètres URL.

- Disqualifier les URLs dupliquées dans les robots.txt.

Étape 2 : Examiner la Google Search Console et les Bing Webmaster Tools.

Outils :

- Google Search Console.

- Bing Webmaster Tools.

- Sublime Text (ou tout outil d’édition de texte).

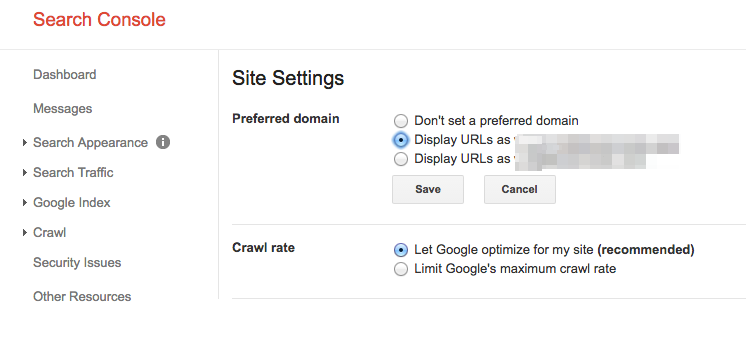

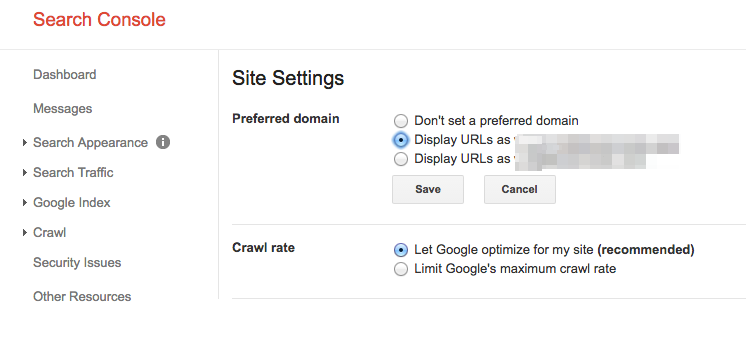

Définir un domaine préféré

Depuis la mise à jour Panda, il est bénéfique de clarifier aux moteurs de recherche le domaine préféré. Cela permet également de s’assurer que tous vos liens donnent à un seul site l’amour supplémentaire au lieu d’être répartis sur deux sites.

Comment corriger:

- Dans Google Search Console, cliquez sur l’icône d’engrenage dans le coin supérieur droit.

- Choisissez laquelle des URL est le domaine préféré.

- Vous n’avez pas besoin de définir le domaine préféré dans les Bing Webmaster Tools, il suffit de soumettre votre sitemap pour aider Bing à déterminer votre domaine préféré.

Liens retour

Avec l’annonce que Pingouin est en temps réel, il est vital que les liens retour de votre client répondent aux normes de Google.

Si vous remarquez qu’un grand nombre de liens retour arrivent sur le site de votre client à partir d’une page d’un site Web, vous voudrez prendre les mesures nécessaires pour le nettoyer, et VITE !

Comment réparer :

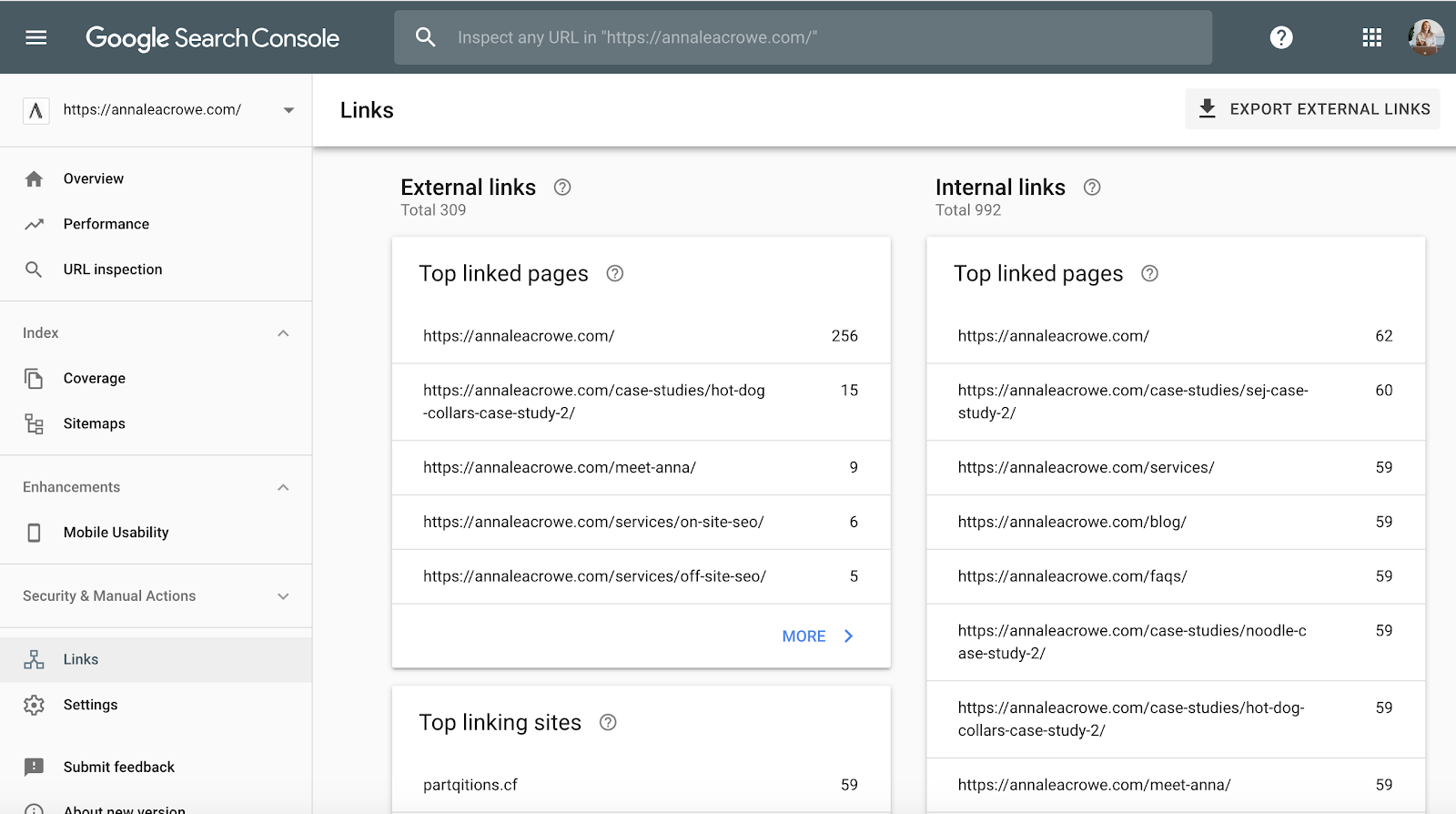

- Dans la Google Search Console, allez dans Liens > puis triez vos sites de liens supérieurs.

- Contactez les entreprises qui ont des liens vers vous à partir d’une page pour qu’elles suppriment les liens.

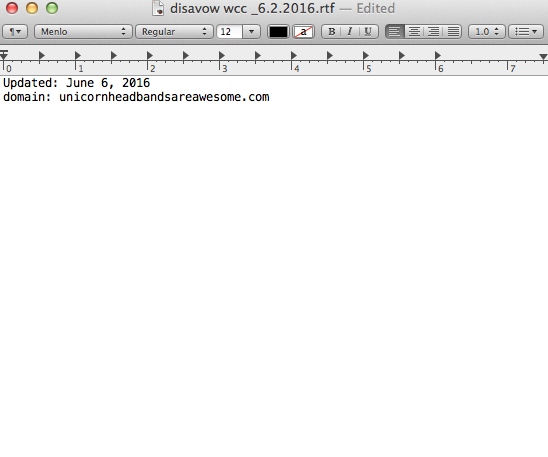

- Ou, ajoutez-les à votre liste de désaveu. Lorsque vous ajoutez des entreprises à votre liste de désaveu, faites très attention à comment et pourquoi vous le faites. Vous ne voulez pas supprimer des liens précieux.

Voici un exemple de ce à quoi ressemble mon fichier de désaveu :

Mots-clés

Mots-clés

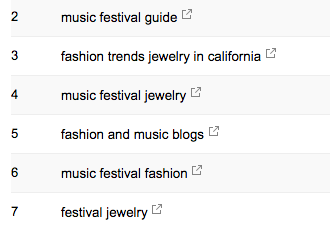

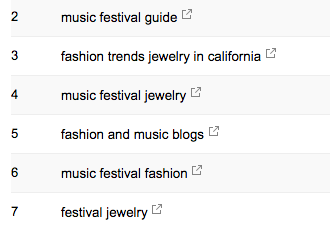

En tant que consultant SEO, c’est mon travail de commencer à apprendre le paysage du marché de mon client. Je dois savoir qui est leur public cible, ce qu’ils recherchent et comment ils le font. Pour commencer, je jette un coup d’œil aux termes de recherche de mots clés à partir desquels ils obtiennent déjà du trafic.

- Dans Google Search Console, sous Trafic de recherche > Search Analytics vous montrera quels mots clés envoient déjà des clics à votre client.

Sitemap

Sitemap

Les sitemaps sont essentiels pour que les moteurs de recherche explorent le site web de votre client. Ils parlent leur langage. Lors de la création de sitemaps, il y a quelques choses à savoir :

- Ne pas inclure d’URL de paramètres dans votre sitemap.

- Ne pas inclure de pages non indexables.

- Si le site a différents sous-domaines pour le mobile et le bureau, ajoutez la balise rel= »alternate » au sitemap.

Comment corriger:

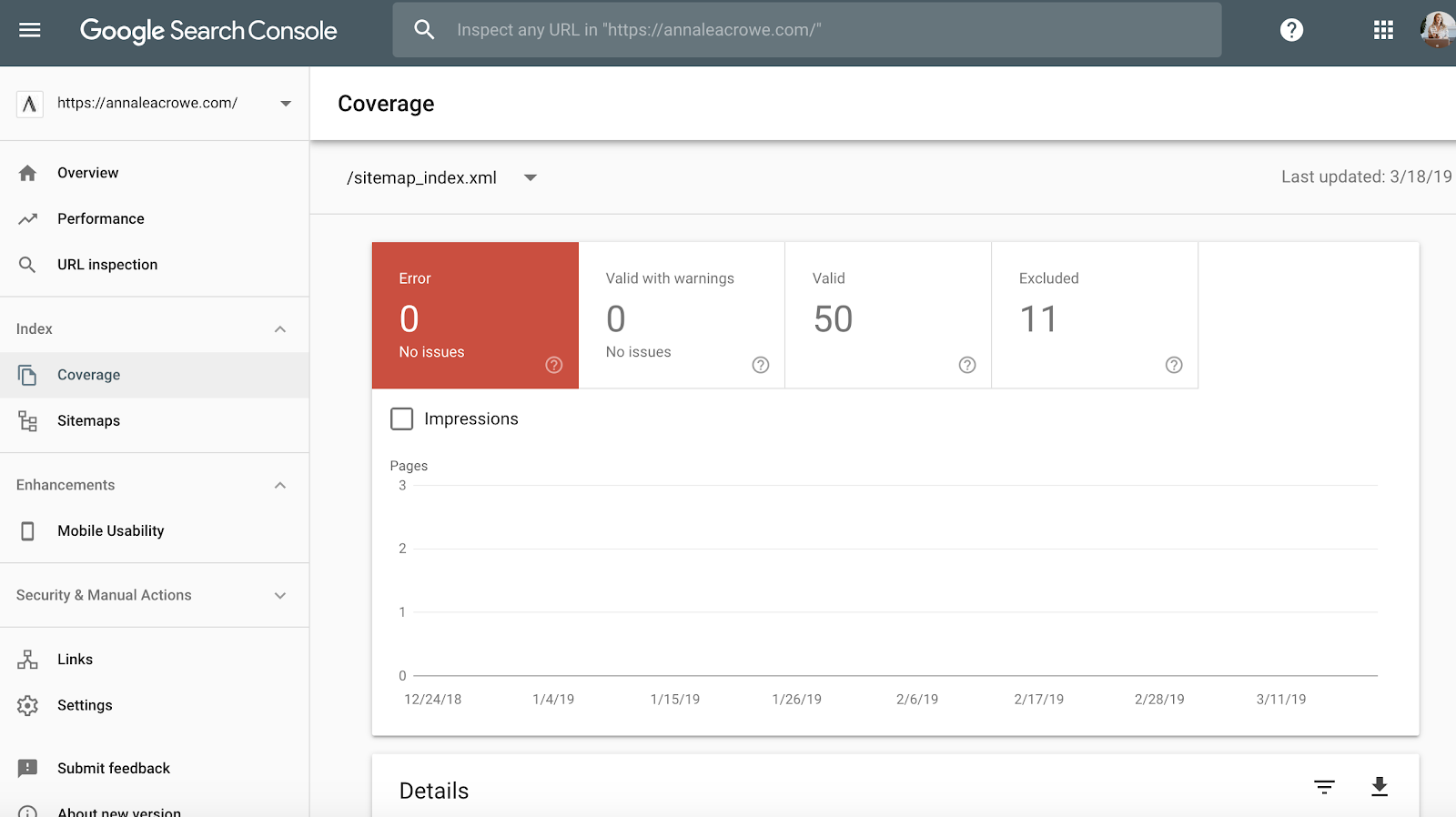

- Voir Google Search Console > Index > Sitemaps pour comparer les URLs indexées dans le sitemap aux URLs dans l’index web.

- Puis, faites une recherche manuelle pour déterminer les pages qui ne sont pas indexées et pourquoi.

- Si vous trouvez d’anciennes URL redirigées dans le sitemap de votre client, supprimez-les. Ces anciennes redirections auront un impact négatif sur votre référencement si vous ne les supprimez pas.

- Si le client est nouveau, soumettez un nouveau sitemap pour lui à la fois dans Bing Webmaster Tools et Google Search Console.

Crawl

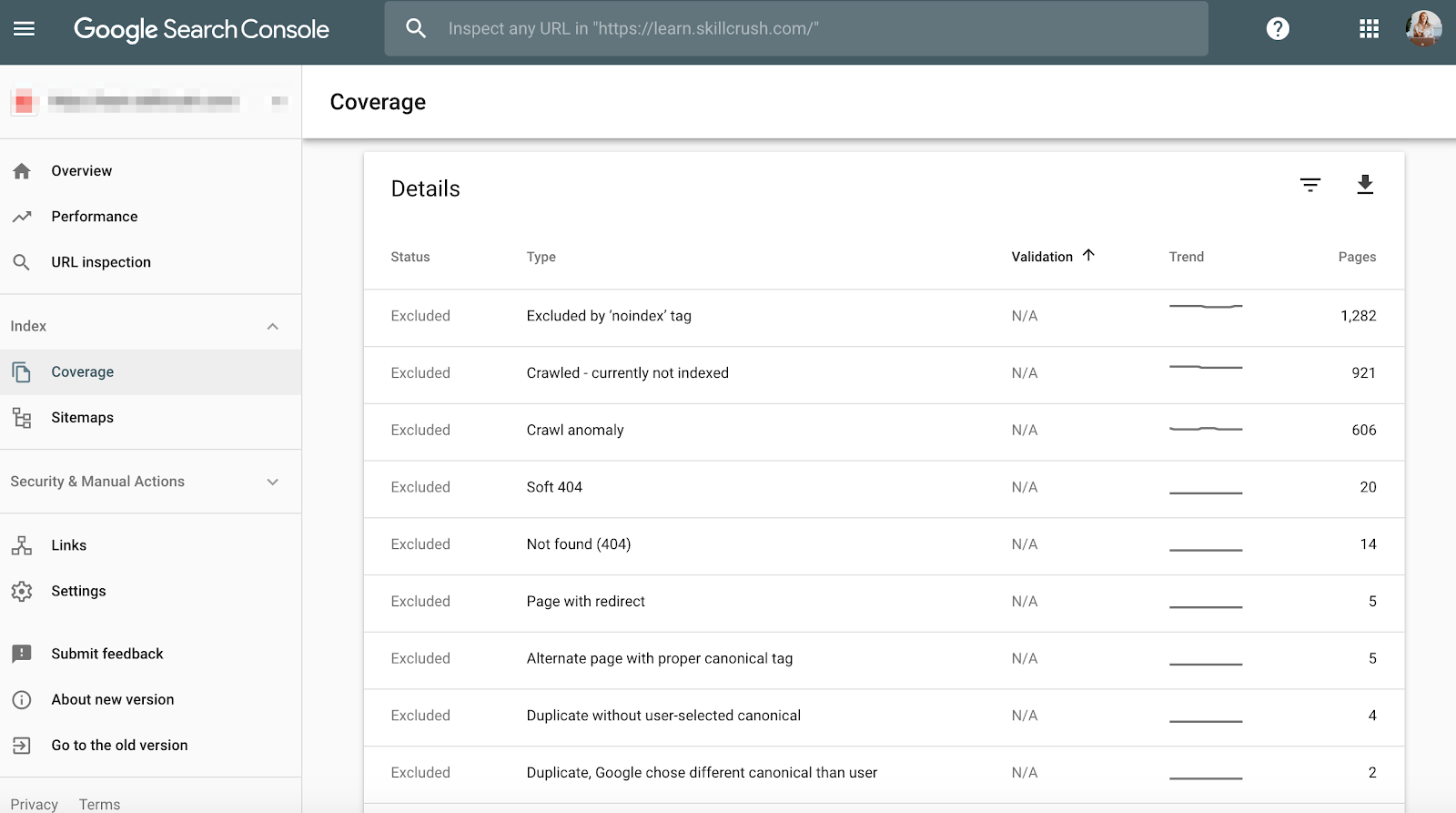

Les erreurs de crawl sont importantes à vérifier car ce n’est pas seulement mauvais pour l’utilisateur, mais c’est mauvais pour le classement de votre site Web. Et, John Mueller a déclaré qu’un faible taux de crawl peut être le signe d’un site de faible qualité.

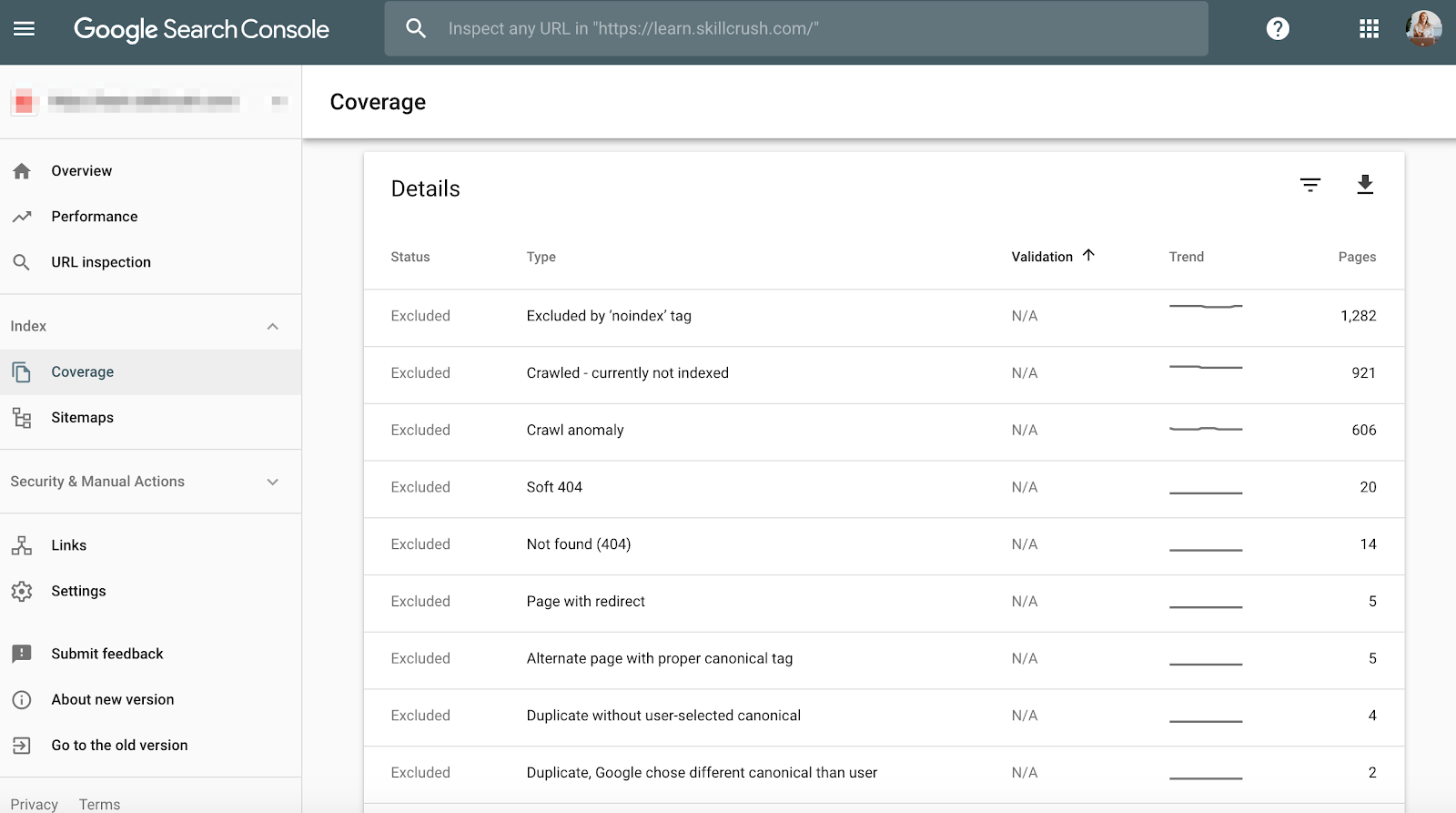

Pour vérifier cela dans Google Search Console, allez à Couverture >Détails.

Pour vérifier cela dans Bing Webmaster Tools, allez dans Rapports & Données > Informations sur le crawl.

Comment corriger:

- Vérifiez manuellement vos erreurs de crawl pour déterminer si des erreurs de crawl proviennent d’anciens produits qui n’existent plus ou si vous voyez des erreurs de crawl qui devraient être interdites dans le fichier robots.txt.

- Une fois que vous avez déterminé d’où elles viennent, vous pouvez mettre en œuvre des redirections 301 vers des pages similaires qui renvoient aux pages mortes.

- Vous voudrez également croiser les statistiques d’exploration dans Google Search Console avec le temps de chargement moyen dans Google Analytics pour voir s’il y a une corrélation entre le temps passé à télécharger et les pages explorées par jour.

Données structurées

Comme mentionné ci-dessus dans la section sur le schéma de Screaming Frog, vous pouvez examiner le balisage du schéma de votre client dans Google Search Console.

Utilisez le rapport d’état des résultats riches individuels dans Google Search Console. (Remarque : le rapport sur les données structurées n’est plus disponible).

Cela vous aidera à déterminer quelles pages présentent des erreurs de données structurées que vous devrez corriger en cours de route.

Comment corriger:

- Google Search Console vous dira ce qui manque dans le schéma lorsque vous testez la version live.

- Selon vos codes d’erreur, réécrivez le schéma dans un éditeur de texte et envoyez-le à l’équipe de développement web pour qu’elle le mette à jour. J’utilise Sublime Text pour mon édition de texte. Les utilisateurs de Mac en ont un intégré et les utilisateurs de PC peuvent utiliser Google acheté YouTube.

Étape 3 : Examiner Google Analytics

Outils:

- Google Analytics.

- Google Tag Manager Assistant Chrome Extension.

- Guide de balisage des campagnes d’Annie Cushing.

Vues

Lorsque je reçois un nouveau client pour la première fois, je configure 3 vues différentes dans Google Analytics.

- Vue de rapport.

- Vue maître.

- Vue de test.

Ces différentes vues me donnent la flexibilité de faire des changements sans affecter les données.

Comment corriger:

- Dans Google Analytics, allez à Admin > View > View Settings pour créer les trois différentes vues ci-dessus.

- Assurez-vous de vérifier la section Bot Filtering pour exclure tous les hits provenant de robots et d’araignées.

- Liez Google Ads et Google Search Console.

- Enfin, assurez-vous que le suivi de la recherche sur le site est activé.

Filtre

Vous voulez vous assurer que vous ajoutez votre adresse IP et celle de votre client aux filtres de Google Analytics afin de ne pas recevoir de faux trafic.

Comment corriger:

- Allez dans Admin> Afficher >Filtres

- Puis, les paramètres devraient être définis pour Exclure >le trafic des adresses IP > qui sont égales à.

Code de suivi

Code de suivi

Vous pouvez vérifier manuellement le code source, ou vous pouvez utiliser ma technique de la grenouille hurlante du dessus.

Si le code est là, vous voudrez suivre qu’il tire en temps réel.

- Pour vérifier cela, allez sur le site web de votre client et cliquez un peu sur le site.

- Puis allez dans Google Analytics > Temps réel >Lieux, votre emplacement devrait se remplir.

- Si vous utilisez Google Tag Manager, vous pouvez également vérifier cela avec l’extension Chrome Google Tag Assistant.

Comment corriger:

- Si le code ne se déclenche pas, vous voudrez vérifier l’extrait de code pour vous assurer que c’est le bon. Si vous gérez plusieurs sites, vous avez peut-être ajouté le code d’un autre site.

- Avant de copier le code, utilisez un éditeur de texte, et non un traitement de texte pour copier le snippet sur le site Web. Cela peut provoquer des caractères supplémentaires ou des espaces blancs.

- Les fonctions sont sensibles à la casse, donc vérifiez que tout est en minuscules dans le code.

Indexation

Si vous avez eu l’occasion de jouer dans Google Search Console, vous avez probablement remarqué la section Couverture.

Lorsque j’audite un client, je vais examiner son indexation dans Google Search Console par rapport à Google Analytics. Voici comment :

- Dans Google Search Console, allez à Couverture

- Dans Google Analytics, allez à Acquisition > Canaux > Recherche organique > Page d’atterrissage.

- Une fois que vous êtes ici, allez dans Advanced > Site Usage > Sessions > 9.

Comment réparer:

- Comparer les chiffres de Google Search Console avec ceux de Google Analytics, si les chiffres sont largement différents, alors vous savez que même si les pages sont indexées, seule une fraction reçoit du trafic organique.

Balisage de campagne

La dernière chose que vous voudrez vérifier dans Google Analytics est si votre client utilise correctement le balisage de campagne. Vous ne voulez pas ne pas être crédité pour le travail que vous faites parce que vous avez oublié le balisage de campagne.

Comment réparer :

- Mettez en place une stratégie de balisage de campagne pour Google Analytics et partagez-la avec votre client. Annie Cushing a mis en place un guide de balisage de campagne génial.

- Mettez en place le suivi des événements si votre client utilise des annonces mobiles ou des vidéos.

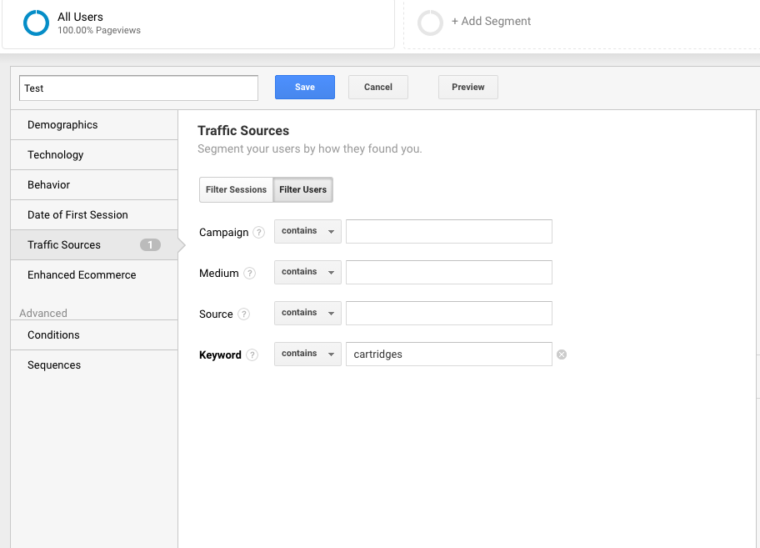

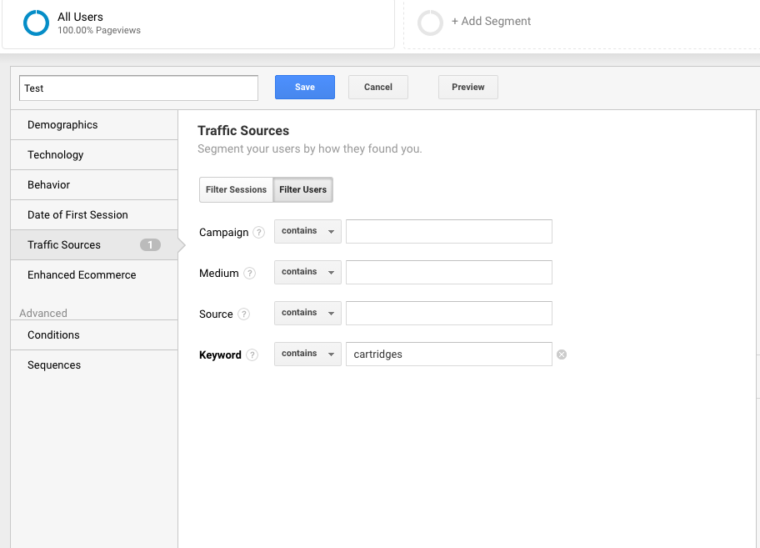

Keywords

Vous pouvez utiliser Google Analytics pour avoir un aperçu des gemmes de mots-clés potentiels pour votre client. Pour trouver des mots-clés dans Google Analytics, suivez les étapes suivantes :

Allez dans Google Analytics > Comportement > Recherche sur le site > Termes de recherche. Cela vous donnera un aperçu de ce que les clients recherchent sur le site Web.

Puis, j’utiliserai ces termes de recherche pour créer un nouveau segment dans Google Analytics afin de voir quelles pages du site sont déjà classées pour ce terme de mot clé particulier.

Étape 4 : Vérification manuelle

Outils :

- Google Analytics.

- Accès au serveur et à l’hôte du client.

- You Get Signal.

- Pingdom.

- PageSpeed Tools.

- Wayback Machine.

Une version du site de votre client est consultable

Vérifiez toutes les différentes façons dont vous pourriez rechercher un site web. Par exemple :

- http://annaisaunicorn.com

- https://annaisaunicorn.com

- http://www.annaisaunicorn.com

Comme dirait Highlander, « il ne peut y avoir qu’un » site web qui soit consultable.

Comment réparer : Utilisez une redirection 301 pour toutes les URL qui ne sont pas le site principal vers le site canonique.

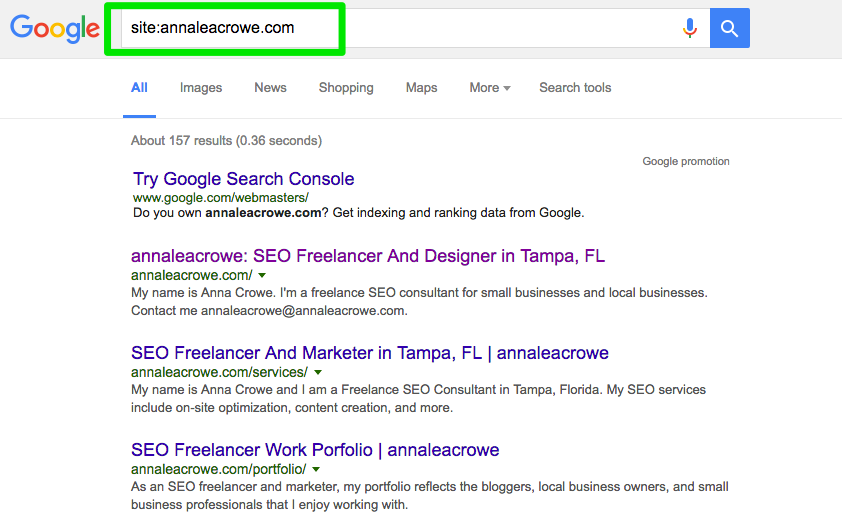

Indexation

Réalisez une recherche manuelle dans Google et Bing pour déterminer combien de pages sont indexées par Google. Ce nombre n’est pas toujours précis avec vos données Google Analytics et Google Search Console, mais il devrait vous donner une estimation approximative.

Pour vérifier, faites ce qui suit :

- Faites une recherche de site dans les moteurs de recherche.

- Lorsque vous effectuez une recherche, scannez manuellement pour vous assurer que seule la marque de votre client apparaît.

- Vérifiez que la page d’accueil est sur la première page. John Mueller a déclaré qu’il n’est pas nécessaire que la page d’accueil apparaisse en premier résultat.

Comment réparer:

- Si une autre marque apparaît dans les résultats de recherche, vous avez un plus gros problème sur les bras. Vous devrez vous plonger dans les analyses pour diagnostiquer le problème.

- Si la page d’accueil n’apparaît pas comme premier résultat, effectuez une vérification manuelle du site web pour voir ce qu’il manque. Cela pourrait également signifier que le site a une pénalité ou une mauvaise architecture de site, ce qui est un problème plus important de refonte du site.

- Croisez le nombre de pages de destination organiques dans Google Analytics pour voir s’il correspond au nombre de résultats de recherche que vous avez vus dans le moteur de recherche. Cela peut vous aider à déterminer quelles sont les pages que les moteurs de recherche considèrent comme précieuses.

Cache

Je vais lancer une vérification rapide pour voir si les principales pages sont mises en cache par Google. Google utilise ces pages mises en cache pour connecter votre contenu avec les requêtes de recherche.

Pour vérifier si Google met en cache les pages de votre client, faites ceci :

http://webcache.googleusercontent.com/search?q=cache:https://www.searchenginejournal.com/pubcon-day-3-women-in-digital-amazon-analytics/176005/

Assurez-vous de basculer vers la version Texte seul.

Vous pouvez également vérifier cela dans Wayback Machine.

Comment réparer:

- Vérifiez le serveur du client pour voir s’il est en panne ou fonctionne plus lentement que d’habitude. Il peut y avoir une erreur interne du serveur ou un échec de connexion à la base de données. Cela peut se produire si plusieurs utilisateurs tentent d’accéder au serveur en même temps.

- Vérifiez qui d’autre est sur votre serveur avec une vérification d’adresse IP inverse. Vous pouvez utiliser le site Web You Get Signal pour cette phase. Vous devrez peut-être mettre à niveau le serveur de votre client ou commencer à utiliser un CDN si vous avez des domaines sommaires qui partagent le serveur.

- Vérifier si le client supprime des pages spécifiques du site.

Hébergement

Bien que cela puisse devenir un peu technique pour certains, il est vital pour votre succès SEO de vérifier le logiciel d’hébergement associé au site Web de votre client. L’hébergement peut nuire au référencement et tout votre travail acharné ne servira à rien.

Vous devrez avoir accès au serveur de votre client pour vérifier manuellement tout problème. Les problèmes d’hébergement les plus courants que je vois sont d’avoir le mauvais TLD et une vitesse de site lente.

Comment réparer:

- Si votre client a le mauvais TLD, vous devez vous assurer que l’adresse IP du pays est associée au pays dans lequel votre client opère le plus. Si votre client possède un domaine .co et également un domaine .com, vous devrez rediriger le .co vers le domaine principal de votre client sur le .com.

- Si la vitesse du site de votre client est lente, vous devrez y remédier rapidement car la vitesse du site est un facteur de classement. Découvrez ce qui rend le site lent avec des outils comme PageSpeed Tools et Pingdom. Voici un aperçu de certains problèmes courants de vitesse de page :

- Host.

- Grandes images.

- Vidéos intégrées.

- Plugins.

- Ads.

- Theme.

- Widgets.

- Scripts répétitifs ou code dense.

Audit Core Web Vitals

Core Web Vitals est une collection de trois métriques qui sont représentatives de l’expérience utilisateur d’un site web. Elles sont importantes car Google met à jour ses algorithmes au printemps 2021 pour intégrer Core Web Vitals comme facteur de classement.

Bien que le facteur de classement devrait être faible, il est toujours important d’auditer les scores Core Web Vitals et d’identifier les domaines à améliorer.

Pourquoi est-il important d’inclure Core Web Vitals dans votre audit ?

L’amélioration des scores Core Web Vitals n’aidera pas seulement le classement de recherche, mais peut-être plus important encore, cela peut être payant avec plus de conversions et de gains.

Les améliorations de la vitesse et de la performance des pages sont associées à une augmentation des ventes, du trafic et des clics publicitaires.

La mise à niveau de l’hébergement web et l’installation d’un nouveau plugin peuvent améliorer la vitesse des pages mais auront peu (ou pas) d’effet sur les Core Web Vitals.

La mesure est effectuée au moment où quelqu’un télécharge littéralement votre site sur son téléphone mobile.

Cela signifie que le goulot d’étranglement se situe au niveau de sa connexion Internet et de son appareil mobile. Un serveur rapide n’accélérera pas une connexion Internet lente sur un téléphone mobile à petit budget.

De même, parce que beaucoup de solutions impliquent de modifier le code dans un modèle ou les fichiers de base du système de gestion de contenu lui-même, un plugin de vitesse de page sera très peu utile.

Il existe de nombreuses ressources pour aider à comprendre les solutions. Mais la plupart des solutions nécessitent l’assistance d’un développeur qui se sent à l’aise pour mettre à jour et modifier les fichiers de base de votre système de gestion de contenu.

Réparer les problèmes de Core Web Vitals peut être difficile. WordPress, Drupal et d’autres systèmes de gestion de contenu (CMS) n’ont pas été construits pour obtenir un bon score pour Core Web Vitals.

Il est important de noter que le processus d’amélioration de Core Web Vitals implique de changer le codage au cœur de WordPress et d’autres CMS.

Essentiellement, l’amélioration de Core Web Vitals nécessite de faire faire à un site Web quelque chose qu’il n’a jamais été destiné à faire lorsque les développeurs ont créé un thème ou un CMS.

Le but d’un audit Core Web Vitals est d’identifier ce qui a besoin d’être corrigé et de remettre cette information à un développeur qui peut alors apporter les changements nécessaires.

Que sont les Core Web Vitals ?

Les Core Web Vitals sont constitués de trois métriques qui identifient collectivement la vitesse de chargement de la partie la plus importante de votre page, la vitesse à laquelle un utilisateur peut interagir avec la page (exemple : cliquer sur un bouton) et la vitesse à laquelle la page web devient stable sans que les éléments de la page ne se déplacent.

Il y a :

- Peinture du plus grand contenu (LCP).

- Délai de première entrée (FID).

- Décalage cumulatif de mise en page (CLS).

Il existe deux types de scores pour les Core Web Vitals :

- Données de laboratoire.

- Données de terrain.

Données de laboratoire

Les données de laboratoire sont ce qui est généré lorsque vous exécutez une page par Google Lighthouse ou dans PageSpeed Insights.

Les données de laboratoire consistent en des scores générés par un appareil et une connexion Internet simulés. Le but est de donner à la personne qui travaille sur le site une idée des parties des Core Web Vitals qui doivent être améliorées.

La valeur d’un outil comme PageSpeed Insights est qu’il identifie le code spécifique et les éléments de la page qui font qu’une page a un mauvais score.

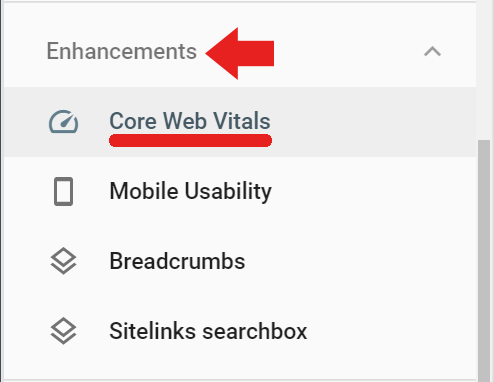

Données de terrain

Les données de terrain sont des scores réels des Core Web Vitals qui ont été collectés par le navigateur Google Chrome pour le Chrome User Experience Report (également connu sous le nom de CrUX).

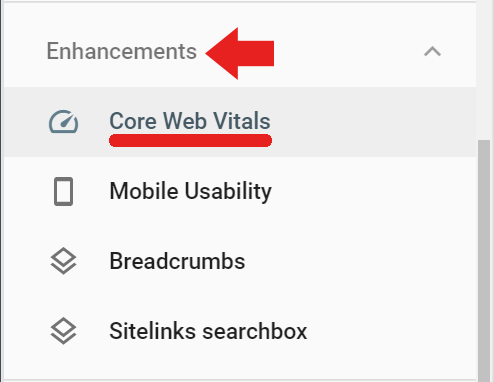

Les données de champ sont disponibles dans Google Search Console sous l’onglet Améliorations via le lien intitulé Core Web Vitals (les données de champ sont également accessibles via ce lien) https://search.google.com/search-console/core-web-vitals.

Les données de champ rapportées dans Google Search Console proviennent des pages visitées qui ont eu un minimum de visites et de mesures. Si Google ne reçoit pas suffisamment de notes, alors Google Search Console ne signalera pas ce score.

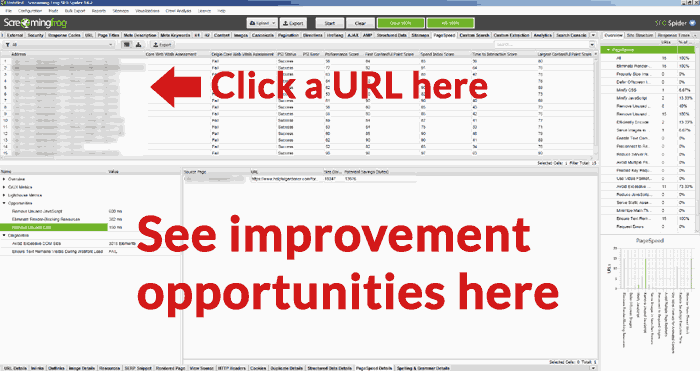

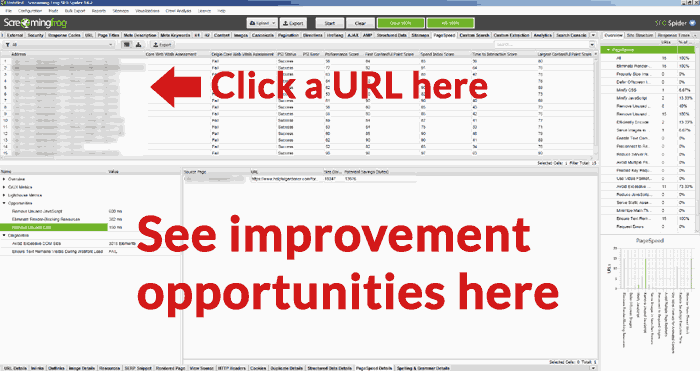

Screaming Frog pour l’audit Core Web Vitals

Screaming Frog version 14.2 a maintenant la capacité d’afficher une évaluation Core Web Vitals réussie ou non. Vous devez connecter Screaming Frog à l’API PageSpeed Insights (obtenez une clé API ici) via une clé.

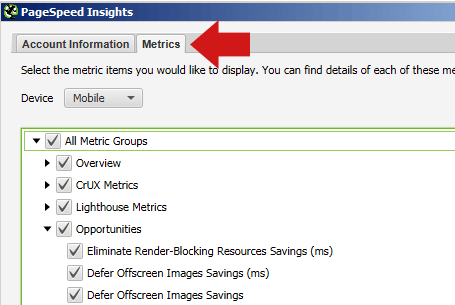

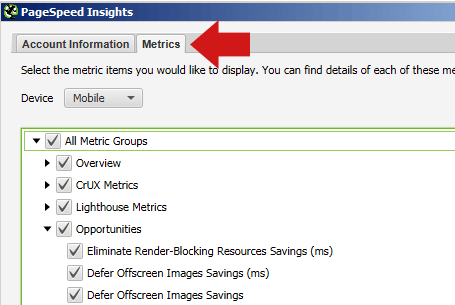

Pour enregistrer votre clé API Page Speed Insights avec Screaming Frog, naviguez d’abord dans Configuration > Accès API > PageSpeed Insights

Là, vous verrez un endroit pour entrer votre clé API et la connecter au service.

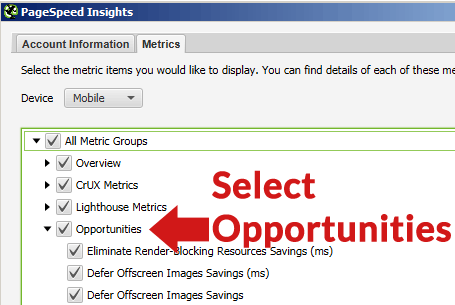

Dans la même fenêtre contextuelle de PageSpeed Insights, vous pouvez également sélectionner l’onglet Métriques et cocher les cases indiquant les métriques que vous souhaitez voir rapportées.

Veillez à sélectionner Mobile pour l’appareil, car c’est la métrique qui compte à des fins de classement.

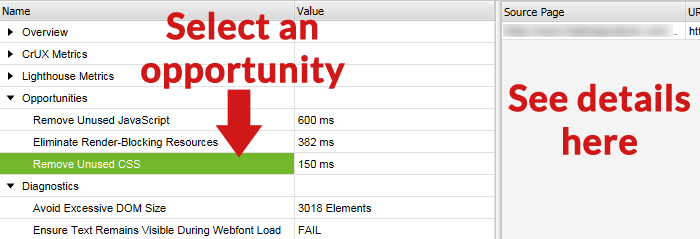

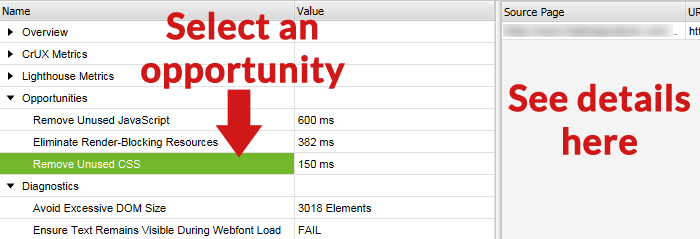

Si vous sélectionnez l’onglet Opportunités, après le crawl Screaming Frog vous montrera une liste de différents types d’améliorations (comme reporter les images hors écran, supprimer les CSS inutilisées, etc.)

Note avant le crawling

Il n’est généralement pas nécessaire de crawler un site entier et de produire une comptabilité exhaustive page par page de ce qui ne va pas avec chaque page du site web.

Avant de crawler, vous pouvez envisager de crawler un ensemble représentatif de pages. Pour ce faire, sélectionnez d’abord un groupe de pages qui représentent les types de pages communes à chaque section ou catégorie du site Web. Créez une feuille de calcul, une liste de fichiers texte ou collez manuellement les URL à l’aide de l’onglet Upload de Screaming Frog.

La plupart des sites contenaient des pages et des billets créés avec une structure de page et un contenu similaires. Par exemple, toutes les pages d’une catégorie « news » vont être assez similaires, les pages d’une catégorie « reviews » vont également être similaires les unes aux autres.

Vous pouvez gagner du temps en crawlant un groupe représentatif de pages afin d’identifier les problèmes communs à toutes les catégories individuelles ainsi que les problèmes communs à toutes les pages du site qui doivent être corrigés.

En raison de ces similarités, les problèmes découverts vont être similaires. Il peut être seulement nécessaire de crawler une poignée de pages représentatives de chaque type de catégorie afin d’identifier quels types de problèmes sont spécifiques à chacune de ces sections.

Le genre de choses qui sont corrigées sont généralement des problèmes communs à l’ensemble du site, comme les CSS inutilisés qui sont chargés à partir de chaque page ou le Cumulative Layout Shift causé par une unité publicitaire située dans la zone gauche des pages web.

Parce que les sites Web modernes sont modélisés, les corrections se produiront au niveau du modèle ou avec un codage personnalisé dans la feuille de style, etc.

Crawl le site avec Screaming Frog

Une fois que les URL sont entièrement crawlées, vous pouvez cliquer sur l’onglet PageSpeed et lire toutes les recommandations et voir les notations de réussite/échec pour les différentes métriques.

Zoomer sur les opportunités d’URL

Une fonctionnalité utile de l’audit Screaming Frog Core Web Vitals est la possibilité de sélectionner une URL dans la liste des URL du volet supérieur, puis de voir les opportunités d’amélioration dans le volet inférieur de l’écran d’affichage de Screaming Frog.

Vous trouverez ci-dessous une capture d’écran de l’écran inférieur, avec une opportunité sélectionnée et les détails de cette opportunité d’amélioration dans le volet de droite.

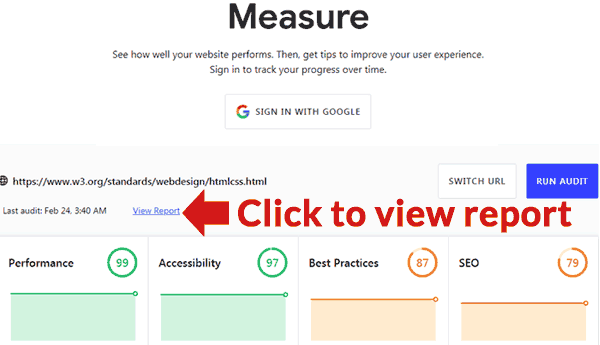

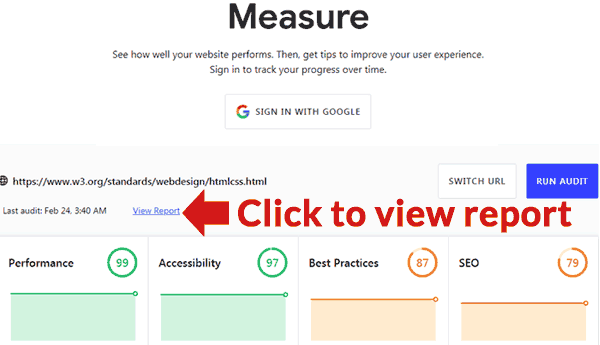

Outil officiel de Google

Google a publié un outil qui peut fournir un audit. Il est situé ici : https://web.dev/measure/

Insérez une URL pour obtenir un aperçu des performances de la page. Si vous êtes connecté, Google suivra la page pour vous au fil du temps. En cliquant sur le lien Afficher le rapport, vous ouvrirez une nouvelle page contenant un rapport détaillant ce qui ne va pas et des liens vers des guides indiquant comment résoudre chaque problème.

.