正直に言うと、私はそう思っています。

そして、SEOコンサルタントとして、「あなたの監査は素晴らしい!」という言葉ほど嬉しいものはありません。

新しい仕事を積極的に探していなかったとしても、SEO監査がうまくいったと分かれば、自尊心が高まります。 これはあなたの最初のSEO監査ですか?

潜在的なクライアントに素晴らしい SEO 監査を送信することで、あなたは可能な限り最高の場所にいることができるのです。

このコラムでは、SEO監査を行うために知っておくべき手順と、私が初めて新しいクライアントを得たときのプロセスの最初の段階について少し洞察してまとめました。 以下、各セクションに分かれています。 このページでは、SEO監査に必要なステップと、私が新しいクライアントを獲得したときの最初のプロセスについての考察をまとめました。

潜在的な顧客が一緒に仕事をすることに興味を示したメールを送り、彼らが私のアンケートに答えた後、イントロコールを設定します(スカイプまたはGoogleハングアウトが望ましい)

電話の前に、私は彼らの市場の状況に慣れるために、アンケートの回答に基づいて私自身のミニ クイックSEO監査(私は手動で調査するのに少なくとも1時間投資)を実行します。 これは、一度も会ったことのない人とデートするようなものです。

Facebook、Twitter、Instagram、および公開されている他のすべてのチャンネルで、明らかに彼らをストーカーするつもりです。

以下は、私の調査がどのように見えるかの例です:

最初の会議でクライアントに尋ねたい重要な質問をいくつか紹介します。 チャネル目標(PR、ソーシャルなど)は何ですか。

スジャン・パテルは、新しいSEOクライアントに尋ねるべき質問について、いくつかの素晴らしい勧告も行っています。

まず、最初の1ヶ月はお試し期間として、私たちの雰囲気を確認するために、クライアントにオファーするようにしています。 この1ヶ月の間に、私は時間をかけて綿密なSEO監査を行います。

これらのSEO監査は、ウェブサイトの規模にもよりますが、40時間から60時間かかることもあります。 これらの監査は、3つの別々の部分にバケットされ、Google Slides.

- 技術で提示されます。 クロールエラー、インデックス、ホスティング、など。 キーワードリサーチ、競合分析、コンテンツマップ、メタデータなど。 バックリンクプロファイルの分析、成長戦術など

最初の1ヶ月後、クライアントが私の仕事を気に入れば、SEO監査からの推奨事項を実行に移します。

要約すると、私はクライアントのためにSEO監査を行います:

- 初月。

- 毎月(ミニ監査)。

SEO監査の前にクライアントから必要なもの

クライアントと私が一緒に仕事を始めるとき、私はパスワードとベンダーのリストを要求するGoogleドキュメントを共有します:

これには以下が含まれます:

- Google Analyticsアクセスおよび任意のサードパーティ解析ツール

- GoogleおよびBing広告SEO監査の前にクライアントが必要とするものは?

- Webmaster tools.

- Website backend access.

- Social media accounts.

- List of vendors.

- List of internal team members (including any work they outsource)(外部委託を含む)。

SEO監査のためのツール

SEO監査を始める前に、私が使用しているツールをまとめておきます:

- Screaming Frog.

- Integrity (Mac ユーザー用) と Xenu Sleuth (PC ユーザー用).

- SEO Browser.

- Wayback Machine.

- Moz.

- BuzzSumo.

- DeepCrawl.

- Copyscape.

- Google Tag Manager.

- SMO.index.etc。

- Google Tag Manager Chrome Extension.

- Annie Cushing’s Campaign Tagging Guide.

- Google Analytics(アクセス権がある場合).

- Google Search Console(アクセス権がある場合).

- Bing Webmaster Tools(アクセス権がある場合).

- You Get Signal.

- Pingdom.(英語のみ).(英語のみ).etc。

- PageSpeed Tool.

- Sublime Text.

テクニカルSEO監査の実施

テクニカルSEO監査に必要なツール:

- Screaming Frog.

- DeepCrawl.

- Copyscape.を使用することです。

- Integrity for Mac (または PC ユーザーは Xenu Sleuth).

- Google Analytics (アクセスが許可されている場合).

- Google Search Console (アクセス許可がある場合).

- Bing Webmaster Tools(アクセスがある場合).

Step 1: Add Site to DeepCrawl and Screaming Frog

Tools:

- DeepCrawl.Screaming Frog (サイトがDeepCrawlとScreaming Frogに追加される).Bing Webmaster Tools (アクセス権がある場合).

- Copyscape.

- Screaming Frog.

- Google Analytics.

- Integrity.

- Googleタグマネージャ.

- Google Analytics code.

DeepCrawlを使うときに見るべきもの

私が最初に行うことは、クライアントのサイトをDeepCrawlに追加することです。 クライアントのサイトの規模にもよりますが、クロールの結果が返ってくるまで1日か2日かかるかもしれません。

DeepCrawlの結果が戻ってきたら、私が探すものは次のとおりです。

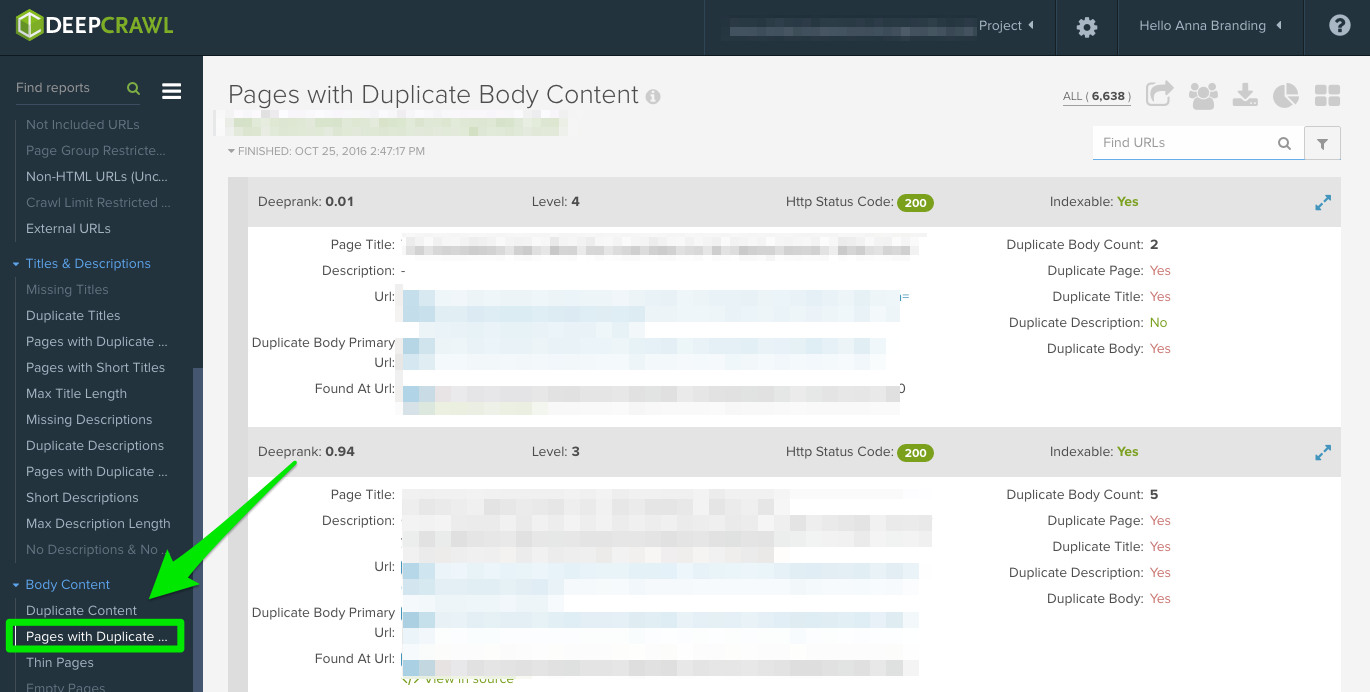

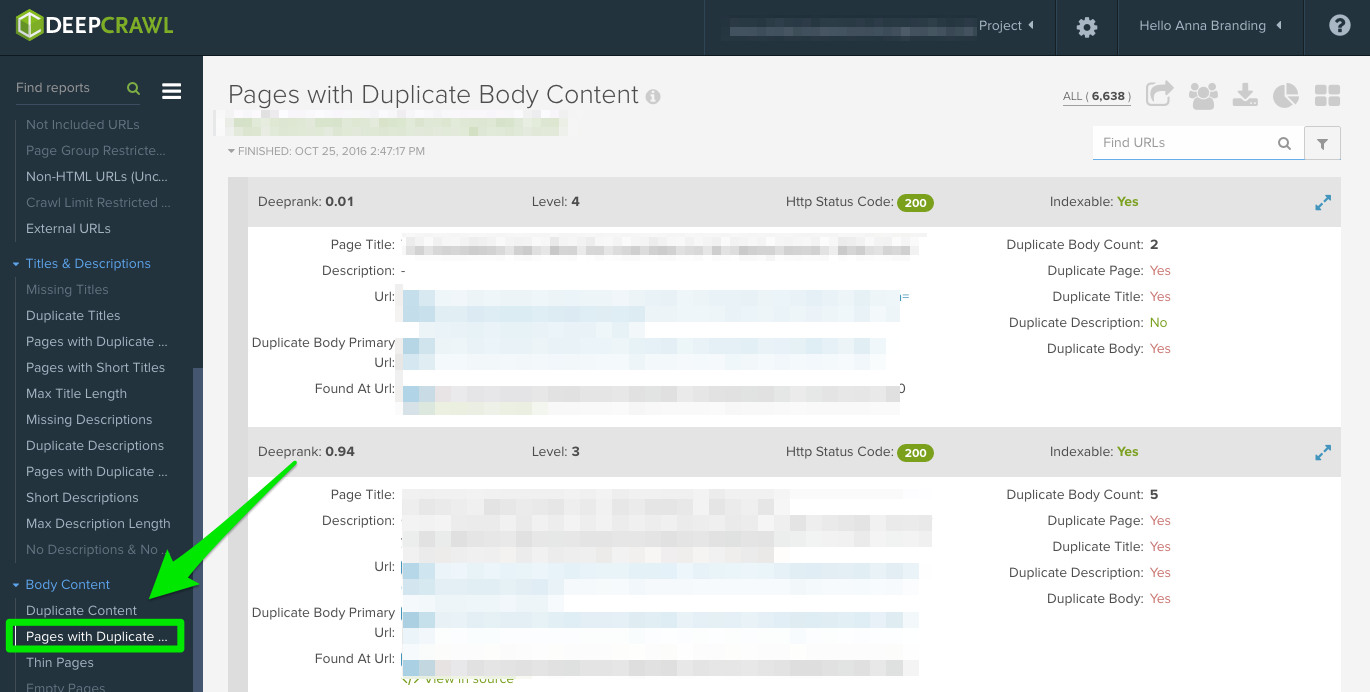

Duplicate Content

重複したコンテンツを探すために「重複したページ」レポートをチェックすること。

重複したコンテンツが見つかった場合、クライアントに対してこれらのページを書き直すよう最優先で提案し、その間に、重複したページに <meta name=”robots” content=”noindex, nofollow”> タグを追加します。

発見できる共通の重複コンテンツ エラー:

- meta title と meta descriptions が重複している。

- タグページからの本文の重複(何かが盗用されているかどうかを判断するためにCopyscapeを使用します)。

- 2つのドメイン(ex: yourwebsite.co, yourwebsite.com).

- サブドメイン(ex: jobs.yourwebsite.com).

- 異なるドメインで同様のコンテンツ。

- 不適切に実施されたページネーションページ(以下を参照ください)。)

修正方法:

- ページに canonical タグを追加して、優先する URL を Google に知らせる。

- robots.php で不正な URL を許可しない。

- コンテンツを書き直す(ボディ コピーやメタデータを含む)。

ここで、私のクライアントで発生した重複コンテンツ問題の一例を紹介します。 以下のように、canonical タグを使用しない URL パラメーターがありました。

私が問題を解決するために取った手順は以下のとおりです。

- 301 リダイレクト問題を修正しました。

- Googleがクロールしたいページに対して正規化タグを追加しました。

- Googleサーチコンソールのパラメータ設定を更新し、ユニークなコンテンツを生成しないパラメータを除外しました。

- robotsにdisallow関数を追加しました。txtを不正なURLに追加し、クロールバジェットを改善しました。

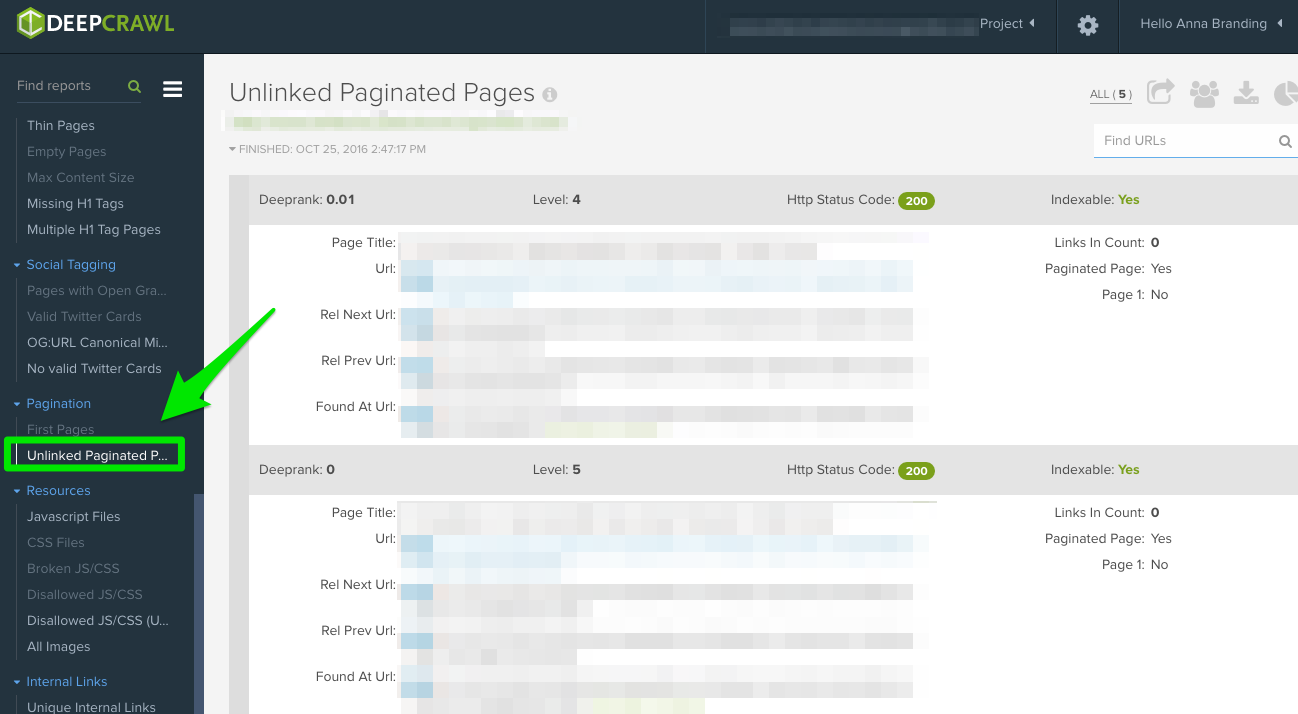

Pagination

チェックすべきレポートは2つあります:

- First Pages.Pagination。 どのページがページ付けを使用しているかを調べるには、「First Pages」レポートを確認します。 その後、サイト上でこれを使用しているページを手動で確認し、ページネーションが正しく実装されているかどうかを発見できます。

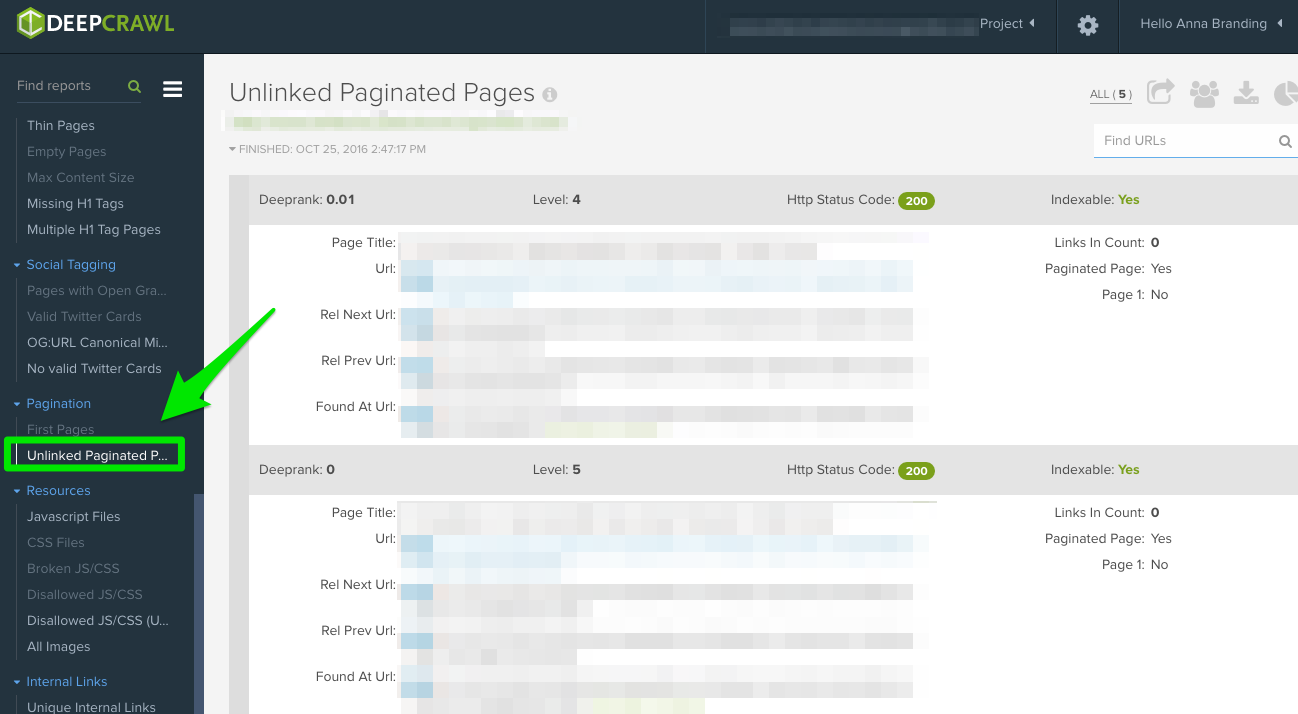

- Unlinked Pagination Pages。 ページネーションが正しく機能しているかどうかを調べるには、「Unlinked Pagination Pages」レポートで、rel=”next” と rel=”prev” が前のページと次のページにリンクされているかどうかを知ることができます。

この下の例では、DeepCrawlを使用して、クライアントが相互ページネーションタグを持っていることを見つけることができました。

修正方法:

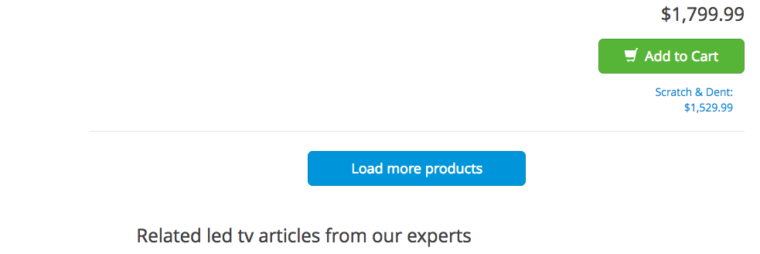

- “view all” または “load more” ページを持っているなら、 rel=”canonical” タグを追加してください。 以下は、Crutchfield の例です:

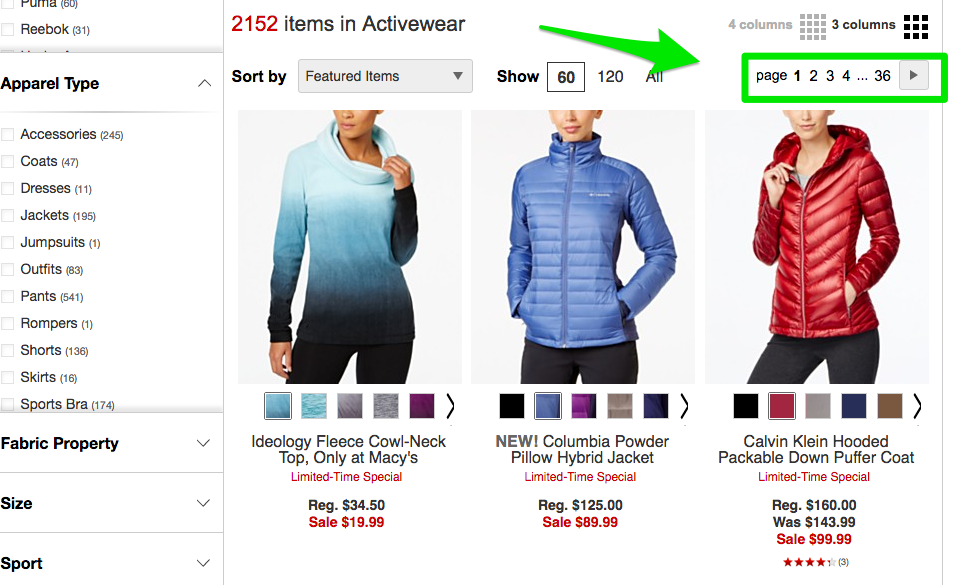

- すべてのページを別々のページにしている場合は、標準の rel=”next” および rel=”prev” マークアップを追加してください。 以下は Macy’s の例です。

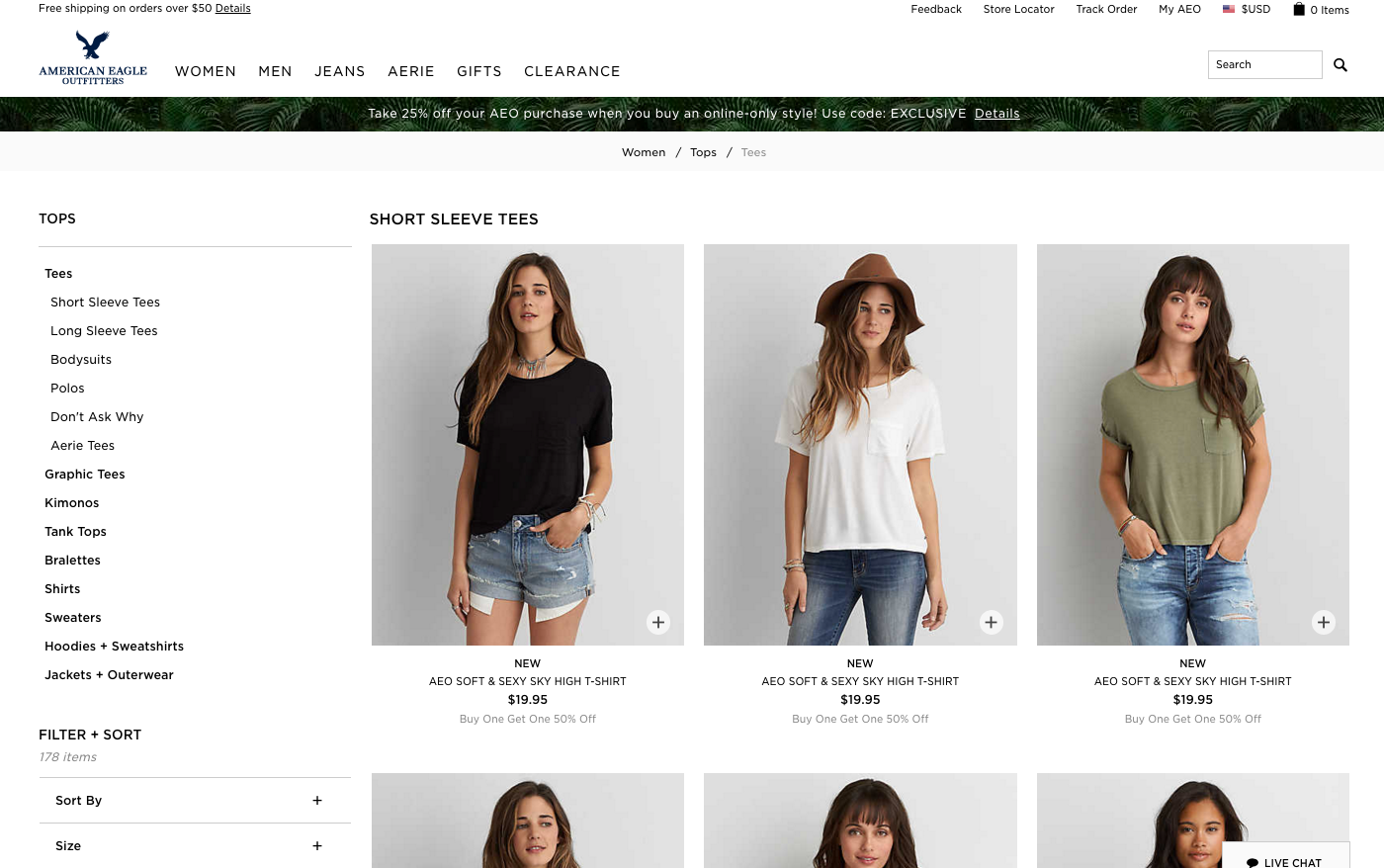

- 無限スクロールを使用している場合は、javascript で同等のページ分割ページ URL を追加してください。 以下はAmerican Eagleの例です。

Max Redirections

「Max Redirections」レポートを確認し、4回以上リダイレクトするすべてのページを見てください。 John Mueller氏は2015年に、5回以上あるとGoogleはリダイレクトを追えなくなると言及しています。

こうしたクロールエラーを「クロール予算」を食い尽くすと言う人もいますが、Gary Illyes氏はこれを「ホストロード」と呼んでいます。

ここで、あなたが目にするかもしれない応答コードの概要を簡単に説明します:

- 301 – これらはあなたが調査を通して目にするコードの大部分である。 301リダイレクトは、リダイレクトが1つだけで、リダイレクトループがない限り大丈夫です。

- 302 – これらのコードは大丈夫ですが、もし3ヶ月以上放置されている場合は、それらが永久であるように手動で301に変更します。

- 400 – ユーザーがページにアクセスできない。

- 403 – ユーザーがページにアクセスする権限がない。

- 404 – ページが見つからない(通常は、クライアントが301リダイレクトなしでページを削除したことを意味します)。

- 500 – 内部サーバー エラー。原因を特定するために Web 開発チームに接続する必要があります。

修正方法:

- 古い 404 ページを指す内部リンクをすべて削除し、リダイレクト ページの内部リンクで更新してください。 例えば、リダイレクトAがリダイレクトB、C、Dに行く場合、リダイレクトBとCを元に戻すことになります。最終的には、リダイレクトAからDになります。

- また、Screaming FrogとGoogle Search Consoleでこれを行う方法がありますので、そのバージョンを使用している場合は以下を参照してください。

Screaming Frogを使うときに見るべきこと

新しいクライアントサイトを入手したときに私が行う2つ目のことは、そのURLをScreaming Frogに追加することです。

クライアントのサイトのサイズによっては、一度にサイトの特定の領域をクロールするように設定することができます。

以下は、私のScreaming Frogスパイダーの設定のようすです。

これはスパイダーの設定かサイトの領域を除外して行うことができます。

Screaming Frogの結果が返ってきたら、私が探すものは以下のとおりです:

Google Analytics Code

Screaming Frogは、どのページにGoogle Analyticsコード(UA-1234568-9)が欠けているかを特定するのに役に立ちます。 不足しているGoogle Analyticsコードを見つけるには、以下の手順に従ってください:

- ナビゲーションバーの「設定」から「カスタム」を選択します。

- フィルター1 に analytics.js を追加し、ドロップダウンを Does not contain に変更します。

修正方法:

- クライアントの開発者に連絡し、不足している特定のページにコードを追加してもらうよう依頼します。

- Google Analytics の詳細については、以下の Google Analytics のセクションに進んでください。

Google Tag Manager

Screaming Frogでも、同様の手順でGoogle Tag Managerスニペットがないページを見つけることができます。

- ナビゲーションバーの設定タブに移動し、カスタム。

- フィルターで<iframe src-“//www.googletagmanager.com/ with Does not contain selected.

修正方法:

- Googleタグマネージャに移動して、エラーがあるかどうかを確認し、必要な場所を更新します。

- コードをクライアントの開発者と共有し、サイトに追加できるかどうかを確認します。

スキーマ

また、クライアントのサイトでスキーマ マークアップを使用しているかどうかを確認することもできます。 スキーマまたは構造化データは、検索エンジンがサイト内のページが何であるかを理解するのに役立ちます。

Screaming Frog でスキーマ マークアップを確認するには、次の手順に従ってください:

- ナビゲーション バーの設定タブに移動し、カスタム。

- フィルターで「含む」を選択して itemstype=”http://schema.\.org/ を追加します。

Indexing

Indexing

クライアントに対してインデックスされているページ数を決定したい場合は、Screaming Frogでこの手順に従ってください。

- Screaming Frogでサイトの読み込みが完了したら、Directives > Filter > Indexに移動し、コードの欠落がないか確認します。

修正方法:

- 新しいサイトでは、Googleはまだそれをインデックスされていない可能性があります。txt ファイルを確認し、Google にクロールさせたいものを許可していないことを確認します。

- クライアントのサイトマップを Google Search Console と Bing Webmaster Tools に送信したことを確認します。

- 手動調査を行います(以下を参照)。

Flash

Googleは2016年に、ページの読み込み時間が遅いことを理由に、ChromeがFlashをブロックするようになると発表しました。 そのため、監査を行う場合、新しいクライアントが Flash を使用しているかどうかを特定したいと思います。

Screaming Frog でこれを行うには、以下を試してください:

- ナビゲーションから Spider Configuration へ向かいます。

- Check SWFをクリックします。

- クロールが終わったらInternalタブをFlashでフィルタリングします。

解決方法:

- YouTubeから動画を埋め込んでいます。 Google は 2006 年に YouTube を買収しました。

- または、動画を追加するときに、HTML5 標準を選択します。

動画を追加する際のHTML5コードの例です:

<video controls="controls" width="320" height="240">> <source class="hiddenSpellError" data-mce-bogus="1" />src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.mp4" type="video/mp4"> <source src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.ogg" type="video/ogg" />Your browser does not support the video tag.</video>

JavaScript

2015年のGoogleの発表によると、robots.txtで何もブロックしていなければ、ウェブサイトにJavaScriptを使って問題ありません(少し掘り下げてみますね!)。 しかし、それでも、Javascriptがどのようにサイトに配信されているかを覗いてみたいものです。

修正方法:

- Javascriptを見直して、ロボットによってブロックされていないことを確認します。

- サーバー上でJavascriptが動作していることを確認する(これは動的なデータに対してプレーンテキストのデータを生成するのに役立ちます)。

- AngularのJavaScriptを実行している場合、なぜそれがあなたのSEO努力を殺しているかもしれないか、Ben Orenによるこの記事をチェックしてみてください。 クロールが完了したら、内部タブで結果をJavaScriptでフィルタリングします。

Robots.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.txt

Robots.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.XXX.txt

初めて robots.txt を確認するときは、重要なものがブロックされていないかどうか確認したい。

たとえば、このコードを見た場合:

User-agent: *Disallow: /

Your client’s website is blocked from all web crawlers.

But, if you have something like Zappos robots.txt file, you should be good to go.

# Global robots.txt as of 2012-06-19User-agent.Txt: *Disallow: /bin/Disallow: /multiview/Disallow: /product/review/add/Disallow。 /cartDisallow: /loginDisallow: /logoutDisallow: /registerDisallow。 /account

ウェブクローラーに検索されたくないものだけをブロックしています。 ブロックされているこのコンテンツは、Webクローラーにとって関連性も有用性もありません。

How to fix:

- Your robots.

- Screaming Frogはデフォルトでrobots.txtによって許可されていないURLは読み込むことができません。 Screaming Frogのデフォルト設定を切り替えると、すべてのrobots.txtを無視します。

- また、クロール完了後にScreaming Frogでレスポンスコードタブ、そしてブロックされたページ by Robots.txt フィルターで表示することが可能です。

- 複数のサブドメインを持つサイトでは、それぞれ別のrobots.txtを用意する必要があります。

- サイトマップがrobots.txtに記載されていることを確認します。

クロールエラー

クライアントのクロールエラーを見つけてクロスチェックするのにDeepCrawl、Screaming Frog、GoogleとBingのWebmaster Toolsを使用しています。

Screaming Frogでクロールエラーを見つけるには、次の手順に従います:

- クロールが完了したら、[一括レポート]に進みます。

- [応答コード]までスクロールし、サーバー側エラーレポートとクライアント側エラーレポートをエクスポートしてください。

修正方法:

- クライアント エラー レポートでは、サイトのバックエンドの 404 エラーの大部分を自分で 301 リダイレクトできるはずです。

- サーバー エラー レポートでは、開発チームと協力して原因を突き止めます。 ルート ディレクトリのこれらのエラーを修正する前に、必ずサイトをバックアップしてください。 単に新しい .html アクセス ファイルを作成するか、PHP メモリ制限を増やす必要があるかもしれません。

- また、サイトマップおよび内部または外部リンクからこれらの永久リダイレクトのいずれかを削除します。

- また、Google Analytics で追跡するために URL で 404 を使用することができます。

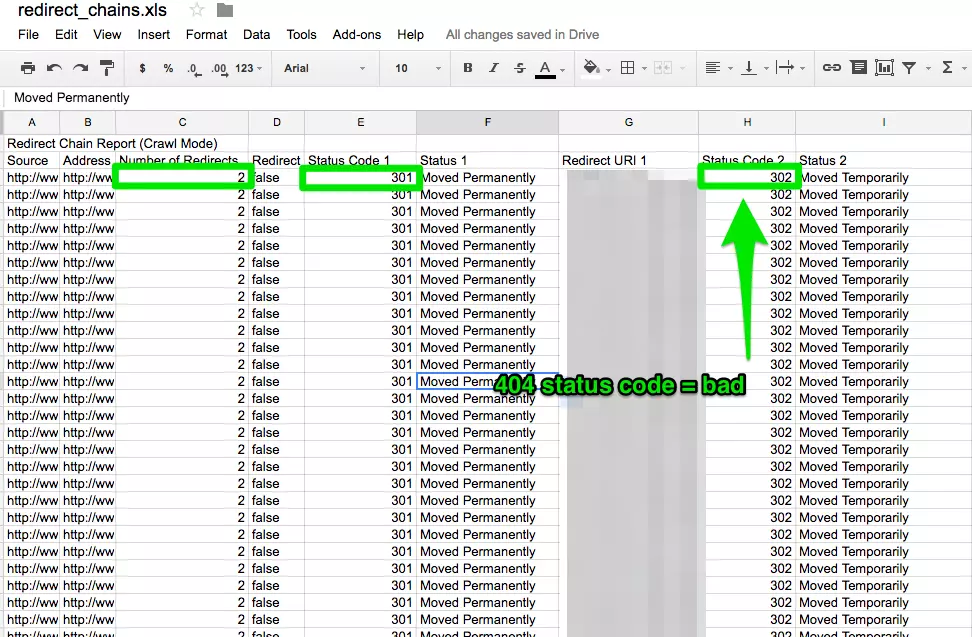

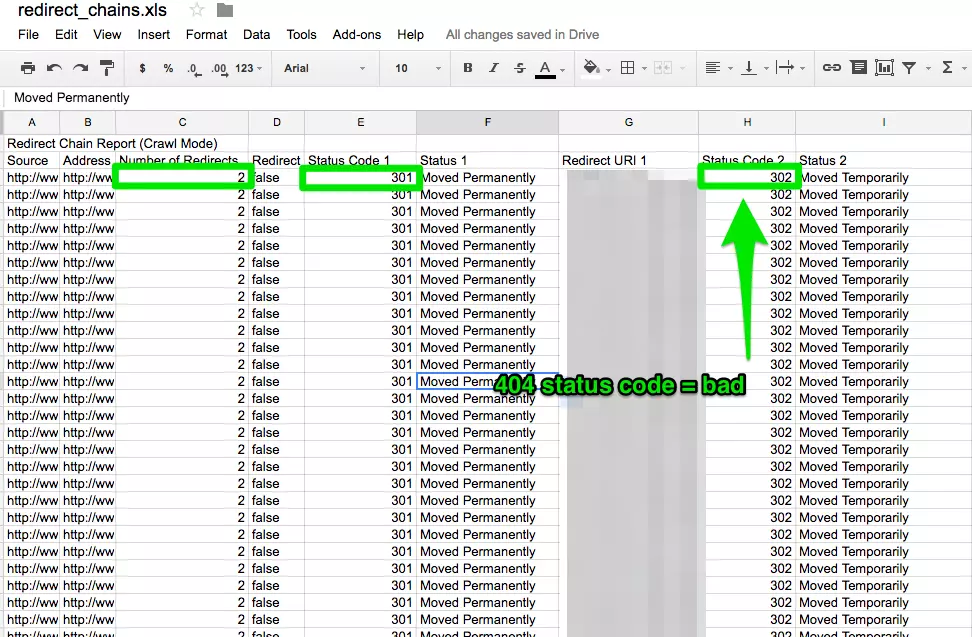

リダイレクトチェーン

リダイレクトチェーンは、貧しいユーザー体験を引き起こすだけでなく、それはページ速度を遅くし、変換率が低下し、あなたが以前に受け取ったかもしれないリンク愛を失っている。

リダイレクトチェーンを修正することは、どの企業にとっても迅速な勝利です。

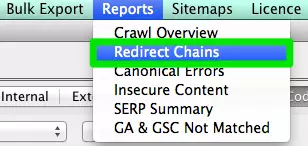

修正方法:

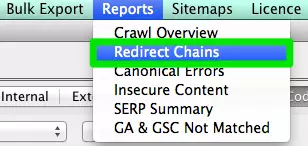

- Screaming Frogでクローリングを完了したら、レポート > Redirect Chainsでリダイレクトのクロール経路を確認します。 エクセルシートで、301リダイレクトが301リダイレクトのままであることを確認するために追跡することができます。 404エラーが表示される場合は、これをクリーンアップすることをお勧めします。

内部 & 外部リンク

ユーザーがあなたのサイトへのリンクをクリックしたときに404エラーが表示されるときがあります。 良いユーザーエクスペリエンスとは言えません。

また、検索エンジンに好かれることもありません。

壊れた内部リンクと外部リンクを見つけるために、私は Integrity for Mac を使用しています。 PC ユーザーなら Xenu Sleuth も使えます。

Screaming Frog と DeepCrawl を使用している場合は、これらの内部および外部リンクを見つける方法も説明します。

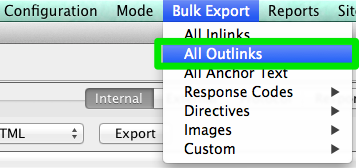

修正方法:

- Integrity または Xenu Sleuth を使用している場合、クライアントのサイトの URL を実行すると、壊れた URL の全リストが表示されます。 Screaming Frog を使用している場合、クロールが完了した後、ナビゲーション バーの [一括エクスポート]、[すべてのアウトリンク] の順に移動します。 URLでソートして、どのページが404シグナルを送信しているかを確認することができます。 All Inlinksで同じ手順を繰り返します。

- DeepCrawlを使っている場合、内部リンクセクションのUnique Broken Linksタブに行きます。

URLs

新しい顧客を担当するたびに、そのURLフォーマットを確認したくなりますね。 URL で何を探せばよいのでしょうか。

- パラメータ – URL に ?、=、+ などの奇妙な文字がある場合、それは動的 URL であり、最適化しなければ重複コンテンツを引き起こす可能性があります。

- ユーザーフレンドリー – URLは短くシンプルにしつつ、余分なスラッシュは削除したい。

修正方法:

- GoogleでパラメータURLを検索するには、site:www.buyaunicorn.com/ inurlと実行することでできます。 “? “など、パラメータが含まれると思われるものを入力します。

- ScreamingFrogでクロールを実行した後、URLを見てみましょう。 コンテンツの重複を作成しているパラメータが記載されている場合は、以下を提案する必要があります。

- メインURLのページにcanonicalタグを追加します。 たとえば、www.buyaunicorn.com/magical-headbands がメイン ページで、www.buyaunicorn.com/magical-headbands/?dir=mode123$ が表示される場合、www.buyaunicorn.com/magical-headbands に canonical タグを追加する必要があります。

- Google Search Console のクロール > URL パラメータでパラメータを更新してください。

- Disallow the duplicate URLs in the robots.で重複URLの削除を行います。txt.

ステップ 2: Google Search Console と Bing Webmaster Tools.

Tools:

- Google Search Console.

- Bing Webmaster Tools.

- Sublime Text (or any text editor tool).Text.TXT.Txt.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TXT.TT.TXT.

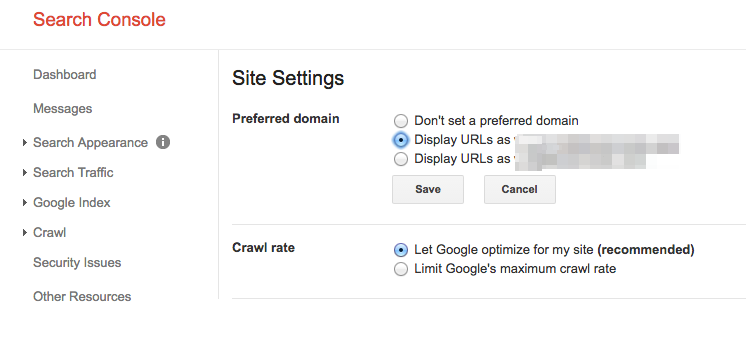

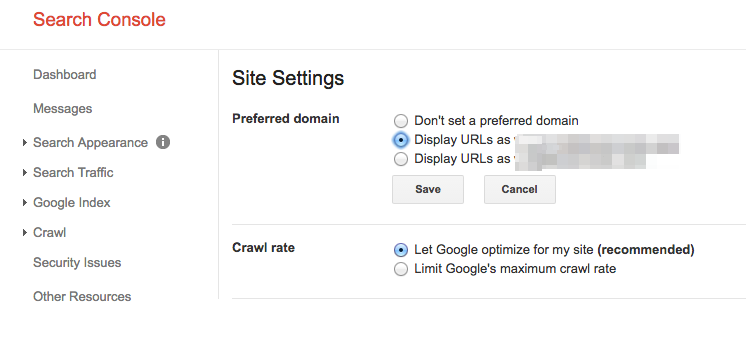

優先ドメインを設定する

広告Continue Reading Belowパンダアップデート以来、優先ドメインを検索エンジンに明示することは有益なことである。 また、すべてのリンクが 2 つのサイトに分散するのではなく、1 つのサイトに余分な愛を与えていることを確認できます。

修正方法:

- Googleサーチコンソールで、右上の歯車のアイコンをクリックします。

- URL のいずれを優先ドメインとするか選択します。

- Bing Webmaster Toolsで優先ドメインを設定する必要はなく、サイトマップを送信してBingの優先ドメインが決定できるようにするだけでよいです。

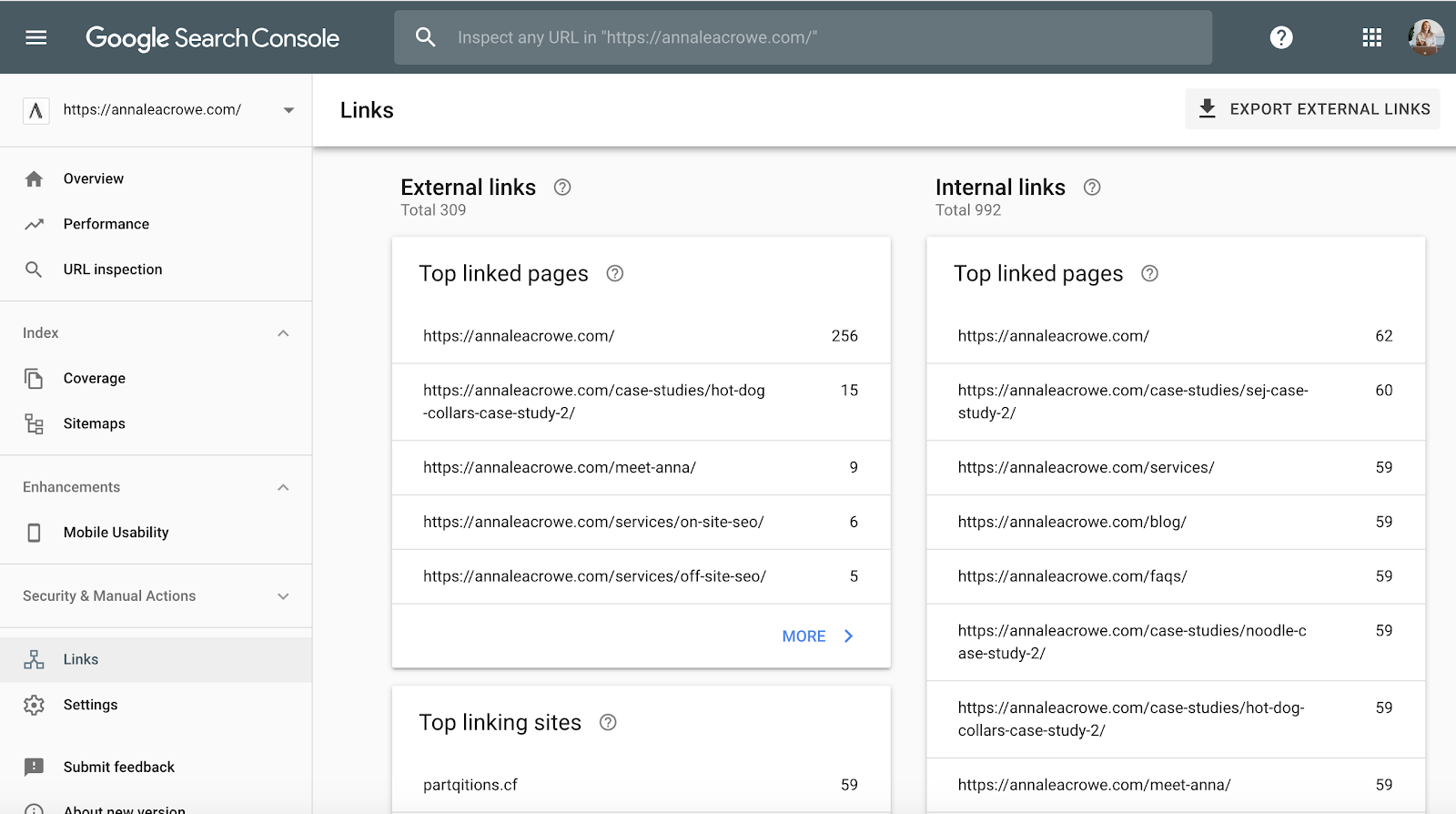

バックリンク

ペンギンがリアルタイムであることを発表したので、クライアントのバックリンクがGoogleの基準を満たすことが不可欠です。

ウェブサイトの1ページからクライアントのサイトに来るバックリンクの大きな塊に気づいたら、それをきれいにするために必要な手順を、速く踏みたいはずです!

バックリンクが、Googleの基準を満たすことを確認したら、そのページからのバックリンクを削除します。

AdvertisementContinue Reading Below修正方法:

- Googleサーチコンソールで、リンク>に移動し、トップリンクサイトをソートしてください。

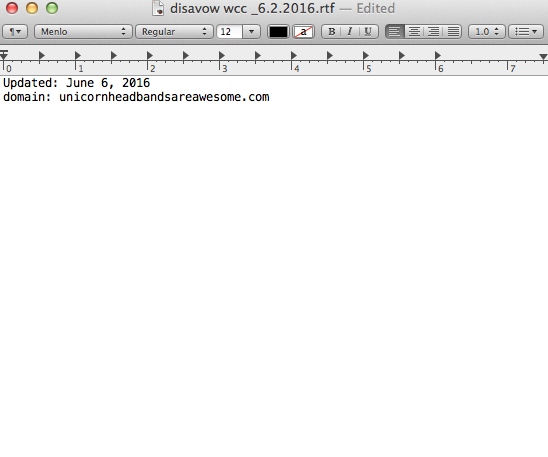

- 1つのページからリンクしている企業に連絡して、リンクを削除してもらうか、リンクを無効にするリストに追加してください。 企業を否認リストに追加する場合、その方法と理由には十分注意してください。 このような場合、「誹謗中傷の例」として、「誹謗中傷の例キーワード

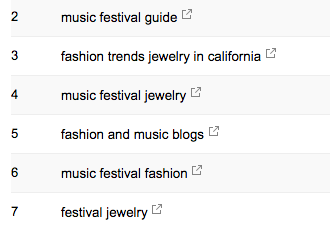

SEOコンサルタントとして、クライアントの市場環境を知ることが私の仕事です。 私は、彼らのターゲットオーディエンスが誰であるか、彼らが何を探しているのか、そしてどのように検索しているのかを知る必要があります。 そのため、私は、彼らがすでにトラフィックを得ているキーワード検索語を見てみましょう。

AdvertisementContinue Reading Below- Google Search Consoleで、検索トラフィック>検索分析では、すでにあなたのクライアントをクリックしているキーワードが表示されます。

Sitemap

Sitemap

Sitemaps は検索エンジンにクライアントのウェブサイトをクロールさせるために不可欠なものです。 それは彼らの言語を話します。 サイトマップを作成する際には、いくつか知っておくべきことがあります。

- サイトマップにパラメータ URL を含めない。

- インデックス化できないページを含めない。

- サイトにモバイルとデスクトップで異なるサブドメインがある場合、サイトマップに rel=”alternate” タグを追加する。

修正方法:

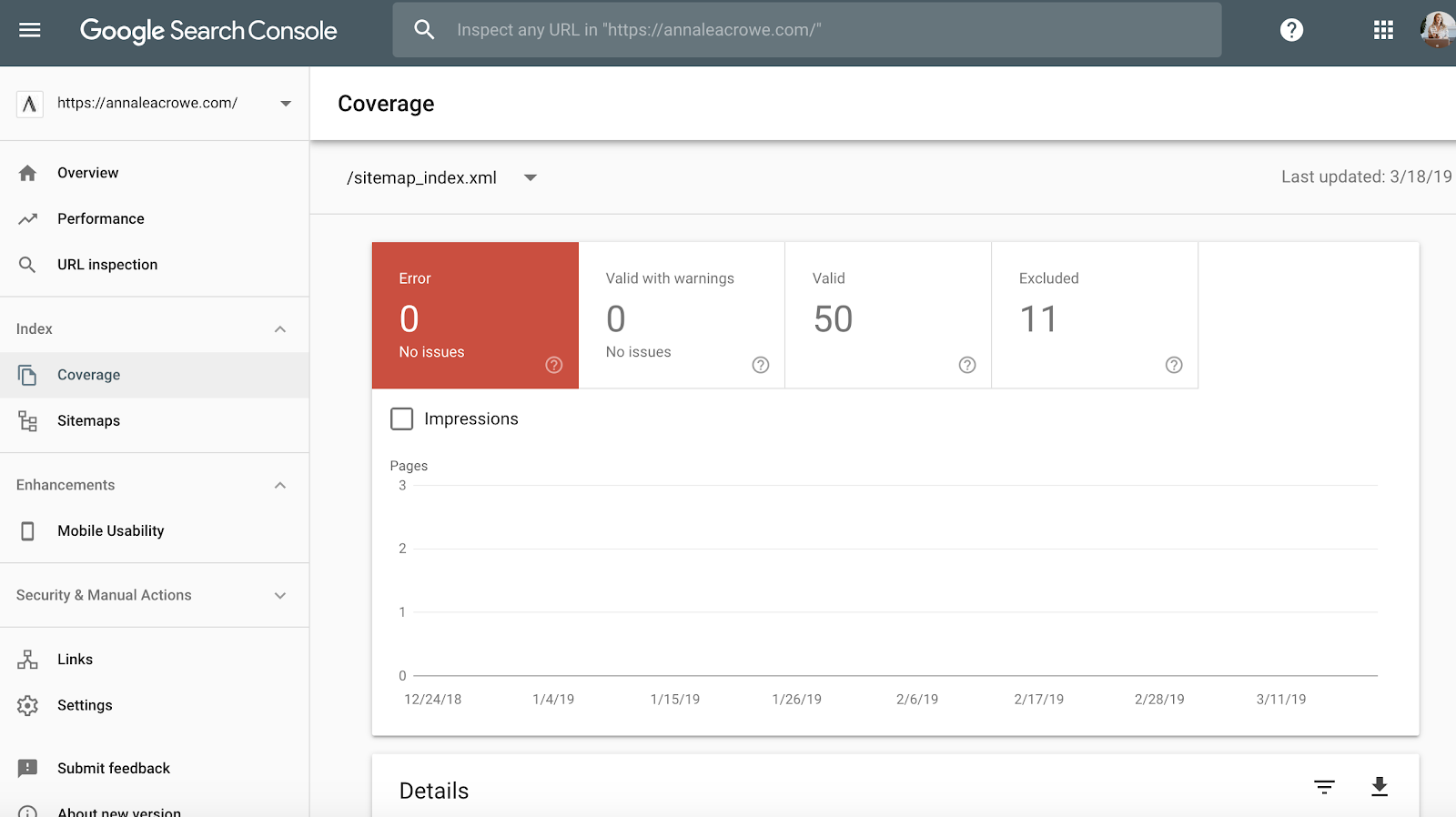

- Googleサーチコンソール>インデックス>サイトマップで、サイトマップでインデックスされているURLとWebインデックス内のURLを比較してください。

- 次に、手動検索を行って、インデックスされていないページとその理由を特定します。

- クライアントのサイトマップに古いリダイレクトURLを見つけた場合、それらを削除してください。 これらの古いリダイレクトは、それらを削除しない場合、SEOに悪影響を与えます。

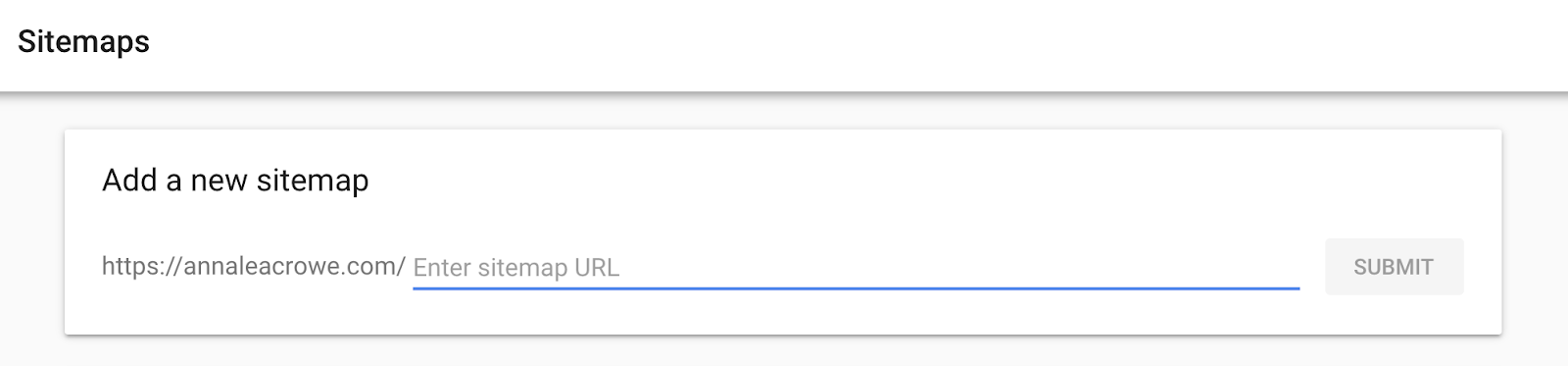

- クライアントが新しい場合、Bing Webmaster ToolsとGoogle Search Consoleの両方でそれらのために新しいサイトマップを提出します。

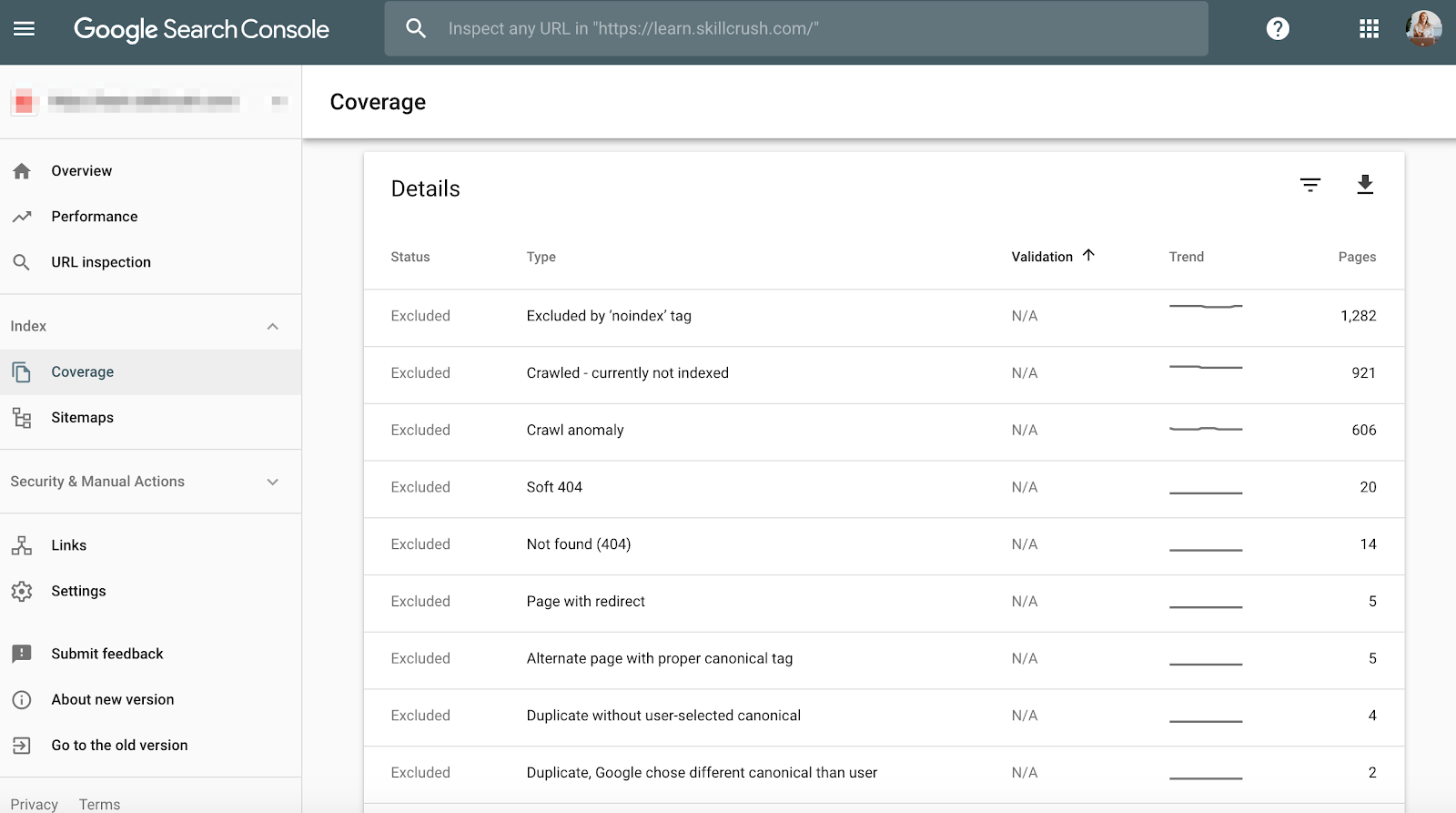

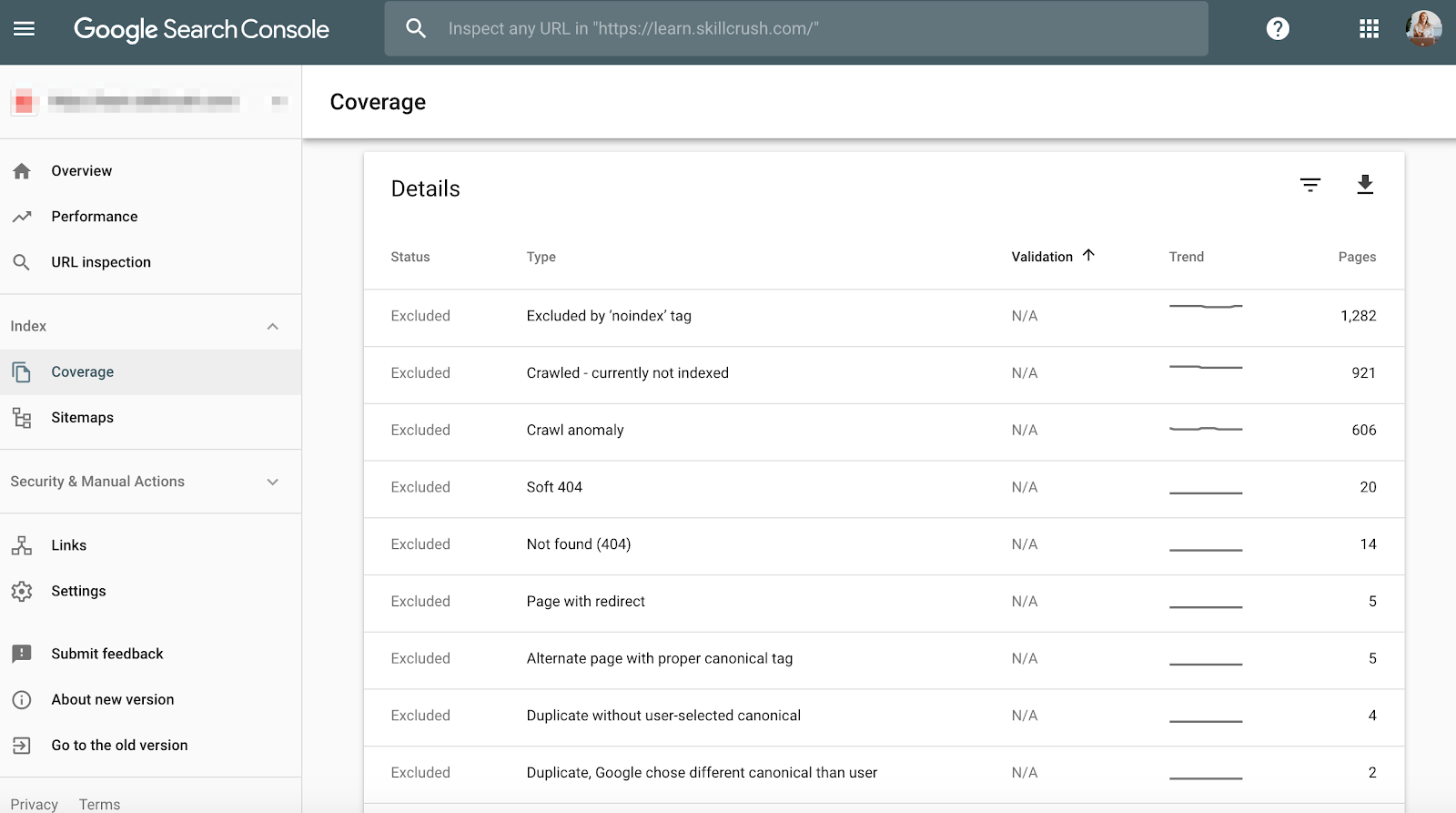

Crawl

クロールエラーはユーザーにとって悪いだけでなく、ウェブサイトのランキングにも悪いので、チェックが重要です。 また、ジョン・ミューラー氏は、クロール率が低いのは低品質なサイトのサインかもしれないと述べています。

広告Continue Reading BelowGoogle Search Consoleで確認するには、カバレッジ>詳細へ移動して確認できます。

Bingウェブマスターツールで確認するには、レポート & データ > クロール情報 に移動してください。

修正方法:

- クロールエラーを手動で確認して、もう存在しない古い製品からのクロールエラーかどうか、または、ロボットで禁止されるべきクロールエラーが表示されているかどうか判断してください。

- どこから来ているのかを判断したら、死んだページにリンクする類似のページへの301リダイレクトを実装します。

- また、Google Search Consoleのクロール統計とGoogle Analyticsの平均ロード時間をクロスチェックして、ダウンロードにかかった時間と1日あたりのクロールされたページの間に相関関係があるかどうかを確認したいと思います。

Structured Data

Screaming Frogのスキーマの項で述べたように、Google Search Consoleでクライアントのスキーママークアップを確認できます。

Googleサーチコンソールで個々のリッチリザルトステータスレポートを使用する。 (注:構造化データレポートは廃止されました)

AdvertisementContinue Reading Belowこれにより、この先修正する必要がある構造化データエラーがあるページを判断することができるようになります。

修正方法:

- Google Search Console は、ライブ版をテストすると、スキーマに何が欠けているかを教えてくれます。

- エラー コードに基づいて、テキスト エディタでスキーマを書き直し、Web 開発チームに送信して更新してもらいます。 私はテキスト編集に Sublime Text を使用しています。 Macユーザーは1つが内蔵されており、PCユーザーはGoogleが購入したYouTubeを使用できます。

Step 3: Review Google Analytics

Tools:

- Google Analytics.

- Google Tag Manager Assistant Chrome Extension.を使用して、Google Analyticsを確認します。

- Annie Cushing Campaign Tagging Guide.

ビュー

新しいクライアントを最初に得たとき、私はGoogle Analyticsで3種類のビューを設定します。

- Reporting view.

- Master view.

- Test view.

- Master view.Testビューを設定します。

これらの異なるビューは、データに影響を与えずに変更を加える柔軟性を与えてくれます。

修正方法:

- Google Analytics で、管理 > ビュー > ビュー設定 に移動して上記の3つのビューを作成します。

- ボットやスパイダーからのヒットをすべて除外するために、ボットフィルタリングの項目に必ずチェックを入れます。

- Google広告とGoogle Search Consoleをリンクします。

- 最後に、サイト検索トラッキングがオンになっていることを確認します。

フィルター

誤ったトラフィックを取得しないように、Google Analyticsのフィルターに自分のIPアドレスとクライアントのIPアドレスを追加するようにしたいです。

AdvertisementContinue Reading Below修正方法:

- 管理>表示>フィルター

- に移動し、設定は、等しいIPアドレス>からの>アクセスを除外するようにする必要があります。

Tracking Code

Tracking Code

ソースコードを手動で確認するか、上記の私のScreaming Frog手法を利用することが可能です。

コードがある場合、それがリアルタイムで機能していることを追跡します。

- これを確認するには、クライアントの Web サイトに行き、サイト上で少しクリックします。

- それから Google Analytics > リアルタイム > ロケーションに行くと、場所が入力されます。

- Googleタグマネージャを使用している場合、GoogleタグアシスタントChrome拡張機能でも確認できます。

修正方法:

- コードが発射されていない場合は、コードスニペットをチェックして正しいものであるかを確認したいものです。 複数のサイトを管理している場合、別のサイトのコードを追加している可能性があります。

- コードをコピーする前に、ワープロではなくテキスト エディターを使用してスニペットを Web サイトにコピーしてください。 これは余分な文字や空白の原因となります。

- 関数は大文字と小文字を区別するので、コード内ですべてが小文字であることを確認します。

インデックス作成

Googleサーチコンソールで遊ぶ機会があったなら、おそらく「カバレッジ」のセクションに気づいたでしょう。

私はクライアントを監査するとき、GoogleサーチコンソールでのインデックスをGoogle Analyticsと比較して確認するつもりです。 以下はその方法です。

- Googleサーチコンソールでは、「カバレッジ」

- Googleアナリティクスでは、「獲得」 > チャネル > オーガニック検索 > ランディングページ」へと進みます。

- ここまで来たら、詳細 > Site Usage > Sessions > 9.ランディングページに移動します。

AdvertisementContinue Reading Below修正方法:

- Google Search Consoleからの数値とGoogle Analyticsからの数値を比較して、もし大きく異なる場合は、インデックスされていても一部のページだけがオーガニックトラフィックを得ていると判断します。

キャンペーンタグ

最後にGoogleアナリティクスで確認したいのは、クライアントがキャンペーンタグを正しく使用しているかということです。 キャンペーンタギングを忘れたために、自分の仕事が評価されないのは困ります。

修正方法:

- Googleアナリティクスのキャンペーンタギング戦略を設定し、クライアントと共有することです。 Annie Cushingが素晴らしいキャンペーンタギングガイドをまとめました。

キーワード

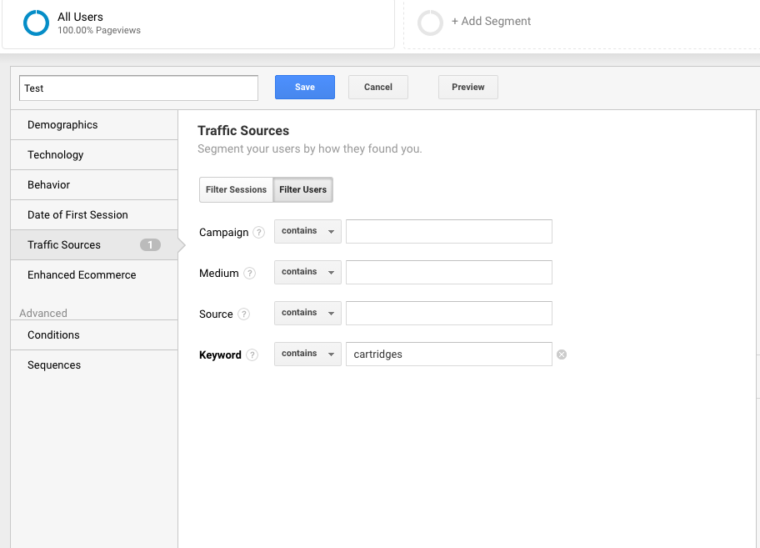

Googleアナリティクスを使用すると、クライアントの潜在的なキーワードを把握することができます。 Google Analytics でキーワードを見つけるには、次の手順に従います。

Google Analytics > Behavior > Site Search > Search Terms に移動します。 これで、顧客がウェブサイトで何を検索しているかがわかります。

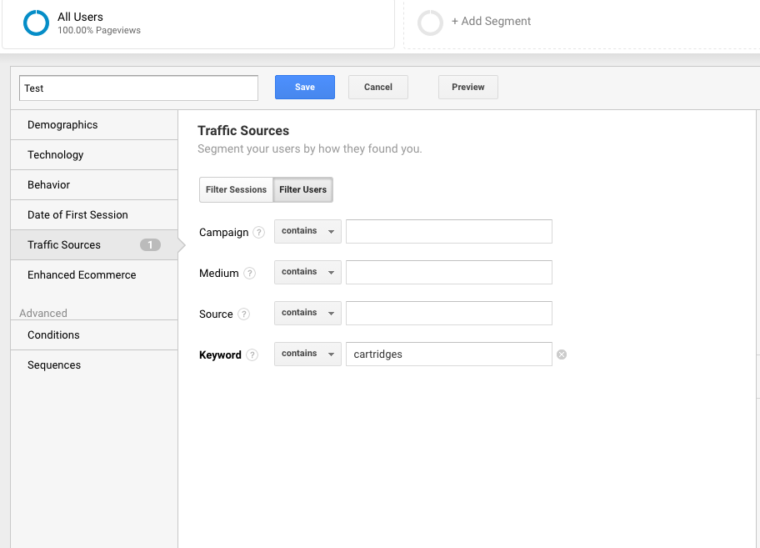

次に、これらの検索キーワードを使ってGoogle Analyticsで新しいセグメントを作成して、サイト内のどのページがすでにその特定のキーワードでランキングされているか確認することにします。

ステップ4:手動チェック

ツール:

AdvertisementContinue Reading below- Google Analytics.NET.com(英語)

- Googleアナリティクス.NET.com(英語)

- クライアントのサーバーとホストへのアクセス。

- You Get Signal.

- Pingdom.

- PageSpeed Tools.

- Wayback Machine.

クライアントのサイトのいずれかのバージョンが検索可能

ウェブサイトの検索方法をすべてチェックします。 たとえば、

- http://annaisaunicorn.com

- https://annaisaunicorn.com

- http://www.annaisaunicorn.com

ハイランダーが言うように、「1つだけ」検索可能なウェブサイトが存在する可能性があります

修正する方法。

インデックス作成

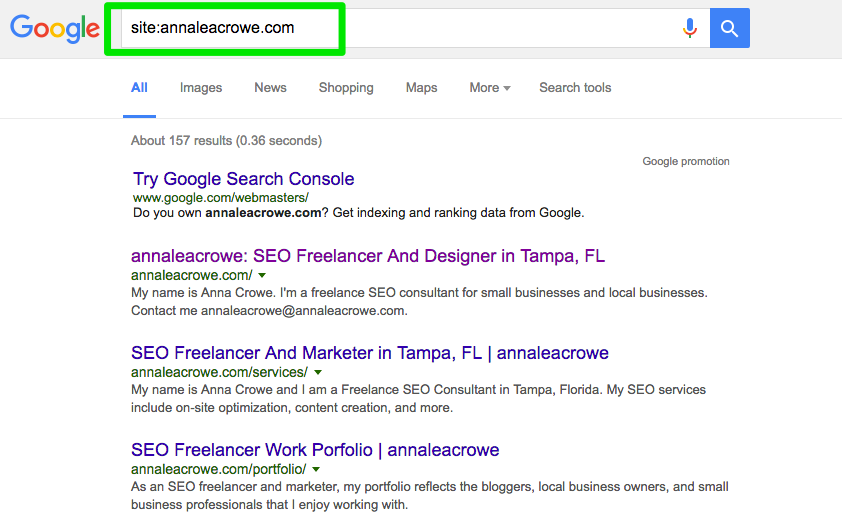

GoogleとBingで手動検索を行い、Googleにインデックスされているページの数を確認します。 この数字はGoogle AnalyticsやGoogle Search Consoleのデータで必ずしも正確ではありませんが、おおよその目安にはなるでしょう。

確認するには、以下を行います:

- 検索エンジンでサイト内検索を実行します。

- 検索したら、クライアントのブランドだけが表示されているか手動でスキャンする。

- ホームページが1ページ目にあるかどうか確認する。 ジョン・ミューラー氏は、ホームページが最初の結果として表示される必要はないと述べています。

修正方法:

- 別のブランドが検索結果に表示されている場合、より大きな問題があります。 これはまた、サイトがペナルティを持っているか、より大きなサイト再設計の問題である貧しいサイトアーキテクチャを持っていることを意味します。

- Googleアナリティクスで有機ランディングページの数をクロスチェックし、それが検索エンジンで見た検索結果の数と一致しているかどうかを確認します。 これは、検索エンジンがどのページを価値あるものとして見ているかを判断するのに役立ちます。

キャッシュ

上位ページがGoogleにキャッシュされているかどうか、簡単にチェックします。 Google はこれらのキャッシュされたページを使用して、コンテンツを検索クエリに結び付けます。

Googleがクライアントのページをキャッシュしているかどうかを確認するには、次のようにしてください:

http://webcache.googleusercontent.com/search?q=cache:https://www.searchenginejournal.com/pubcon-day-3-women-in-digital-amazon-analytics/176005/

必ずテキストのみのバージョンに切り替えてください。

Wayback Machineでも確認できます。

修正方法:

- クライアントのサーバがダウンしたり通常より遅い動作をしていないか確認する。 サーバーの内部エラーやデータベース接続に失敗している可能性があります。 複数のユーザーが一度にサーバーにアクセスしようとしている場合に発生する可能性があります。

- 逆引きIPアドレスチェックで、サーバーに他に誰がいるのか確認してください。 この段階は、You Get Signalのウェブサイトを利用できます。 このような場合、クライアントのサーバーをアップグレードするか、サーバーを共有している大雑把なドメインがある場合はCDNの使用を開始する必要があるかもしれません。

Hosting

これはいくつかのために少し専門的になるかもしれませんが、クライアントのウェブサイトに関連するホスティングソフトウェアを確認するためにあなたのSEO成功に不可欠です。 ホスティングはSEOに悪影響を及ぼし、せっかくの努力が水の泡になってしまいます。

問題があれば手動でチェックするために、クライアントのサーバーにアクセスする必要があります。 私が見る最も一般的なホスティングの問題は、間違ったTLDを持っていると遅いサイト速度です。

How to fix:

- あなたのクライアントが間違ったTLDを持っている場合、国のIPアドレスがあなたのクライアントが最も運営している国に関連付けられていることを確認する必要があります。 クライアントが.coドメインと.comドメインを持っている場合、.coを.comのクライアントの主要ドメインにリダイレクトします。

- クライアントのサイト速度が遅い場合、サイト速度はランキング要因なので、これに迅速に対処することをお勧めします。 PageSpeed ToolsやPingdomなどのツールを使って、何がサイトを遅くしているのかを見つけてください。 ここでは、一般的なページ速度の問題を見てみましょう:

- Host.

- 大きな画像

- 埋め込みビデオ

- プラグイン

- Ads.

- テーマ

- Widgets.

- 繰り返しのスクリプトまたは密集したコード

- Wedding.

- Ads.

- Thome.

- Them.

- Them.#362

Core Web Vitals Audit

Core Web Vitals は、ウェブサイトのユーザー体験を代表する 3 つの指標の集まりです。 Googleは2021年春にアルゴリズムを更新し、Core Web Vitalsをランキング要因として取り入れるため、これらは重要です。

ランキング要因は小さいと予想されますが、Core Web Vitalsのスコアを監査し、改善すべき領域を特定することは依然として重要です。

なぜコア ウェブ バイタルを監査に含めることが重要なのか

コア ウェブ バイタルのスコアを改善することは、検索ランキングに役立つだけでなく、おそらくより多くのコンバージョンと収益で報われる可能性があります。

スピードとページ パフォーマンスの向上は、売上、トラフィック、広告クリックの増加と関連しています。

ウェブ ホスティングをアップグレードして新しいプラグインをインストールすると、ページ速度は向上しますが、Core Web Vitals にはほとんど(もしあれば)影響を与えません。

測定は、誰かが文字通り携帯電話であなたのサイトをダウンロードしている時点で行われます。 同様に、解決策の多くは、テンプレート内のコードやコンテンツ管理システム自体のコア ファイルの変更を伴うため、ページ速度プラグインはほとんど役に立ちません。 しかし、ほとんどのソリューションは、コンテンツ管理システムのコア ファイルの更新や変更に慣れている開発者の支援を必要とします。 WordPress、Drupal、およびその他のコンテンツ管理システム (CMS) は、Core Web Vitals で良いスコアを出すように構築されていません。

コア Web Vitals を改善するプロセスは、WordPress およびその他の CMS のコアでのコーディングを変更することを含むことに注意することが重要です。

本質的に、Core Web Vitalsの改善には、開発者がテーマやCMSを作ったときに意図しなかったことをWebサイトにさせることが必要です。

コア Web バイタル監査の目的は、修正する必要があるものを特定し、その情報を開発者に渡して、開発者が必要な変更を行えるようにすることです。

コア Web バイタルは、ページの最も重要な部分の読み込み速度、ユーザーがページと対話できる速度 (例: ボタンをクリックする)、およびページ要素が移動せずに Web ページが安定するまでの速度の 3 つの指標から構成されています。

There are:

- Largest Contentful Paint (LCP).

- First Input Delay (FID).

- Cumulative Layout Shift (CLS).

- Cumulative Layout Shift (CLS).LCP (LCP) は、ページがロードされた後、ページ要素が移動することなく安定するまでの時間です。

コア Web バイタルには、2 種類のスコアがあります。

Lab Data

Lab dataは、Google Lighthouseを介してページを実行するとき、またはPageSpeed Insightsで生成されるものです。

Labデータはシミュレーションデバイスとインターネット接続を介して生成されたスコアで構成されています。

Field Data

Field Data は、Chrome User Experience Report (CrUX) のために Google Chrome ブラウザによって収集された、実際の Core Web Vitals スコアです。

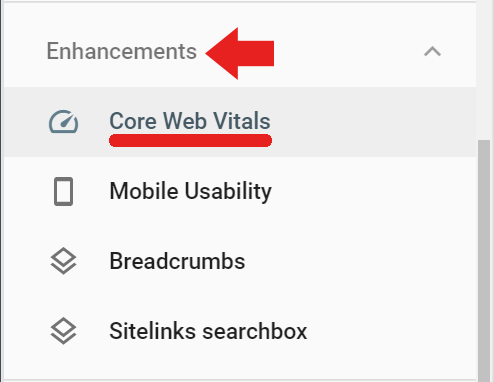

フィールド データは、Google Search Console の [強化] タブの [Core Web Vitals] というリンクから利用できます(フィールド データもこのリンクからアクセス可能です)https://search.google.com/search-console/core-web-vitals。

Googleサーチコンソールで報告されるフィールドデータは、最低限の訪問と測定があった訪問済みページから取得されます。 Googleが十分なスコアを受け取っていない場合、Google Search Consoleはそのスコアを報告しません。

Screaming Frog for Core Web Vitals Audit

Screaming Frog バージョン 14.2 では Core Web Vitals評価のパスまたはフェイルを表示できる機能を備えています。 Screaming FrogをPageSpeed Insights API(APIキーはこちらから取得)にキーで接続する必要があります。

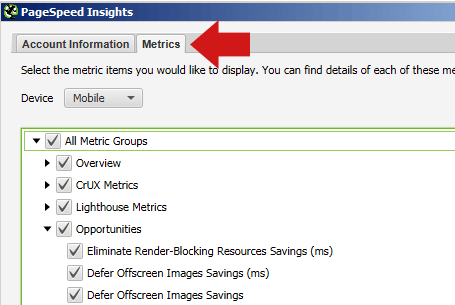

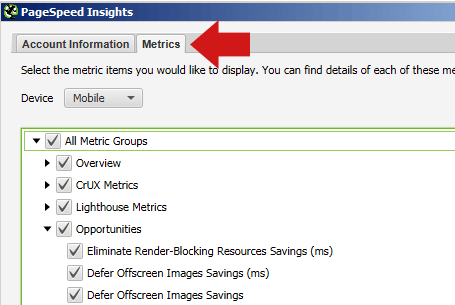

Page Speed Insights APIキーをScreaming Frogに登録するには、まず設定 > APIアクセス > PageSpeed Insights

に移動し、APIキーを入力してサービスに接続する場所が表示されます。

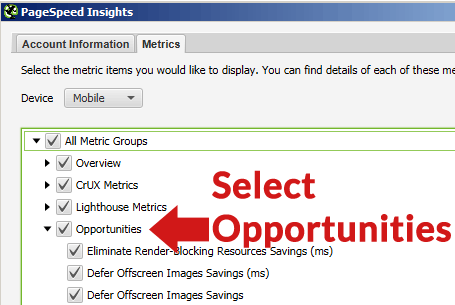

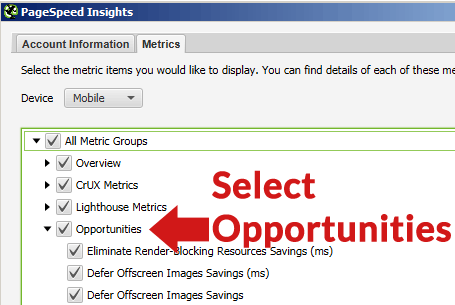

同じ PageSpeed Insights ポップアップで、メトリック タブを選択し、レポートさせたいメトリックを示すボックスにチェックを入れることもできます。

それはランキングの目的のために重要なメトリックなので、デバイスにモバイルを選択することを確認してください。

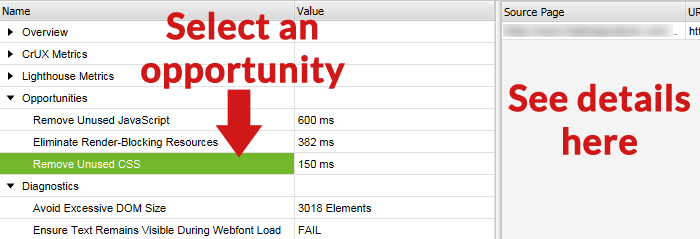

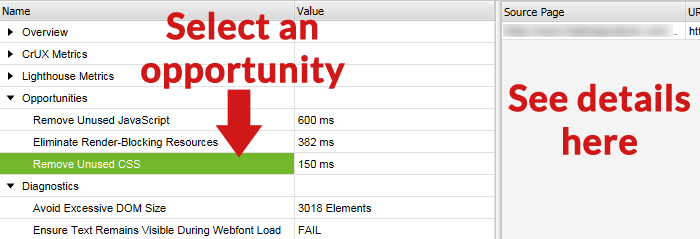

機会タブを選択すると、クロール後にさまざまな種類の改善(画面外の画像の遅延、使用しないCSSを削除するなど)一覧がScreaming Frogから表示されるようになります。

クロールする前の注意

一般に、サイト全体をクロールして、Webサイトのすべてのページで何が問題かをページごとに徹底的に説明する必要はないでしょう。

クロールする前に、代表的なページのセットをクロールすることを検討するとよいでしょう。 これを行うには、まず、Web サイトの各セクションまたはカテゴリに共通するページの種類を代表するページのグループを選択します。 スプレッドシート、テキスト ファイルのリストを作成するか、Screaming Frog のアップロード タブを使用して手動で URL を貼り付けます。

ほとんどのサイトには、類似したページ構造とコンテンツで作成されたページと投稿が含まれていました。 たとえば、「ニュース」カテゴリのすべてのページはかなり類似しており、「レビュー」カテゴリのページも互いに類似しています。

個々のカテゴリに共通する問題と、サイト全体のすべてのページに共通する修正が必要な問題を識別するために、代表的なページのグループをクロールすることで時間を節約することができます。 どのような種類の問題がそれぞれのセクションに固有であるかを特定するために、各タイプのカテゴリからほんの一握りの代表的なページをクロールする必要があるに過ぎないかもしれません。

修正されるのは、通常、サイト全体に共通する問題で、すべてのページから読み込まれる未使用の CSS や、Web ページの左側の領域にある広告ユニットによる累積レイアウト シフトなどです。

最近の Web サイトはテンプレート化されているので、修正はテンプレート レベルで行われるか、スタイル シートなどでカスタム コード化されます。

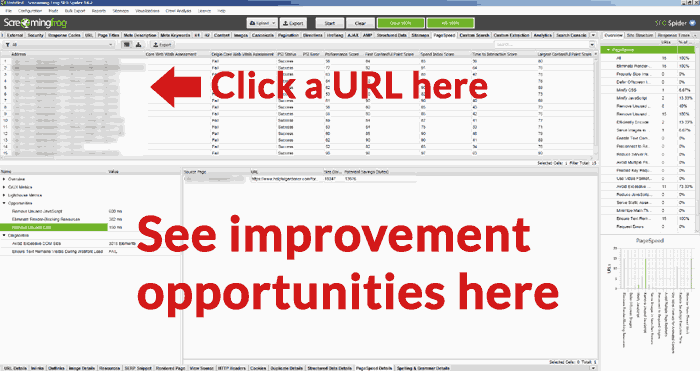

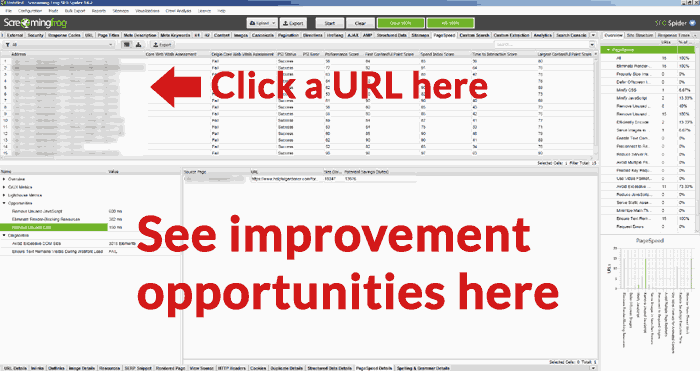

Screaming Frog でサイトをクロールする

いったん URL を完全にクロールしたら、PageSpeed タブをクリックしてすべての勧告を読み、各種メトリックの合否の表記を見ることができます。

Zoom In on URL Opportunities

Screaming Frog Core Web Vitals Auditの便利な機能は、上部ペインのURL一覧からURLを選択し、Screaming Frog表示画面の下部ペインで改善の機会を見ることができる点です。

下の画面は、機会を選択すると右ペインにその改善の機会の詳細が表示されるものです。

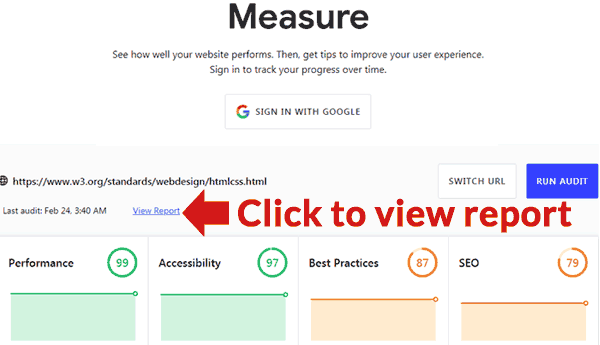

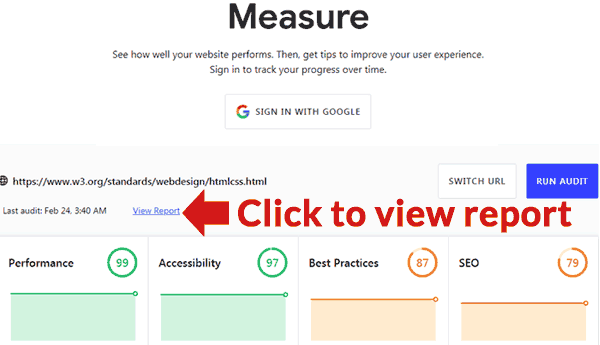

Google公式ツール

Googleが監査を提供できるツールを公表しています。 場所はここです。 https://web.dev/measure/

ページのパフォーマンスの概要を確認するURLを挿入してください。 ログインしている場合は、Google がそのページを長期にわたって追跡します。 レポートを見る」リンクをクリックすると、何が問題なのかを詳細に説明したレポートと、各問題を修正する方法を示すガイドへのリンクが含まれた新しいページが開きます。