Ik zal er niet om liegen: Het uitvoeren van een diepgaande SEO-audit is een hele klus.

En als SEO-consultant zijn er maar weinig mooiere woorden dan: “Uw audit ziet er goed uit! Wanneer kunnen we je aan boord halen?”

Zelfs als je niet actief op zoek bent geweest naar een nieuwe klus, is de wetenschap dat je SEO-audit de spijker op z’n kop heeft geslagen een enorme ego-boost.

Maar, ben je doodsbang om te beginnen? Is dit uw eerste SEO-audit? Of weet je gewoon niet waar je moet beginnen?

Door een fantastische SEO-audit naar een potentiële klant te sturen, zet je jezelf op de best mogelijke plaats.

Neem dus je tijd. Vergeet niet: Je primaire doel is om waarde toe te voegen aan je klant met je site-aanbevelingen voor zowel de korte als de lange termijn.

In deze column heb ik de need-to-know stappen voor het uitvoeren van een SEO-audit en een beetje inzicht in de eerste fase van mijn processen samengebracht wanneer ik voor het eerst een nieuwe klant krijg. Het is opgesplitst in secties hieronder. Als u het gevoel heeft dat u een bepaalde sectie goed onder de knie heeft, voel u dan vrij om naar de volgende sectie te springen.

Wanneer moet ik een SEO audit uitvoeren?

Nadat een potentiële klant mij een e-mail stuurt waarin hij interesse toont in samenwerking en mijn enquête beantwoordt, plannen we een introgesprek (Skype of Google Hangouts heeft de voorkeur).

Voordat het gesprek plaatsvindt, doe ik mijn eigen mini snelle SEO audit (ik investeer minstens een uur om handmatig onderzoek te doen) op basis van hun antwoorden op de enquête om vertrouwd te raken met hun marktlandschap. Het is alsof je iemand date die je nog nooit hebt ontmoet.

Je gaat ze natuurlijk stalken op Facebook, Twitter, Instagram en alle andere kanalen die openbaar zijn #soIcreep.

Hier is een voorbeeld van hoe mijn enquête eruitziet:

Hier zijn enkele belangrijke vragen die je de klant wilt stellen tijdens de eerste ontmoeting:

- Wat zijn uw algemene zakelijke doelen? Wat zijn uw kanaaldoelstellingen (PR, sociaal, etc.)?

- Wie is uw doelgroep?

- Heeft u zakelijke partnerschappen?

- Hoe vaak wordt de website bijgewerkt? Heeft u een web developer of een IT afdeling?

- Heeft u ooit eerder met een SEO consultant gewerkt? Of heeft u al eerder SEO werk laten doen?

Sujan Patel heeft ook een aantal goede aanbevelingen voor vragen die u aan een nieuwe SEO klant kunt stellen.

Na het gesprek, als ik het gevoel heb dat we een goede match zijn, stuur ik u mijn formele voorstel en contract (dank u HelloSign om dit een gemakkelijk proces voor mij te maken!

Om te beginnen, bied ik mijn klanten altijd graag de eerste maand als proefperiode om ervoor te zorgen dat we vibe.

Dit geeft zowel de klant en ik een kans om eerst vrienden te worden voordat dating. Tijdens deze maand neem ik de tijd om een diepgaande SEO-audit uit te voeren.

Deze SEO-audits kunnen me ergens tussen 40 uur en 60 uur kosten, afhankelijk van de grootte van de website. Deze audits worden onderverdeeld in drie afzonderlijke delen en gepresenteerd met Google Slides.

- Technisch: Crawl fouten, indexering, hosting, etc.

- Inhoud: Keyword onderzoek, concurrentie analyse, content maps, meta data, etc.

- Links: Backlink profiel analyse, groei tactieken, etc.

Na die eerste maand, als de klant mijn werk goed vindt, zullen we beginnen met de uitvoering van de aanbevelingen van de SEO-audit. En daarna voer ik maandelijks een mini-audit uit en elk kwartaal een grondige audit.

Om samen te vatten, ik voer een SEO-audit uit voor mijn klanten:

- Eerste maand.

- Maandelijks (mini-audit).

- Kwartaals (grondige audit).

Wat je nodig hebt van een klant voor een SEO Audit

Wanneer een klant en ik beginnen samen te werken, zal ik een Google Doc met hen te delen met het verzoek om een lijst van wachtwoorden en leveranciers.

Dit omvat:

- Google Analytics toegang en eventuele derde-partij analytische tools.

- Google en Bing advertenties.

- Webmaster tools.

- Toegang tot back-end website.

- Social media accounts.

- Lijst van leveranciers.

- Lijst van interne teamleden (inclusief werk dat zij uitbesteden).

Tools voor SEO Audit

Voordat u met uw SEO audit begint, volgt hier een overzicht van de tools die ik gebruik:

- Screaming Frog.

- Integrity (voor Mac-gebruikers) en Xenu Sleuth (voor PC-gebruikers).

- SEO Browser.

- Wayback Machine.

- Moz.

- BuzzSumo.

- DeepCrawl.

- Copyscape.

- Google Tag Manager.

- Google Tag Manager Chrome Extension.

- Annie Cushing’s Campaign Tagging Guide.

- Google Analytics (indien toegang gegeven).

- Google Search Console (indien toegang gegeven).

- Bing Webmaster Tools (indien toegang gegeven).

- You Get Signal.

- Pingdom.

- PageSpeed Tool.

- Sublime Text.

Uitvoeren van een Technische SEO Audit

Tools nodig voor technische SEO audit:

- Screaming Frog.

- DeepCrawl.

- Copyscape.

- Integrity voor Mac (of Xenu Sleuth voor PC-gebruikers).

- Google Analytics (indien toegang gegeven).

- Google Search Console (indien toegang gegeven).

- Bing Webmaster Tools (indien toegang gegeven).

Step 1: Site toevoegen aan DeepCrawl en Screaming Frog

Tools:

- DeepCrawl.

- Copyscape.

- Screaming Frog.

- Google Analytics.

- Integrity.

- Google Tag Manager.

- Google Analytics code.

What to Look for When Using DeepCrawl

Het eerste wat ik doe is de site van mijn klant toevoegen aan DeepCrawl. Afhankelijk van de grootte van de site van uw klant, kan het crawlen een dag of twee duren om de resultaten terug te krijgen.

Als u de DeepCrawl-resultaten eenmaal hebt, zoek ik naar de volgende dingen:

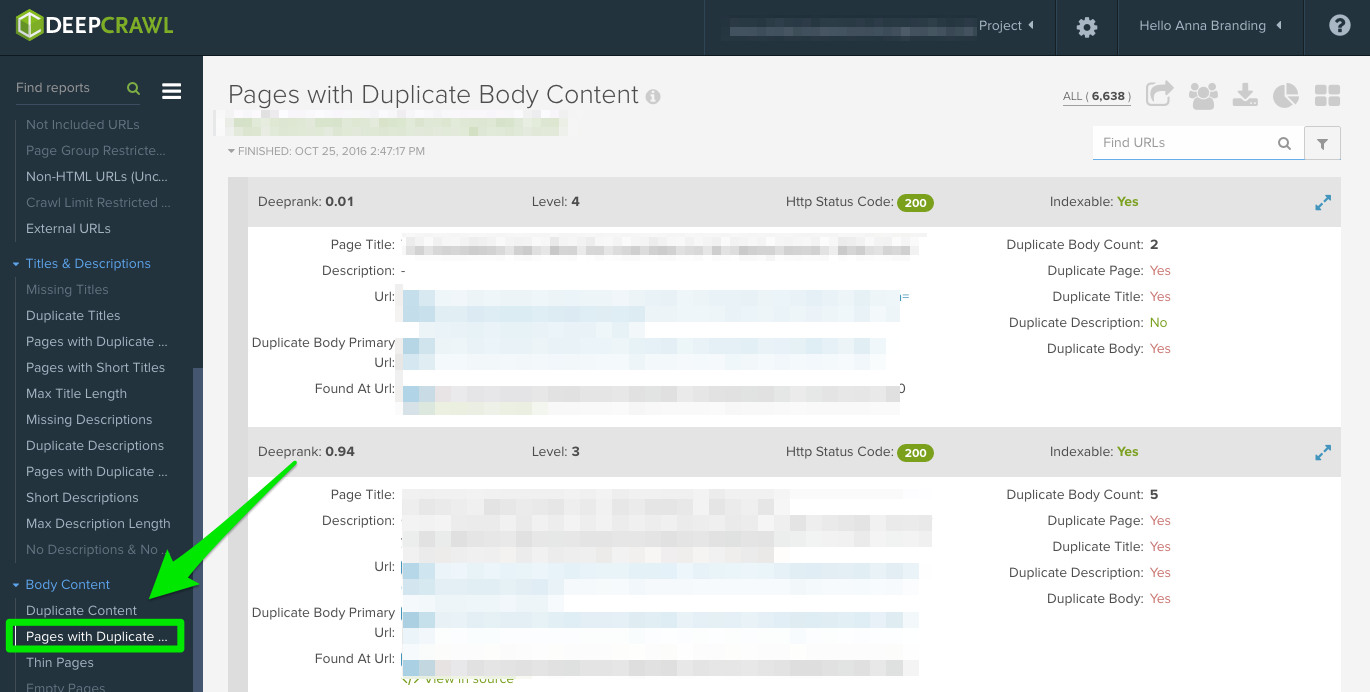

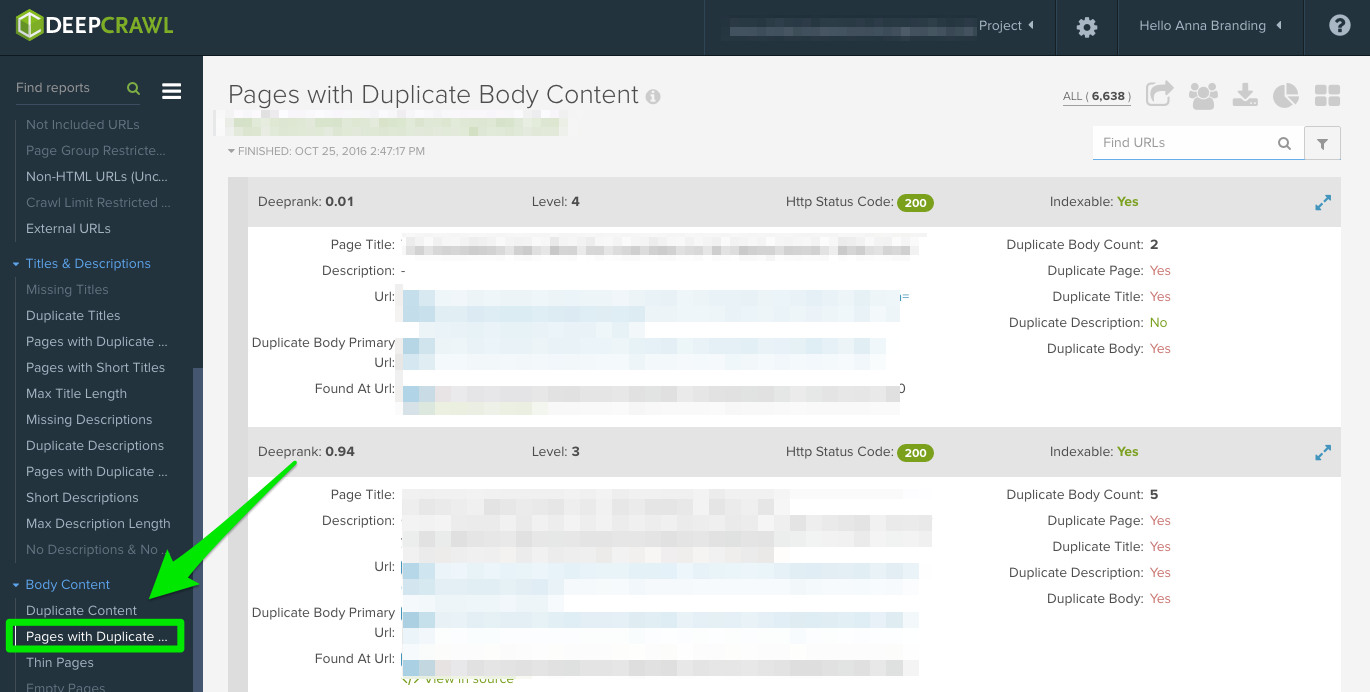

Duplicate content

Kijk naar het rapport “Duplicate Pages” om duplicate content te lokaliseren.

Als dubbele inhoud wordt geïdentificeerd, maak ik dit een topprioriteit in mijn aanbevelingen aan de klant om deze pagina’s te herschrijven, en in de tussentijd voeg ik de <meta name=”robots” content=”noindex, nofollow”> tag toe aan de dubbele pagina’s.

Gemeenschappelijke fouten met dubbele inhoud die u zult ontdekken:

- Duplicate meta titles en meta descriptions.

- Duplicate body content van tag pagina’s (ik zal Copyscape gebruiken om te helpen bepalen of iets wordt geplagieerd).

- Twee domeinen (ex: uwwebsite.co, uwwebsite.com).

- Subdomeinen (ex: jobs.uwwebsite.com).

- Gelijkaardige inhoud op een ander domein.

- Niet goed geïmplementeerde paginering pagina’s (zie hieronder.)

Hoe op te lossen:

- Voeg de canonical tag toe aan uw pagina’s om Google te laten weten wat u wilt dat uw voorkeurs-URL is.

- Sluit onjuiste URL’s uit in de robots.txt.

- Herschrijf content (inclusief body copy en metadata).

Hier volgt een voorbeeld van een duplicate content-probleem dat ik met een klant van me had. Zoals je hieronder kunt zien, hadden ze URL-parameters zonder de canonieke tag.

Dit zijn de stappen die ik heb genomen om het probleem op te lossen:

- Ik heb alle 301 redirect-problemen verholpen.

- Een canonieke tag toegevoegd aan de pagina die ik door Google wil laten crawlen.

- De parameterinstellingen van Google Search Console bijgewerkt om alle parameters uit te sluiten die geen unieke inhoud genereren.

- De disallow-functie toegevoegd aan de robots.txt naar de onjuiste URL’s om het crawlbudget te verbeteren.

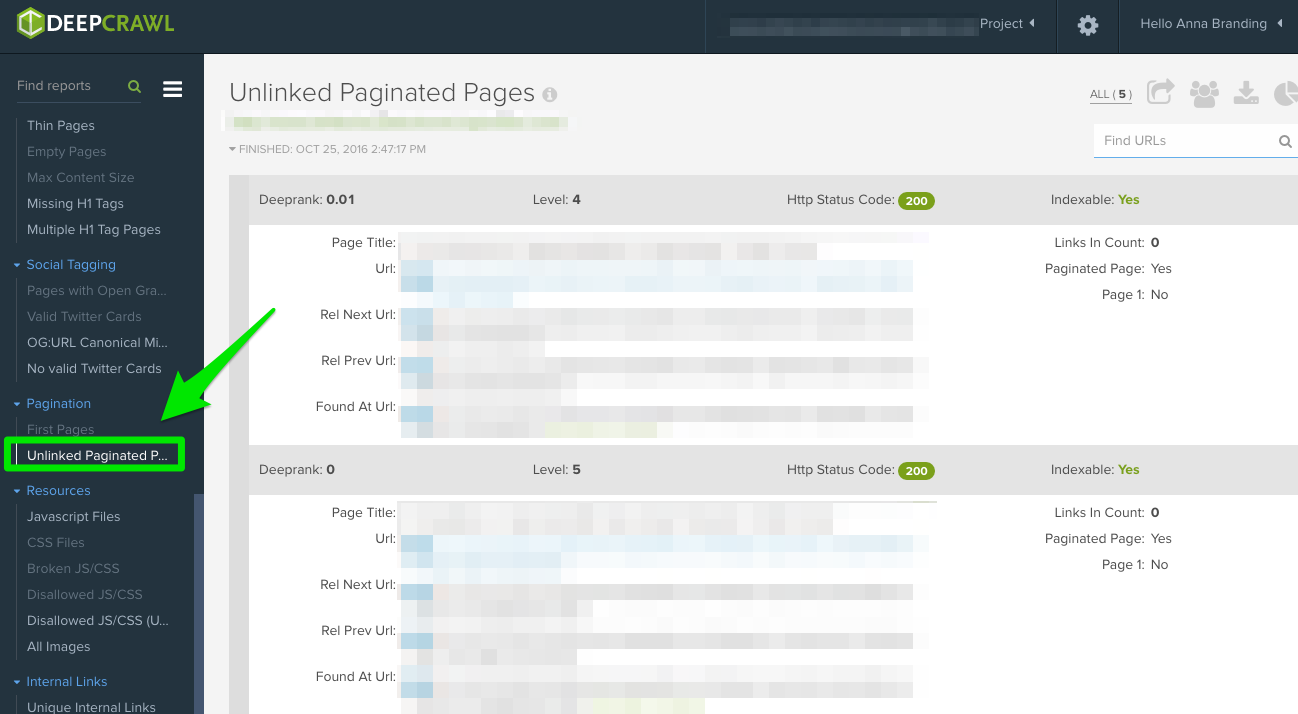

Paginatie

Er zijn twee rapporten om te controleren:

- Eerste pagina’s: Om te weten te komen welke pagina’s paginering gebruiken, bekijk het “Eerste Pagina’s” rapport. Vervolgens kunt u handmatig de pagina’s bekijken die dit gebruiken op de site om te ontdekken of paginatie correct is geïmplementeerd.

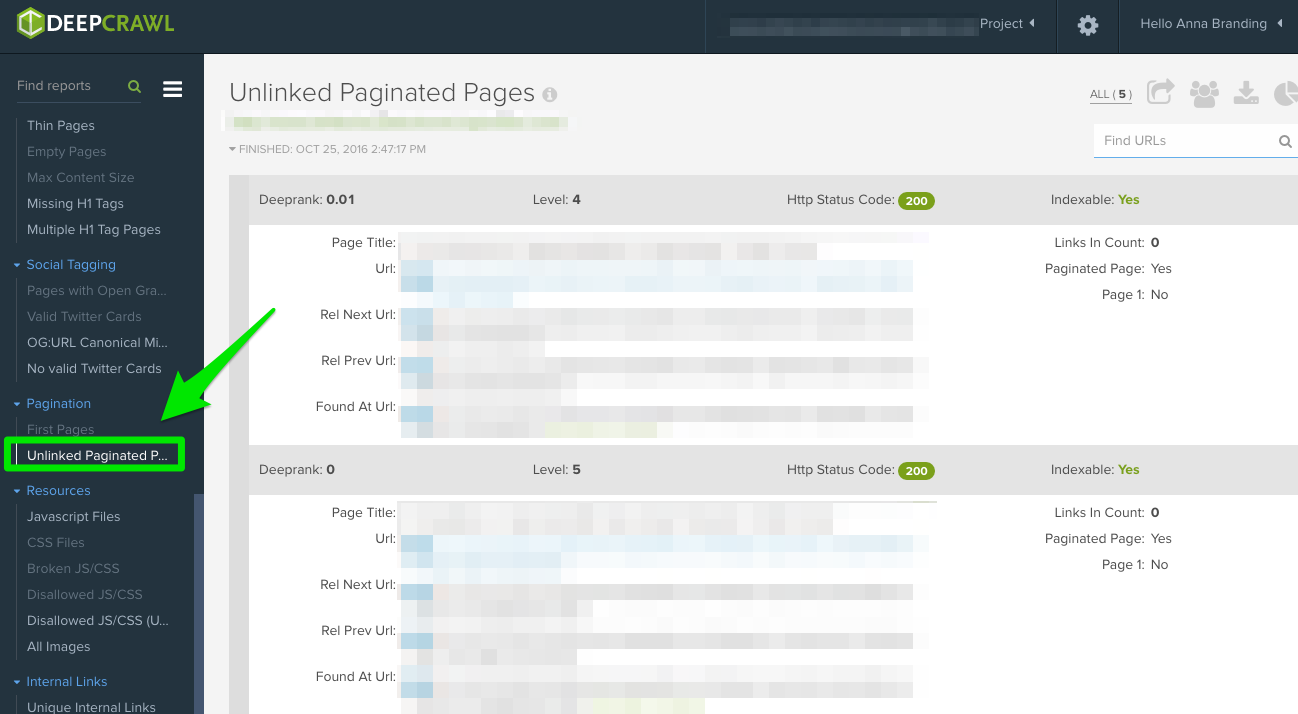

- Unlinked Pagination Pages: Om erachter te komen of paginering correct werkt, zal het “Unlinked Pagination Pages” rapport u vertellen of de rel=”next” en rel=”prev” linken naar de vorige en volgende pagina’s.

In het onderstaande voorbeeld kon ik met DeepCrawl vinden dat een klant wederzijdse paginatags had:

Hoe op te lossen:

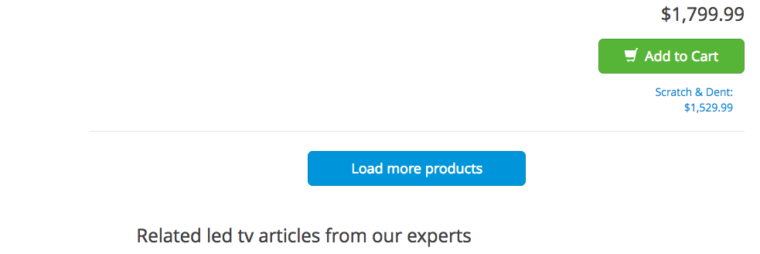

- Als u een “bekijk alles”- of een “laad meer”-pagina hebt, voegt u rel=”canonical” tag toe. Hier is een voorbeeld van Crutchfield:

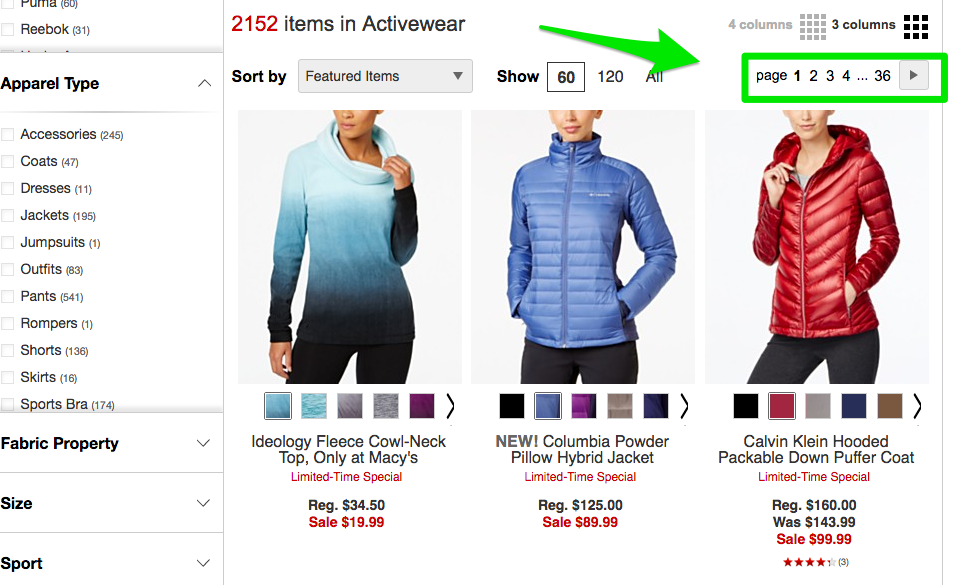

- Als al uw pagina’s op afzonderlijke pagina’s staan, voeg dan de standaard rel=”next” en rel=”prev” markup toe. Hier is een voorbeeld van Macy’s:

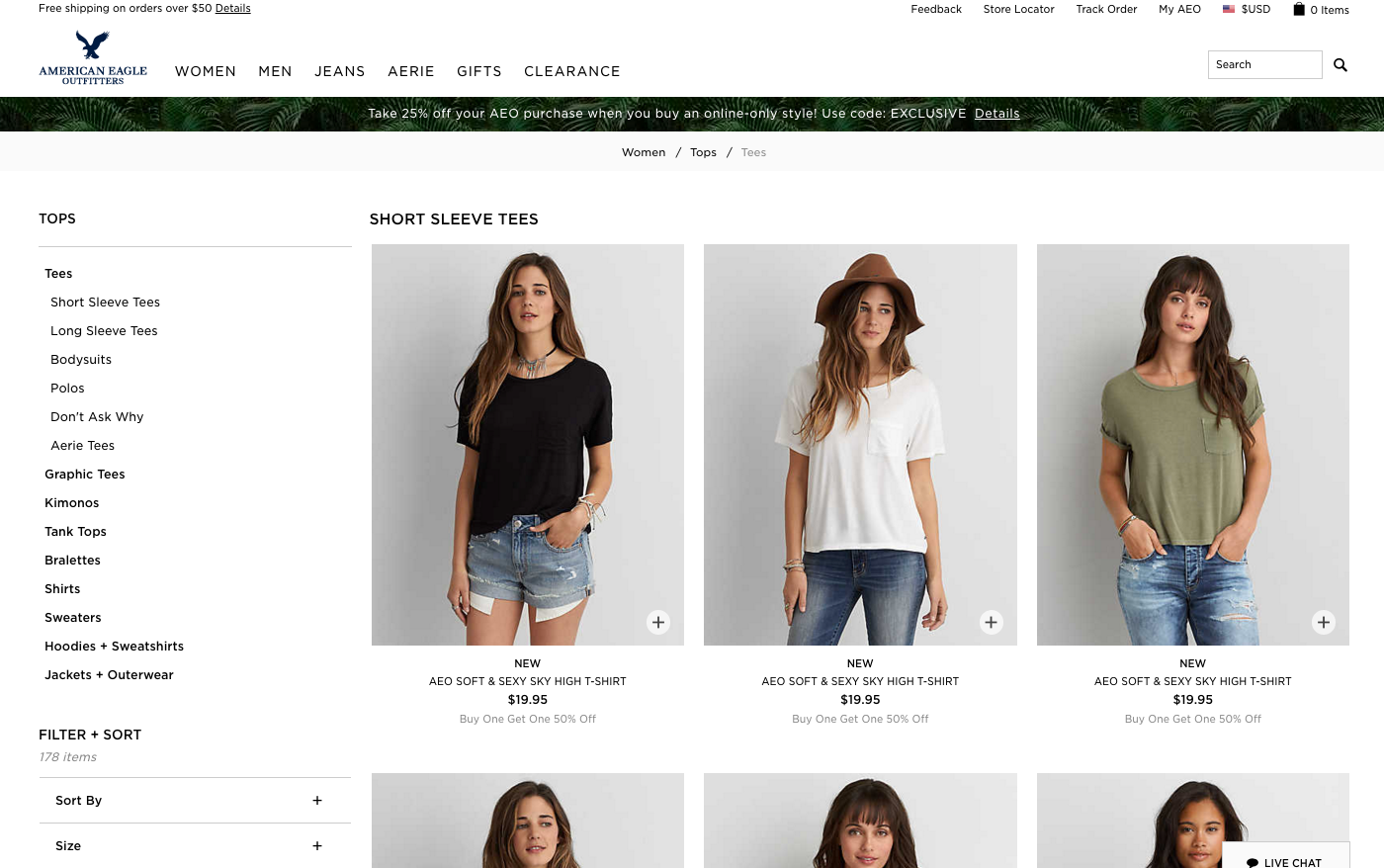

- Als u oneindig scrollen gebruikt, voegt u de URL van de gepagineerde pagina toe aan uw javascript. Hier is een voorbeeld van American Eagle.

Max Redirections

Bekijk het rapport “Max Redirections” om alle pagina’s te zien die meer dan 4 keer worden omgeleid. John Mueller vermeldde in 2015 dat Google kan stoppen met het volgen van omleidingen als het er meer dan vijf zijn.

Terwijl sommige mensen naar deze crawlfouten verwijzen als het opeten van het “crawlbudget”, verwijst Gary Illyes hiernaar als “hostbelasting”. Het is belangrijk om ervoor te zorgen dat uw pagina’s goed renderen, omdat u wilt dat uw hostbelasting efficiënt wordt gebruikt.

Hier volgt een kort overzicht van de responscodes die u kunt zien:

- 301 – Dit zijn de meerderheid van de codes die u tijdens uw onderzoek zult zien. 301 redirects zijn oke, zolang er slechts een redirect en geen redirect loop.

- 302 – Deze codes zijn oke, maar als ze langer dan 3 maanden of zo, zou ik handmatig wijzigen in 301s, zodat ze permanent zijn. Dit is een foutcode die ik vaak zie bij e-commerce sites als een product niet op voorraad is.

- 400 – Gebruikers kunnen de pagina niet bereiken.

- 403 – Gebruikers hebben geen toestemming om de pagina te openen.

- 404 – De pagina is niet gevonden (meestal betekent dit dat de klant een pagina heeft verwijderd zonder een 301-redirect).

- 500 – Interne serverfout die u moet verbinden met het webontwikkelingsteam om de oorzaak vast te stellen.

Hoe op te lossen:

- Verwijder alle interne links die naar oude 404-pagina’s wijzen en werk ze bij met de interne link van de omgeleide pagina.

- Ontbind de omleidingsketens door de middelste omleidingen te verwijderen. Bijvoorbeeld, als redirect A gaat naar redirect B, C, en D, dan zul je willen redirects B en C ongedaan te maken. Het uiteindelijke resultaat zal een redirect A naar D.

- Er is ook een manier om dit te doen in Screaming Frog en Google Search Console hieronder als je die versie gebruikt.

Wat te zoeken bij het gebruik van Screaming Frog

Het tweede wat ik doe wanneer ik een nieuwe klant site krijg is om hun URL toe te voegen aan Screaming Frog.

Afhankelijk van de grootte van de site van uw klant, kan ik de instellingen configureren om specifieke gebieden van de site te crawlen op een moment.

Hier is hoe mijn Screaming Frog spider configuraties eruit zien:

U kunt dit doen in uw spiderinstellingen of door gebieden van de site uit te sluiten.

Als u eenmaal de resultaten van Screaming Frog terug heeft, zijn dit de dingen waar ik naar zoek:

Google Analytics Code

Screaming Frog kan u helpen te identificeren welke pagina’s de Google Analytics code (UA-1234568-9) missen. Om de ontbrekende Google Analytics code te vinden, volgt u deze stappen:

- Ga naar Configuration in de navigatiebalk, dan Custom.

- Voeg analytics\.js toe aan Filter 1, verander dan de drop-down naar Does not contain.

Hoe op te lossen:

- Contacteer de ontwikkelaars van uw klant en vraag hen om de code toe te voegen aan de specifieke pagina’s waar deze ontbreekt.

- Voor meer informatie over Google Analytics, gaat u verder naar het Google Analytics-gedeelte hieronder.

Google Tag Manager

Screaming Frog kan u ook helpen te achterhalen welke pagina’s de Google Tag Manager snippet missen met vergelijkbare stappen:

- Ga naar het tabblad Configuratie in de navigatiebalk, dan Aangepast.

- Voeg <iframe src-“//www.googletagmanager.com/ met Does not contain geselecteerd in het Filter.

Hoe op te lossen:

- Ga naar Google Tag Manager om te zien of er fouten zijn en update waar nodig.

- Deel de code met de ontwikkelaars van uw klant om te zien of ze het weer aan de site kunnen toevoegen.

Schema

U zult ook willen controleren of de site van uw klant schema markup op hun site gebruikt. Schema of gestructureerde gegevens helpt zoekmachines begrijpen wat een pagina op de site is.

Om te controleren op schema markup in Screaming Frog, volg deze stappen:

- Ga naar het tabblad Configuratie in de navigatiebalk, dan Aangepast.

- Voeg itemtype=”http://schema.\.org/ met ‘Contain’ geselecteerd in de Filter.

Indexeren

Indexeren

U wilt bepalen hoeveel pagina’s er worden geïndexeerd voor uw klant, volg dit in Screaming Frog:

- Nadat uw site klaar is met laden in Screaming Frog, gaat u naar Directives > Filter > Index om te controleren of er ontbrekende stukken code zijn.

Hoe op te lossen:

- Als de site nieuw is, heeft Google hem misschien nog niet geïndexeerd.

- Controleer het robots.txt bestand om ervoor te zorgen dat u niet iets dat je wilt Google om te crawlen weigeren.

- Controleer om ervoor te zorgen dat u uw klant sitemap ingediend bij Google Search Console en Bing Webmaster Tools.

- Leidt handmatig onderzoek (zie hieronder).

Flash

Google kondigde in 2016 aan dat Chrome Flash zal gaan blokkeren vanwege de trage laadtijden van pagina’s. Dus, als je een audit doet, wil je identificeren of je nieuwe klant Flash gebruikt of niet.

Om dit in Screaming Frog te doen, probeer dit:

- Hoofd naar de Spider Configuratie in de navigatie.

- Klik op Controleer SWF.

- Filter het Interne tabblad door Flash nadat het crawlen klaar is.

Hoe op te lossen:

- Video’s van YouTube opnemen. Google kocht YouTube in 2006, no-brainer hier.

- Of, kiezen voor HTML5-standaarden bij het toevoegen van een video.

Hier is een voorbeeld van HTML5-code voor het toevoegen van een video:

<video controls="controls" width="320" height="240">> <source class="hiddenSpellError" data-mce-bogus="1" />src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.mp4" type="video/mp4"> <source src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.ogg" type="video/ogg" />Your browser does not support the video tag.</video>

JavaScript

Volgens de aankondiging van Google in 2015 is JavaScript prima te gebruiken voor uw website, zolang u niets blokkeert in uw robots.txt (we zullen hier zo meteen dieper op ingaan!). Maar u wilt nog steeds een kijkje nemen op de manier waarop het Javascript op uw site wordt afgeleverd.

Hoe op te lossen:

- Bekijk Javascript om er zeker van te zijn dat het niet wordt geblokkeerd door robots.txt

- Zorg ervoor dat Javascript op de server draait (dit helpt bij het produceren van platte tekst gegevens in plaats van dynamische).

- Als je Angular JavaScript gebruikt, bekijk dan dit artikel van Ben Oren over waarom het je SEO inspanningen zou kunnen doden.

- In Screaming Frog, ga naar de Spider Configuratie in de navigatiebalk en klik op Controleer JavaScript. Nadat het crawlen is voltooid, filtert u de resultaten op het tabblad Intern op JavaScript.

Robots.txt

Robots.txt

Wanneer u een robots.txt voor de eerste keer bekijkt, wilt u kijken of er iets belangrijks wordt geblokkeerd of afgekeurd.

Als u bijvoorbeeld deze code ziet:

User-agent: *Disallow: /

De website van uw klant wordt geblokkeerd voor alle webcrawlers.

Maar als u zoiets hebt als het robots.txt-bestand van Zappos, zou u goed moeten zijn om te gaan.

# Global robots.txt as of 2012-06-19User-agent: *Disallow: /bin/Disallow: /multiview/Disallow: /product/review/add/Disallow: /cartDisallow: /loginDisallow: /logoutDisallow: /registerDisallow: /account

Ze blokkeren alleen wat ze niet willen dat webcrawlers kunnen vinden. Deze inhoud die wordt geblokkeerd is niet relevant of nuttig voor de webcrawler.

Hoe op te lossen:

- Uw robots.txt is hoofdlettergevoelig dus werk deze bij zodat het allemaal kleine letters zijn.

- Verwijder alle pagina’s die vermeld staan als Disallow en die u wilt laten crawlen door de zoekmachines.

- Screaming Frog zal standaard geen URL’s kunnen laden die niet zijn toegestaan door robots.txt. Als u ervoor kiest om de standaard instellingen in Screaming Frog te wijzigen, zal het alle robots.txt negeren.

- U kunt ook geblokkeerde pagina’s bekijken in Screaming Frog onder de Response Codes tab, vervolgens gefilterd door Geblokkeerd door Robots.txt filter nadat u uw crawl heeft voltooid.

- Als u een site met meerdere subdomeinen, moet u een aparte robots.txt voor elk.

- Zorg ervoor dat de sitemap wordt vermeld in de robots.txt.

Crawl fouten

Ik gebruik DeepCrawl, Screaming Frog, en Google en Bing webmaster tools te vinden en cross-check van de crawl fouten van mijn klant.

Om uw crawl fouten in Screaming Frog te vinden, volg deze stappen:

- Nadat de crawl is voltooid, ga naar Bulk Reports.

- Scroll naar beneden naar Response Codes, exporteer dan het server-side error report en het client error report.

Hoe op te lossen:

- De client error rapporten, moet u in staat zijn om de meerderheid van de 404 fouten in de backend van de site zelf 301 redirect.

- De server foutrapporten, samen te werken met het development team om de oorzaak te bepalen. Voordat u deze fouten in de hoofddirectory herstelt, moet u een back-up van de site maken. Mogelijk moet u gewoon een nieuw .html toegangsbestand maken of de geheugenlimiet van PHP verhogen.

- U wilt ook al deze permanente omleidingen verwijderen uit de sitemap en alle interne of externe links.

- U kunt ook 404 in uw URL gebruiken om te helpen bijhouden in Google Analytics.

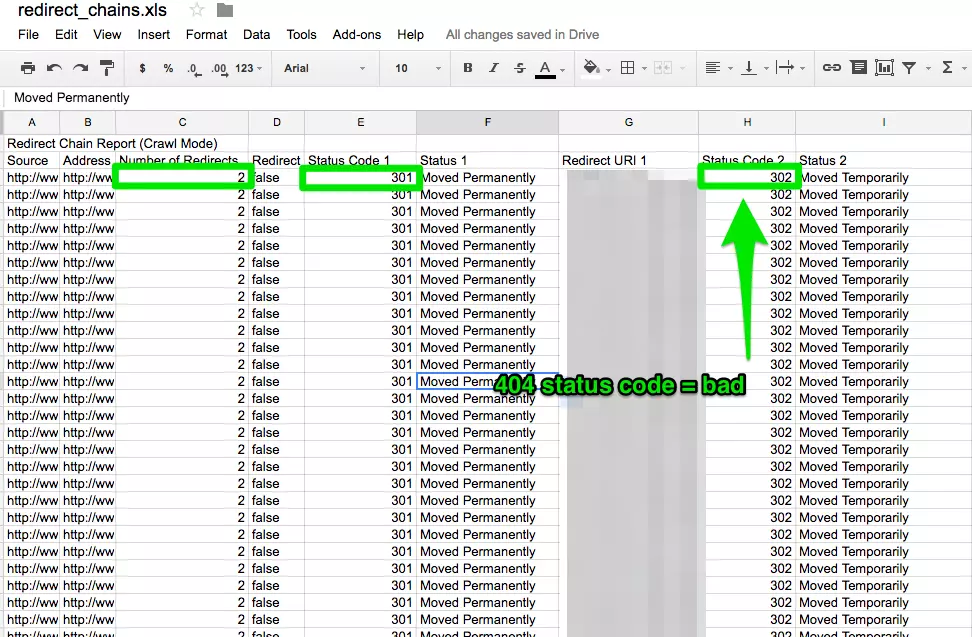

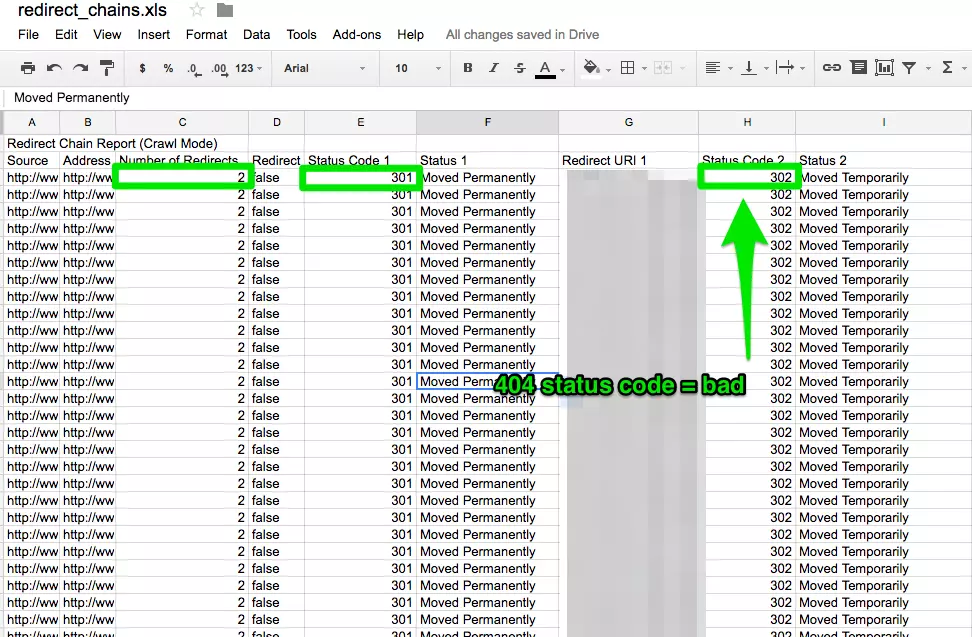

Redirect Ketens

Redirect ketens veroorzaken niet alleen een slechte gebruikerservaring, maar het vertraagt de snelheid van de pagina, de conversie daalt, en alle link liefde die u eerder kan hebben ontvangen is verloren gegaan.

Het verhelpen van redirectketens is een snelle overwinning voor elk bedrijf.

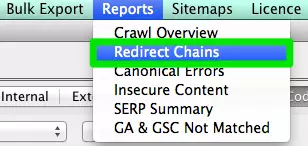

Hoe te verhelpen:

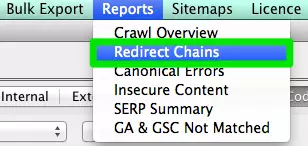

- In Screaming Frog gaat u nadat u uw crawl hebt voltooid naar Rapporten > Redirect Chains om het crawlpad van uw redirects te bekijken. In een excel spreadsheet, kunt u bijhouden om ervoor te zorgen dat uw 301 redirects 301 redirects blijven. Als u een 404-fout ziet, wilt u deze opruimen.

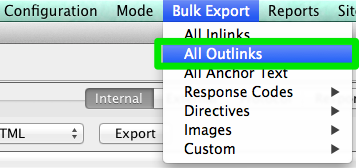

Interne &Externe links

Wanneer een gebruiker op een link naar uw site klikt en een 404-foutmelding krijgt, is dat geen goede gebruikerservaring.

En de zoekmachines worden er ook niet beter van.

Om mijn kapotte interne en externe links te vinden, gebruik ik Integrity for Mac. Je kunt ook Xenu Sleuth gebruiken als je een PC-gebruiker bent.

Ik zal je ook laten zien hoe je deze interne en externe links kunt vinden in Screaming Frog en DeepCrawl als je die software gebruikt.

Hoe op te lossen:

- Als je Integrity of Xenu Sleuth gebruikt, voer dan de URL van de site van je klant uit en je krijgt een volledige lijst met kapotte URL’s. Je kunt deze zelf handmatig bijwerken of als je met een dev team werkt, vraag hen om hulp.

- Als je Screaming Frog gebruikt, ga dan nadat het crawlen is voltooid naar Bulk Export in de navigatiebalk, dan naar Alle Outlinks. U kunt sorteren op URL’s en zien welke pagina’s een 404-signaal verzenden. Herhaal dezelfde stap met Alle Inlinks.

- Als u DeepCrawl gebruikt, gaat u naar het tabblad Unique Broken Links onder het gedeelte Internal Links.

URLs

Ledere keer dat u een nieuwe klant aanneemt, wilt u hun URL-indeling bekijken. Waar moet ik op letten in de URL’s?

- Parameters – Als de URL vreemde tekens heeft zoals ?, =, of +, dan is het een dynamische URL die dubbele inhoud kan veroorzaken als hij niet geoptimaliseerd is.

- Gebruiksvriendelijk – Ik hou ervan om de URL’s kort en eenvoudig te houden en verwijder ook eventuele extra slashes.

Hoe op te lossen:

- U kunt zoeken naar parameter URL’s in Google door te doen site:www.buyaunicorn.com/ inurl: “?” of wat je ook denkt dat de parameter zou kunnen bevatten.

- Nadat je de crawl op Screaming Frog hebt uitgevoerd, kijk dan eens naar de URLs. Als u parameters ziet die duplicaten van uw inhoud creëren, moet u het volgende voorstellen:

- Voeg een canonieke tag toe aan de hoofd URL-pagina. Bijvoorbeeld, www.buyaunicorn.com/magical-headbands is de hoofdpagina en ik zie www.buyaunicorn.com/magical-headbands/?dir=mode123$, dan zou de canonieke tag moeten worden toegevoegd aan www.buyaunicorn.com/magical-headbands.

- Update uw parameters in Google Search Console onder Crawl > URL Parameters.

- Wijs de dubbele URL’s toe in de robots.txt.

Stap 2: Controleer Google Search Console en Bing Webmaster Tools.

Tools:

- Google Search Console.

- Bing Webmaster Tools.

- Sublime Text (of een ander tekstverwerkingsprogramma).

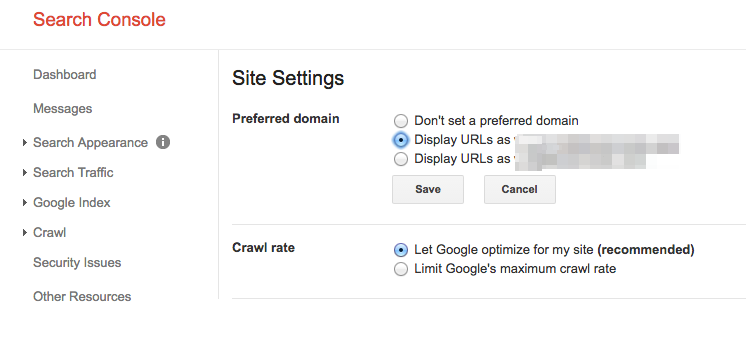

Stel een voorkeursdomein

Sinds de Panda update, is het gunstig om aan de zoekmachines het voorkeursdomein te verduidelijken. Het helpt ook om ervoor te zorgen dat al uw links één site extra liefde geven in plaats van verspreid te zijn over twee sites.

Hoe te verhelpen:

- In Google Search Console, klik op het tandwielpictogram in de rechterbovenhoek.

- Kies welke van de URL’s het voorkeursdomein is.

- U hoeft het voorkeursdomein niet in te stellen in Bing Webmaster Tools. U hoeft alleen uw sitemap in te dienen om Bing te helpen uw voorkeursdomein te bepalen.

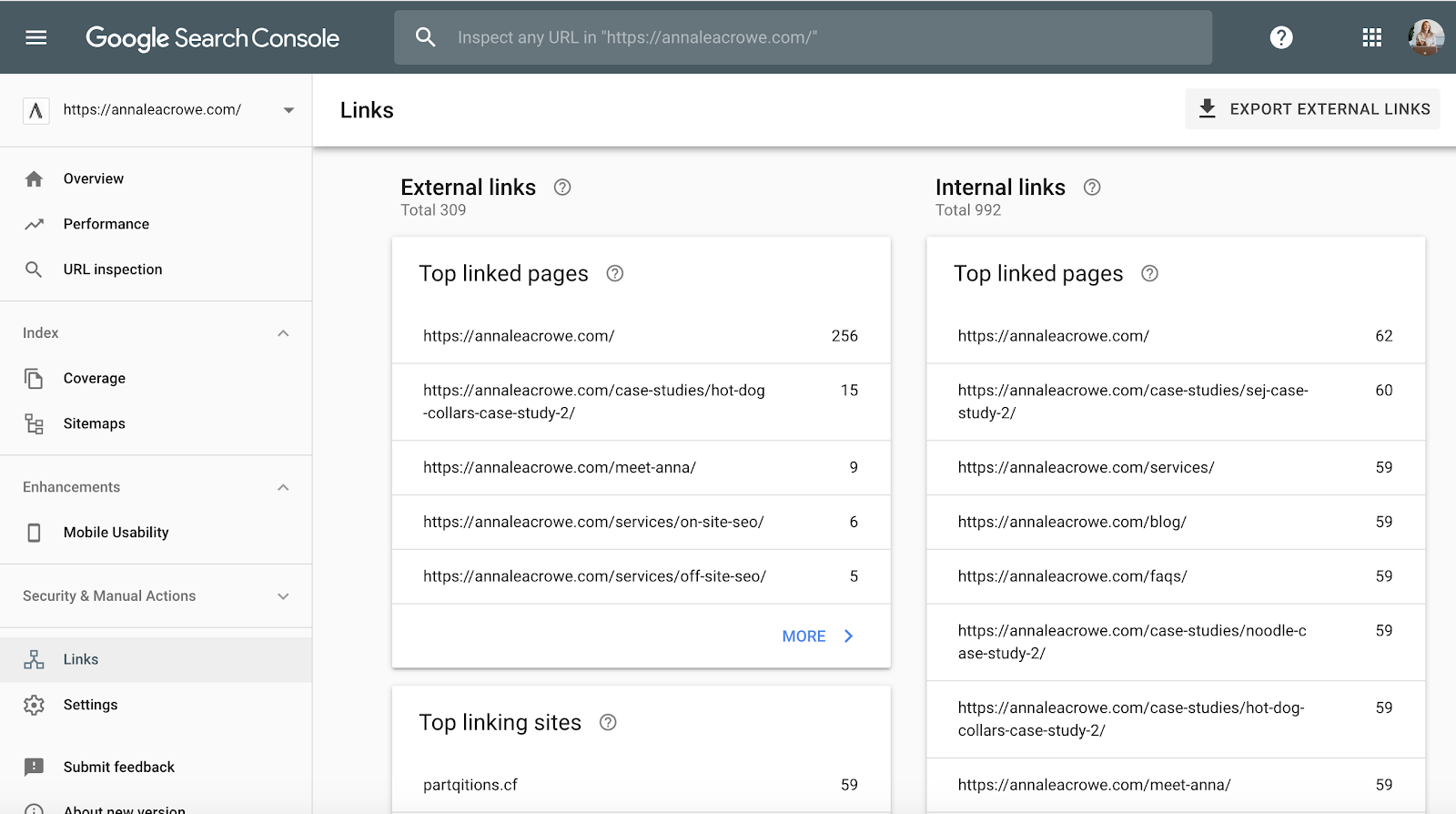

Backlinks

Nu Penguin is aangekondigd, is het van vitaal belang dat de backlinks van uw klant voldoen aan de normen van Google.

Als u een grote hoeveelheid backlinks ziet die vanaf één pagina op een website naar de site van uw klant komen, wilt u de nodige stappen ondernemen om dit op te ruimen, en SNEL!

Hoe op te ruimen:

- In Google Search Console gaat u naar Links > en sorteert u vervolgens uw Top linking sites.

- Contacteer de bedrijven die vanaf één pagina naar u linken en laat ze de links verwijderen.

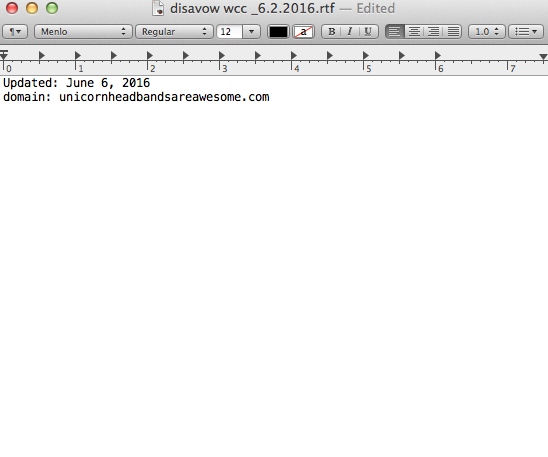

- Of voeg ze toe aan uw disavow-lijst. Wanneer u bedrijven aan uw disavow-lijst toevoegt, wees dan heel voorzichtig hoe en waarom u dit doet. U wilt geen waardevolle links verwijderen.

Hier volgt een voorbeeld van hoe mijn disavow-bestand eruitziet:

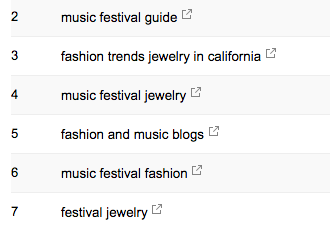

Keywords

Keywords

Als SEO-consultant is het mijn taak om te beginnen met het leren kennen van het marktlandschap van mijn klant. Ik moet weten wie hun doelgroep is, waar ze naar zoeken en hoe ze zoeken. Om te beginnen kijk ik naar de zoektermen waar ze al verkeer van krijgen.

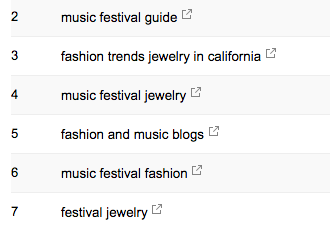

- In Google Search Console, onder Search Traffic > Search Analytics kunt u zien op welke zoekwoorden uw klant al klikken krijgt.

Sitemap

Sitemap

Sitemaps zijn essentieel om zoekmachines de website van uw klant te laten crawlen. Het spreekt hun taal. Bij het maken van sitemaps zijn er een paar dingen die u moet weten:

- Neem geen parameter-URL’s op in uw sitemap.

- Neem geen niet-indexeerbare pagina’s op.

- Als de site verschillende subdomeinen heeft voor mobiel en desktop, voeg dan de rel=”alternate” tag toe aan de sitemap.

Hoe op te lossen:

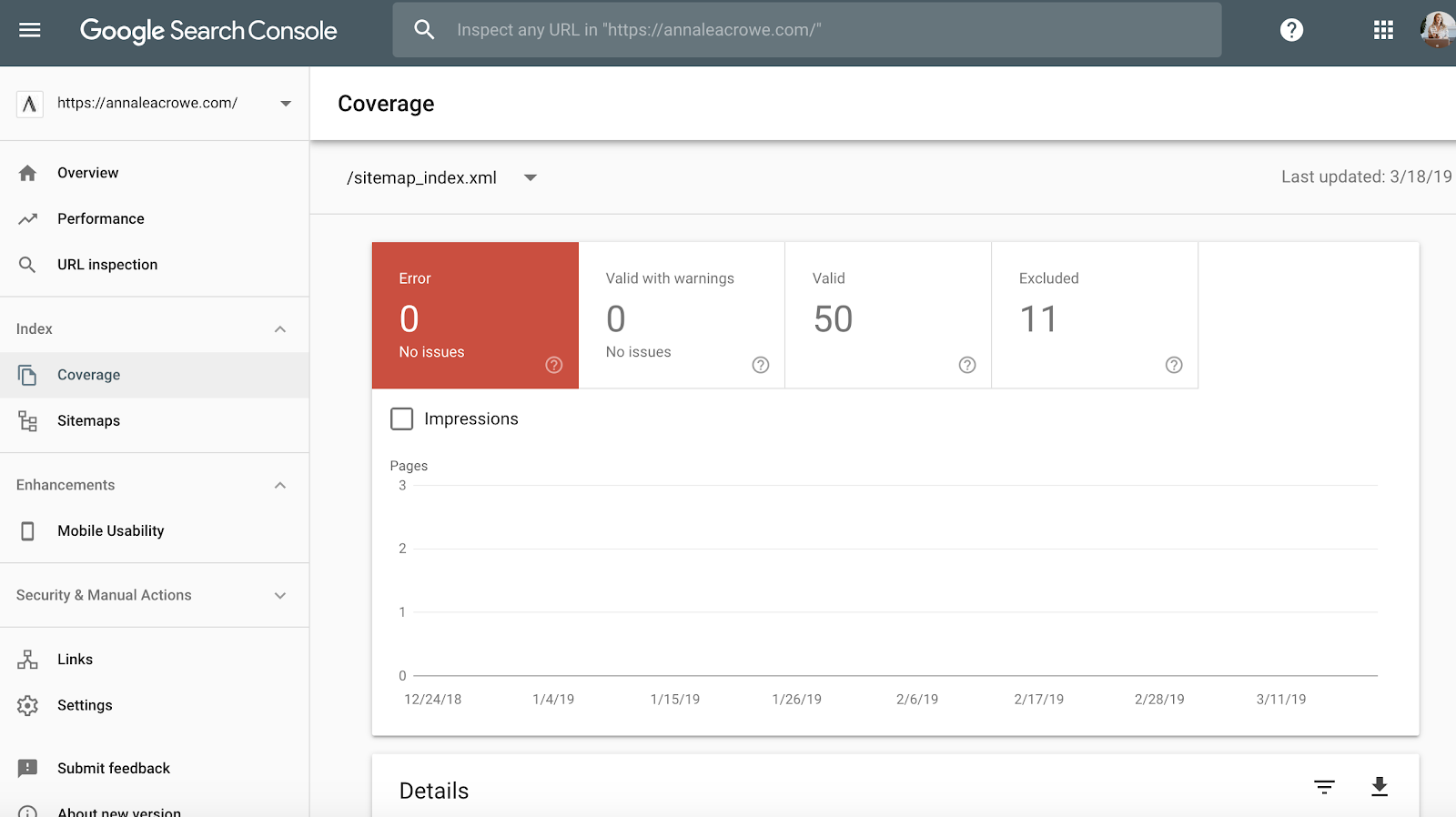

- Ga naar Google Search Console > Index > Sitemaps om de geïndexeerde URL’s in de sitemap te vergelijken met de URL’s in de webindex.

- Doe vervolgens een handmatige zoekactie om vast te stellen welke pagina’s niet worden geïndexeerd en waarom.

- Als u oude doorverwezen URL’s vindt in de sitemap van uw klant, verwijder deze dan. Deze oude redirects zullen een negatieve invloed hebben op uw SEO als u ze niet verwijdert.

- Als de klant nieuw is, dient u een nieuwe sitemap voor hem in zowel Bing Webmaster Tools als Google Search Console in.

Crawl

Crawlfouten zijn belangrijk om te controleren omdat ze niet alleen slecht zijn voor de gebruiker, maar ook voor de ranking van uw website. En, John Mueller verklaarde dat een lage crawl rate een teken kan zijn van een site van lage kwaliteit.

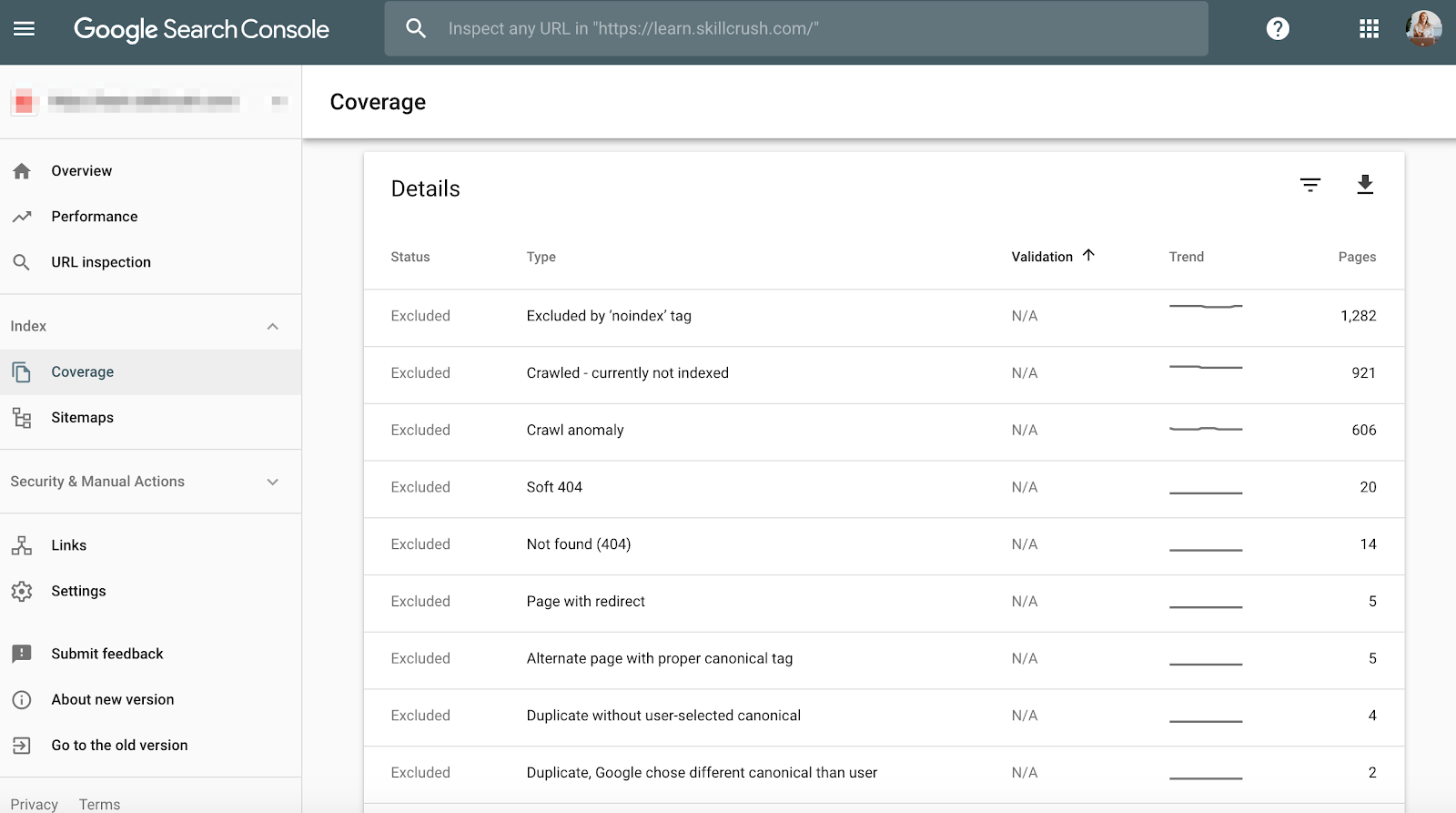

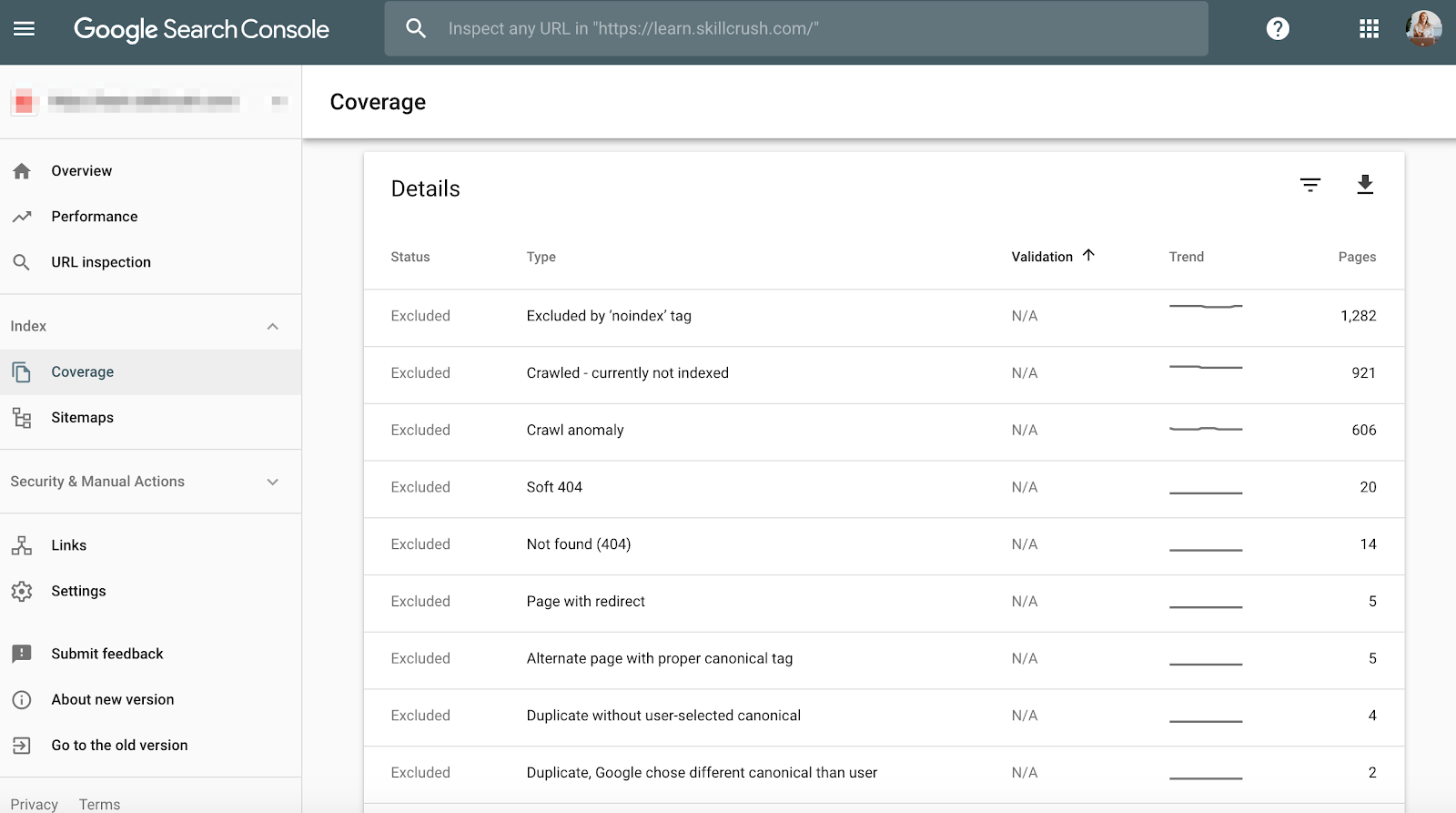

Om dit te controleren in Google Search Console, ga naar Dekking > Details.

Om dit in Bing Webmaster Tools te controleren, gaat u naar Rapporten & Gegevens > Crawlinformatie.

Hoe op te lossen:

- Controleer handmatig uw crawlfouten om te bepalen of er crawlfouten zijn die afkomstig zijn van oude producten die niet meer bestaan of als u crawlfouten ziet die zouden moeten worden afgekeurd in het robots.txt file.

- Als je eenmaal hebt vastgesteld waar ze vandaan komen, kun je 301 redirects implementeren naar vergelijkbare pagina’s die linken naar de dode pagina’s.

- Je zult ook de crawl-statistieken in Google Search Console willen vergelijken met de gemiddelde laadtijd in Google Analytics om te zien of er een correlatie is tussen de tijd die wordt besteed aan downloaden en de pagina’s die per dag worden gecrawld.

Structured Data

Zoals hierboven vermeld in de schema sectie van Screaming Frog, kunt u de schema markup van uw klant bekijken in Google Search Console.

Gebruik het individuele rijke resultaten statusrapport in Google Search Console. (Opmerking: Het gestructureerde gegevensrapport is niet langer beschikbaar).

Dit zal u helpen bepalen welke pagina’s gestructureerde gegevensfouten hebben die u op de weg zult moeten repareren.

Hoe op te lossen:

- Google Search Console zal u vertellen wat er ontbreekt in het schema wanneer u de live versie test.

- Gebaseerd op uw foutcodes, herschrijf het schema in een teksteditor en stuur het naar het web development team om het bij te werken. Ik gebruik Sublime Text voor mijn tekstbewerking. Mac-gebruikers hebben een ingebouwde en PC-gebruikers kunnen Google gekocht YouTube.

Step 3: Review Google Analytics

Tools:

- Google Analytics.

- Google Tag Manager Assistant Chrome Extension.

- Annie Cushing Campaign Tagging Guide.

Views

Als ik voor het eerst een nieuwe klant krijg, stel ik 3 verschillende views in Google Analytics in.

- Rapportage view.

- Master view.

- Test view.

Deze verschillende weergaven geven me de flexibiliteit om wijzigingen aan te brengen zonder de gegevens te beïnvloeden.

Hoe te verhelpen:

- In Google Analytics gaat u naar Beheer > Weergave > Weergave-instellingen om de drie verschillende weergaven hierboven te maken.

- Vink de sectie Botfiltering aan om alle hits van bots en spiders uit te sluiten.

- Link Google Ads en Google Search Console.

- Ten slotte moet u ervoor zorgen dat het traceren van zoekopdrachten op de site is ingeschakeld.

Filter

U moet ervoor zorgen dat u uw IP-adres en het IP-adres van uw klant toevoegt aan de filters in Google Analytics, zodat u geen vals verkeer krijgt.

Hoe op te lossen:

- Ga naar Admin> Weergave > Filters

- Dan moeten de instellingen worden ingesteld op Uitsluiten > verkeer van de IP-adressen > die gelijk zijn aan.

Tracking Code

Tracking Code

U kunt de broncode handmatig controleren, of u kunt mijn Screaming Frog techniek van hierboven gebruiken.

Als de code er is, wilt u controleren of deze in real-time wordt geactiveerd.

- Om dit te controleren, gaat u naar de website van uw klant en klikt u wat rond op de site.

- Dan gaat u naar Google Analytics > Real-Time > Locaties, uw locatie zou moeten worden ingevuld.

- Als u Google Tag Manager gebruikt, kunt u dit ook controleren met de Chrome-extensie Google Tag Assistant.

Hoe te verhelpen:

- Als de code niet werkt, moet u het codefragment controleren om er zeker van te zijn dat het de juiste is. Als u meerdere sites beheert, kan het zijn dat u de code van een andere site hebt toegevoegd.

- Voordat u de code kopieert, moet u een teksteditor gebruiken en geen tekstverwerker om het knipsel naar de website te kopiëren. Dit kan extra tekens of witruimte veroorzaken.

- De functies zijn hoofdlettergevoelig, dus controleer om ervoor te zorgen dat alles kleine letters is in de code.

Indexering

Als u de kans hebt gehad om rond te spelen in Google Search Console, hebt u waarschijnlijk de sectie Dekking opgemerkt.

Wanneer ik een klant controleer, zal ik hun indexering in Google Search Console bekijken in vergelijking met Google Analytics. Dit is hoe:

- In Google Search Console, ga naar Dekking

- In Google Analytics, ga naar Acquisitie > Kanalen > Organisch zoeken > Landingspagina.

- Als u hier eenmaal bent, gaat u naar Geavanceerd > Sitegebruik > Sessies > 9.

Hoe op te lossen:

- Vergelijk de cijfers van Google Search Console met de cijfers van Google Analytics, als de cijfers sterk uiteenlopen, dan weet u dat, ook al worden de pagina’s geïndexeerd, slechts een fractie organisch verkeer krijgt.

Campagne-tagging

Het laatste wat u in Google Analytics wilt controleren, is of uw klant campagne-tagging correct gebruikt. Je wilt geen krediet krijgen voor het werk dat je doet omdat je campagne-tagging bent vergeten.

Hoe te verhelpen:

- Stel een campagne-taggingstrategie op voor Google Analytics en deel deze met je klant. Annie Cushing heeft een geweldige campagne tagging gids samengesteld.

- Stel Event Tracking in als uw klant mobiele advertenties of video gebruikt.

Keywords

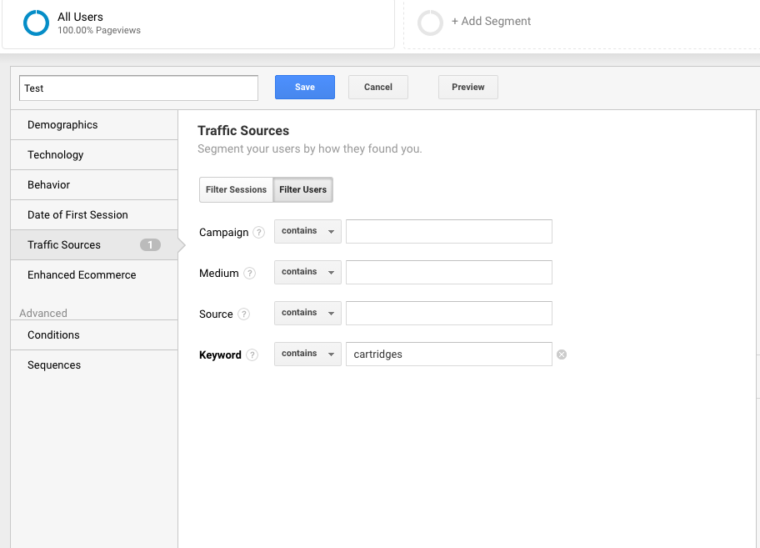

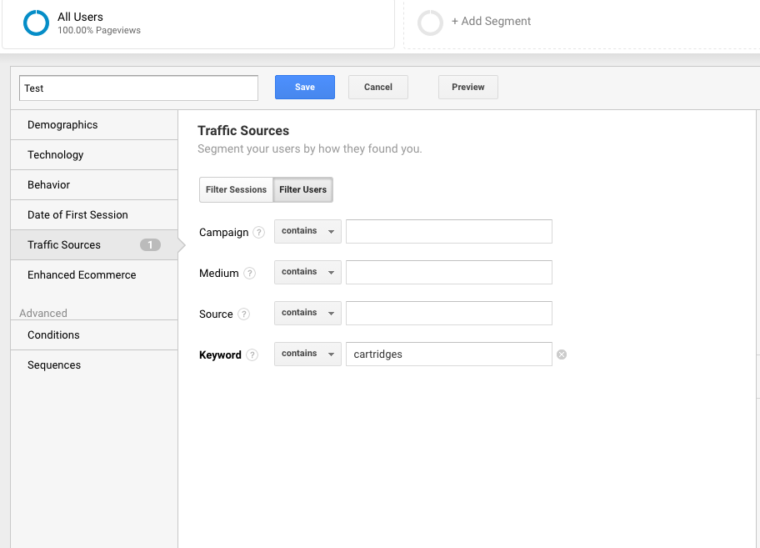

U kunt Google Analytics gebruiken om inzicht te krijgen in potentiële trefwoordpareltjes voor uw klant. Om zoekwoorden in Google Analytics te vinden, volgt u deze stappen:

Ga naar Google Analytics > Gedrag > Site zoeken > Zoektermen. Dit geeft u een beeld van waar klanten naar zoeken op de website.

Volgende, ik zal deze zoektermen gebruiken om een nieuw segment in Google Analytics te maken om te zien welke pagina’s op de site al een ranking hebben voor die bepaalde zoekterm.

Stap 4: Handmatige controle

Tools:

- Google Analytics.

- Toegang tot client’s server en host.

- You Get Signal.

- Pingdom.

- PageSpeed Tools.

- Wayback Machine.

Een versie van de site van uw klant is doorzoekbaar

Bekijk alle verschillende manieren waarop je een website zou kunnen doorzoeken. Bijvoorbeeld:

- http://annaisaunicorn.com

- https://annaisaunicorn.com

- http://www.annaisaunicorn.com

Zoals Highlander zou zeggen, “er kan er maar één” website zijn die doorzoekbaar is.

Hoe op te lossen: Gebruik een 301 redirect voor alle URL’s die niet de primaire site zijn naar de canonieke site.

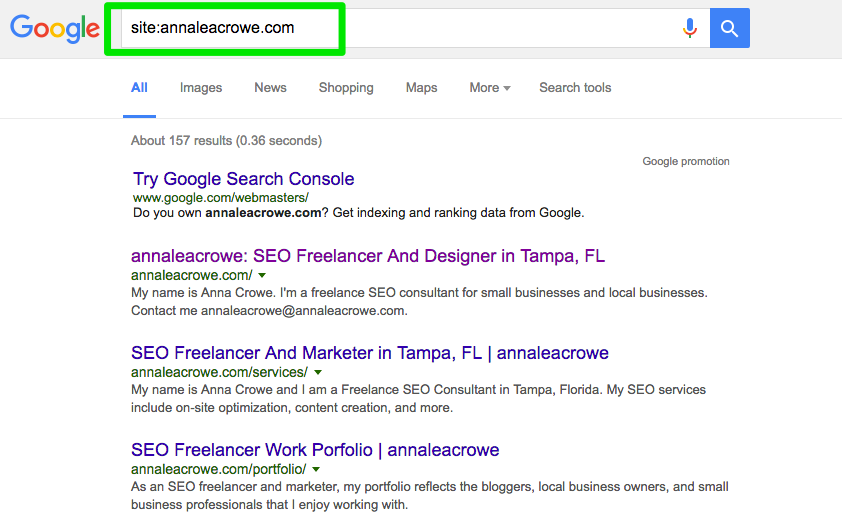

Indexeren

Voer een handmatige zoekopdracht uit in Google en Bing om te bepalen hoeveel pagina’s door Google worden geïndexeerd. Dit aantal is niet altijd accuraat met uw Google Analytics en Google Search Console gegevens, maar het zou u een ruwe schatting moeten geven.

Om dit te controleren, doet u het volgende:

- Voer een site-zoekopdracht uit in de zoekmachines.

- Wanneer u zoekt, scant u handmatig om er zeker van te zijn dat alleen het merk van uw klant wordt weergegeven.

- Controleer of de homepage op de eerste pagina staat. John Mueller zei dat het niet nodig is dat de homepage als eerste resultaat verschijnt.

Hoe op te lossen:

- Als er een ander merk in de zoekresultaten verschijnt, heb je een groter probleem aan je handen. U zult willen duiken in de analytics om het probleem te diagnosticeren.

- Als de homepage niet verschijnt als het eerste resultaat, voer dan een handmatige controle van de website uit om te zien wat er ontbreekt. Dit kan ook betekenen dat de site een penalty of een slechte site-architectuur heeft, wat een groter site-herontwerpprobleem is.

- Cross-check het aantal organische landingspagina’s in Google Analytics om te zien of het overeenkomt met het aantal zoekresultaten dat u in de zoekmachine zag. Dit kan u helpen bepalen welke pagina’s de zoekmachines als waardevol zien.

Caching

Ik zal een snelle controle uitvoeren om te zien of de toppagina’s door Google in de cache worden geplaatst. Google gebruikt deze pagina’s in de cache om uw inhoud aan zoekopdrachten te koppelen.

Om te controleren of Google de pagina’s van uw klant in de cache opslaat, doet u het volgende:

http://webcache.googleusercontent.com/search?q=cache:https://www.searchenginejournal.com/pubcon-day-3-women-in-digital-amazon-analytics/176005/

Zorg ervoor dat u overschakelt naar de alleen-tekstversie.

U kunt dit ook controleren in Wayback Machine.

Hoe te verhelpen:

- Controleer de server van de client om te zien of deze plat ligt of langzamer werkt dan normaal. Er kan een interne server fout zijn of een database connectie fout. Dit kan gebeuren als meerdere gebruikers tegelijk toegang proberen te krijgen tot de server.

- Controleer wie er nog meer op uw server zit met een omgekeerde IP adres controle. U kunt de You Get Signal website gebruiken voor deze fase. Mogelijk moet u de server van uw klant upgraden of een CDN gaan gebruiken als u schetsmatige domeinen hebt die de server delen.

- Controleer om te zien of de klant specifieke pagina’s van de site verwijdert.

Hosting

Want dit kan een beetje technisch worden voor sommigen, het is van vitaal belang voor uw SEO-succes om de hosting-software te controleren die is gekoppeld aan de website van uw klant. Hosting kan SEO schaden en al je harde werk zal voor niets zijn.

Je hebt toegang nodig tot de server van je klant om handmatig eventuele problemen te controleren. De meest voorkomende hosting problemen die ik zie zijn het hebben van de verkeerde TLD en trage site speed.

Hoe op te lossen:

- Als uw klant heeft de verkeerde TLD, moet u ervoor zorgen dat het land IP-adres is gekoppeld aan het land uw klant is het meest actief in. Als uw klant een .co-domein heeft en ook een .com-domein, dan wilt u de .co omleiden naar het primaire domein van uw klant op de .com.

- Als uw klant een trage sitesnelheid heeft, wilt u dit snel aanpakken omdat sitesnelheid een rankingfactor is. Zoek uit wat is het maken van de site traag met tools zoals PageSpeed Tools en Pingdom. Hier is een blik op een aantal van de gemeenschappelijke pagina snelheid problemen:

- Host.

- Grote afbeeldingen.

- Embedded video’s.

- Plugins.

- Ads.

- Theme.

- Widgets.

- Repetitieve script of dichte code.

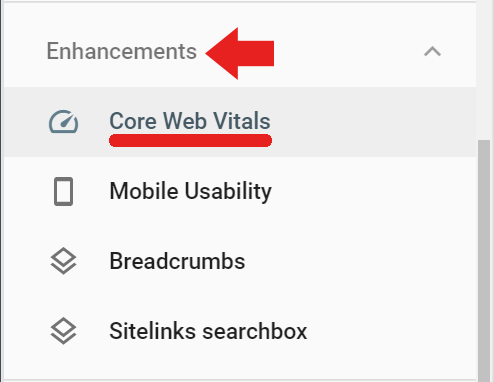

Core Web Vitals Audit

Core Web Vitals is een verzameling van drie metrieken die representatief zijn voor de gebruikerservaring van een website. Ze zijn belangrijk omdat Google in het voorjaar van 2021 hun algoritmen bijwerkt om Core Web Vitals als een rankingfactor op te nemen.

Hoewel de rankingfactor naar verwachting een kleine factor zal zijn, is het nog steeds belangrijk om de Core Web Vitals-scores te auditen en verbeterpunten te identificeren.

Waarom is het belangrijk om Core Web Vitals op te nemen in uw audit?

Het verbeteren van Core Web Vitals-scores zal niet alleen helpen bij het zoeken ranking, maar misschien nog belangrijker het kan zich uitbetalen met meer conversies en inkomsten.

Verbetering van de snelheid en de pagina prestaties worden geassocieerd met een hogere omzet, verkeer, en advertentieklikken.

Het upgraden van de web hosting en het installeren van een nieuwe plugin kan de pagina snelheid te verbeteren, maar zal weinig (of geen) effect op Core Web Vitals hebben.

De meting wordt gedaan op het punt waar iemand letterlijk uw site op hun mobiele telefoon aan het downloaden is.

Dat betekent dat het knelpunt zich bij hun internetverbinding en het mobiele apparaat bevindt. Een snelle server zal niet versnellen van een trage internetverbinding op een budget mobiele telefoon.

Zo ook, omdat veel van de oplossingen betrekken het veranderen van de code in een sjabloon of de kern bestanden van de content management systeem zelf, zal een pagina snelheid plugin zijn van zeer weinig nut.

Er zijn veel middelen om te helpen begrijpen oplossingen. Maar de meeste oplossingen vereisen de hulp van een ontwikkelaar die zich op zijn gemak voelt bij het bijwerken en wijzigen van core-bestanden in uw content management-systeem.

Het oplossen van Core Web Vitals-problemen kan moeilijk zijn. WordPress, Drupal en andere contentmanagementsystemen (CMS) zijn niet gebouwd om goed te scoren voor Core Web Vitals.

Het is belangrijk op te merken dat het proces voor het verbeteren van Core Web Vitals het wijzigen van de codering in de kern van WordPress en andere CMS omvat.

In wezen vereist het verbeteren van Core Web Vitals dat een website iets doet waarvoor het nooit bedoeld was toen de ontwikkelaars een thema of CMS maakten.

Het doel van een Core Web Vitals-audit is om vast te stellen wat er moet worden gerepareerd en die informatie over te dragen aan een ontwikkelaar die vervolgens de noodzakelijke wijzigingen kan aanbrengen.

Wat zijn Core Web Vitals?

Core Web Vitals bestaan uit drie metrieken die samen identificeren hoe snel het belangrijkste deel van uw pagina laadt, hoe snel een gebruiker kan communiceren met de pagina (bijvoorbeeld: klik op een knop), en hoe snel het duurt voor de webpagina om stabiel te worden zonder pagina-elementen verschuiven rond.

Er zijn:

- Largest Contentful Paint (LCP).

- First Input Delay (FID).

- Cumulative Layout Shift (CLS).

Er zijn twee soorten scores voor de Core Web Vitals:

- Lab data.

- Field data.

Lab Data

Lab data is wat wordt gegenereerd wanneer u een pagina door Google Lighthouse of in PageSpeed Insights.

Lab data bestaat uit scores gegenereerd door middel van een gesimuleerd apparaat en een internetverbinding. Het doel is om de persoon die aan de site werkt een idee te geven van welke delen van de Core Web Vitals verbetering behoeven.

De waarde van een tool als PageSpeed Insights is dat het specifieke code en pagina-elementen identificeert die ervoor zorgen dat een pagina slecht scoort.

Field Data

Field Data zijn daadwerkelijke Core Web Vitals-scores die zijn verzameld door de Google Chrome-browser voor het Chrome User Experience Report (ook bekend als CrUX).

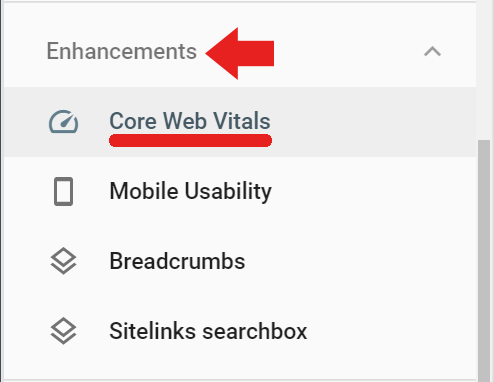

De veldgegevens zijn beschikbaar in Google Search Console onder het tabblad Verbeteringen via de link met het label Core Web Vitals (veldgegevens kunnen ook via deze link worden geopend) https://search.google.com/search-console/core-web-vitals.

De veldgegevens die in Google Search Console worden gerapporteerd, zijn afkomstig van bezochte pagina’s die een minimumaantal bezoeken en metingen hebben gehad. Als Google niet genoeg scores ontvangt dan zal Google Search Console die score niet rapporteren.

Screaming Frog voor Core Web Vitals Audit

Screaming Frog versie 14.2 heeft nu de mogelijkheid om een pass of fail Core Web Vitals beoordeling weer te geven. U moet Screaming Frog verbinden met de PageSpeed Insights API (verkrijg een API sleutel hier) via een sleutel.

Om uw Page Speed Insights API sleutel te registreren met Screaming Frog, navigeert u eerst naar Configuratie > API Toegang > PageSpeed Insights

Daar zult u een plaats zien om uw API sleutel in te voeren en te verbinden met de service.

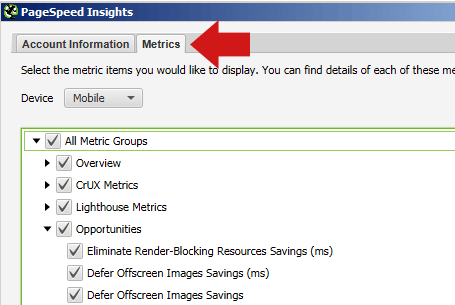

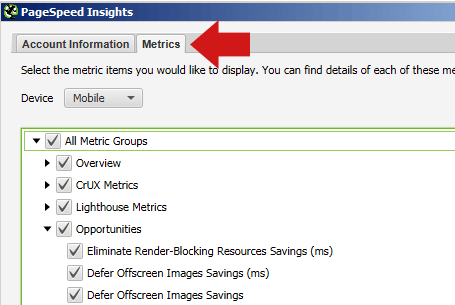

In dezelfde PageSpeed Insights popup, kunt u ook de Metrics tab en vink de vakjes aan die aangeven welke statistieken u wilt hebben gerapporteerd.

Zorg ervoor dat u Mobile selecteert voor het apparaat, want dat is de metric die van belang is voor rangschikkingsdoeleinden.

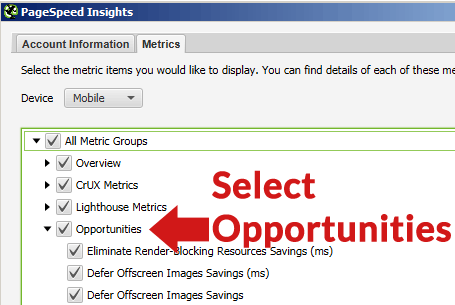

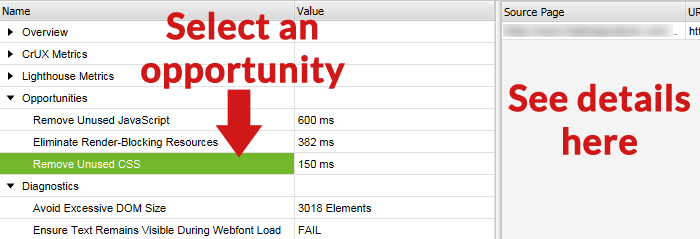

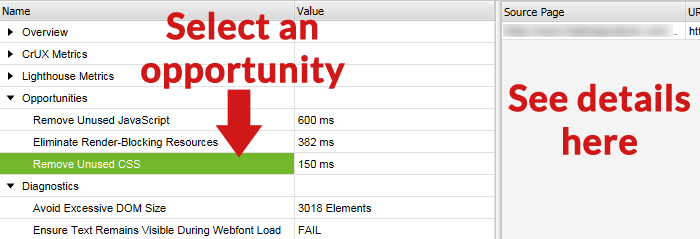

Als u het tabblad Mogelijkheden selecteert, krijgt u na het crawlen van Screaming Frog een lijst te zien met verschillende soorten verbeteringen (zoals het uitstellen van offscreen afbeeldingen, het verwijderen van ongebruikte CSS, enzovoort).

Note vóór het crawlen

Er is over het algemeen geen noodzaak om een hele site te crawlen en een uitputtende pagina-voor-pagina-overzicht te maken van wat er mis is met elke afzonderlijke pagina van de website.

Voordat u gaat crawlen, kunt u overwegen om een representatieve set pagina’s te crawlen. Om dit te doen, selecteert u eerst een groep pagina’s die de soorten pagina’s vertegenwoordigen die gebruikelijk zijn voor elke sectie of categorie van de website. Maak een spreadsheet, een tekstbestand lijst, of plak handmatig de URL’s in met behulp van de Upload tab in Screaming Frog.

De meeste sites bevatten pagina’s en berichten gemaakt met vergelijkbare pagina structuur en inhoud. Bijvoorbeeld, alle pagina’s in een categorie “nieuws” gaan vrij gelijkaardig zijn, pagina’s in een categorie “reviews” gaan ook gelijkaardig zijn aan elkaar.

U kunt tijd besparen door een representatieve groep pagina’s te crawlen om problemen te identificeren die gemeenschappelijk zijn over individuele categorieën, evenals problemen die gemeenschappelijk zijn voor alle pagina’s sitewide die moeten worden opgelost.

Omwille van die gelijkenissen, gaan de ontdekte problemen gelijkaardig zijn. Het kan alleen nodig zijn om een handvol representatieve pagina’s van elk type categorie crawlen om te identificeren wat voor soort problemen zijn specifiek voor elk van die secties.

Het soort dingen dat wordt verholpen, zijn meestal sitebrede problemen die op de hele site voorkomen, zoals ongebruikte CSS die op elke pagina wordt geladen of Cumulative Layout Shift veroorzaakt door een advertentie-unit die zich in het linkergedeelte van de webpagina’s bevindt.

Omdat moderne websites zijn templated, zullen de fixes gebeuren op het template niveau of met aangepaste codering in de stylesheet, etc.

Crawl de site met Screaming Frog

Wanneer de URL’s volledig zijn gecrawld, kunt u op de PageSpeed tab klikken en alle aanbevelingen lezen en de pass/fail notaties voor de verschillende metrieken bekijken.

Zoom in op URL kansen

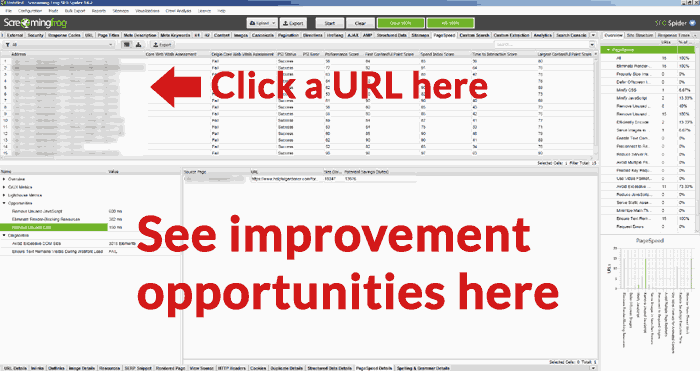

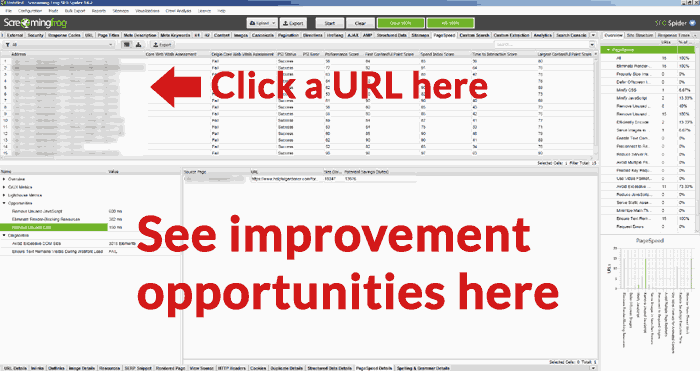

Een nuttige functie in de Screaming Frog Core Web Vitals Audit is de mogelijkheid om een URL te selecteren uit de lijst van URL’s in het bovenste deelvenster en dan de kansen voor verbetering te zien in het onderste deelvenster van het Screaming Frog display scherm.

Hieronder ziet u een screenshot van het onderste scherm, met een geselecteerde kans en de details van die verbetermogelijkheid in het rechterdeelvenster.

Officieel hulpprogramma van Google

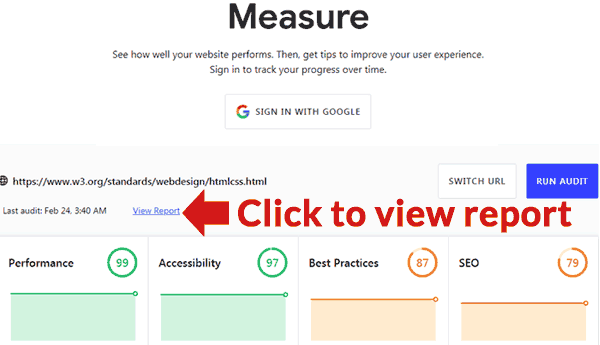

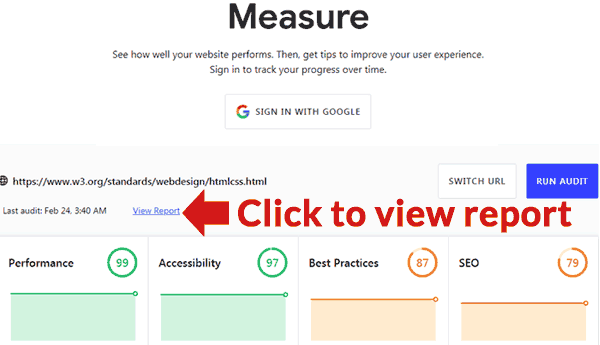

Google heeft een hulpprogramma gepubliceerd waarmee een audit kan worden uitgevoerd. Het is hier te vinden: https://web.dev/measure/

Voeg een URL in voor een overzicht van de paginaprestaties. Als u bent aangemeld, zal Google de pagina in de loop der tijd voor u bijhouden. Als u op de koppeling Rapport weergeven klikt, wordt een nieuwe pagina geopend met een rapport waarin staat wat er mis is en links naar handleidingen waarin staat hoe u elk probleem kunt oplossen.