Jeg vil ikke lyve:

Og som SEO-konsulent er der kun få ord, der er sødere end: “Din revision ser godt ud! Hvornår kan vi tage dig med om bord?”

Selv hvis du ikke aktivt har ledt efter et nyt job, er det et kæmpe ego boost at vide, at din SEO-revision har givet pote.

Men er du bange for at begynde? Er det din første SEO-revision? Eller måske ved du bare ikke, hvor du skal begynde?

At sende en fantastisk SEO-revision til en potentiel kunde sætter dig i den bedst mulige position.

Så tag dig god tid. Husk: Dit primære mål er at tilføje værdi til din kunde med dine anbefalinger til webstedet på både kort og lang sigt.

I denne klumme har jeg samlet de nødvendige trin til at vide, hvordan man udfører en SEO-revision, og et lille indblik i den første fase af mine processer, når jeg først får en ny kunde. Den er opdelt i nedenstående afsnit. Hvis du føler, at du har en god forståelse for et bestemt afsnit, er du velkommen til at springe til det næste.

Hvornår skal jeg udføre en SEO-revision?

Når en potentiel kunde sender mig en e-mail med interesse for et samarbejde, og de besvarer min undersøgelse, arrangerer vi et introopkald (Skype eller Google Hangouts foretrækkes).

Forinden opkaldet foretager jeg min egen mini quick SEO audit (jeg investerer mindst en time i manuel research) baseret på deres besvarelser i undersøgelsen for at blive fortrolig med deres markedslandskab. Det er som at date en person, du aldrig har mødt.

Du skal naturligvis stalke dem på Facebook, Twitter, Instagram og alle andre kanaler, der er offentlige #soIcreep.

Her er et eksempel på, hvordan min undersøgelse ser ud:

Her er nogle nøglespørgsmål, du vil stille kunden under det første møde:

- Hvad er dine overordnede forretningsmål? Hvad er dine kanalmål (PR, sociale medier osv.)?

- Hvem er din målgruppe?

- Har du nogen forretningspartnerskaber?

- Hvor ofte bliver webstedet opdateret? Har du en webudvikler eller en it-afdeling?

- Har du nogensinde arbejdet sammen med en SEO-konsulent før? Eller har du tidligere fået udført SEO-arbejde?

Sujan Patel har også nogle gode anbefalinger til spørgsmål, som du skal stille en ny SEO-kunde.

Efter samtalen, hvis jeg føler, at vi er et godt match, sender jeg mit formelle tilbud og kontrakt (tak HelloSign for at gøre dette til en nem proces for mig!).

Til at begynde, kan jeg altid lide at tilbyde mine klienter den første måned som en prøveperiode for at sikre, at vi vibrerer.

Det giver både klienten og jeg en chance for at blive venner først, før vi dater. I løbet af denne måned vil jeg tage mig tid til at foretage en dybdegående SEO-revision.

Disse SEO-revisioner kan tage mig alt fra 40 timer til 60 timer afhængigt af hjemmesidens størrelse. Disse audits er opdelt i tre separate dele og præsenteres med Google Slides.

- Teknisk: Crawl-fejl, indeksering, hosting osv.

- Indhold:

- Links: Søgeord, konkurrentanalyse, indholdskort, metadata osv.

- Links: Efter den første måned, hvis kunden kan lide mit arbejde, begynder vi at implementere anbefalingerne fra SEO-auditet, hvis kunden kan lide mit arbejde. Og fremadrettet vil jeg udføre en mini-audit månedligt og en dybdegående audit kvartalsvis.

For at opsummere, udfører jeg en SEO-revision for mine kunder:

- Første måned.

- Månedligt (mini-audit).

- Kvartalsvis (dybdegående audit).

Hvad du har brug for fra en klient før en SEO-revision

Når en klient og jeg begynder at arbejde sammen, deler jeg et Google Doc med dem og anmoder om en liste over adgangskoder og leverandører.

Dette omfatter:

- Google Analytics-adgang og eventuelle tredjepartsanalyseværktøjer.

- Google- og Bing-annoncer.

- Webmaster-værktøjer.

- Webstedets backend-adgang.

- Sociale mediekonti.

- Liste over leverandører.

- Liste over interne teammedlemmer (herunder eventuelt arbejde, de outsourcer).

Værktøjer til SEO-audit

Hvor du begynder din SEO-audit, er her en opsummering af de værktøjer, jeg bruger:

- Screaming Frog.

- Integrity (for Mac-brugere) og Xenu Sleuth (for PC-brugere).

- SEO Browser.

- Wayback Machine.

- Moz.

- BuzzSumo.

- DeepCrawl.

- Copyscape.

- Google Tag Manager.

- Google Tag Manager Chrome Extension.

- Annie Cushing’s Campaign Tagging Guide.

- Google Analytics (hvis du får adgang).

- Google Search Console (hvis du får adgang).

- Bing Webmaster Tools (hvis du får adgang).

- You Get Signal.

- Pingdom.

- PageSpeed Tool.

- Sublime Text.

Udførelse af en teknisk SEO-revision

Værktøjer, der er nødvendige til teknisk SEO-revision:

VejledningFortsæt læsning nedenfor- Screaming Frog.

- DeepCrawl.

- Copyscape.

- Integrity for Mac (eller Xenu Sleuth for pc-brugere).

- Google Analytics (hvis der gives adgang).

- Google Search Console (hvis der gives adgang).

- Bing Webmaster Tools (hvis der gives adgang).

Stræk 1: Tilføj websted til DeepCrawl og Screaming Frog

Tools:

- DeepCrawl.

- Copyscape.

- Screaming Frog.

- Google Analytics.

- Integrity.

- Google Tag Manager.

- Google Analytics-kode.

Hvad man skal kigge efter, når man bruger DeepCrawl

Det første, jeg gør, er at tilføje min kundes websted til DeepCrawl. Afhængigt af størrelsen af din klients websted kan crawlen tage en dag eller to, før resultaterne kommer tilbage.

Når du får dine DeepCrawl-resultater tilbage, er her de ting, jeg kigger efter:

ReklameFortsæt læsning nedenforDupliceret indhold

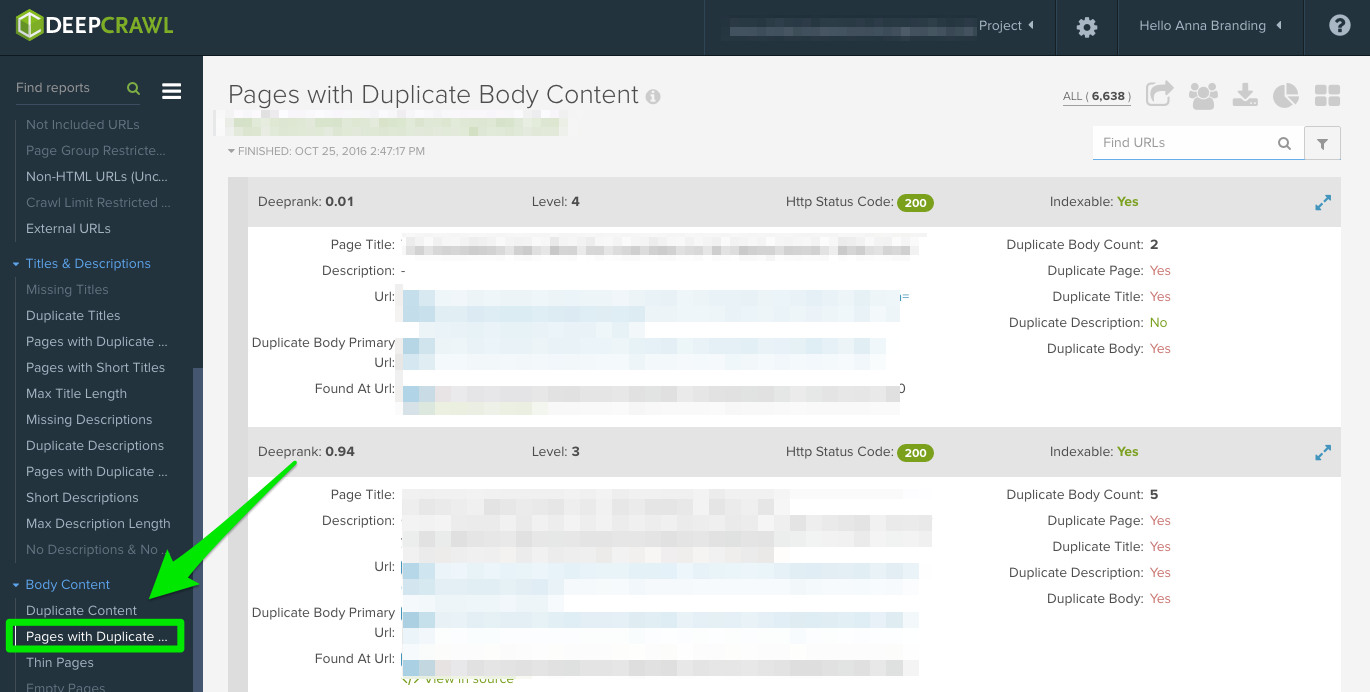

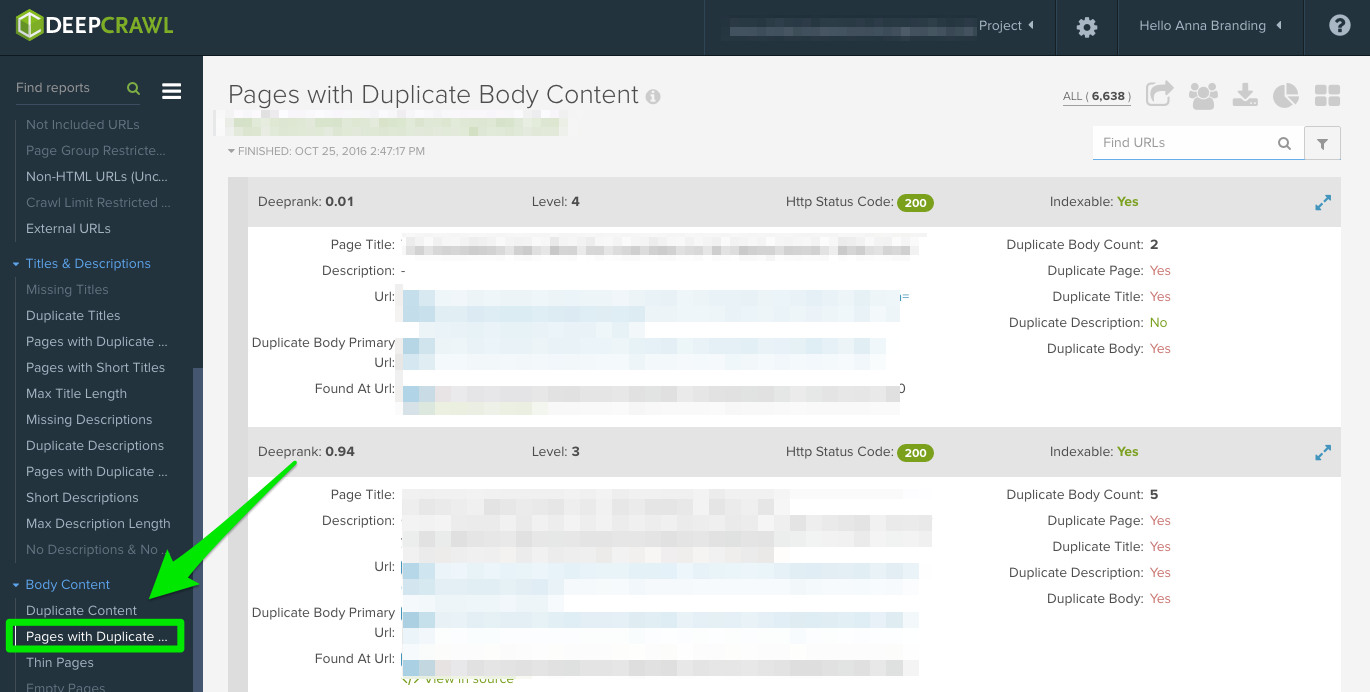

Kig på rapporten “Duplicate Pages” for at lokalisere duplicate content.

Hvis duplikeret indhold identificeres, vil jeg gøre dette til en topprioritet i mine anbefalinger til kunden om at omskrive disse sider, og i mellemtiden vil jeg tilføje <meta name=”robots” content=”noindex, nofollow”>-tagget til de duplikerede sider.

Hyppige fejl ved duplikeret indhold, som du vil opdage:

- Duplikerede metatitler og metabeskrivelser.

- Duplikeret kropsindhold fra tag-sider (jeg bruger Copyscape til at hjælpe med at afgøre, om noget er plagieret).

- To domæner (f.eks. yourwebsite.co, yourwebsite.com).

- Subdomæner (f.eks. jobs.yourwebsite.com).

- Lignende indhold på et andet domæne.

- Mangelfuldt implementerede pagineringssider (se nedenfor.)

Sådan løser du problemet:

- Tilføj det kanoniske tag på dine sider for at fortælle Google, hvad du ønsker, at din foretrukne URL skal være.

- Undgå forkerte URL’er i robotterne.txt.

- Opnyt indhold (herunder brødtekst og metadata).

Her er et eksempel på et problem med duplicate content, som jeg havde med en af mine kunder. Som du kan se nedenfor, havde de URL-parametre uden det kanoniske tag.

Dette er de trin, jeg tog for at løse problemet:

- Jeg løste eventuelle 301 redirect-problemer.

- Føjede et canonical-tag til den side, jeg vil have Google til at crawle.

- Jeg opdaterede parameterindstillingerne i Google Search Console for at udelukke parametre, der ikke genererer unikt indhold.

RådgivningFortsæt læsning nedenfor- Jeg tilføjede funktionen disallow til robots.txt til de forkerte URL’er for at forbedre crawlbudgettet.

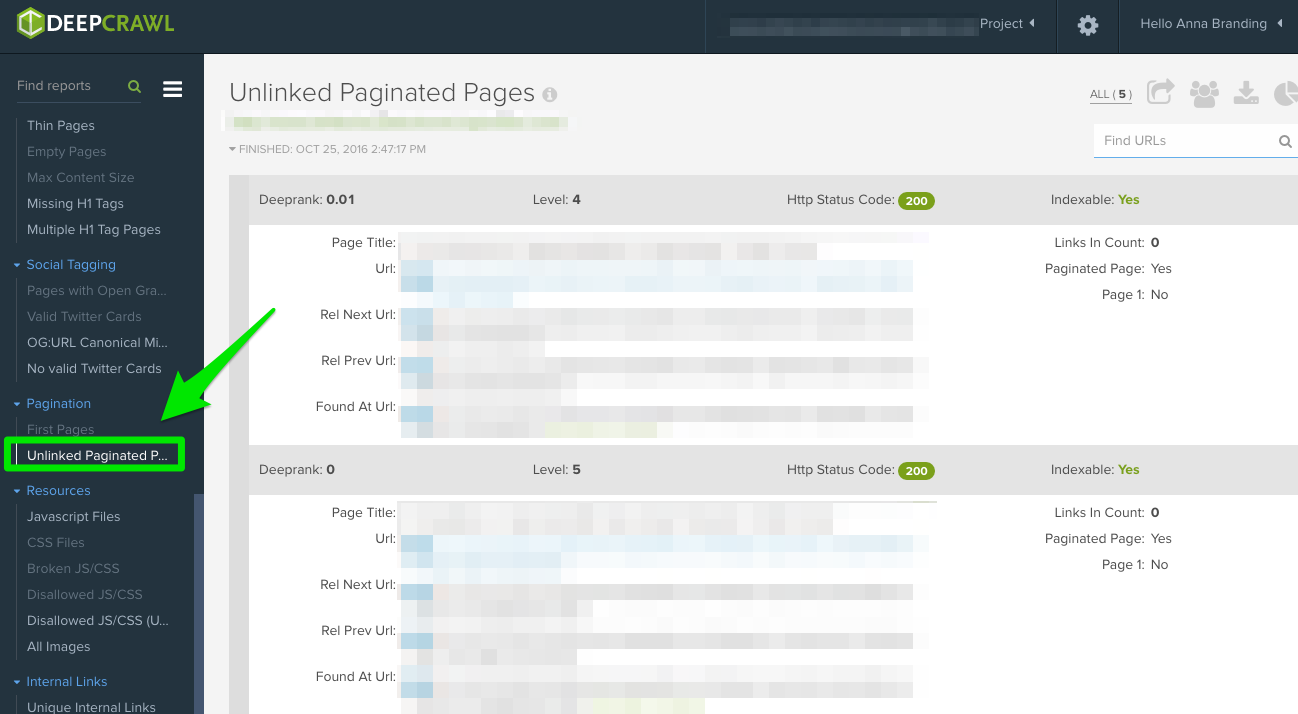

Pagination

Der er to rapporter at tjekke ud:

- Første sider: Hvis du vil finde ud af, hvilke sider der bruger paginering, skal du gennemgå rapporten “Første sider”. Derefter kan du manuelt gennemgå de sider, der bruger dette på webstedet, for at finde ud af, om paginering er implementeret korrekt.

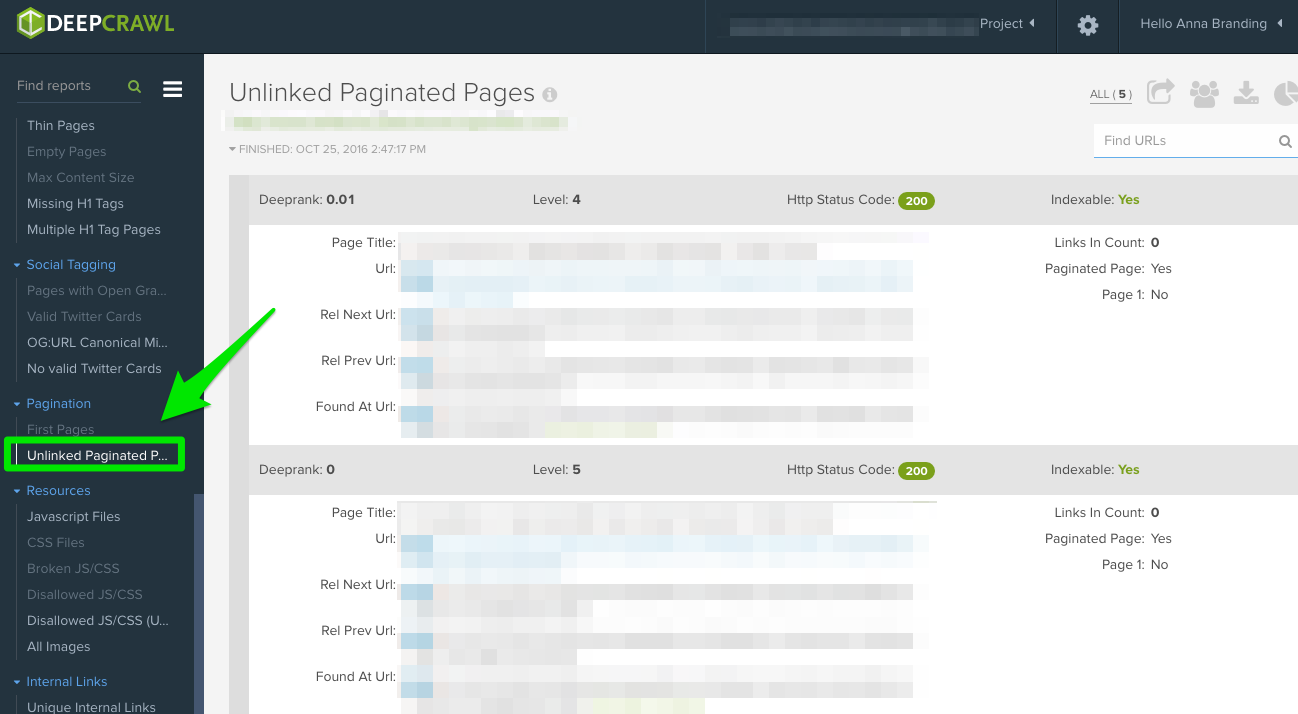

- Uforbundne pagineringssider: Hvis du vil finde ud af, om paginering fungerer korrekt, kan du i rapporten “Unlinked Pagination Pages” se, om rel=”next” og rel=”prev” linker til den foregående og næste side.

I dette eksempel nedenfor var jeg i stand til at finde ud af, at en kunde havde gensidige pagineringstags ved hjælp af DeepCrawl:

Sådan løser du problemet:

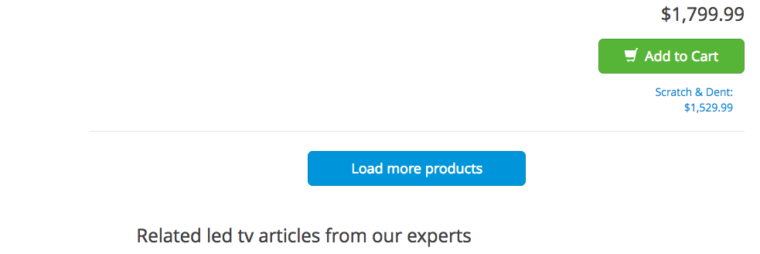

- Hvis du har en “view all” eller en “load more”-side, skal du tilføje rel=”canonical”-tag. Her er et eksempel fra Crutchfield:

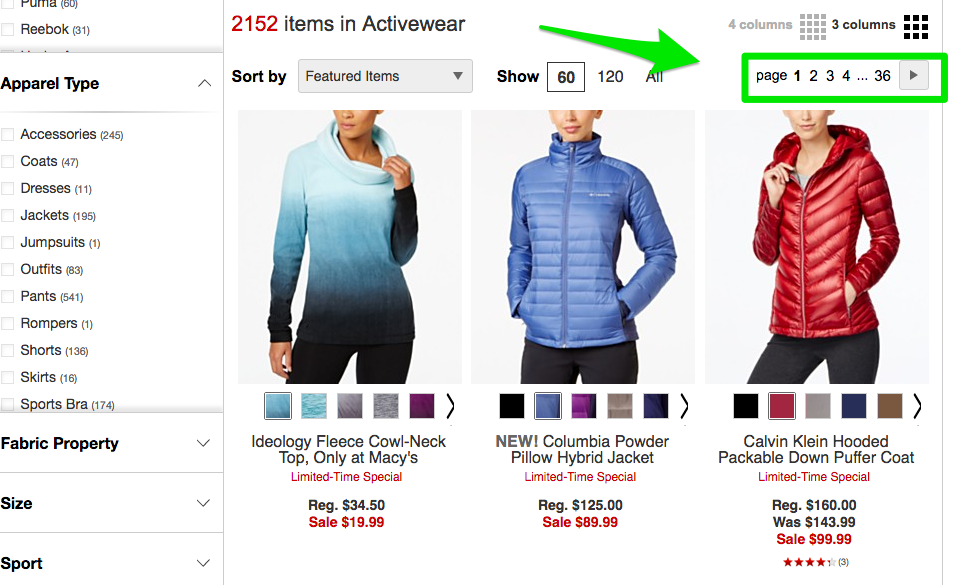

- Hvis du har alle dine sider på separate sider, skal du tilføje standard rel=”next” og rel=”prev”-markup. Her er et eksempel fra Macy’s:

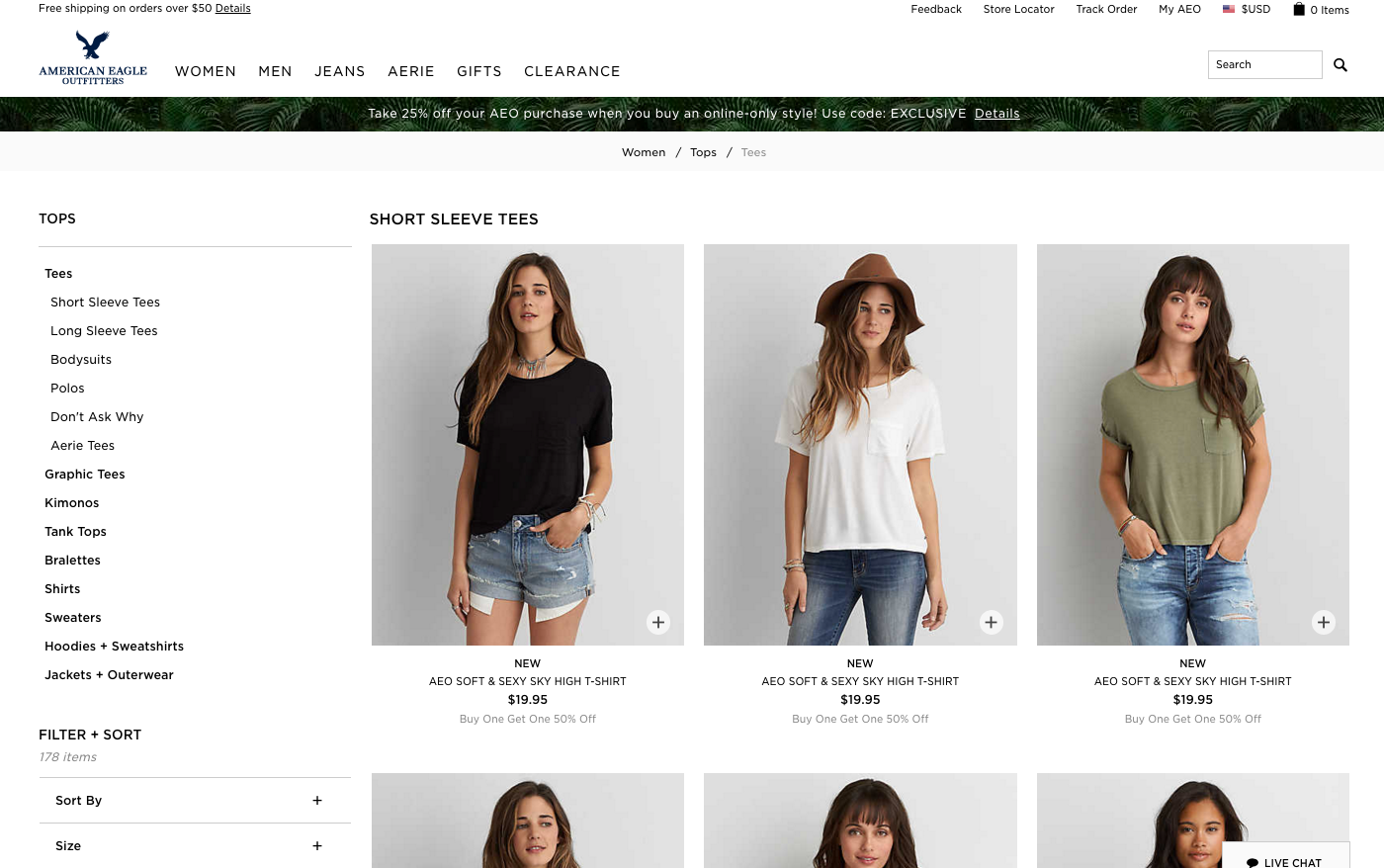

- Hvis du bruger uendelig rulning, skal du tilføje den tilsvarende URL til den paginerede side i dit javascript. Her er et eksempel fra American Eagle.

Max Redirections

Se rapporten “Max Redirections” for at se alle de sider, der omdirigerer mere end 4 gange. John Mueller nævnte i 2015, at Google kan stoppe med at følge omdirigeringer, hvis der er mere end fem.

Mens nogle mennesker henviser til disse crawlfejl som værende opslugende af “crawlbudgettet”, henviser Gary Illyes til dette som “værtsbelastning”. Det er vigtigt at sikre, at dine sider gengives korrekt, fordi du ønsker, at din værtsbelastning skal bruges effektivt.

ReklameFortsæt læsning nedenforHer er en kort oversigt over de svarkoder, du kan se:

- 301 – Dette er størstedelen af de koder, du vil se i løbet af din søgning. 301 redirects er okay, så længe der kun er én redirect og ingen redirect loop.

- 302 – Disse koder er okay, men hvis de ligger længere end 3 måneder eller deromkring, ville jeg manuelt ændre dem til 301s, så de er permanente. Dette er en fejlkode, som jeg ofte ser på e-handelswebsteder, når et produkt er udsolgt.

- 400 – Brugerne kan ikke komme til siden.

- 403 – Brugerne har ikke tilladelse til at få adgang til siden.

- 404 – Siden kan ikke findes (hvilket normalt betyder, at kunden har slettet en side uden en 301-redirect).

- 500 – Intern serverfejl, som du skal kontakte webudviklingsteamet for at fastslå årsagen.

Sådan løser du problemet:

- Fjern eventuelle interne links, der peger på gamle 404-sider, og opdater dem med det interne link til den omdirigerede side.

- Fjern redirect-kæderne ved at fjerne de midterste redirects. Hvis redirect A f.eks. går til redirect B, C og D, skal du fortryde redirects B og C. Det endelige resultat vil være en redirect A til D.

- Der er også en måde at gøre dette i Screaming Frog og Google Search Console nedenfor, hvis du bruger den version.

Hvad du skal kigge efter, når du bruger Screaming Frog

Den anden ting, jeg gør, når jeg får et nyt klientwebsted, er at tilføje deres URL til Screaming Frog.

Afhængigt af størrelsen af din klients websted, kan jeg konfigurere indstillingerne til at crawle bestemte områder af webstedet ad gangen.

ReklameFortsæt læsning nedenforHer er, hvordan mine Screaming Frog spider-konfigurationer ser ud:

Du kan gøre dette i dine spider-indstillinger eller ved at udelukke områder af webstedet.

Når du får dine Screaming Frog-resultater tilbage, er her de ting, jeg kigger efter:

Google Analytics-kode

Screaming Frog kan hjælpe dig med at identificere, hvilke sider der mangler Google Analytics-koden (UA-1234568-9). For at finde den manglende Google Analytics-kode skal du følge disse trin:

VejledningFortsæt læsning nedenfor- Gå til Konfiguration i navigationslinjen og derefter Tilpasset.

- Føj analytics\.js til Filter 1, og skift derefter rullemenuen til Indeholder ikke.

Sådan løser du problemet:

- Kontakt din kundes udviklere, og bed dem om at tilføje koden til de specifikke sider, som den mangler.

- For flere oplysninger om Google Analytics skal du springe videre til dette afsnit om Google Analytics nedenfor.

Google Tag Manager

Screaming Frog kan også hjælpe dig med at finde ud af, hvilke sider der mangler Google Tag Manager-snippet med lignende trin:

- Gå til fanen Konfiguration i navigationslinjen og derefter Tilpasset.

- Føj <iframe src-“//www.googletagmanager.com/ med Does not contain valgt i Filteret.

Sådan løser du problemet:

- Gå over til Google Tag Manager for at se, om der er nogen fejl, og opdater om nødvendigt.

- Del koden med din kundes udviklere for at se, om de kan tilføje den tilbage til webstedet.

Schema

Du skal også kontrollere, om din kundes websted bruger skema-markup på deres websted. Schema eller strukturerede data hjælper søgemaskinerne med at forstå, hvad en side er på webstedet.

Følg disse trin for at kontrollere for skema-markup i Screaming Frog:

AdvertisementFortsæt læsning nedenfor- Gå til fanen Konfiguration i navigationslinjen og derefter Tilpasset.

- Føj itemtype=”http://schema.\.org/ med ‘Indeholder’ valgt i Filteret.

Indeksering

Indeksering

Du vil bestemme, hvor mange sider der bliver indekseret for din klient, skal du følge dette i Screaming Frog:

- Når dit websted er færdig med at blive indlæst i Screaming Frog, skal du gå til Directives > Filter > Index for at gennemgå, om der mangler nogen kodestykker.

Sådan løser du problemet:

- Hvis webstedet er nyt, har Google måske ikke indekseret det endnu.

- Kontroller robotterne.txt-filen for at sikre, at du ikke udelukker noget, som du ønsker, at Google skal crawle.

- Kontroller, at du har indsendt din klients sitemap til Google Search Console og Bing Webmaster Tools.

- Før manuel research (se nedenfor).

Flash

Google meddelte i 2016, at Chrome vil begynde at blokere Flash på grund af de langsomme indlæsningstider på siderne. Så hvis du laver en revision, vil du gerne identificere, om din nye klient bruger Flash eller ej.

For at gøre dette i Screaming Frog skal du prøve dette:

VejledningFortsæt læsning nedenfor- Kør til Spider-konfigurationen i navigationen.

- Klik på Check SWF.

- Filtrer fanen Internal (Intern) med Flash, efter at crawlingen er udført.

Sådan løser du:

- Indlejrer videoer fra YouTube. Google købte YouTube i 2006, det er en selvfølge her.

- Og vælg HTML5-standarder, når du tilføjer en video.

Her er et eksempel på HTML5-kode til tilføjelse af en video:

<video controls="controls" width="320" height="240">> <source class="hiddenSpellError" data-mce-bogus="1" />src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.mp4" type="video/mp4"> <source src="/tutorials/media/Anna-Teaches-SEO-To-Small-Businesses.ogg" type="video/ogg" />Your browser does not support the video tag.</video>

JavaScript

I henhold til Googles meddelelse i 2015 er JavaScript okay at bruge til dit website, så længe du ikke blokerer noget i din robots.txt (vi graver lidt dybere ned i dette om lidt!). Men du vil stadig gerne tage et kig på, hvordan Javascript leveres til dit websted.

RådgivningFortsæt læsning nedenforSådan løser du problemet:

- Review Javascript for at sikre, at det ikke blokeres af robotter.txt

- Sørg for, at Javascript kører på serveren (dette hjælper med at producere almindelig tekstdata i forhold til dynamiske).

- Hvis du kører Angular JavaScript, skal du læse denne artikel af Ben Oren om, hvorfor det måske dræber dine SEO-indsatser.

- I Screaming Frog skal du gå til Spider-konfiguration i navigationslinjen og klikke på Check JavaScript. Når crawlingen er færdig, skal du filtrere dine resultater på fanen Intern efter JavaScript.

Robotter.txt

Robotter.txt

Når du gennemgår en robots.txt for første gang, skal du se efter, om noget vigtigt bliver blokeret eller ikke tilladt.

For eksempel, hvis du ser denne kode:

User-agent: *Disallow: /

Din klients websted er blokeret for alle webcrawlere.

Men hvis du har noget som Zappos robots.txt-fil, burde du kunne klare dig.

# Global robots.txt pr. 2012-06-19User-agent: *Disallow: /bin/Disallow: /multiview/Disallow: /product/review/add/Disallow: /product/review/add/Disallow: /cartDisallow: /cartDisallow: /loginDisallow: /loginDisallow: /logoutDisallow: /loginDisallow: /logoutDisallow: /loginDisallow /registerDisallow: /registerDisallow: /account

De blokerer kun for det, som de ikke ønsker, at webcrawlere skal finde. Dette indhold, der blokeres, er ikke relevant eller nyttigt for webcrawleren.

RådgivningFortsæt læsning nedenforSådan retter du:

- Din robots.txt er case-sensitiv, så opdater dette til at være alle små bogstaver.

- Fjern alle sider, der er opført som Disallow, som du vil have søgemaskinerne til at crawle.

- Screaming Frog vil som standard ikke være i stand til at indlæse nogen URL’er, der er forbudt af robots.txt. Hvis du vælger at ændre standardindstillingerne i Screaming Frog, vil den ignorere alle robots.txt.

- Du kan også se de blokerede sider i Screaming Frog under fanen Svarskoder og derefter filtreret efter filteret Blokeret af Robots.txt, når du har afsluttet din crawl.

- Hvis du har et websted med flere underdomæner, bør du have en separat robots.txt for hvert af dem.

- Sørg for, at sitemapet er opført i robots.txt.

Crawl-fejl

Jeg bruger DeepCrawl, Screaming Frog og Google og Bing webmaster tools til at finde og krydstjekke mine kunders crawlfejl.

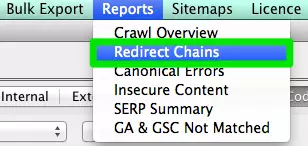

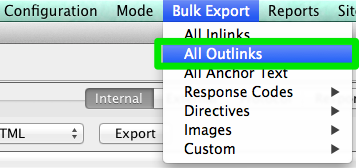

For at finde dine crawlfejl i Screaming Frog skal du følge disse trin:

- Når crawlingen er afsluttet, skal du gå til Bulk Reports.

- Rul ned til Response Codes, og eksporter derefter fejlrapporten på serversiden og klientfejlrapporten.

Sådan løser du problemet:

- Med hensyn til klientfejlrapporterne burde du selv kunne 301-omdirigere størstedelen af 404-fejlene i webstedets backend.

- Med hensyn til serverfejlrapporterne skal du samarbejde med udviklingsteamet for at finde årsagen. Før du retter disse fejl i rodmappen, skal du sørge for at tage en sikkerhedskopi af webstedet. Du skal måske blot oprette en ny .html-adgangsfil eller øge PHP-hukommelsesgrænsen.

- Du skal også fjerne alle disse permanente omdirigeringer fra sitemapet og alle interne eller eksterne links.

- Du kan også bruge 404 i din URL for at hjælpe med at spore i Google Analytics.

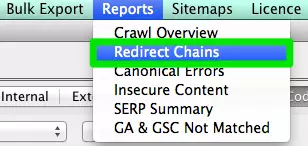

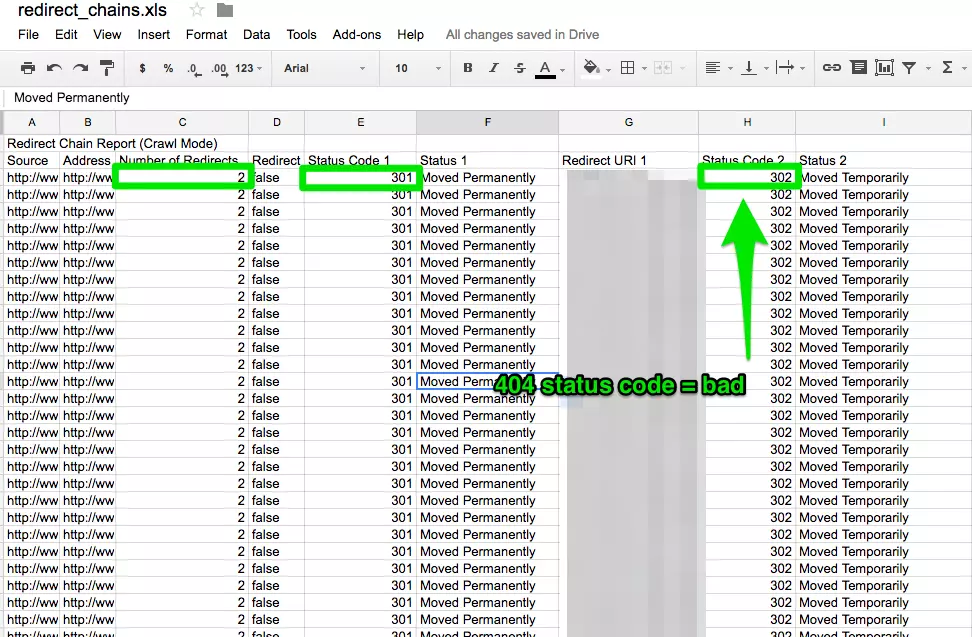

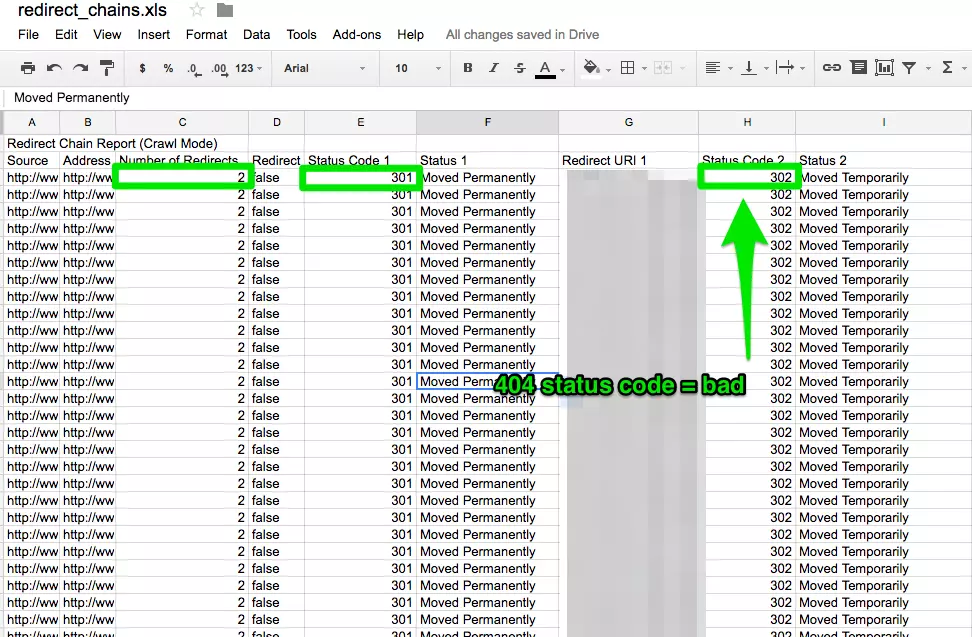

Redirect-kæder

Redirect-kæder forårsager ikke kun en dårlig brugeroplevelse, men det sænker også sidehastigheden, konverteringsraten falder, og enhver linkkærlighed, som du måske har modtaget før, går tabt.

Fiksering af redirect-kæder er en hurtig gevinst for enhver virksomhed.

Sådan løser du problemet:

- I Screaming Frog, når du har afsluttet din crawl, skal du gå til Rapporter >Redirect-kæder for at se crawlvejen for dine redirects. I et excel-regneark kan du spore for at sikre, at dine 301-omdirigeringer er resterende 301-omdirigeringer. Hvis du ser en 404-fejl, skal du rydde op i det.

Internt & Eksternt link

Når en bruger klikker på et link til dit websted og får en 404-fejl, er det ikke en god brugeroplevelse.

Og det hjælper heller ikke søgemaskinerne til at synes bedre om dig.

For at finde mine ødelagte interne og eksterne links bruger jeg Integrity for Mac. Du kan også bruge Xenu Sleuth, hvis du er pc-bruger.

Jeg vil også vise dig, hvordan du finder disse interne og eksterne links i Screaming Frog og DeepCrawl, hvis du bruger den software.

Sådan løser du:

- Hvis du bruger Integrity eller Xenu Sleuth, skal du køre din klients websteds URL, så får du en komplet liste over brudte URL’er. Du kan enten selv opdatere disse manuelt, eller hvis du arbejder sammen med et udviklingsteam, kan du bede dem om hjælp.

- Hvis du bruger Screaming Frog, skal du, når crawlingen er afsluttet, gå til Bulk Export i navigationslinjen og derefter til All Outlinks. Du kan sortere efter URL’er og se, hvilke sider der sender et 404-signal. Gentag det samme trin med All Inlinks.

- Hvis du bruger DeepCrawl, skal du gå til fanen Unique Broken Links under afsnittet Internal Links.

URLs

Hver gang du tager en ny kunde, skal du gennemgå deres URL-format. Hvad skal jeg kigge efter i URL’erne?

- Parametre – Hvis URL’en har mærkelige tegn som ?, = eller +, er det en dynamisk URL, der kan forårsage duplicate content, hvis den ikke optimeres.

- Brugervenlig – Jeg kan godt lide at holde URL’erne korte og enkle og samtidig fjerne eventuelle ekstra skråstreger.

Sådan løser du problemet:

- Du kan søge efter URL’er med parametre i Google ved at gøre site:www.buyaunicorn.com/ inurl: “

- Når du har kørt crawl på Screaming Frog, skal du kigge på URL’er. Hvis du ser parametre opført, der skaber dubletter af dit indhold, skal du foreslå følgende:

- Føj et canonical tag til den primære URL-side. Hvis www.buyaunicorn.com/magical-headbands f.eks. er hovedsiden, og jeg ser www.buyaunicorn.com/magical-headbands/?dir=mode123$, skal det canoniske tag tilføjes til www.buyaunicorn.com/magical-headbands.

- opdatér dine parametre i Google Search Console under Crawl > URL-parametre.

- Disallow de duplikerede URL’er i robots.txt.

Stræk 2: Gennemgå Google Search Console og Bing Webmaster Tools.

Værktøjer:

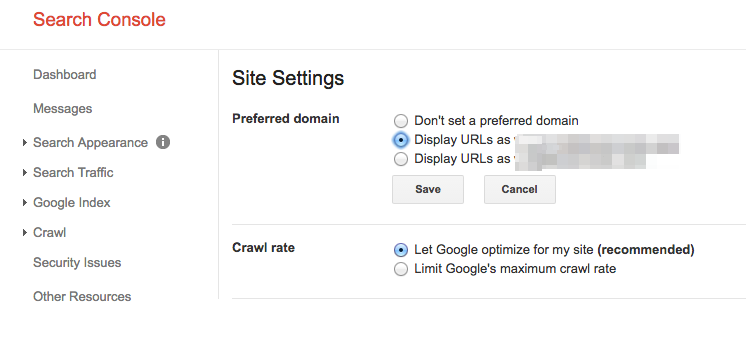

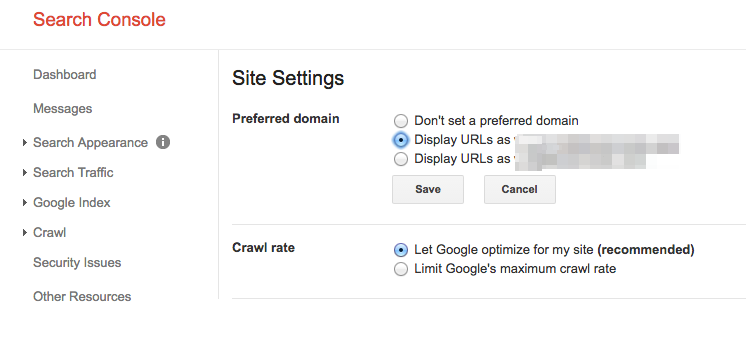

Indstil et foretrukket domæne

Siden Panda-opdateringen er det en fordel at tydeliggøre det foretrukne domæne over for søgemaskinerne. Det hjælper også med at sikre, at alle dine links giver ét websted den ekstra kærlighed i stedet for at blive spredt ud over to websteder.

Sådan løser du problemet:

- I Google Search Console skal du klikke på tandhjulsikonet i øverste højre hjørne.

- Vælg, hvilken af URL’erne der er det foretrukne domæne.

- Du behøver ikke at indstille det foretrukne domæne i Bing Webmaster Tools, du skal blot indsende dit sitemap for at hjælpe Bing med at bestemme dit foretrukne domæne.

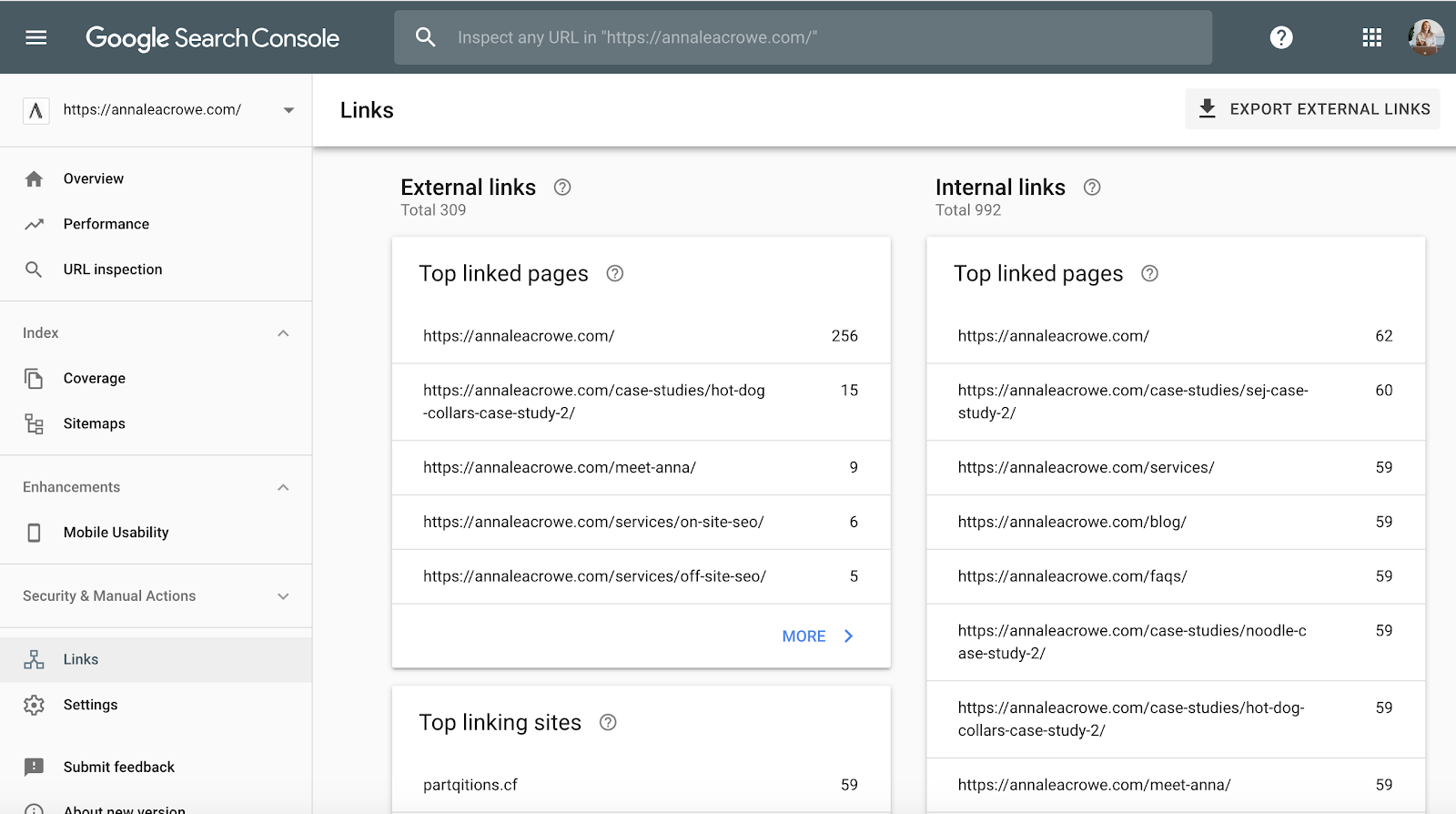

Backlinks

Med meddelelsen om, at Penguin er i realtid, er det afgørende, at din klients backlinks opfylder Googles standarder.

Hvis du bemærker en stor del af backlinks, der kommer til din klients websted fra én side på et websted, skal du tage de nødvendige skridt til at rydde op, og det skal ske FAST!

Sådan retter du op:

- I Google Search Console skal du gå til Links > og derefter sortere dine Top linking sites.

- Kontakt de virksomheder, der linker til dig fra en side, for at få dem til at fjerne linkene.

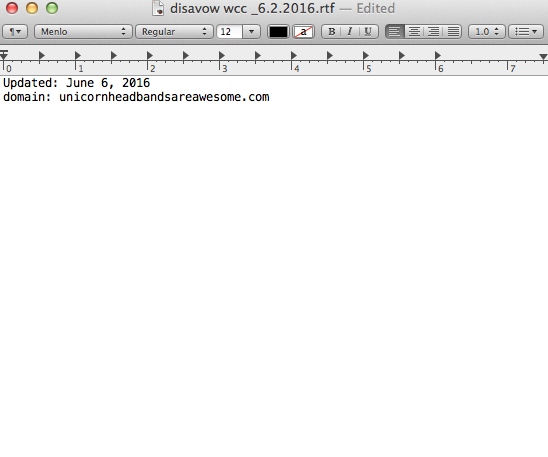

- Og tilføj dem til din disavow-liste. Når du tilføjer virksomheder til din disavow-liste, skal du være meget forsigtig med, hvordan og hvorfor du gør det. Du ønsker ikke at fjerne værdifulde links.

Her er et eksempel på, hvordan min disavow-fil ser ud:

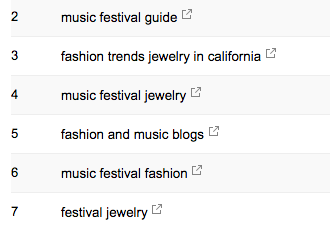

Keywords

Keywords

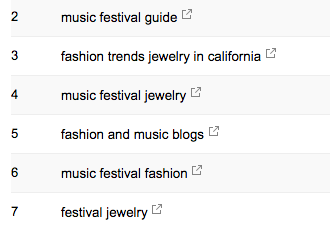

Som SEO-konsulent er det min opgave at begynde at lære min kundes markedslandskab at kende. Jeg er nødt til at vide, hvem deres målgruppe er, hvad de søger efter, og hvordan de søger. Til at starte med tager jeg et kig på de søgeord, som de allerede får trafik fra.

- I Google Search Console vil Search Analytics under Search Traffic > vise dig, hvilke søgeord der allerede sender kliks til din klient.

Sitemap

Sitemap

Sitemaps er afgørende for at få søgemaskinerne til at crawle din kundes website. Det taler deres sprog. Når du opretter sitemaps, er der et par ting, du skal vide:

- Indlem ikke parameter-URL’er i dit sitemap.

- Indlem ikke sider, der ikke kan indekseres.

- Hvis webstedet har forskellige subdomæner til mobil og desktop, skal du tilføje rel=”alternate” tagget til sitemapet.

Sådan løser du problemet:

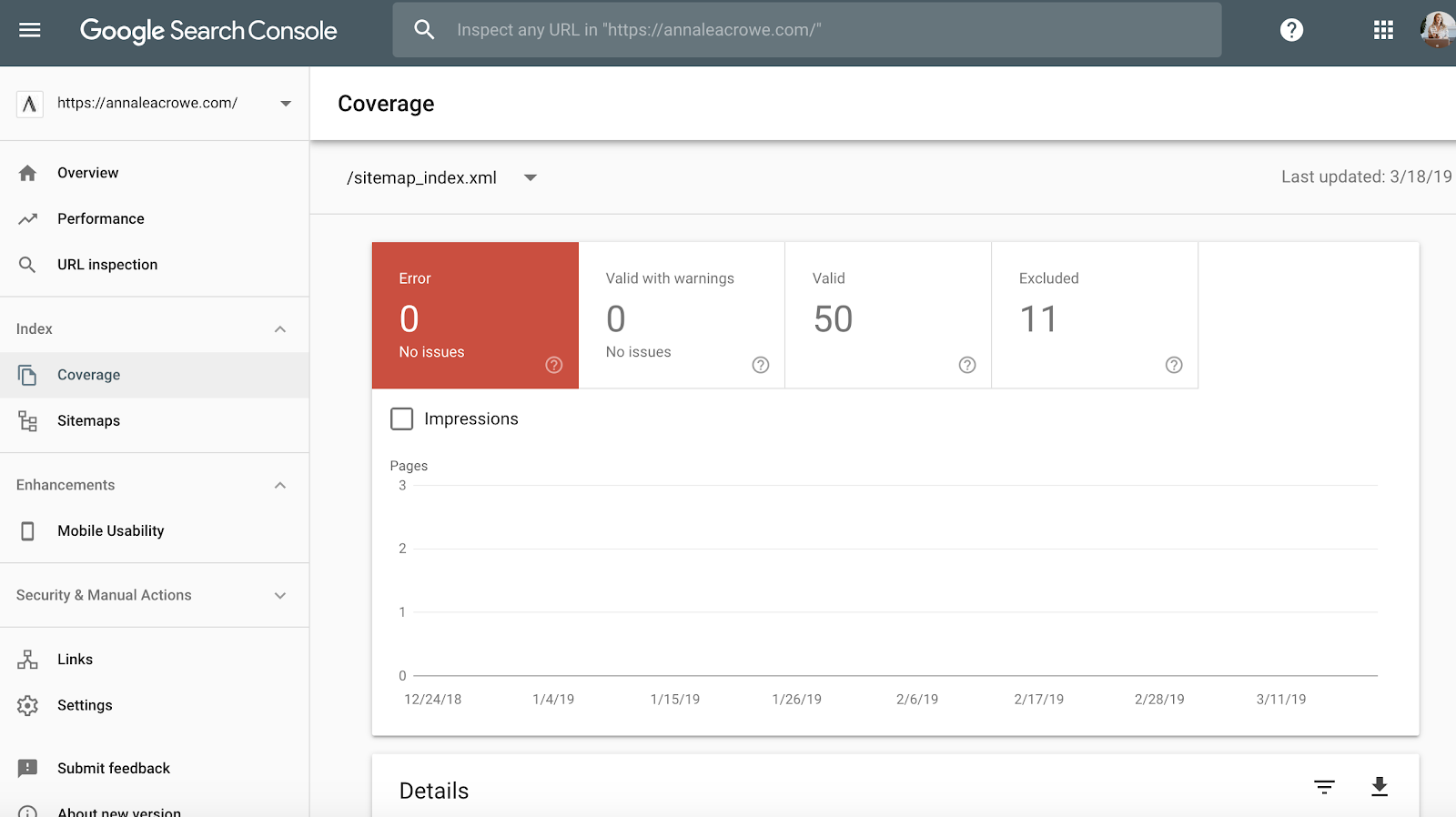

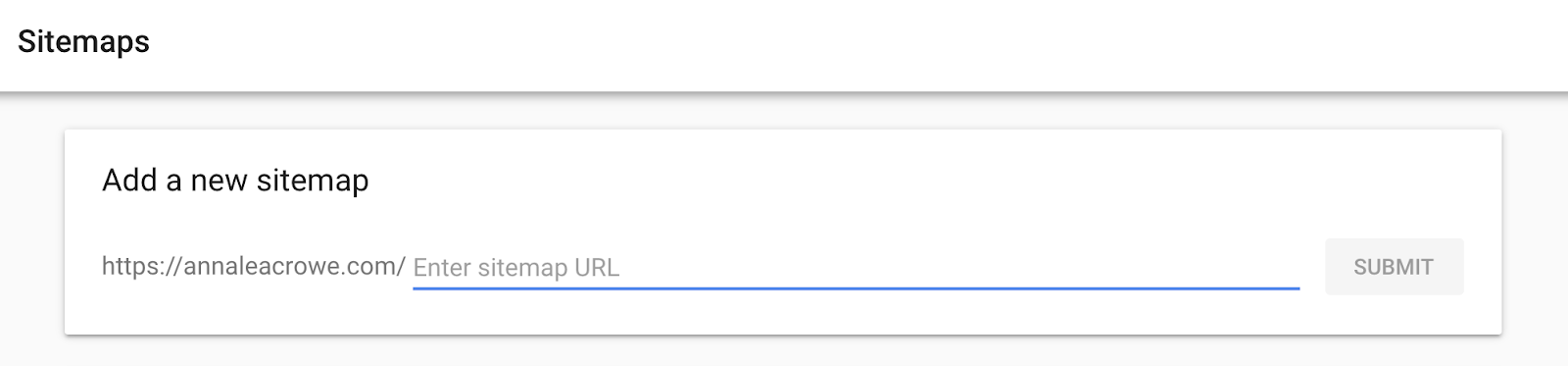

- Gå til Google Search Console > Index > Sitemaps for at sammenligne de URL’er, der er indekseret i sitemapet, med URL’erne i webindekset.

- Dernæst skal du foretage en manuel søgning for at fastslå, hvilke sider der ikke bliver indekseret, og hvorfor.

- Hvis du finder gamle omdirigerede URL’er i din kundes sitemap, skal du fjerne dem. Disse gamle redirects vil have en negativ indvirkning på din SEO, hvis du ikke fjerner dem.

- Hvis kunden er ny, skal du indsende et nyt sitemap for dem i både Bing Webmaster Tools og Google Search Console.

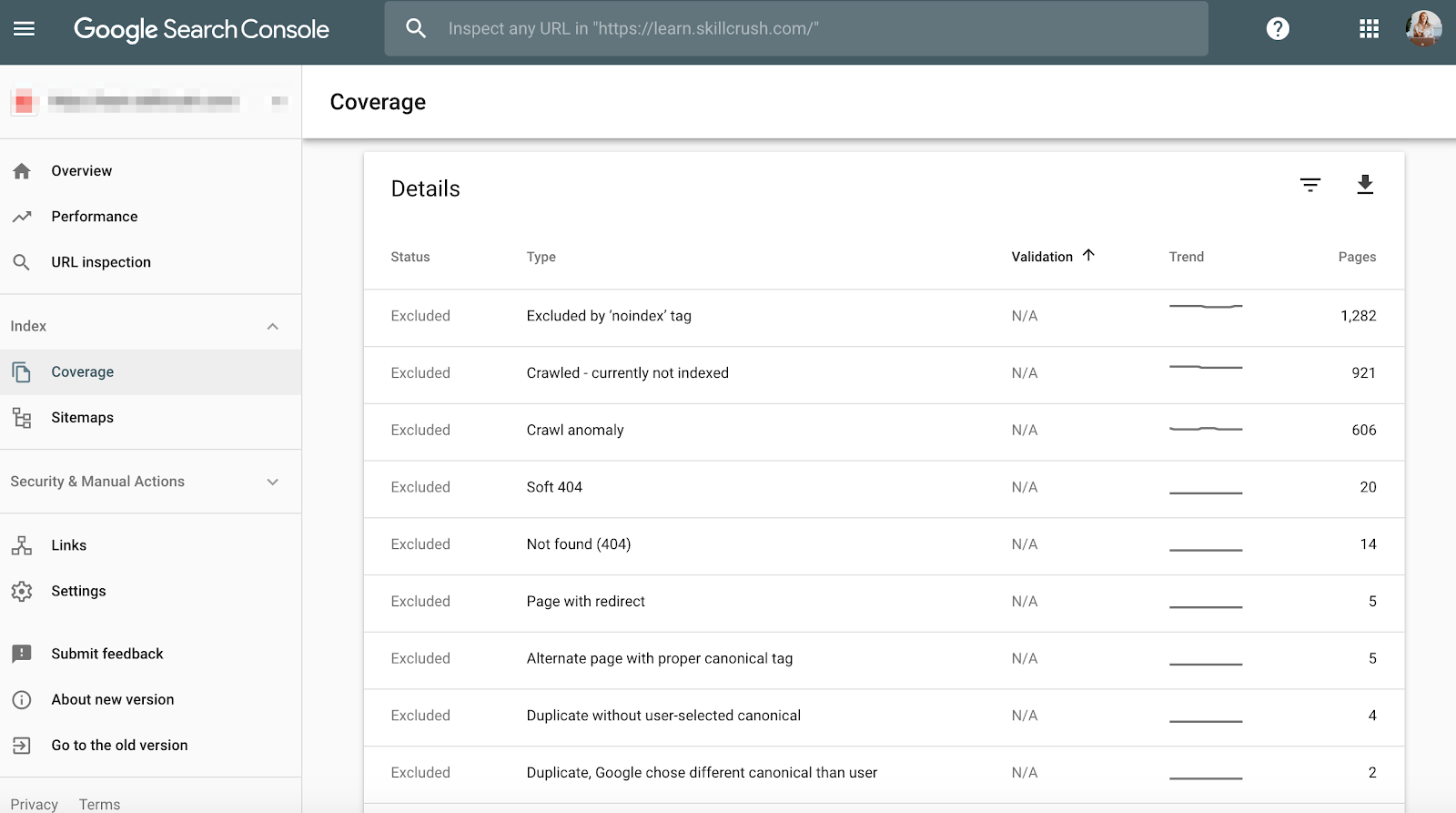

Crawl

Crawl-fejl er vigtige at kontrollere, fordi det ikke kun er dårligt for brugeren, men det er også dårligt for din website-ranking. Og John Mueller udtalte, at en lav crawlrate kan være et tegn på et websted af lav kvalitet.

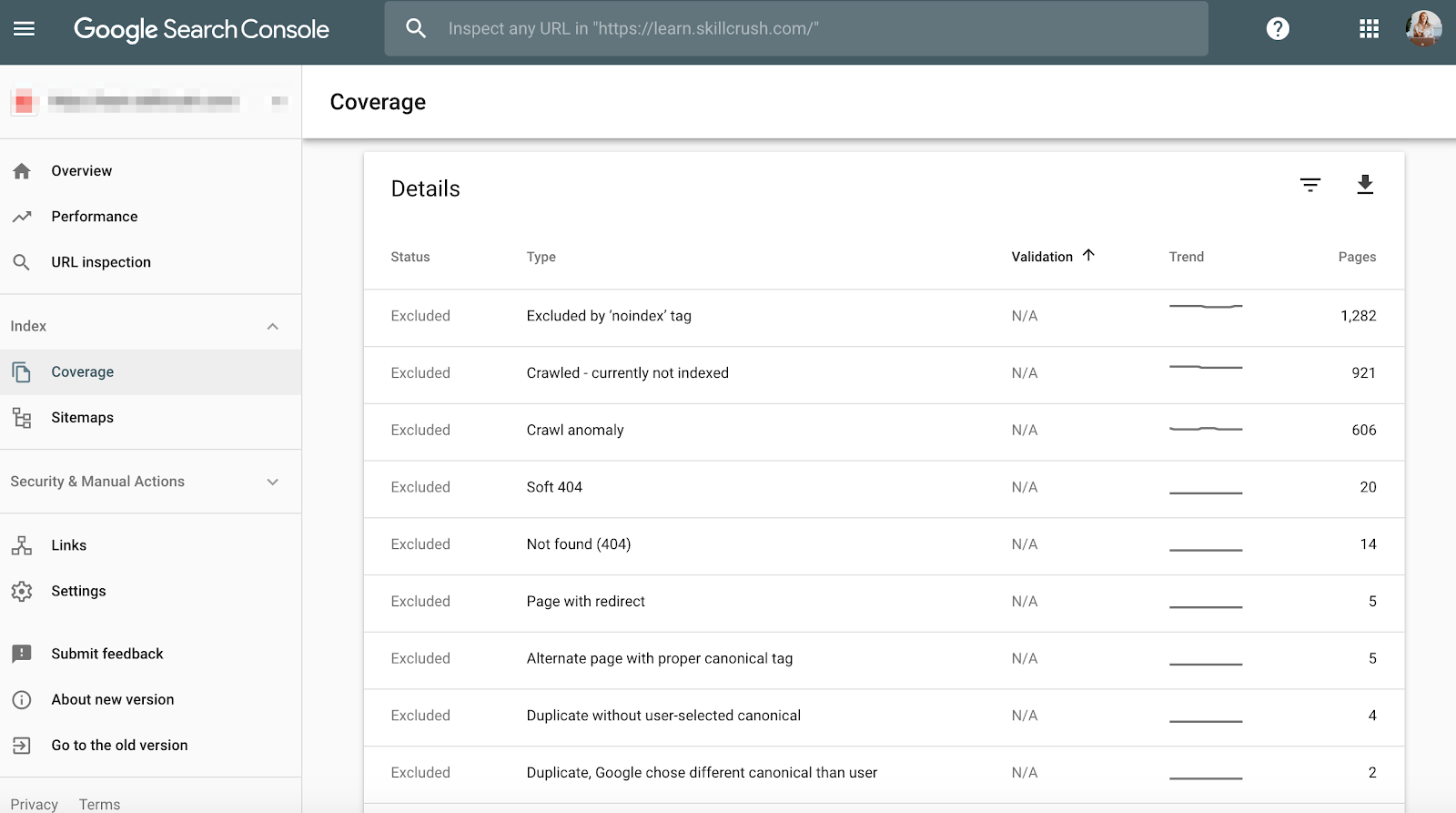

For at kontrollere dette i Google Search Console skal du gå til Dækning > Detaljer.

For at kontrollere dette i Bing Webmaster Tools skal du gå til Rapporter & Data > Crawloplysninger.

Sådan løser du problemet:

- Kontroller manuelt dine crawlfejl for at fastslå, om der er crawlfejl, der kommer fra gamle produkter, som ikke længere eksisterer, eller om du ser crawlfejl, der burde være forbudt i robotterne.txt-filen.

- Når du har fastslået, hvor de kommer fra, kan du implementere 301-omdirigeringer til lignende sider, der linker til de døde sider.

- Du skal også krydstjekke crawlstatistikkerne i Google Search Console med den gennemsnitlige indlæsningstid i Google Analytics for at se, om der er en sammenhæng mellem den tid, der bruges på at downloade, og de sider, der crawles pr. dag.

Strukturerede data

Som nævnt ovenfor i afsnittet om skemaer i Screaming Frog kan du gennemgå din klients skemamarkup i Google Search Console.

Brug den individuelle statusrapport om rige resultater i Google Search Console. (Bemærk: Rapporten om strukturerede data er ikke længere tilgængelig).

Dette vil hjælpe dig med at afgøre, hvilke sider der har fejl i strukturerede data, som du skal rette hen ad vejen.

Sådan retter du:

- Google Search Console fortæller dig, hvad der mangler i skemaet, når du tester live-versionen.

- Baseret på dine fejlkoder skal du omskrive skemaet i en teksteditor og sende det til webudviklingsteamet til opdatering. Jeg bruger Sublime Text til min tekstredigering. Mac-brugere har en indbygget, og pc-brugere kan bruge Google købte YouTube.

Stræk 3: Gennemgå Google Analytics

Tools:

- Google Analytics.

- Google Tag Manager Assistant Chrome Extension.

- Annie Cushing Campaign Tagging Guide.

Visninger

Når jeg først får en ny kunde, opretter jeg 3 forskellige visninger i Google Analytics.

- Rapporteringsvisning.

- Hovedvisning.

- Mastervisning.

- Testvisning.

Disse forskellige visninger giver mig fleksibilitet til at foretage ændringer uden at påvirke dataene.

Sådan gør du:

- I Google Analytics skal du gå til Admin > Vis > Visning > Visningsindstillinger for at oprette de tre forskellige visninger ovenfor.

- Sørg for at kontrollere afsnittet Bot Filtering for at udelukke alle hits fra bots og spiders.

- Link Google Ads og Google Search Console.

- Sørg til sidst for, at sporing af søgninger på webstedet er slået til.

Filter

Du skal sørge for at tilføje din IP-adresse og din kundes IP-adresse til filtrene i Google Analytics, så du ikke får falsk trafik.

Sådan løser du problemet:

- Gå til Admin> Vis > Filtre

- Så skal indstillingerne indstilles til at Udelukke > trafik fra IP-adresser >, der er lig med: >.

Sporingskode

Sporingskode

Du kan manuelt kontrollere kildekoden, eller du kan bruge min Screaming Frog-teknik fra ovenfor.

Hvis koden er der, skal du spore, at den affyrer i realtid.

- For at kontrollere dette skal du gå til din kundes websted og klikke lidt rundt på webstedet.

- Derpå skal du gå til Google Analytics > Real-Time > Locations, din placering skal udfyldes.

- Hvis du bruger Google Tag Manager, kan du også kontrollere dette med Google Tag Assistant Chrome-udvidelsen.

Sådan løser du problemet:

- Hvis koden ikke affyres, skal du kontrollere kodestumpen for at sikre dig, at det er den korrekte. Hvis du administrerer flere websteder, kan du have tilføjet koden til et andet websted.

- Hvis du kopierer koden, skal du bruge en teksteditor og ikke et tekstbehandlingsprogram til at kopiere udklippet til webstedet, før du kopierer koden. Dette kan medføre ekstra tegn eller whitespace.

- Funktionerne er case-sensitive, så kontroller, at alt er med små bogstaver i koden.

Indeksering

Hvis du har haft mulighed for at lege lidt rundt i Google Search Console, har du sikkert bemærket afsnittet Coverage.

Når jeg reviderer en kunde, gennemgår jeg deres indeksering i Google Search Console sammenlignet med Google Analytics. Sådan gør du:

- I Google Search Console skal du gå til Dækning

- I Google Analytics skal du gå til Erhvervelse > Kanaler > Organisk søgning > Landingsside.

- Når du er her, skal du gå til Avanceret > Brug af websted > Sessioner > 9.

Sådan løser du problemet:

- Sammenlign tallene fra Google Search Console med tallene fra Google Analytics, hvis tallene er vidt forskellige, så ved du, at selvom siderne bliver indekseret, så er det kun en brøkdel, der får organisk trafik.

Campaign Tagging

Den sidste ting, du vil kontrollere i Google Analytics, er, om din kunde bruger campaign tagging korrekt. Du ønsker ikke, at du ikke får kredit for det arbejde, du udfører, fordi du har glemt kampagne-tagging.

Sådan løser du problemet:

- Opret en strategi for kampagne-tagging i Google Analytics, og del den med din kunde. Annie Cushing har sammensat en fantastisk guide til kampagne-tagging.

- Opsæt Event Tracking, hvis din klient bruger mobilannoncer eller video.

Nøgleord

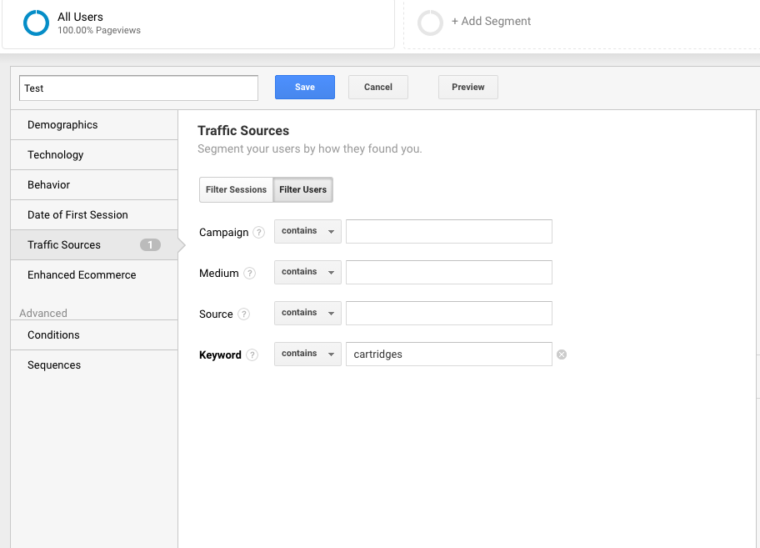

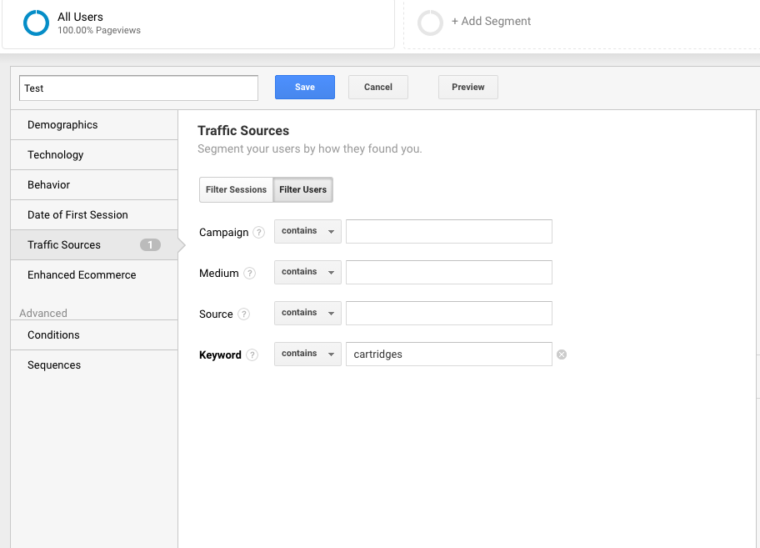

Du kan bruge Google Analytics til at få indsigt i potentielle nøgleordsperler for din klient. Hvis du vil finde nøgleord i Google Analytics, skal du følge disse trin:

Gå til Google Analytics > Adfærd > Adfærd > Site Search > Søgeord. På den måde får du et overblik over, hvad kunderne søger efter på webstedet.

Næst vil jeg bruge disse søgeudtryk til at oprette et nyt segment i Google Analytics for at se, hvilke sider på webstedet der allerede rangerer for det pågældende søgeordsterm.

Stræk 4: Manuel kontrol

Værktøjer:

- Google Analytics.

- Access til klientens server og vært.

- Du får signal.

- Pingdom.

- PageSpeed Tools.

- Wayback Machine.

En version af din kundes websted er søgbar

Tjek alle de forskellige måder, du kan søge efter et websted på. For eksempel:

- http://annaisaunicorn.com

- https://annaisaunicorn.com

- http://www.annaisaunicorn.com

Som Highlander ville sige, “kan der kun være ét” websted, der er søgbart.

Sådan løser du det: Brug en 301 redirect for alle URL’er, der ikke er det primære websted, til det kanoniske websted.

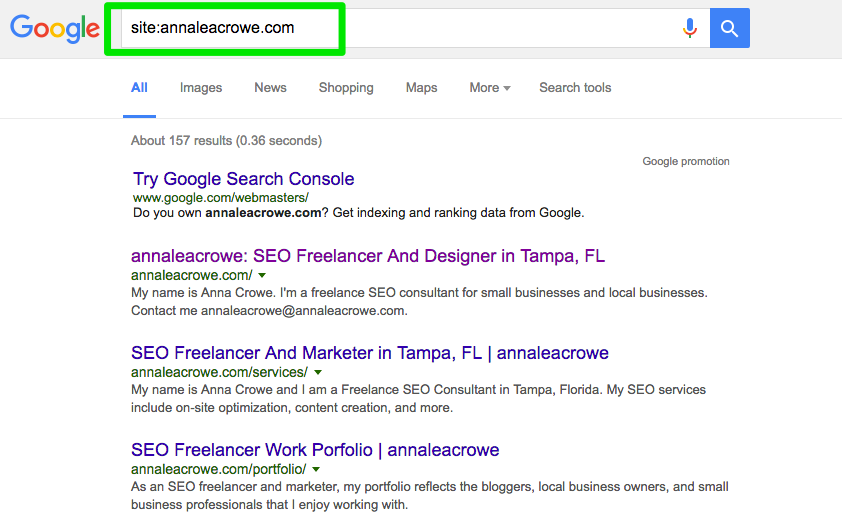

Indeksering

Indfør en manuel søgning i Google og Bing for at bestemme, hvor mange sider der indekseres af Google. Dette tal er ikke altid nøjagtigt med dine data fra Google Analytics og Google Search Console, men det bør give dig et groft skøn.

For at kontrollere dette skal du gøre følgende:

- Udfør en søgning på et websted i søgemaskinerne.

- Når du søger, skal du manuelt scanne for at sikre dig, at kun din kundes brand vises.

- Kontroller, at hjemmesiden er på første side. John Mueller sagde, at det ikke er nødvendigt, at hjemmesiden vises som det første resultat.

Sådan løser du problemet:

- Hvis et andet brand vises i søgeresultaterne, har du et større problem på hånden. Du skal dykke ned i analyserne for at diagnosticere problemet.

- Hvis hjemmesiden ikke vises som det første resultat, skal du udføre et manuelt tjek af hjemmesiden for at se, hvad den mangler. Det kan også betyde, at webstedet har en straf eller dårlig webstedsarkitektur, hvilket er et større problem med at redesigne webstedet.

- Kryds-kontroller antallet af organiske landingssider i Google Analytics for at se, om det stemmer overens med antallet af søgeresultater, du så i søgemaskinen. Dette kan hjælpe dig med at afgøre, hvilke sider søgemaskinerne ser som værdifulde.

Caching

Jeg vil køre et hurtigt tjek for at se, om de øverste sider bliver cachet af Google. Google bruger disse cachede sider til at forbinde dit indhold med søgeforespørgsler.

For at kontrollere, om Google cacher din klients sider, skal du gøre dette:

http://webcache.googleusercontent.com/search?q=cache:https://www.searchenginejournal.com/pubcon-day-3-women-in-digital-amazon-analytics/176005/

Sørg for at skifte over til den rene tekstversion.

Du kan også kontrollere dette i Wayback Machine.

Sådan løser du problemet:

- Kontroller klientens server for at se, om den er nede eller fungerer langsommere end normalt. Der kan være tale om en intern serverfejl eller en fejl i en databaseforbindelse. Dette kan ske, hvis flere brugere forsøger at få adgang til serveren på samme tid.

- Kontroller, hvem der ellers er på din server med en omvendt IP-adressekontrol. Du kan bruge You Get Signal-webstedet til denne fase. Du skal muligvis opgradere din kundes server eller begynde at bruge et CDN, hvis du har skitseagtige domæner, der deler serveren.

- Kontroller, om kunden fjerner specifikke sider fra webstedet.

Hosting

Selv om dette kan blive lidt teknisk for nogle, er det afgørende for din SEO-succes at kontrollere den hosting-software, der er tilknyttet din kundes websted. Hosting kan skade SEO, og alt dit hårde arbejde vil være forgæves.

Du skal have adgang til din kundes server for manuelt at kontrollere eventuelle problemer. De mest almindelige hostingproblemer, jeg ser, er at have det forkerte TLD og langsom webstedshastighed.

Sådan løser du problemet:

- Hvis din klient har det forkerte TLD, skal du sørge for, at land-IP-adressen er forbundet med det land, som din klient opererer mest i. Hvis din klient har et .co-domæne og også et .com-domæne, skal du omdirigere .co-domænet til din klients primære domæne på .com.

- Hvis din klient har langsom webstedshastighed, skal du løse dette hurtigt, da webstedshastighed er en rankingfaktor. Find ud af, hvad der gør webstedet langsomt, med værktøjer som PageSpeed Tools og Pingdom. Her er et kig på nogle af de almindelige problemer med sidehastighed:

- Host.

- Store billeder.

- Indlejrede videoer.

- Plugins.

- Ads.

- Theme.

- Widgets.

- Repetitive scripts eller tæt kode.

Core Web Vitals Audit

Core Web Vitals er en samling af tre målepunkter, der er repræsentative for et websteds brugeroplevelse. De er vigtige, fordi Google opdaterer sine algoritmer i foråret 2021 for at indarbejde Core Web Vitals som en rankingfaktor.

Selv om rankingfaktoren forventes at være en lille faktor, er det stadig vigtigt at revidere Core Web Vitals-scorerne og identificere områder, der kan forbedres.

Hvorfor er det vigtigt at medtage Core Web Vitals i din revision?

En forbedring af Core Web Vitals-scorerne vil ikke kun hjælpe på søgerangering, men måske endnu vigtigere kan det betale sig med flere konverteringer og indtjening.

Forbedringer af hastigheden og sidens ydeevne er forbundet med højere salg, trafik og annonceklik.

En opgradering af webhotellet og installation af et nyt plugin kan forbedre sidens hastighed, men vil kun have ringe (hvis nogen) effekt på Core Web Vitals.

Målingen foretages på det tidspunkt, hvor en person bogstaveligt talt downloader dit websted på sin mobiltelefon.

Det betyder, at flaskehalsen er ved deres internetforbindelse og den mobile enhed. En hurtig server vil ikke fremskynde en langsom internetforbindelse på en budgetmobiltelefon.

Sådan vil et sidehastigheds-plugin være af meget ringe nytte, fordi mange af løsningerne indebærer ændring af koden i en skabelon eller kernefilerne i selve indholdsstyringssystemet.

Der er mange ressourcer til at hjælpe med at forstå løsninger. Men de fleste løsninger kræver hjælp fra en udvikler, som føler sig tryg ved at opdatere og ændre kernefiler i dit indholdsstyringssystem.

Løsningen af problemer med Core Web Vitals kan være vanskelig. WordPress, Drupal og andre indholdsstyringssystemer (CMS) blev ikke bygget til at score godt for Core Web Vitals.

Det er vigtigt at bemærke, at processen til forbedring af Core Web Vitals indebærer ændring af kodningen i kernen af WordPress og andre CMS.

Væsentligt nok kræver forbedring af Core Web Vitals, at man får et websted til at gøre noget, som det aldrig var meningen, da udviklerne skabte et tema eller CMS.

Sigtet med en revision af Core Web Vitals er at identificere, hvad der skal rettes, og at overdrage disse oplysninger til en udvikler, som derefter kan foretage de nødvendige ændringer.

Hvad er Core Web Vitals?

Core Web Vitals består af tre målinger, der tilsammen identificerer, hvor hurtigt den vigtigste del af din side indlæses, hvor hurtigt en bruger kan interagere med siden (eksempel: klikke på en knap), og hvor hurtigt det tager for websiden at blive stabil, uden at sideelementer flytter sig rundt.

Der er:

- Largest Contentful Paint (LCP).

- First Input Delay (FID).

- Cumulative Layout Shift (CLS).

Der er to slags scoringer for Core Web Vitals:

- Labdata.

- Feltdata.

Labdata

Labdata er det, der genereres, når du kører en side gennem Google Lighthouse eller i PageSpeed Insights.

Labdata består af scoringer, der genereres gennem en simuleret enhed og internetforbindelse. Formålet er at give den person, der arbejder på siden, en idé om, hvilke dele af Core Web Vitals, der skal forbedres.

Værdien af et værktøj som PageSpeed Insights er, at det identificerer specifik kode og sideelementer, der er årsag til, at en side scorer dårligt.

Feltdata

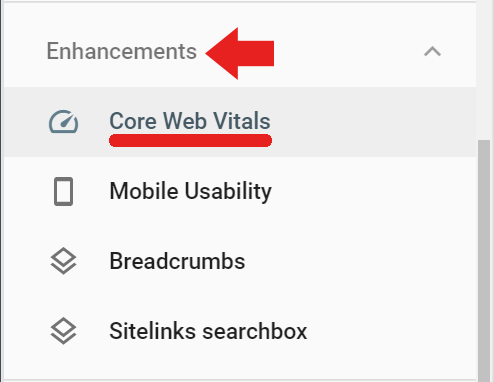

Feltdata er faktiske Core Web Vitals-scores, der er blevet indsamlet af Google Chrome-browseren til Chrome User Experience Report (også kendt som CrUX).

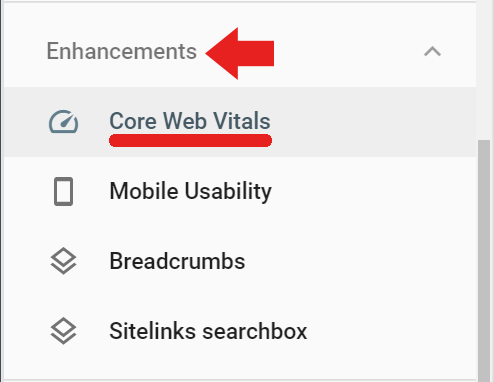

Feltdataene er tilgængelige i Google Search Console under fanen Forbedringer via linket Core Web Vitals (feltdata kan også tilgås via dette link) https://search.google.com/search-console/core-web-vitals.

Felddataene, der rapporteres i Google Search Console, kommer fra besøgte sider, der har haft et minimum af besøg og målinger. Hvis Google ikke modtager nok scoringer, vil Google Search Console ikke rapportere den pågældende score.

Screaming Frog til Core Web Vitals Audit

Screaming Frog version 14.2 har nu mulighed for at vise en bestået eller ikke-bestået Core Web Vitals-vurdering. Du skal forbinde Screaming Frog til PageSpeed Insights API (få en API-nøgle her) via en nøgle.

For at registrere din Page Speed Insights API-nøgle hos Screaming Frog skal du først navigere til Konfiguration > API-adgang > PageSpeed Insights

Der vil du se et sted, hvor du kan indtaste din API-nøgle og forbinde den til tjenesten.

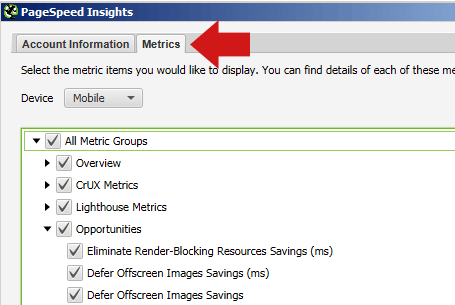

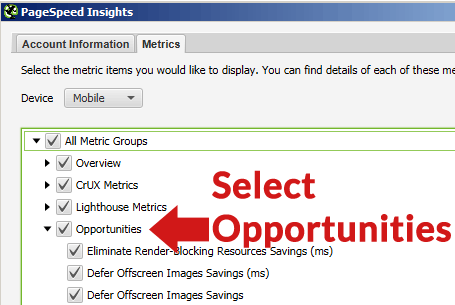

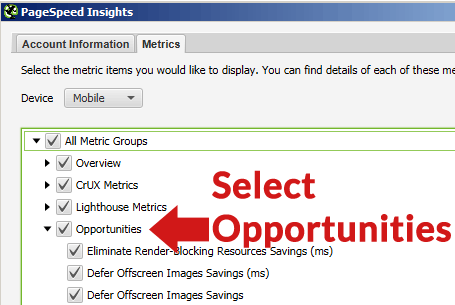

I samme PageSpeed Insights-popup kan du også vælge fanen Metrics og afkrydse de felter, der angiver, hvilke målinger du gerne vil have rapporteret.

Sørg for at vælge Mobile for enheden, da det er den måling, der betyder noget i forbindelse med rangering.

Hvis du vælger fanen Muligheder, vil Screaming Frog efter crawlingen vise dig en liste over forskellige former for forbedringer (som f.eks. at udskyde offscreen-billeder, fjerne ubrugt CSS osv.).

Note Before Crawling

Der er generelt ikke behov for at crawle et helt websted og udarbejde en udtømmende side-for-side-regnskab over, hvad der er galt med hver eneste side på webstedet.

Hvor du crawler, kan du overveje at crawle et repræsentativt sæt af sider. For at gøre dette skal du først vælge en gruppe af sider, der repræsenterer de typer af sider, der er fælles for hver sektion eller kategori på webstedet. Opret et regneark, en liste i en tekstfil, eller indsæt URL’erne manuelt ved hjælp af fanen Upload i Screaming Frog.

De fleste websteder indeholdt sider og indlæg, der var oprettet med lignende sidestruktur og indhold. F.eks. vil alle sider i en “nyheder”-kategori være ret ens, og sider i en “anmeldelser”-kategori vil også være ens.

Du kan spare tid ved at crawle en repræsentativ gruppe af sider for at identificere problemer, der er fælles for de enkelte kategorier, samt problemer, der er fælles for alle sider i hele webstedet, og som skal løses.

På grund af disse ligheder vil de problemer, der opdages, være ens. Det er måske kun nødvendigt at crawle en håndfuld repræsentative sider fra hver type kategori for at identificere, hvilke typer problemer der er specifikke for hver af disse sektioner.

Den slags ting, der bliver rettet, er typisk problemer på hele webstedet, som er fælles for hele webstedet, f.eks. ubrugt CSS, der indlæses fra alle sider, eller Cumulative Layout Shift forårsaget af en annonceenhed, der er placeret i venstre side af websiderne.

Da moderne websteder er skabelonbaserede, vil rettelserne ske på skabelonniveau eller med brugerdefineret kodning i stylesheetet osv.

Crawl webstedet med Screaming Frog

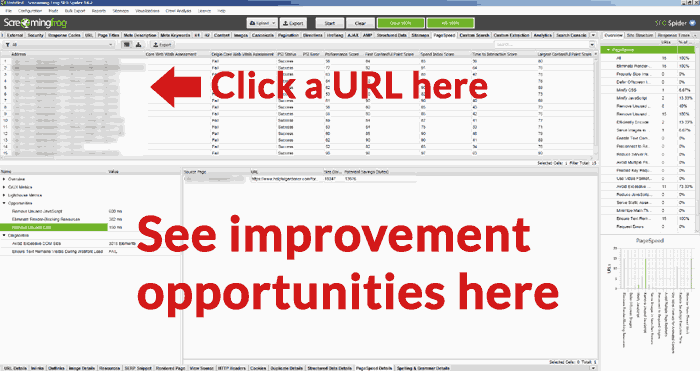

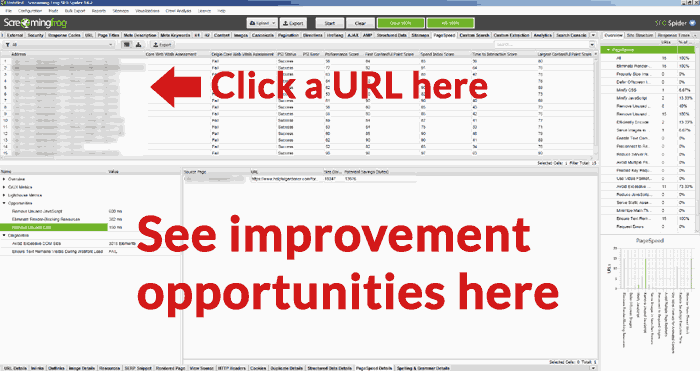

Når URL’erne er fuldt crawlet, kan du klikke på fanen PageSpeed og læse alle anbefalingerne og se noteringerne for bestået/ikke bestået for de forskellige måleparametre.

Zoom ind på URL-muligheder

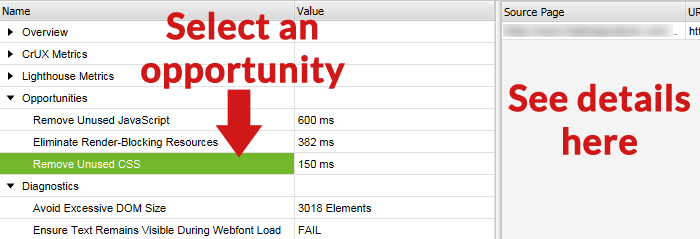

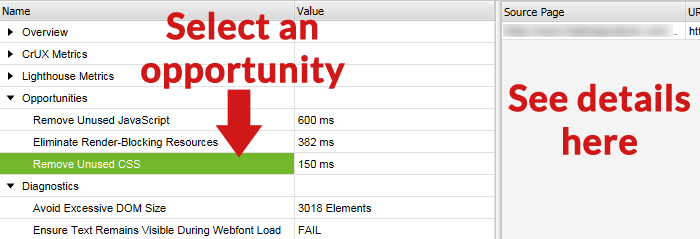

En nyttig funktion i Screaming Frog Core Web Vitals Audit er muligheden for at vælge en URL fra listen over URL’er i den øverste rude og derefter se mulighederne for forbedringer i den nederste rude på Screaming Frog-skærmen.

Nedenfor er et skærmbillede af det nederste skærmbillede, hvor en mulighed er valgt og detaljerne for denne forbedringsmulighed i højre rude.

Officiel Google-værktøj

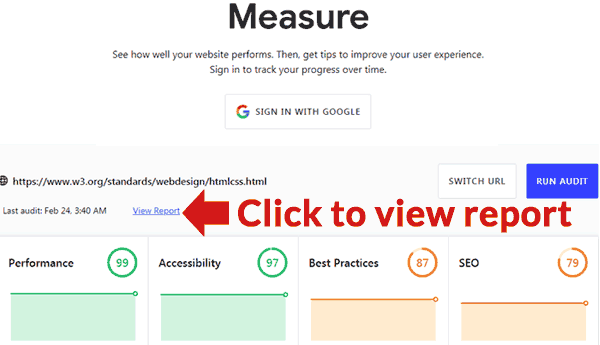

Google har offentliggjort et værktøj, der kan give en revision. Det er placeret her: https://web.dev/measure/

Indsæt en URL for at få et overblik over sidens ydeevne. Hvis du er logget ind, vil Google spore siden for dig over tid. Hvis du klikker på linket Vis rapport, åbnes en ny side med en rapport, der indeholder en detaljeret beskrivelse af, hvad der er galt, og links til vejledninger, der viser, hvordan du løser hvert problem.